xpath爬虫实战-爬取小说斗罗大陆第四部

爬取思路

- 用到的第三方库文件

lxml,requests,fake_agent - 用fake_agent里的UserAgent修饰爬虫

- 用requests进行基本的请求

- 用lxml进行html的分析

- 用xpath进行网页元素的选择

爬取的一些问题

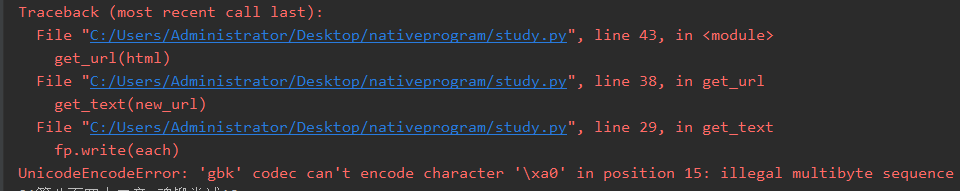

1.编码问题这两个编码无法转换成utf-8

- UnicodeEncodeError: ‘gbk’ codec can’t encode character ‘\xa0’ in position 15: illegal multibyte sequence

- UnicodeEncodeError: ‘gbk’ codec can’t encode character ‘\xufeff’ in position 15: illegal multibyte sequence

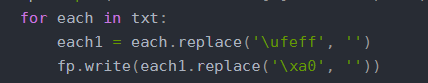

- 解决:将这两个提前换成空字符

2.要提前建好一个txts的文件夹

全部源码

from lxml import etree

import requests

from fake_useragent import UserAgent

url1 = 'https://www.ibiquge.net/66_66791/'

url2 = 'https://www.ibiquge.net'

# 爬取HTML的函数

def get_html(url):

ua = UserAgent()

kv = {'user-agent': ua.random}

re = requests.get(url, headers=kv)

re.encoding = 'utf-8'

htm1 = re.text

return htm1

# 根据url获得文章并保存的函数

def get_text(url):

html = get_html(url)

selector = etree.HTML(html)

title = selector.xpath('//*[@id="main"]/div/div/div[2]/h1/text()')

txt = selector.xpath('//*[@id="content"]/text()')

print(title)

fp = open('txts\\' + title[0] + '.txt', 'w')

for each in txt:

each1 = each.replace('\ufeff', '')

fp.write(each1.replace('\xa0', ''))

fp.close()

def get_url(html):

selector = etree.HTML(html)

url_list = selector.xpath('//*[@id="list"]/dl/dd/a/@href')

for url in url_list:

new_url = url2 + url

get_text(new_url)

if __name__ == '__main__':

html = get_html(url1)

get_url(html)

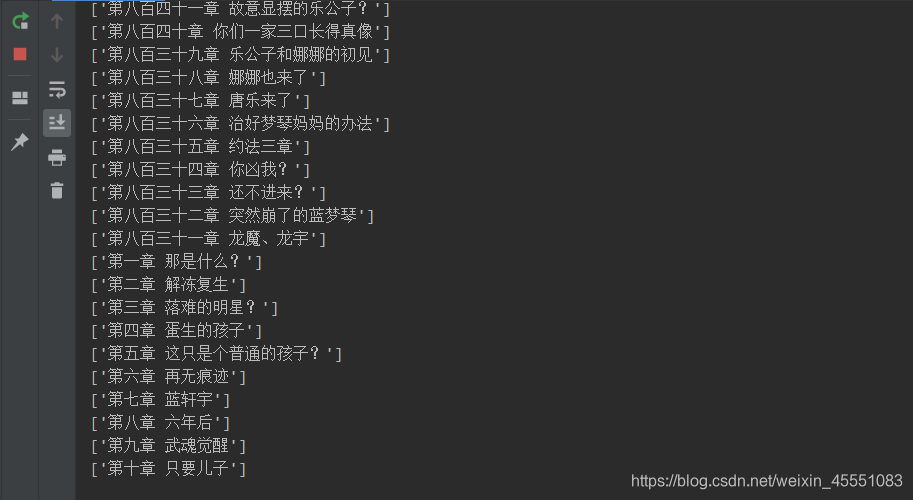

爬取过程

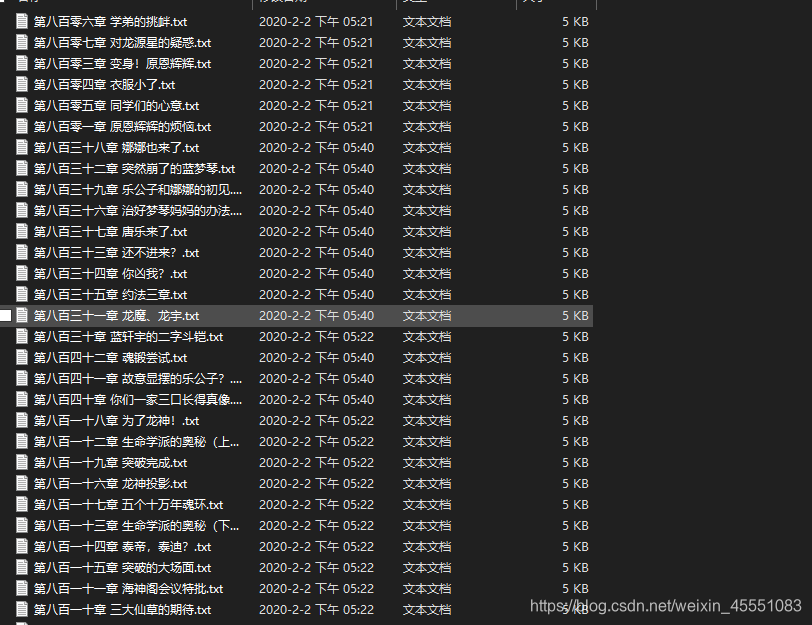

爬取结果

如有侵权,联系删除

xpath爬虫实战-爬取小说斗罗大陆第四部的更多相关文章

- python爬虫实战---爬取大众点评评论

python爬虫实战—爬取大众点评评论(加密字体) 1.首先打开一个店铺找到评论 很多人学习python,不知道从何学起.很多人学习python,掌握了基本语法过后,不知道在哪里寻找案例上手.很多已经 ...

- 第三百三十节,web爬虫讲解2—urllib库爬虫—实战爬取搜狗微信公众号—抓包软件安装Fiddler4讲解

第三百三十节,web爬虫讲解2—urllib库爬虫—实战爬取搜狗微信公众号—抓包软件安装Fiddler4讲解 封装模块 #!/usr/bin/env python # -*- coding: utf- ...

- Python实战项目网络爬虫 之 爬取小说吧小说正文

本次实战项目适合,有一定Python语法知识的小白学员.本人也是根据一些网上的资料,自己摸索编写的内容.有不明白的童鞋,欢迎提问. 目的:爬取百度小说吧中的原创小说<猎奇师>部分小说内容 ...

- 九 web爬虫讲解2—urllib库爬虫—实战爬取搜狗微信公众号—抓包软件安装Fiddler4讲解

封装模块 #!/usr/bin/env python # -*- coding: utf-8 -*- import urllib from urllib import request import j ...

- 初次尝试python爬虫,爬取小说网站的小说。

本次是小阿鹏,第一次通过python爬虫去爬一个小说网站的小说. 下面直接上菜. 1.首先我需要导入相应的包,这里我采用了第三方模块的架包,requests.requests是python实现的简单易 ...

- Scrapy爬虫实战-爬取体彩排列5历史数据

网站地址:http://www.17500.cn/p5/all.php 1.新建爬虫项目 scrapy startproject pfive 2.在spiders目录下新建爬虫 scrapy gens ...

- python2.7 爬虫_爬取小说盗墓笔记章节及URL并导入MySQL数据库_20161201

1.爬取页面 http://www.quanshu.net/book/9/9055/ 2.用到模块urllib(网页下载),re正则匹配取得title及titleurl,urlparse(拼接完整ur ...

- 慕课爬虫实战 爬取百度百科Python词条相关1000个页面数据

http://www.imooc.com/learn/563 spider_main.py #!/usr/bin/python # coding=utf-8 #from baike_spider im ...

- Node.js爬虫实战 - 爬你喜欢的

前言 今天没有什么前言,就是想分享些关于爬虫的技术,任性.来吧,各位客官,里边请... 开篇第一问:爬虫是什么嘞? 首先咱们说哈,爬虫不是"虫子",姑凉们不要害怕. 爬虫 - 一种 ...

随机推荐

- mybatis采坑之Cause: com.mysql.jdbc.exceptions.jdbc4.MySQLSyntaxErrorException: Unknown column '?°?é?“é?“' in 'field list'

最后找到问题: 符号问题 修改之后正常

- Python学习前端之JavaScript

JavaScript介绍 1992年Nombas开发出C-minus-minus(C--)的嵌入式脚本语言(最初绑定在CEnvi软件中),后将其改名ScriptEase(客户端执行的语言). Nets ...

- 获取data 数据

export function getData(el, name, val) { const prefix = 'data-' if (val) { return el.setAttribute(pr ...

- IDEA 正式版终于支持中文版和 JDK 直接下载了(太方便了)附介绍视频

IDEA 2020.1 经过了漫长的打磨终于发布正式版了,而这次的版本不止直接支持 Java 14,还带来了两个重量级的功能,官方中文版支持和 JDK 直接下载. 在之前的开发中,当我们需要下载 JD ...

- qt creator源码全方面分析(3-9)

依赖分析图 我们对库和插件的依赖性进行分析,并画图如下,稍微省略了一些插件,画出来太乱了,核心的都在图中了. 原创造福大家,共享改变世界 献出一片爱心,温暖作者心灵

- python--Django(后台管理模块)

一.准备工作 1.创建应用 python manage.py startapp test 2.定义模型类 (1)打开刚创建的app目录test,打开models.py文件 (2)代码如下 from d ...

- (js描述的)数据结构[哈希表1.2](9)

一. 优秀的哈希函数 1.快速的计算: 需要快速的计算来获得对应的hashCode(霍纳法则来减少乘除次数) 2.均匀的分布: 尽可能将元素映射到不同的位置,让元素在哈希表中均匀分布 二.哈希表的扩容 ...

- 了解一下mock

1.mock简介: mock测试就是在测试过程中,对于某些不容易构成或者不容易获取的对象,用一个虚拟的对象来创建以便测试的测试方法,mock是在测试过程中,对于一些不容易构造/获取的对象,创建一个mo ...

- std::chrono计算程序运行时间

void CalRunTime() { auto t1=std::chrono::steady_clock::now(); //run code auto t2=std::chrono::steady ...

- java实现图片的上传和展示

一.注意事项: 1,该项目主要采用的是springboot+thymeleaf框架 2,代码展示的为ajax完成图片上传(如果不用ajax只需要改变相应的form表单配置即可) 二.效果实现: 1,页 ...