Prometheus monitor RabbitMQ

Install docker-compose

sudo curl -L "https://github.com/docker/compose/releases/download/1.23.2/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

sudo chmod +x /usr/local/bin/docker-compose

docker-compose --version

Prometheus

docker-compose

version: '3.2' services:

prometheus:

image: prom/prometheus:latest

container_name: prometheus

restart: unless-stopped

ports:

- '9090:9090'

user: '0'

command:

- '--config.file=/etc/prometheus/prometheus.yml'

- '--storage.tsdb.path=/prometheus/data'

- '--storage.tsdb.retention=90d'

- '--web.enable-lifecycle'

volumes:

- ./etc/prometheus:/etc/prometheus

- ./data/prometheus/data:/prometheus/data

- /etc/localtime:/etc/localtime

depends_on:

- cadvisor cadvisor:

image: google/cadvisor:latest

container_name: cadvisor

restart: unless-stopped

ports:

- '8080:8080'

volumes:

- /:/rootfs:ro

- /var/run:/var/run:rw

- /sys:/sys:ro

- /var/lib/docker/:/var/lib/docker:ro node-exporter:

image: prom/node-exporter:latest

container_name: node-exporter

restart: unless-stopped

ports:

- '9100:9100'

command:

- '--path.procfs=/host/proc'

- '--path.sysfs=/host/sys'

- '--collector.filesystem.ignored-mount-points=^/(sys|proc|dev|host|etc)($$|/)'

- '--collector.textfile.directory=/node_exporter/prom'

volumes:

- /proc:/host/proc

- /sys:/host/sys

- /:/rootfs

- ./etc/node_exporter/prom:/node_exporter/prom grafana:

image: grafana/grafana:latest

container_name: grafana

restart: unless-stopped

ports:

- '3000:3000'

user: '0'

volumes:

- ./data/grafana:/var/lib/grafana

environment:

- GF_SECURITY_ADMIN_PASSWORD=admin

- GF_USERS_ALLOW_SIGN_UP=false

vim ./etc/prometheus/prometheus.yml

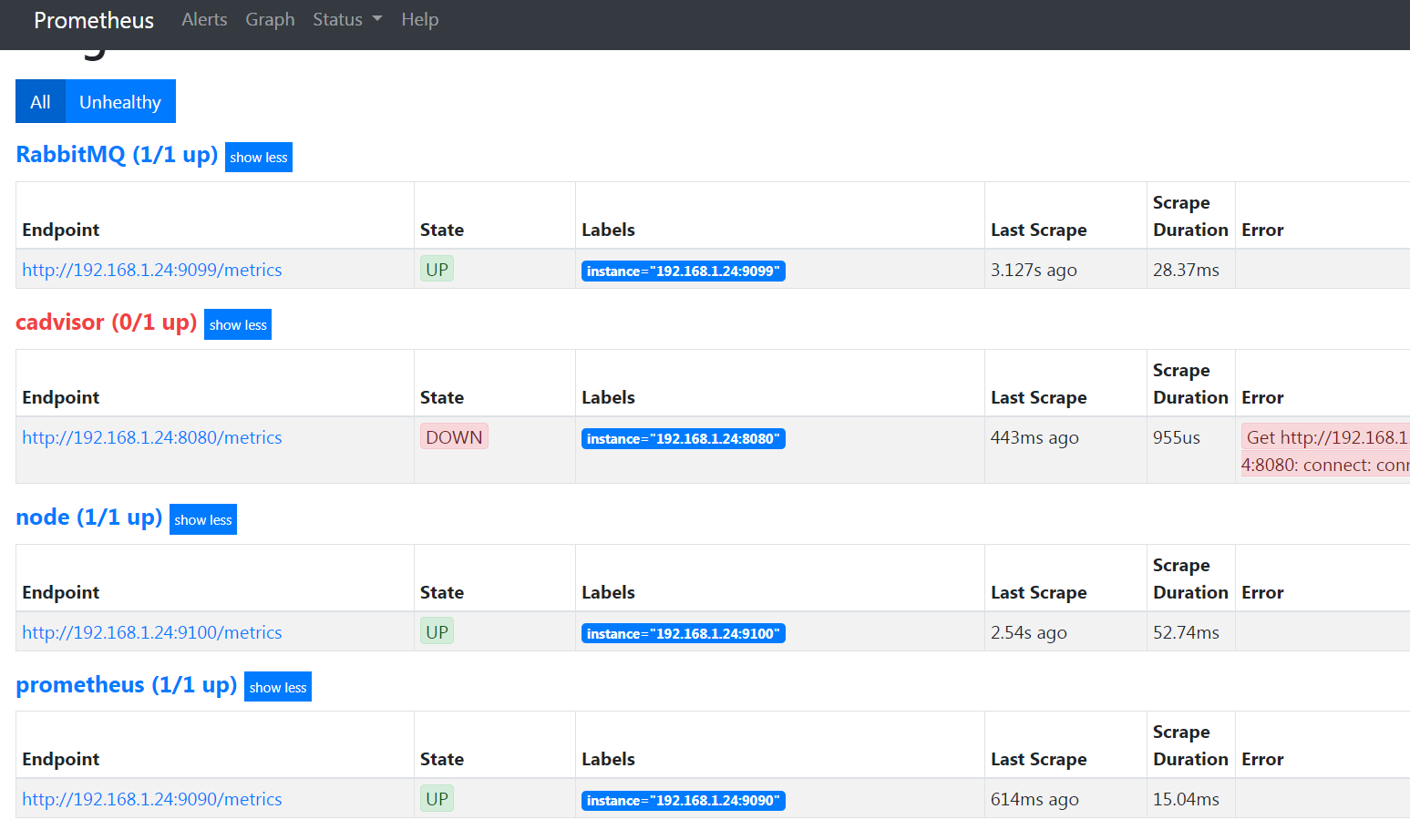

scrape_configs:

- job_name: 'prometheus'

scrape_interval: 5s

static_configs:

- targets: ['192.168.1.24:9090']

- job_name: 'node'

scrape_interval: 5s

static_configs:

- targets: ['192.168.1.24:9100']

- job_name: 'cadvisor'

scrape_interval: 5s

static_configs:

- targets: ['192.168.1.24:8080']

- job_name: 'RabbitMQ'

scrape_interval: 5s

static_configs:

- targets: ['192.168.1.24:9099']

start

docker-compose up -d

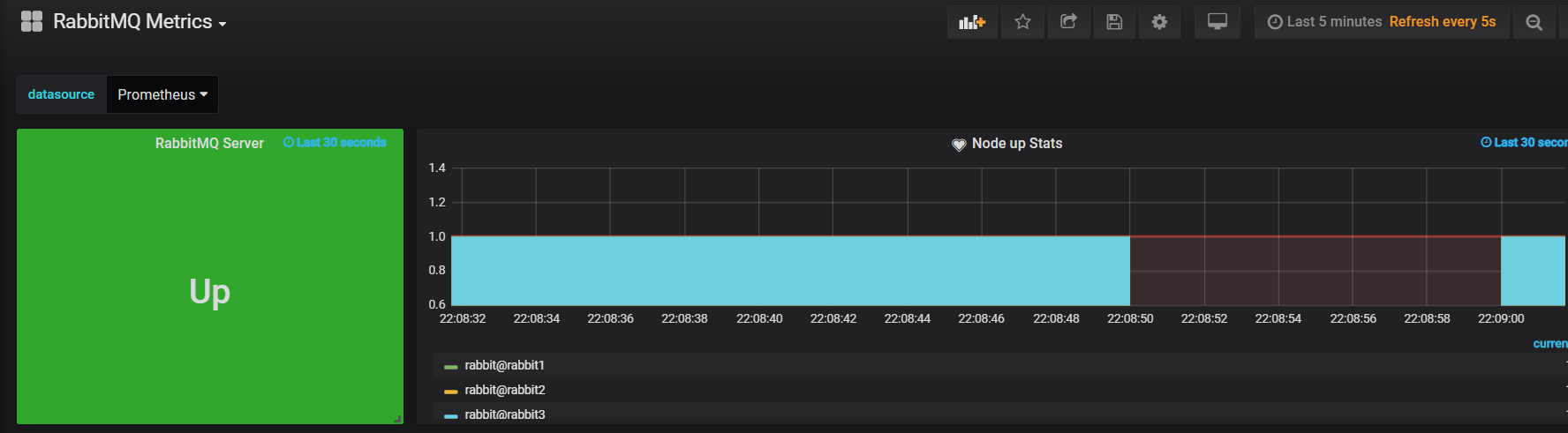

Rabbit Cluster

docker-compose

rabbit1:

image: bijukunjummen/rabbitmq-server:3.7.0

hostname: rabbit1

ports:

- "5672:5672"

- "15672:15672"

environment:

- RABBITMQ_DEFAULT_USER=admin

- RABBITMQ_DEFAULT_PASS=123456

volumes:

- /etc/timezone:/etc/timezone

- /etc/localtime:/etc/localtime

rabbit2:

image: bijukunjummen/rabbitmq-server:3.7.0

hostname: rabbit2

links:

- rabbit1

environment:

- CLUSTERED=true

- CLUSTER_WITH=rabbit1

- RAM_NODE=true

ports:

- "5673:5672"

- "15673:15672"

volumes:

- /etc/timezone:/etc/timezone

- /etc/localtime:/etc/localtime

rabbit3:

image: bijukunjummen/rabbitmq-server:3.7.0

hostname: rabbit3

links:

- rabbit1

- rabbit2

environment:

- CLUSTERED=true

- CLUSTER_WITH=rabbit1

ports:

- "5674:5672"

volumes:

- /etc/timezone:/etc/timezone

- /etc/localtime:/etc/localtime

start

docker-compose up -d

rabbitmq_exporter

https://github.com/kbudde/rabbitmq_exporter/releases

wget https://github.com/kbudde/rabbitmq_exporter/releases/download/v1.0.0-RC4/rabbitmq_exporter-1.0.0-RC4.linux-amd64.tar.gz

tar zxf rabbitmq_exporter-1.0.0-RC4.linux-amd64.tar.gz

start

RABBIT_USER=admin RABBIT_PASSWORD=123456 OUTPUT_FORMAT=JSON PUBLISH_PORT=9099 RABBIT_URL=http://192.168.1.24:15672 nohup ./rabbitmq_exporter &

cadvisor Error

Failed to start container manager: inotify_add_watch

/sys/fs/cgroup/cpuacct,cpu: no such file or directory

solution

mount -o remount,rw '/sys/fs/cgroup'

ln -s /sys/fs/cgroup/cpu,cpuacct /sys/fs/cgroup/cpuacct,cpu

grafana import Json File

https://grafana.com/dashboards/2121

Prometheus monitor RabbitMQ的更多相关文章

- 使用Prometheus和Grafana监控RabbitMQ集群 (使用RabbitMQ自带插件)

配置RabbitMQ集群 官方文档:https://www.rabbitmq.com/prometheus.html#quick-start 官方github地址:https://github.com ...

- RabbitMQ 3.7.X集群:从入门到精通,这一篇就够了

RabbitMQ是流行的开源消息队列系统,本身已经具备了较强的并发处理速度及运行稳定性,然而在大规模的实际应用中,往往还需要使用集群配置来保证系统中消息通信部分的高可用性,并发处理性能及异常恢复能力. ...

- Prometheus监控系统之入门篇(一)

1. 简介 Prometheus: (简称Prom)是由SoundCloud开发的开源监控报警系统.是大名鼎鼎的CNCF云原生基金会下的第二大开源项目.具有如下特点: 使用Go语言开发 内置时序数据库 ...

- 基于 Spring Cloud 完整的微服务架构实战

本项目是一个基于 Spring Boot.Spring Cloud.Spring Oauth2 和 Spring Cloud Netflix 等框架构建的微服务项目. @作者:Sheldon地址:ht ...

- AI云原生浅谈:好未来AI中台实践

AI时代的到来,给企业的底层IT资源的丰富与敏捷提出了更大的挑战,利用阿里云稳定.弹性的GPU云服务器,领先的GPU容器化共享和隔离技术,以及K8S集群管理平台,好未来通过云原生架构实现了对资源的灵活 ...

- Docker常用image

MySQL Start a mysql server instance Starting a MySQL instance is simple: docker run -itd --name mysq ...

- 08 . Prometheus+Grafana监控haproxy+rabbitmq

List CentOS7.3 prometheus-2.2.1.linux-amd64.tar.gz haproxy_exporter-0.11.0.linux-amd64.tar.gz 节点名 IP ...

- prometheus + grafana部署RabbitMQ监控

prometheus + grafana部署RabbitMQ监控 1.grafana导入dashboards https://grafana.com/dashboards/2121 2.expor ...

- Monitor Minio server with Prometheus

转自:https://blog.minio.io/monitor-minio-server-with-prometheus-4ed537abcb74 Prometheus is an open sou ...

随机推荐

- idea 快捷键 pvsm sout

1.在IntelJ中和Eclipse中稍有不同,在Eclipse中,输入main再按Alt+/即可自动补全main函数,但是在IntellJ中则是输入psvm,选中即可 2.在方法体内部有for循环, ...

- hadoop(十)hdfs上传删除文件(完全分布式七)|12

集群测试 上传小文件到集群,随便选择一个小文件上传到hdfs的根目录 [shaozhiqi@hadoop102 hadoop-3.1.2]$ bin/hdfs dfs -put wcinput/wc. ...

- 一个不错的spring 学习博客

http://www.iteye.com/blogs/subjects/spring-tittle-tattle

- python从零开始基础入门——开发环境搭建:Visual Studio Code

前言 文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者:山海皆可平z PS:如有需要Python学习资料的小伙伴可以加点击下方 ...

- 你只要5行代码,拥有你的个性二维码,用Python生成动态二维码

如果想了解更多关于python的应用,可以私信我,或者点击下方链接自行获取,里面到资料都是免费的(http://t.cn/A6Zvjdun) 二维码满天飞,但是有没有想过Python也能制作出专属于自 ...

- vue的组件通讯

Vue的组件通讯又称组件传值 一.父子组件传值: 父组件: <子组件名 :动态变量名 (随便起)='你想要传递的数据' ></子组件名> 子组件: 利用 prop去接收父组 ...

- 基于 HTML5 WebGL 的高炉炼铁厂可视化系统

前言 在当今 工业4.0 新时代的推动下,不仅迎来了 工业互联网 的发展,还开启了 5G 时代的新次元.而伴随着带宽的提升,网络信息飞速发展,能源管控上与实时预警在工业互联网中也占着举足轻 ...

- Os-Hax: 1 靶机记录

靶机地址:172.16.1.197 Kali地址:172.16.1.108 1 信息搜集 靶机首页 相关信息查看 端口扫描: 开放22和80 目录扫描: 访问http://172.16.1.197/c ...

- 【5min+】为你的.NET应用进行一次全方位体检

系列介绍 [五分钟的dotnet]是一个利用您的碎片化时间来学习和丰富.net知识的博文系列.它所包含了.net体系中可能会涉及到的方方面面,比如C#的小细节,AspnetCore,微服务中的.net ...

- orcale 树形结构查询

接到需求是要在一个表中(表结构为主键id和父id)循环显示数据,类似于省市县++这种情况 也可能不只有三级子菜单 id name parentid 1 a 0 2 ...