Hadoop 历史服务配置启动查看

历史服务配置启动查看

1)配置mapred-site.xml

|

<property> <name>mapreduce.jobhistory.address</name> <value>hadoop-001:10020</value> </property> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>hadoop-001:19888</value> </property> |

2)查看启动历史服务器文件目录:

[hadoop@hadoop-001 hadoop-2.7.2]# ls sbin/ |grep mr

mr-jobhistory-daemon.sh

3)启动历史服务器

sbin/mr-jobhistory-daemon.sh start historyserver

4)查看历史服务器是否启动

jps

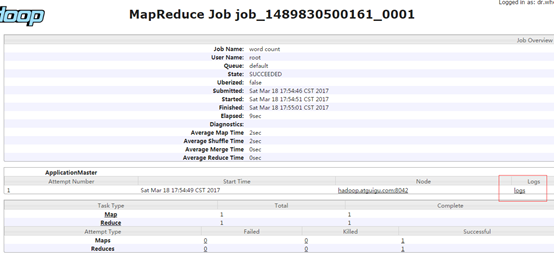

5)查看jobhistory

http://hadoop-001:19888/jobhistory

日志的聚集

日志聚集概念:应用运行完成以后,将日志信息上传到HDFS系统上

开启日志聚集功能步骤:

(1)配置yarn-site.xml

|

<!-- 日志聚集功能使能 --> <property> <name>yarn.log-aggregation-enable</name> <value>true</value> </property> <!-- 日志保留时间设置7天 --> <property> <name>yarn.log-aggregation.retain-seconds</name> <value>604800</value> </property> |

(2)关闭nodemanager 、resourcemanager和historymanager

sbin/yarn-daemon.sh stop resourcemanager

sbin/yarn-daemon.sh stop nodemanager

sbin/mr-jobhistory-daemon.sh stop historyserver

(3)启动nodemanager 、resourcemanager和historymanager

sbin/yarn-daemon.sh start resourcemanager

sbin/yarn-daemon.sh start nodemanager

sbin/mr-jobhistory-daemon.sh start historyserver

(4)删除hdfs上已经存在的hdfs文件

bin/hdfs dfs -rm -R /gec/mapreduce/wordcount/output

(5)执行wordcount程序

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount /gec/mapreduce/wordcount/input /gec/mapreduce/wordcount/output

(6)查看日志

http://hadoop-001:19888/jobhistory

Hadoop 历史服务配置启动查看的更多相关文章

- Mapreduce 历史服务 配置启动查看

如果没有进行配置的话,那个History是不可以进行点击的,点击进去就会报错!所以需要进行配置一下 使用命令启动HistoryServer 就可以查看任务执行的进度了 命令: sbin/mr-jobh ...

- hadoop历史服务的启动与停止

a.配置项(在分布式环境中配置) 1.RPC访问地址 mapreduce.jobhistory.address 2.HTTP访问地址 mapreduce.jobhistory.webapp.addre ...

- 配置spark历史服务(spark二)

1. 编辑spark-defaults.conf位置文件 添加spark.eventLog.enabled和spark.eventLog.dir的配置修改spark.eventLog.dir为我们之前 ...

- 【转载】Hadoop历史服务器详解

免责声明: 本文转自网络文章,转载此文章仅为个人收藏,分享知识,如有侵权,请联系博主进行删除. 原文作者:过往记忆(http://www.iteblog.com/) 原文地址: ...

- 初识Hadoop一,配置及启动服务

一.Hadoop简介: Hadoop是由Apache基金会所开发的分布式系统基础架构,实现了一个分布式文件系统(Hadoop Distributed File System),简称HDFS:Hadoo ...

- hadoop配置历史服务器&&配置日志聚集

配置历史服务器 1.在mapred-site.xml中写入一下配置 <property> <name>mapreduce.jobhistory.address</name ...

- linux服务创建及jq配置服务列表查看

1.应用背景 随着业务需求,后台处理服务不断增多,对于这些服务或后台程序的查看.更新操作越来越凌乱,所以我们首先需要一个服务列表查看工具,方便查看各 服务的端口.运行状态.jar包路径等等. 2.创建 ...

- 马士兵hadoop第四课:Yarn和Map/Reduce配置启动和原理讲解

马士兵hadoop第一课:虚拟机搭建和安装hadoop及启动 马士兵hadoop第二课:hdfs集群集中管理和hadoop文件操作 马士兵hadoop第三课:java开发hdfs 马士兵hadoop第 ...

- 马士兵hadoop第四课:Yarn和Map/Reduce配置启动和原理讲解(转)

马士兵hadoop第一课:虚拟机搭建和安装hadoop及启动 马士兵hadoop第二课:hdfs集群集中管理和hadoop文件操作 马士兵hadoop第三课:java开发hdfs 马士兵hadoop第 ...

随机推荐

- Delphi 10.3实现Android App的动态权限申请

Delphi 10.3 RIO发布近两个月,针对Google Play的要求,完美实现了对Android 8的支持,即对Android API Level 26的支持.这支持当中,最主要的得算是动态申 ...

- django面试四

Django的优点 功能完善.要素齐全:自带大量常用工具和框架(比如分页,auth,权限管理), 适合快速开发企业级网站. 完善的文档:经过十多年的发展和完善,Django有广泛的实践案例和完善的在线 ...

- JAVA线程sleep与wait区别

sleep就是正在执行的线程主动让出cpu,cpu去执行其他线程,在sleep指定的时间过后,cpu才会回到这个线程上继续往下执行,如果当前线程进入了同步锁,sleep方法并不会释放锁,即使当前线程使 ...

- 【Python】一些零散的练习

#练习:subprocess模块来产生子进程 import subprocess obj = subprocess.Popen(["python"], stdin=subproce ...

- socket 映射服务器程序

server #include <stdio.h> #include <sys/types.h> /* See NOTES */ #include <sys/socket ...

- INS-20802 Oracle Cluster Verification Utility failed解释说明

背景:安装RAC,安装GI集群管理软件时,在最后快结束时,总是报如上INS-错误 #官方文档:error 说明;字符串解析失败 INS-20802: string failed. Cause: The ...

- word2vec原理推导与代码分析

https://github.com/hankcs/HanLP/wiki/word2vec http://www.hankcs.com/nlp/word2vec.html Hanlp word2vec ...

- js中三种定义变量的方式const, var, let的区别。

const var let区别 1.const 定义的变量不可以修改,而且必须初始化 const a = 3;正确 const a;错误,必须初始化 console.log("函数外c ...

- Math.floor(-8.5)=多少?

Math.floor() 表示向下取整,返回double类型 (floor---地板) Math.ceil() 表示向上取整,返回double类型 (ceil---天花板) Ma ...

- 【spring源码分析】spring ioc容器之前生今世--DefaultListableBeanFactory源码解读

spring Ioc容器的实现,从根源上是beanfactory,但真正可以作为一个可以独立使用的ioc容器还是DefaultListableBeanFactory,因此可以这么说, DefaultL ...