[Localization] MobileNet with SSD

先来一波各版本性能展览:

Pre-trained Models

Choose the right MobileNet model to fit your latency and size budget. The size of the network in memory and on disk is proportional to the number of parameters. The latency and power usage of the network scales with the number of Multiply-Accumulates (MACs) which measures the number of fused Multiplication and Addition operations. These MobileNet models have been trained on the ILSVRC-2012-CLS image classification dataset. Accuracies were computed by evaluating using a single image crop.

| Model Checkpoint | Million MACs | Million Parameters | Top-1 Accuracy | Top-5 Accuracy |

|---|---|---|---|---|

| MobileNet_v1_1.0_224 | 569 | 4.24 | 70.7 | 89.5 |

| MobileNet_v1_1.0_192 | 418 | 4.24 | 69.3 | 88.9 |

| MobileNet_v1_1.0_160 | 291 | 4.24 | 67.2 | 87.5 |

| MobileNet_v1_1.0_128 | 186 | 4.24 | 64.1 | 85.3 |

| MobileNet_v1_0.75_224 | 317 | 2.59 | 68.4 | 88.2 |

| MobileNet_v1_0.75_192 | 233 | 2.59 | 67.4 | 87.3 |

| MobileNet_v1_0.75_160 | 162 | 2.59 | 65.2 | 86.1 |

| MobileNet_v1_0.75_128 | 104 | 2.59 | 61.8 | 83.6 |

| MobileNet_v1_0.50_224 | 150 | 1.34 | 64.0 | 85.4 |

| MobileNet_v1_0.50_192 | 110 | 1.34 | 62.1 | 84.0 |

| MobileNet_v1_0.50_160 | 77 | 1.34 | 59.9 | 82.5 |

| MobileNet_v1_0.50_128 | 49 | 1.34 | 56.2 | 79.6 |

| MobileNet_v1_0.25_224 | 41 | 0.47 | 50.6 | 75.0 |

| MobileNet_v1_0.25_192 | 34 | 0.47 | 49.0 | 73.6 |

| MobileNet_v1_0.25_160 | 21 | 0.47 | 46.0 | 70.7 |

| MobileNet_v1_0.25_128 | 14 | 0.47 | 41.3 | 66.2 |

前两个大小还是可以接受的。

Here is an example of how to download the MobileNet_v1_1.0_224 checkpoint:

$ CHECKPOINT_DIR=/tmp/checkpoints

$ mkdir ${CHECKPOINT_DIR}

$ wget http://download.tensorflow.org/models/mobilenet_v1_1.0_224_2017_06_14.tar.gz

$ tar -xvf mobilenet_v1_1.0_224_2017_06_14.tar.gz

$ mv mobilenet_v1_1.0_224.ckpt.* ${CHECKPOINT_DIR}

$ rm mobilenet_v1_1.0_224_2017_06_14.tar.gz

代码于此,未来需研究一波。

models/research/slim/nets/mobilenet_v1.py

传统卷积-->分离成每个通道的单滤波器卷积 then 与每个pixel的1*1卷积做合并。可以提高至少十倍性能!

Ref: http://www.jianshu.com/p/072faad13145

Ref: http://blog.csdn.net/jesse_mx/article/details/70766871

摘要

- 使用深度可分解卷积(depthwise separable convolutions)来构建轻量级深度神经网络的精简结构(streamlined architecture,流线型结构 or 精简结构,倾向于后者)。

- 本文引入了两个 简单的全局超参来有效权衡延迟(latency)和准确度(accuracy)。这些超参允许模型构建者根据具体问题的限制为他们的应用选择规模合适的模型。

1.引言

2.背景介绍

1)直接设计较小且高效的网络,并训练。

- Inception思想,采用小卷积。

- Network in Network 改进传统CNN,使用1x1卷积,提出MLP CONV层Deep Fried Convents采用Adaptive Fast-food transform重新 参数化全连接层的向量矩阵。

- SqueezeNet设计目标主要是为了简化CNN的模型参数数量,主要采用了替换卷积核3x3为1x1,使用了deep compression技术对网络进行了压缩 。

- Flattened networks针对快速前馈执行设计的扁平神经网络。

- 采用hashing trick进行压缩;采用huffman编码;

- 用大网络来教小网络;

- 训练低精度乘法器;

- 采用二进制输入二进制权值等等。

3.MobileNet 架构

- 深度可分解滤波(depth wise separable filters)建立的MobileNets核心层;

- 两个模型收缩超参:宽度乘法器和分辨率乘法器(width multiplier和resolution multiplier)。

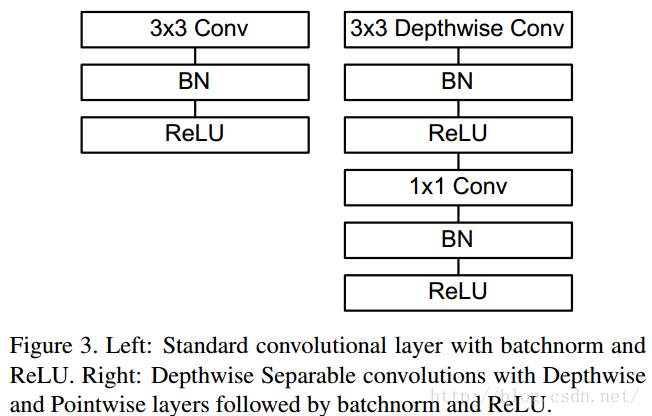

3.1.深度可分解卷积(Depthwise Separable Convolution)

MobileNet模型机遇深度可分解卷积,其可以将标准卷积分解成 一个深度卷积和一个1x1的点卷积。

3.2. 网络结构和训练

对应的api:https://www.tensorflow.org/versions/r0.12/api_docs/python/nn/convolution

tf.nn.depthwise_conv2d(input, filter, strides, padding, name=None)

3.3.宽度乘法器(Width Multiplier)

第一个超参数,即宽度乘数 α 。

为了构建更小和更少计算量的网络,引入了宽度乘数 α ,改变输入输出通道数,减少特征图数量,让网络变瘦。

在 α 参数作用下,MobileNets某一层的计算量为:

其中, α 取值是0~1,应用宽度乘数可以进一步减少计算量,大约有 α2 的优化空间。

3.4. 分辨率乘法器(Resolution Multiplier)

第二个超参数是分辨率乘数 ρ

用来改变输入数据层的分辨率,同样也能减少参数。

在 α 和 ρ 共同作用下,MobileNets某一层的计算量为:

DK×DK×αM×ρDF×ρDF + αM×αN×ρDF×ρDF

其中,ρ 是隐式参数,ρ 如果为{1,6/7,5/7,4/7},则对应输入分辨率为{224,192,160,128},ρ 参数的优化空间同样是 ρ2 左右。

以上就是重点。

Final Report: Towards Real-time Detection and Camera Triggering

在草莓pi上各个轻网络的的实验效果,其中有介绍剪裁网络的思路,提供了很多线索,挺好。

以及对mobileNet结构的微调方法。

The main thing that makes MobileNets stand out is its use of depthwise separable convolution (DSC) layer.

The Intuition behind DSC: studies [2] have showed that DSC can be treated as an extreme case of inception module.

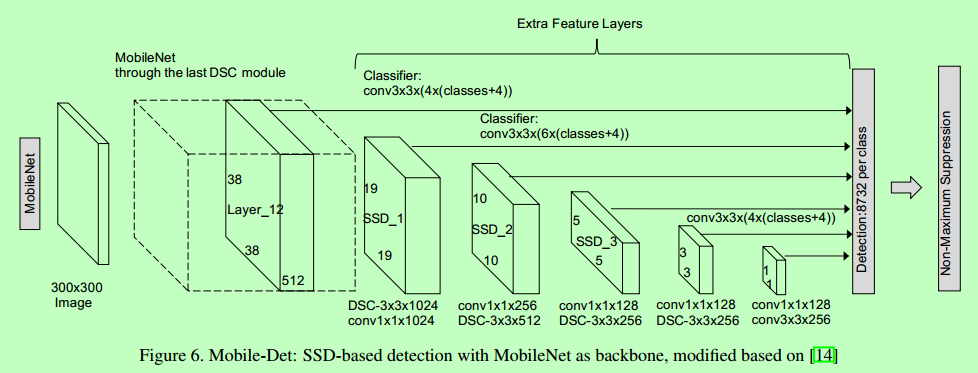

The structure of Mobile-Det is similar to ssd-vgg-300: [Localization] SSD - Single Shot MultiBoxDetector the original SSD framework.

- The difference is that rather than using VGG, now the backbone is MobileNets,

- and also all the following added convolution is replaced with depthwise separable convolution.

The benefit of using SSD framework is evident:

now we have a unified model and is able to train end-to-end;

we do not rely on the reference frame and hence the temporal information, expanding our application scenarios;

it is also more accurate in theory.

However, the main issue is that, the model becomes very slow, as a large amount of convolution operations are added.

In this project, we tested a variety of detection models, including the state-of-art YOLO2, and two our newly proposed models: Temporal Detection and Mobile-Det.

We conclude that the current object detection methods, although accurate, is far from being able to be deployed in real-world applications due to large model size and slow speed.

Our work of Mobile-Det shows that the combination of SSD and MobileNet provides a new feasible and promising insight on seeking a faster detection framework.

Finally, we present the power of temporal information and shows differential based region proposal can drastically increase the detection speed.

7. Future work

There are a few aspects that could potentially improve the performance but remains to be implemented due to limited time, including:

• Implement an efficient inference module of 8bit float in C++ to better take advantage of the speed up of quantization to inference step on small device.

• Try to combine designed CNN modules like MobileNet module and fire module with other real-time standard detection frameworks.

【fire layer貌似不好使,有实验已测试】

今后课题:

- 如何训练识别两个以上的物体。

- 使用传统算子生成训练集。

[Localization] MobileNet with SSD的更多相关文章

- 本人AI知识体系导航 - AI menu

Relevant Readable Links Name Interesting topic Comment Edwin Chen 非参贝叶斯 徐亦达老板 Dirichlet Process 学习 ...

- [Localization] SSD - Single Shot MultiBoxDetector

Prerequisite: VGG Ref: [Object Tracking] Localization and Detection SSD Paper: http://lib.csdn.net/a ...

- [Localization] R-CNN series for Localization and Detection

CS231n Winter 2016: Lecture 8 : Localization and Detection CS231n Winter 2017: Lecture 11: Detection ...

- 深度学习入门篇--手把手教你用 TensorFlow 训练模型

欢迎大家前往腾讯云技术社区,获取更多腾讯海量技术实践干货哦~ 作者:付越 导语 Tensorflow在更新1.0版本之后多了很多新功能,其中放出了很多用tf框架写的深度网络结构(https://git ...

- tensorflow利用预训练模型进行目标检测(一):安装tensorflow detection api

一.tensorflow安装 首先系统中已经安装了两个版本的tensorflow,一个是通过keras安装的, 一个是按照官网教程https://www.tensorflow.org/install/ ...

- 百度大脑EasyEdge端模型生成部署攻略

EasyEdge是百度基于Paddle Mobile研发的端计算模型生成平台,能够帮助深度学习开发者将自建模型快速部署到设备端.只需上传模型,最快2分种即可生成端计算模型并获取SDK.本文介绍Easy ...

- SSD: Single Shot MultiBox Detector

By Wei Liu, Dragomir Anguelov, Dumitru Erhan, Christian Szegedy, Scott Reed, Cheng-Yang Fu, Alexande ...

- SSD: Single Shot MultiBoxDetector英文论文翻译

SSD英文论文翻译 SSD: Single Shot MultiBoxDetector 2017.12.08 摘要:我们提出了一种使用单个深层神经网络检测图像中对象的方法.我们的方法,名为SSD ...

- 深度学习笔记(七)SSD 论文阅读笔记简化

一. 算法概述 本文提出的SSD算法是一种直接预测目标类别和bounding box的多目标检测算法.与faster rcnn相比,该算法没有生成 proposal 的过程,这就极大提高了检测速度.针 ...

随机推荐

- RouterOS双线进行IP分流上网

环境: 1.第一条:电信静态IP,一级路由分配的IP:第二条:移动光纤 2.通过指定某些IP走电信,某些走移动 注意: 1.当有多条线路进行NAT伪装时,Out. Interface这个必须选择具体的 ...

- [Beego模型] 六、事务处理

[Beego模型] 一.ORM 使用方法 [Beego模型] 二.CRUD 操作 [Beego模型] 三.高级查询 [Beego模型] 四.使用SQL语句进行查询 [Beego模型] 五.构造查询 [ ...

- Makefile 中的.PHONY

PHONY 目标并非实际的文件名:只是在显式请求时执行命令的名字.有两种理由需要使用PHONY 目标:避免和同名文件冲突,改善性能. 所谓的PHONY这个单词就是伪造的意思,makefile中将.PH ...

- jstl 格式化

一:JSTL格式化标签又称为I18N标签库,主要用来编写国际化的WEB应用,使用此功能可以对一个特定的语言请求做出合适的处理.例如:中国内地用户将显示简体中文,台湾地区则显示繁体中文,使用I18N格式 ...

- orocos_kdl学习(二):KDL Tree与机器人运动学

KDL(Kinematics and Dynamics Library)中定义了一个树来代表机器人的运动学和动力学参数,ROS中的kdl_parser提供了工具能将机器人描述文件URDF转换为KDL ...

- python3用BeautifulSoup用re.compile来匹配需要抓取的href地址

# -*- coding:utf-8 -*- #python 2.7 #XiaoDeng #http://tieba.baidu.com/p/2460150866 #标签操作 from bs4 imp ...

- 【Linux】ps命令

Linux中的ps命令是Process Status的缩写.ps命令用来列出系统中当前运行的那些进程.ps命令列出的是当前那些进程的快照,就是执行ps命令的那个时刻的那些进程,如果想要动态的显示进程信 ...

- C++11 列表初始化

在我们实际编程中,我们经常会碰到变量初始化的问题,对于不同的变量初始化的手段多种多样,比如说对于一个数组我们可以使用 int arr[] = {1,2,3}的方式初始化,又比如对于一个简单的结构体: ...

- “RESOURCE MONITOR“CPU占用特别高

背景: SQL Server 2008 R2 10.50.1600 没有设置页面文件,内存为64G,数据库分配50G cpu使用占了50%以上,平时只有10-20%,某台服务器“RESOURCE MO ...

- 自己实现字符串转整数(不使用JDK的字符串转整数的方法)

[需求]: (1)如果输入的字符串为null,为空,或者不是数字,抛出异常: (2)如果输入的数字超出int的最大值或最小值,抛出异常: (3)输入的数字允许以+或-号开头,但如果输入的字符串只有&q ...