[ Openstack ] Openstack-Mitaka 高可用之 Pacemaker+corosync+pcs 高可用集群

目录

Openstack-Mitaka 高可用之 概述

Openstack-Mitaka 高可用之 环境初始化

Openstack-Mitaka 高可用之 Mariadb-Galera集群部署

Openstack-Mitaka 高可用之 Rabbitmq-server 集群部署

Openstack-Mitaka 高可用之 memcache

Openstack-Mitaka 高可用之 Pacemaker+corosync+pcs高可用集群

Openstack-Mitaka 高可用之 认证服务(keystone)

OpenStack-Mitaka 高可用之 镜像服务(glance)

Openstack-Mitaka 高可用之 计算服务(Nova)

Openstack-Mitaka 高可用之 网络服务(Neutron)

Openstack-Mitaka 高可用之 Dashboard

Openstack-Mitaka 高可用之 启动一个实例

Openstack-Mitaka 高可用之 测试

介绍及特点

Pacemaker:工作在资源分配层,提供资源管理器的功能

Corosync:提供集群的信息层功能,传递心跳信息和集群事务信息

Pacemaker + Corosync 就可以实现高可用集群架构

集群搭建

以下三个节点都需要执行:

# yum install pcs -y

# systemctl start pcsd ; systemctl enable pcsd

# echo 'hacluster' | passwd --stdin hacluster

# yum install haproxy rsyslog -y

# echo 'net.ipv4.ip_nonlocal_bind = 1' >> /etc/sysctl.conf # 启动服务的时候,允许忽视VIP的存在

# echo 'net.ipv4.ip_forward = 1' >> /etc/sysctl.conf # 开启内核转发功能

# sysctl -p

在任意节点创建用于haproxy监控Mariadb的用户

MariaDB [(none)]> CREATE USER 'haproxy'@'%' ;

配置haproxy用于负载均衡器

[root@controller1 ~]# egrep -v "^#|^$" /etc/haproxy/haproxy.cfg

log 127.0.0.1 local2

chroot /var/lib/haproxy

pidfile /var/run/haproxy.pid

maxconn

user haproxy

group haproxy

daemon

# turn on stats unix socket

stats socket /var/lib/haproxy/stats

defaults

mode http

log global

option httplog

option dontlognull

option http-server-close

option forwardfor except 127.0.0.0/

option redispatch

retries

timeout http-request 10s

timeout queue 1m

timeout connect 10s

timeout client 1m

timeout server 1m

timeout http-keep-alive 10s

timeout check 10s

maxconn

listen galera_cluster

mode tcp

bind 192.168.0.10:

balance source

option mysql-check user haproxy

server controller1 192.168.0.11: check inter rise fall backup

server controller2 192.168.0.12: check inter rise fall

server controller3 192.168.0.13: check inter rise fall backup listen memcache_cluster

mode tcp

bind 192.168.0.10:

balance source

option tcplog

server controller1 192.168.0.11: check inter rise fall

server controller2 192.168.0.12: check inter rise fall

server controller3 192.168.0.13: check inter rise fall

注意:

(1)确保haproxy配置无误,建议首先修改ip和端口启动测试是否成功。

(2)Mariadb-Galera和rabbitmq默认监听到 0.0.0.0 修改调整监听到本地 192.168.0.x

(3)将haproxy正确的配置拷贝到其他节点,无需手动启动haproxy服务

为haproxy配置日志(所有controller节点执行):

# vim /etc/rsyslog.conf

…

$ModLoad imudp

$UDPServerRun

…

local2.* /var/log/haproxy/haproxy.log

… # mkdir -pv /var/log/haproxy/

mkdir: created directory ‘/var/log/haproxy/’ # systemctl restart rsyslog

启动haproxy进行验证操作:

# systemctl start haproxy

[root@controller1 ~]# netstat -ntplu | grep ha

tcp 192.168.0.10: 0.0.0.0:* LISTEN /haproxy

tcp 192.168.0.10: 0.0.0.0:* LISTEN /haproxy

udp 0.0.0.0: 0.0.0.0:* /haproxy 验证成功,关闭haproxy

# systemctl stop haproxy

在controller1节点上执行:

[root@controller1 ~]# pcs cluster auth controller1 controller2 controller3 -u hacluster -p hacluster --force

controller3: Authorized

controller2: Authorized

controller1: Authorized

创建集群:

[root@controller1 ~]# pcs cluster setup --name openstack-cluster controller1 controller2 controller3 --force

Destroying cluster on nodes: controller1, controller2, controller3...

controller3: Stopping Cluster (pacemaker)...

controller2: Stopping Cluster (pacemaker)...

controller1: Stopping Cluster (pacemaker)...

controller3: Successfully destroyed cluster

controller1: Successfully destroyed cluster

controller2: Successfully destroyed cluster Sending 'pacemaker_remote authkey' to 'controller1', 'controller2', 'controller3'

controller3: successful distribution of the file 'pacemaker_remote authkey'

controller1: successful distribution of the file 'pacemaker_remote authkey'

controller2: successful distribution of the file 'pacemaker_remote authkey'

Sending cluster config files to the nodes...

controller1: Succeeded

controller2: Succeeded

controller3: Succeeded Synchronizing pcsd certificates on nodes controller1, controller2, controller3...

controller3: Success

controller2: Success

controller1: Success

Restarting pcsd on the nodes in order to reload the certificates...

controller3: Success

controller2: Success

controller1: Success

启动集群的所有节点:

[root@controller1 ~]# pcs cluster start --all

controller2: Starting Cluster...

controller1: Starting Cluster...

controller3: Starting Cluster...

[root@controller1 ~]# pcs cluster enable --all

controller1: Cluster Enabled

controller2: Cluster Enabled

controller3: Cluster Enabled

查看集群信息:

[root@controller1 ~]# pcs status

Cluster name: openstack-cluster

WARNING: no stonith devices and stonith-enabled is not false

Stack: corosync

Current DC: controller3 (version 1.1.-.el7_4.-94ff4df) - partition with quorum

Last updated: Thu Nov ::

Last change: Thu Nov :: by hacluster via crmd on controller3 nodes configured

resources configured Online: [ controller1 controller2 controller3 ] No resources Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

[root@controller1 ~]# pcs cluster status

Cluster Status:

Stack: corosync

Current DC: controller3 (version 1.1.-.el7_4.-94ff4df) - partition with quorum

Last updated: Thu Nov ::

Last change: Thu Nov :: by hacluster via crmd on controller3

nodes configured

resources configured PCSD Status:

controller2: Online

controller3: Online

controller1: Online

三个节点都在线

默认的表决规则建议集群中的节点个数为奇数且不低于3。当集群只有2个节点,其中1个节点崩坏,由于不符合默认的表决规则,集群资源不发生转移,集群整体仍不可用。no-quorum-policy="ignore"可以解决此双节点的问题,但不要用于生产环境。换句话说,生产环境还是至少要3节点。

pe-warn-series-max、pe-input-series-max、pe-error-series-max代表日志深度。

cluster-recheck-interval是节点重新检查的频率。

[root@controller1 ~]# pcs property set pe-warn-series-max= pe-input-series-max= pe-error-series-max= cluster-recheck-interval=5min

禁用stonith:

stonith是一种能够接受指令断电的物理设备,环境无此设备,如果不关闭该选项,执行pcs命令总是含其报错信息。

[root@controller1 ~]# pcs property set stonith-enabled=false

二个节点时,忽略节点quorum功能:

[root@controller1 ~]# pcs property set no-quorum-policy=ignore

验证集群配置信息

[root@controller1 ~]# crm_verify -L -V

为集群配置虚拟 ip

[root@controller1 ~]# pcs resource create ClusterIP ocf:heartbeat:IPaddr2 \

ip="192.168.0.10" cidr_netmask= nic=eno16777736 op monitor interval=30s

到此,Pacemaker+corosync 是为 haproxy服务的,添加haproxy资源到pacemaker集群

[root@controller1 ~]# pcs resource create lb-haproxy systemd:haproxy --clone

说明:创建克隆资源,克隆的资源会在全部节点启动。这里haproxy会在三个节点自动启动。

查看Pacemaker资源情况

[root@controller1 ~]# pcs resource

ClusterIP (ocf::heartbeat:IPaddr2): Started controller1 # 心跳的资源绑定在第三个节点的

Clone Set: lb-haproxy-clone [lb-haproxy] # haproxy克隆资源

Started: [ controller1 controller2 controller3 ]

注意:这里一定要进行资源绑定,否则每个节点都会启动haproxy,造成访问混乱

将这两个资源绑定到同一个节点上

[root@controller1 ~]# pcs constraint colocation add lb-haproxy-clone ClusterIP INFINITY

绑定成功

[root@controller1 ~]# pcs resource

ClusterIP (ocf::heartbeat:IPaddr2): Started controller3

Clone Set: lb-haproxy-clone [lb-haproxy]

Started: [ controller1]

Stopped: [ controller2 controller3 ]

配置资源的启动顺序,先启动vip,然后haproxy再启动,因为haproxy是监听到vip

[root@controller1 ~]# pcs constraint order ClusterIP then lb-haproxy-clone

手动指定资源到某个默认节点,因为两个资源绑定关系,移动一个资源,另一个资源自动转移。

[root@controller1 ~]# pcs constraint location ClusterIP prefers controller1

[root@controller1 ~]# pcs resource

ClusterIP (ocf::heartbeat:IPaddr2): Started controller1

Clone Set: lb-haproxy-clone [lb-haproxy]

Started: [ controller1 ]

Stopped: [ controller2 controller3 ]

[root@controller1 ~]# pcs resource defaults resource-stickiness= # 设置资源粘性,防止自动切回造成集群不稳定

现在vip已经绑定到controller1节点

[root@controller1 ~]# ip a | grep global

inet 192.168.0.11/ brd 192.168.0.255 scope global eno16777736

inet 192.168.0.10/ brd 192.168.0.255 scope global eno16777736

inet 192.168.118.11/ brd 192.168.118.255 scope global eno33554992

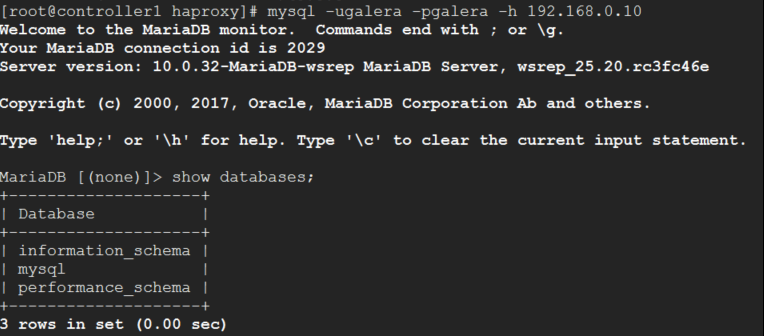

尝试通过vip连接数据库

Controller1:

[root@controller1 haproxy]# mysql -ugalera -pgalera -h 192.168.0.10

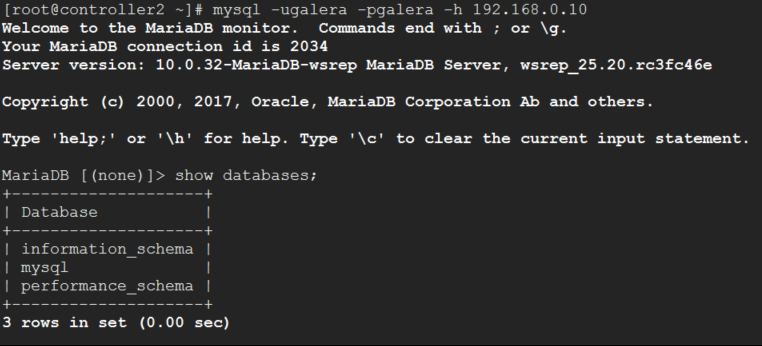

Controller2:

高可用配置成功。

测试高可用是否正常

在controller1节点上直接执行 poweroff -f

[root@controller1 ~]# poweroff -f

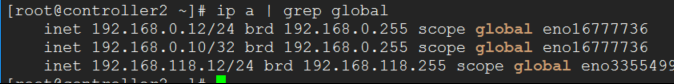

vip很快就转移到controller2节点上

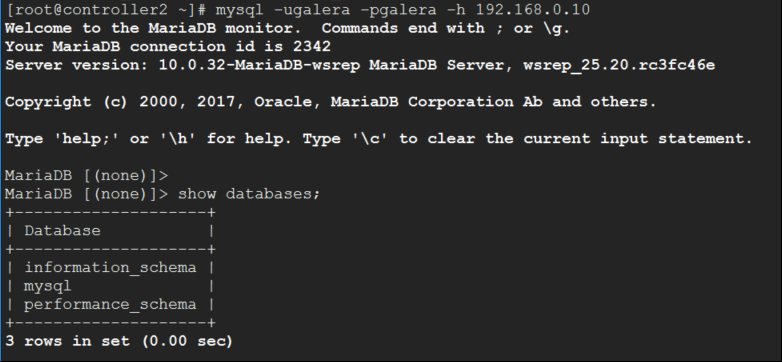

再次尝试访问数据库

无任何问题,测试成功。

查看集群信息:

[root@controller2 ~]# pcs status

Cluster name: openstack-cluster

Stack: corosync

Current DC: controller3 (version 1.1.-.el7_4.-94ff4df) - partition with quorum

Last updated: Thu Nov ::

Last change: Thu Nov :: by root via crm_attribute on controller1 nodes configured

resources configured Online: [ controller2 controller3 ]

OFFLINE: [ controller1 ] # controller1 已经下线 Full list of resources: ClusterIP (ocf::heartbeat:IPaddr2): Started controller2

Clone Set: lb-haproxy-clone [lb-haproxy]

Started: [ controller2 ]

Stopped: [ controller1 controller3 ] Daemon Status:

corosync: active/enabled

pacemaker: active/enabled

pcsd: active/enabled

[ Openstack ] Openstack-Mitaka 高可用之 Pacemaker+corosync+pcs 高可用集群的更多相关文章

- mfs分布式文件系统,分布式存储,高可用(pacemaker+corosync+pcs),磁盘共享(iscsi),fence解决脑裂问题

一.MFS概述 MooseFS是一个分布式存储的框架,其具有如下特性:(1)通用文件系统,不需要修改上层应用就可以使用(那些需要专门api的dfs很麻烦!).(2)可以在线扩容,体系架构可伸缩性极强. ...

- 【Linux运维-集群技术进阶】Nginx+Keepalived+Tomcat搭建高可用/负载均衡/动静分离的Webserver集群

额.博客名字有点长.. . 前言 最终到这篇文章了,心情是有点激动的. 由于这篇文章会集中曾经博客讲到的全部Nginx功能点.包含主要的负载均衡,还有动静分离技术再加上这篇文章的重点.通过Keepal ...

- centos7.4安装高可用(haproxy+keepalived实现)kubernetes1.6.0集群(开启TLS认证)

目录 目录 前言 集群详情 环境说明 安装前准备 提醒 一.创建TLS证书和秘钥 安装CFSSL 创建 CA (Certificate Authority) 创建 CA 配置文件 创建 CA 证书签名 ...

- 基于 kubeadm 搭建高可用的kubernetes 1.18.2 (k8s)集群二 搭建高可用集群

1. 部署keepalived - apiserver高可用(任选两个master节点) 1.1 安装keepalived # 在两个主节点上安装keepalived(一主一备) $ yum inst ...

- 基于 kubeadm 搭建高可用的kubernetes 1.18.2 (k8s)集群一 环境准备

本k8s集群参考了 Michael 的 https://gitee.com/pa/kubernetes-ha-kubeadm-private 这个项目,再此表示感谢! Michael的项目k8s版本为 ...

- docker compose搭建redis7.0.4高可用一主二从三哨兵集群并整合SpringBoot【图文完整版】

一.前言 redis在我们企业级开发中是很常见的,但是单个redis不能保证我们的稳定使用,所以我们要建立一个集群. redis有两种高可用的方案: High availability with Re ...

- 基于 kubeadm 搭建高可用的kubernetes 1.18.2 (k8s)集群 部署 dashboard 2.x

1. 部署dashboard 2.x版本 Dashboard 分为 1.x版本 和 2.x版本, k8s 使用的是1.18.2 故部署2.x版本的 # dashboard 2.x版本的部署 # 上传d ...

- 基于 kubeadm 搭建高可用的kubernetes 1.18.2 (k8s)集群 三 集群可用性测试

1. 创建nginx ds # 写入配置 $ cat > nginx-ds.yml <<EOF apiVersion: v1 kind: Service metadata: name ...

- [ Openstack ] Openstack-Mitaka 高可用之 Rabbitmq-server 集群部署

目录 Openstack-Mitaka 高可用之 概述 Openstack-Mitaka 高可用之 环境初始化 Openstack-Mitaka 高可用之 Mariadb-Galera集群 ...

随机推荐

- DCGAN: "Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Network" Notes

- Alec Radford, ICLR2016 原文:https://arxiv.org/abs/1511.06434 论文翻译:https://www.cnblogs.com/lyrichu/p/ ...

- Mininet实验 动态改变转发规则

介绍 拓扑如下: 在该环境下,假设H1 ping H4,初始的路由规则是S1-S2-S5,一秒后,路由转发规则变为S1-S3-S5,再过一秒,规则变为S1-S4-S5,然后再回到最初的转发规则S1-S ...

- sendto函数的坑

测试unix数据报套接字时,一个程序收,一个程序发,分别绑定自己的socket.结果在收的部分,返回的发送方的地址总是空的,但是返回的地址长度又是对的. ) { bzero(&clientad ...

- 关于如何利用原生js动态给一个空对象添加属性以及属性值

首先,回忆一下,访问对象属性一共有两种方法:点获取法和方括号获取法.而我们最常用的就是点获取法了.但是当我们遇到需要给对象动态添加属性和属性值时,点获取法好像就不太好用了,尤其是我们不知道属性名的时候 ...

- 域名/网站名/URL

http://mail.163.com/index.html 1)http://:协议,也就是HTTP超文本传输协议,网页在网上传输的协议. 2)mail:服务器名,代表着是一个邮箱服务器,所以是ma ...

- CSS优化压缩

顾名思义缩写有简写意思,那就总结一下CSS缩写知识点.为什么要让CSS属性缩写?1.简化代码.一些CSS属性简写可以减少CSS代码从而减少CSS文件的占用字节.加快网页下载速度和网页加载速度.2.优化 ...

- BZOJ1975 SDOI2010魔法猪学院(启发式搜索+最短路+堆)

对反图跑最短路求出每个点到终点的最短路径,令其为估价函数大力A*,第k次到达某个点即是找到了到达该点的非严格第k短路,因为估价函数总是不大于实际值.bzoj可能需要手写堆.正解是可持久化可并堆,至今是 ...

- Java-Eclipse-Jabref一条龙

Java部分: 1. 到Oracle官网下载需要版本的JDK:http://www.oracle.com/technetwork/java/javase/archive-139210.html 2. ...

- WM_CTLCOLOR消息

文章参考地址:http://blog.csdn.net/hisinwang/article/details/8070393 在每个控件开始绘制之前,都会向其父窗口发送WM_CTLCOL ...

- Visual Studio调试之符号文件

原文链接地址:http://www.cnblogs.com/killmyday/archive/2009/10/14/1582882.html 前面在不能设置断点的检查步骤和Visual Studio ...