人工智能论文解读精选 | PRGC:一种新的联合关系抽取模型

NLP论文解读 原创•作者 | 小欣

论文标题:PRGC: Potential Relation and Global Correspondence Based Joint Relational Triple Extraction

论文链接:https://arxiv.org/pdf/2106.09895.pdf

代码:https://github.com/hy-struggle/PRGC

1、前言

1. 论文的相关背景

关系抽取是信息抽取和知识图谱构建的关键任务之一,它的目标是从非结构化的文本中抽取形如<头实体,关系,尾实体>的三元组数据。通常使用Pipeline方法进行抽取:先对句子进行实体识别,然后对识别出的实体两两组合进行关系分类,最后把存在关系的实体对输出为三元组。但这样的做法存在以下缺点:1. 误差积累,实体识别模块的错误会影响下面的关系分类性能。2. 实体冗余:没有关系的实体对会带来多余信息,提升错误率,同时降低整个抽取流程的效率。3. 信息利用不充分:Pipeline方法中两个子任务相对独立,无法有效利用两个子任务的内在联系和依赖关系。为了缓解Pipeline方法存在的一些问题,联合关系抽取模型应运而生。联合关系抽取模型的设计目的是希望进一步利用两个任务之间的潜在信息,加强实体识别模型和关系分类模型之间的交互。早期的联合关系抽取模型通过模型参数共享、多任务和关系信息融入序列标注等方法进行联合抽取,但取得的效果并不尽如人意。随着CasRel、TPLinker等一系列联合解码模型的提出,联合关系抽取模型开始取得SOTA的效果。

2. 论文主要解决的问题

CasRel、TPLinker等基于联合解码的关系抽取模型在抽取效率上的问题

3. 论文的主要创新和贡献

- 通过将关系抽取拆解为关系判断、实体提取和主客实体对⻬三个子任务,定义了一种新的关系抽取模型方法

- 有助于缓解CasRel、TPLinker等模型存在的关系冗余、主客实体对齐效率低等问题

2、论文摘要

实体关系联合抽取是信息抽取中的⼀项重要任务。⽬前的联合抽取⽅法已有了相当可观的表现,但仍存在冗余关系预测能⼒差、Span提取泛化不⾜和效率低等问题。本⽂将联合抽取任务分为三个⼦任务:关系判断、实体提取和主客实体体对⻬,进⽽提出了⼀种新的联合抽取模型PRGC。该模型设计了⼀个模块预测潜在的关系,从⽽限制预测规模;使⽤基于关系的序列标注解决实体重叠问题;最后设计⼀个全局通信模块将主体和客体整合成三元组。

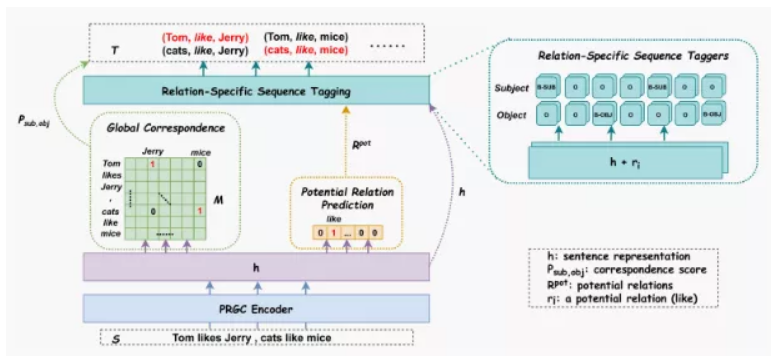

3、论文模型

PRGC将关系抽取分解成三个任务:关系判断、实体抽取和主客体对齐。首先通过关系判断模块获取文本中蕴含的关系,过滤掉不可能存在的关系。接着,将关系信息加入到实体抽取模块,每种关系都抽取出相应的主客实体。最后,使用主客体对齐模块获取的全局实体相关矩阵将主客实体进行对齐,从而抽取出文本所对应的三元组。

PRGC整体架构图

3.1 Relation Judgement

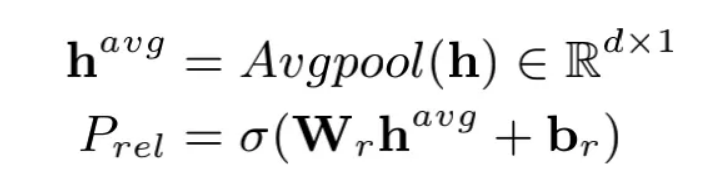

关系判断可以建模为文本多标签问题,即定义为给定一段文本,输出这段文本可能包含的所有关系标签。如下式所示,作者使用BERT编码器将句子转化为向量形式,并通过平均池化获取句子的向量表征,进而实现关系判断。

假设一个句子对应N个关系标签,则PRGC在训练阶段会将一个句子样本拆分成N个句子样本,每个句子样本中仅包含一个关系标签。例如,"九玄珠是在纵横中文网连载的一部小说,作者是龙马"这个句子中存在"连载网站"和"作者"两个关系,则在训练阶段该句子会被分别以<"九玄珠是在纵横中文网连载的一部小说,作者是龙马","连载网站">和<"九玄珠是在纵横中文网连载的一部小说,作者是龙马","作者">输入模型进行关系判断。此时关系判断模型便是常规的多分类模型,使用交叉熵计算损失即可。

# (bs, h)

h_k_avg = self.masked_avgpool(sequence_output, attention_mask)

# (bs, rel_num)

rel_pred = self.rel_judgement(h_k_avg)

loss_func = nn.BCEWithLogitsLoss(reduction='mean')

loss_rel = loss_func(rel_pred, rel_tags.float())

在预测阶段,通过sigmoid函数获取句子对应的所有关系标签的概率,并结合预先设定的概率阈值获取句子蕴含的关系标签。

# (bs, rel_num)

rel_pred_onehot = torch.where(

torch.sigmoid(rel_pred) > rel_threshold,

torch.ones(rel_pred.size(), device=rel_pred.device),

torch.zeros(rel_pred.size(), device=rel_pred.device)

)

3.2 Entity Extraction

实体抽取模块与一般的序列标注任务的不同在于:输入的向量是融合了关系信息的句子向量。作者提供了两种融合方式,一种是直接拼接两个向量,另一种是通过向量相加进行融合。此外,实体抽取模块会将主体实体抽取和客体实体抽取分开进行抽取

if ex_params['emb_fusion'] == 'concat':

decode_input = torch.cat([sequence_output, rel_emb], dim=-1)

# sequence_tagging_sub就是个普通的序列标注模块

output_sub = self.sequence_tagging_sub(decode_input)

output_obj = self.sequence_tagging_obj(decode_input)

elif ex_params['emb_fusion'] == 'sum':

decode_input = sequence_output + rel_emb

# sequence_tagging_sum里面主客实体抽取也是分开进行的

output_sub, output_obj = self.sequence_tagging_sum(decode_input)

3.3 Subject-object Alignment

主客实体对齐模块本质上就是生成字符与字符的相关矩阵。

代码实现

# batch x seq_len x seq_len x 2*hidden

corres_pred = torch.cat([sub_extend, obj_extend], 3)

# (bs, seq_len, seq_len)

corres_pred = self.global_corres(corres_pred).squeeze(-1)

# global_corres的类代码

class MultiNonLinearClassifier(nn.Module):

def __init__(self, hidden_size, tag_size, dropout_rate):

super(MultiNonLinearClassifier, self).__init__()

self.tag_size = tag_size

self.linear = nn.Linear(hidden_size, int(hidden_size / 2))

self.hidden2tag = nn.Linear(int(hidden_size / 2), self.tag_size)

self.dropout = nn.Dropout(dropout_rate)

def forward(self, input_features):

features_tmp = self.linear(input_features)

features_tmp = nn.ReLU()(features_tmp)

features_tmp = self.dropout(features_tmp)

features_output = self.hidden2tag(features_tmp)

return features_output

由于采用了拼接向量后通过全连接生成对齐矩阵,故而会占用较多的显存。笔者在这部分尝试了使用biffine机制进行向量的交叉融合,可以在不降低性能的情况下有效地节约显存。

3.4 Loss Function

PRGC的损失采用了三个子任务加权的形式,本质上都是交叉熵,只是针对不同维度进行了处理。作者在论文中并未详细讨论不同的加权方式对模型的影响,在代码实现中也是采用了常规的三个损失直接相加的结构。笔者认为由于三个损失的收敛情况不同,可以尝试根据训练轮数动态调整三个损失之间的加权关系。

4、论文实验

PRGC主要在NYT和WebNLG上进行实验,NYT和WebNLG都有两个版本,一个版本是标注出整个实体,另一个版本是仅标注出实体的最后一个字符,作者将仅标注出实体的最后一个字符的版本记为NYT*和WebNLG*。如下例中实体North Carolina在NYT中是整体标出的,而在NYT*中则是仅标出Carolina。

- NYT的数据格式:

{

"text": "North Carolina EASTERN MUSIC FESTIVAL Greensboro , June 25-July 30 .",

"triple_list": [

[

"North Carolina",

"/location/location/contains",

"Greensboro"

]

]

}

- NYT*的数据格式:

{

"text": "North Carolina EASTERN MUSIC FESTIVAL Greensboro , June 25-July 30 .",

"triple_list": [

[

"Carolina",

"/location/location/contains",

"Greensboro"

]

]

}

- WebNLG的数据格式:

{

"text": "Alan Bean , who graduated in 1955 from UT Austin with a B.S . and was selected by NASA in 1963 , spent 100305.0 minutes in space .",

"triple_list": [

[

"Alan Bean",

"was selected by NASA",

"1963"

]

]

}

- WebNLG*的数据格式:

{

"text": "Alan Bean , who graduated in 1955 from UT Austin with a B.S . and was selected by NASA in 1963 , spent 100305.0 minutes in space .",

"triple_list": [

[

"Bean",

"was selected by NASA",

"1963"

]

]

}

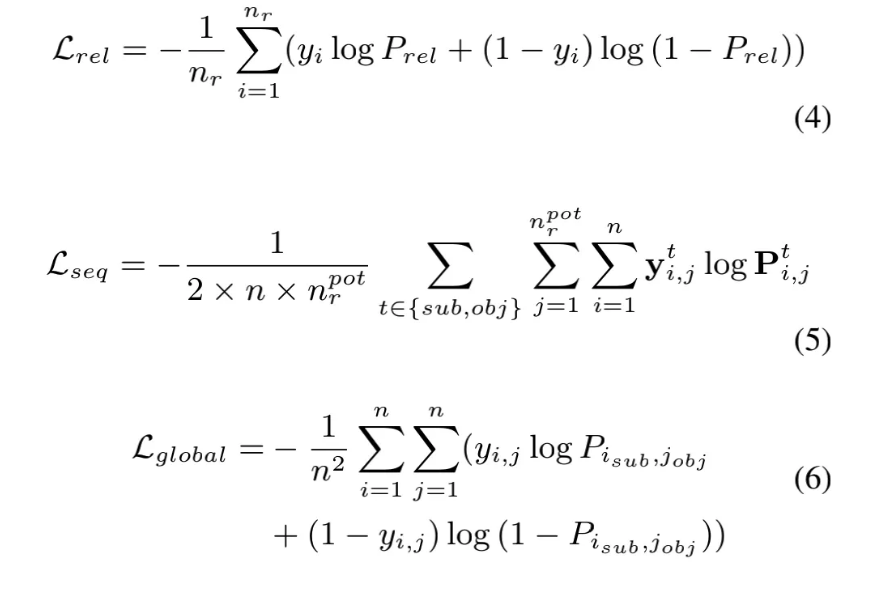

评价指标采用了常见的精准率(Prec.)、 召回率(Rec.)和F1-score。实验结果如下图,可以看出PRGC在四个数据上都取得了不错的效果。

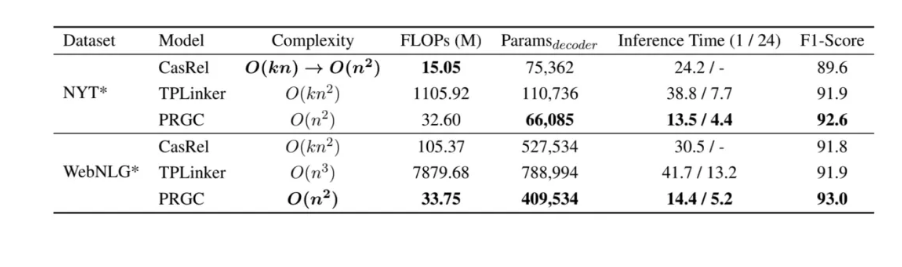

此外,作者还对PRGC的效率进行了实验,得益于PRGC可以通过关系判断去除掉句子中不包含的关系标签和整个模型不存在过于复杂的解码方式,PRGC在复杂度和推理速度上相比于CasRel和TPLinker都有明显的优势:

人工智能论文解读精选 | PRGC:一种新的联合关系抽取模型的更多相关文章

- zz扔掉anchor!真正的CenterNet——Objects as Points论文解读

首发于深度学习那些事 已关注写文章 扔掉anchor!真正的CenterNet——Objects as Points论文解读 OLDPAN 不明觉厉的人工智障程序员 关注他 JustDoIT 等 ...

- [论文解读] 阿里DIEN整体代码结构

[论文解读] 阿里DIEN整体代码结构 目录 [论文解读] 阿里DIEN整体代码结构 0x00 摘要 0x01 文件简介 0x02 总体架构 0x03 总体代码 0x04 模型基类 4.1 基本逻辑 ...

- CVPR2019 | Mask Scoring R-CNN 论文解读

Mask Scoring R-CNN CVPR2019 | Mask Scoring R-CNN 论文解读 作者 | 文永亮 研究方向 | 目标检测.GAN 推荐理由: 本文解读的是一篇发表于CVPR ...

- Features for Multi-Target Multi-Camera Tracking and Re-identification论文解读

解读一:Features for Multi-Target Multi-Camera Tracking and Re-identification Abstract MTMCT:从多个摄像头采集的视频 ...

- 《Stereo R-CNN based 3D Object Detection for Autonomous Driving》论文解读

论文链接:https://arxiv.org/pdf/1902.09738v2.pdf 这两个月忙着做实验 博客都有些荒废了,写篇用于3D检测的论文解读吧,有理解错误的地方,烦请有心人指正). 博客原 ...

- 论文解读丨基于局部特征保留的图卷积神经网络架构(LPD-GCN)

摘要:本文提出一种基于局部特征保留的图卷积网络架构,与最新的对比算法相比,该方法在多个数据集上的图分类性能得到大幅度提升,泛化性能也得到了改善. 本文分享自华为云社区<论文解读:基于局部特征保留 ...

- CVPR2019论文解读:单眼提升2D检测到6D姿势和度量形状

CVPR2019论文解读:单眼提升2D检测到6D姿势和度量形状 ROI-10D: Monocular Lifting of 2D Detection to 6D Pose and Metric Sha ...

- CVPR2020 论文解读:少点目标检测

CVPR2020 论文解读:具有注意RPN和多关系检测器的少点目标检测 Few-Shot Object Detection with Attention-RPN and Multi-Relation ...

- CVPR2020行人重识别算法论文解读

CVPR2020行人重识别算法论文解读 Cross-modalityPersonre-identificationwithShared-SpecificFeatureTransfer 具有特定共享特征变换 ...

随机推荐

- Codeforces 1225G - To Make 1(bitset+状压 dp+找性质)

Codeforces 题目传送门 & 洛谷题目传送门 还是做题做太少了啊--碰到这种题一点感觉都没有-- 首先我们来证明一件事情,那就是存在一种合并方式 \(\Leftrightarrow\) ...

- 【R】一对一变为一对多:将列折叠/连接/聚合为每个组(一行)内的字符串?

目录 需求 实现 方法一 其他方法 data.table dplyr aggregate sqldf 延申:不用逗号分隔 需求 原始文件: data <- data.frame(A = c(re ...

- 【基因组组装】HiC挂载软件以及如何用Juice_box手工纠错?

目录 1.常用HiC挂载软件 2. Juice_box手工纠错 1.常用HiC挂载软件 ALLHiC 张兴坦老师专为多倍体和高杂合度物种基因组挂载开发.如果是复杂基因组,肯定是首选.对于简单基因组,我 ...

- linux系统中安装MySQL

linux系统中安装MySQL 检查原来linux系统中安装的版本 rpm -qa | grep mysql 将其卸载掉 以 mysql-libs-5.1.71-1.el6.x86_64 版本为例 r ...

- InnoDB学习(一)之BufferPool

我们知道InnoDB数据库的数据是持久化在磁盘上的,而磁盘的IO速度很慢,如果每次数据库访问都直接访问磁盘,显然严重影响数据库的性能.为了提升数据库的访问性能,InnoDB为数据库的数据增加了内存缓存 ...

- SparkStreaming消费Kafka,手动维护Offset到Mysql

目录 说明 整体逻辑 offset建表语句 代码实现 说明 当前处理只实现手动维护offset到mysql,只能保证数据不丢失,可能会重复 要想实现精准一次性,还需要将数据提交和offset提交维护在 ...

- Scala【json字符串和json对象互相转换】

一.fastjson工具 pom依赖 <dependency> <groupId>com.alibaba</groupId> <artifactId>f ...

- Shell学习(九)——chattr与lsattr命令详解

有时候你发现用root权限都不能修改某个文件,大部分原因是曾经用chattr命令锁定该文件了.chattr命令的作用很大,其中一些功能是由Linux内核版本来支持的,不过现在生产绝大部分跑的linux ...

- windows下的_vimrc

折腾了一天 在https://keelii.github.io/2016/06/13/awsome-window-vimrc/的基础上进行了一些改动 " ------------------ ...

- poi做一个简单的EXCAL

//创建一个实体类 package text; import java.util.Date; public class Student { private int id; private String ...