将白码平台数据存储到MySQL数据库

概述:

此前在白码平台上搭建并使用系统,若想要将白码平台上搭建的系统的数据存储到自己本地的MySQL数据库中的话,需要将数据导出后再对数据进行处理。如今想要实现这一需求,直接通过使用白码的数据库对接功能,将数据存储到自己本地的数据库中即可。平均一个数据表只需要一分钟的操作时间便能完成对接,效率提升十分显著。

实现效果:

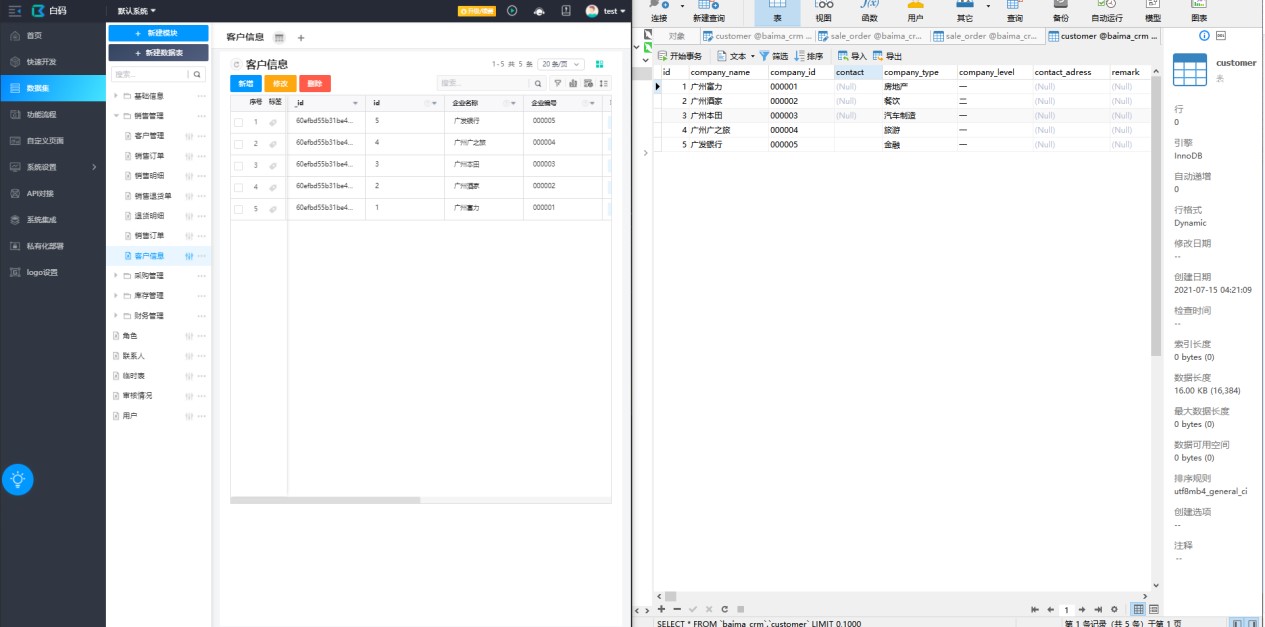

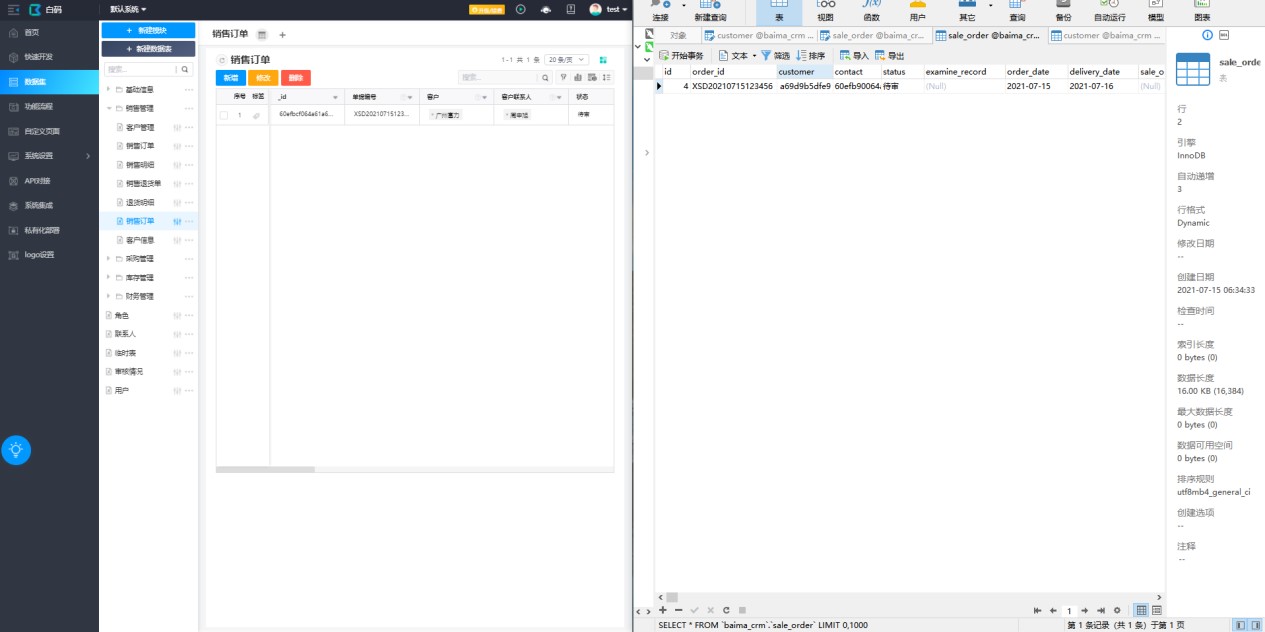

左边为白码数据表中的数据,右边为本地数据库的数据,点击自动生成后,字段以及数据就一并存储到本地的数据库中了,实现数据的同步。下面展示存储后的效果。

客户信息表:

销售订单表:

实现步骤:

本地数据库设置:

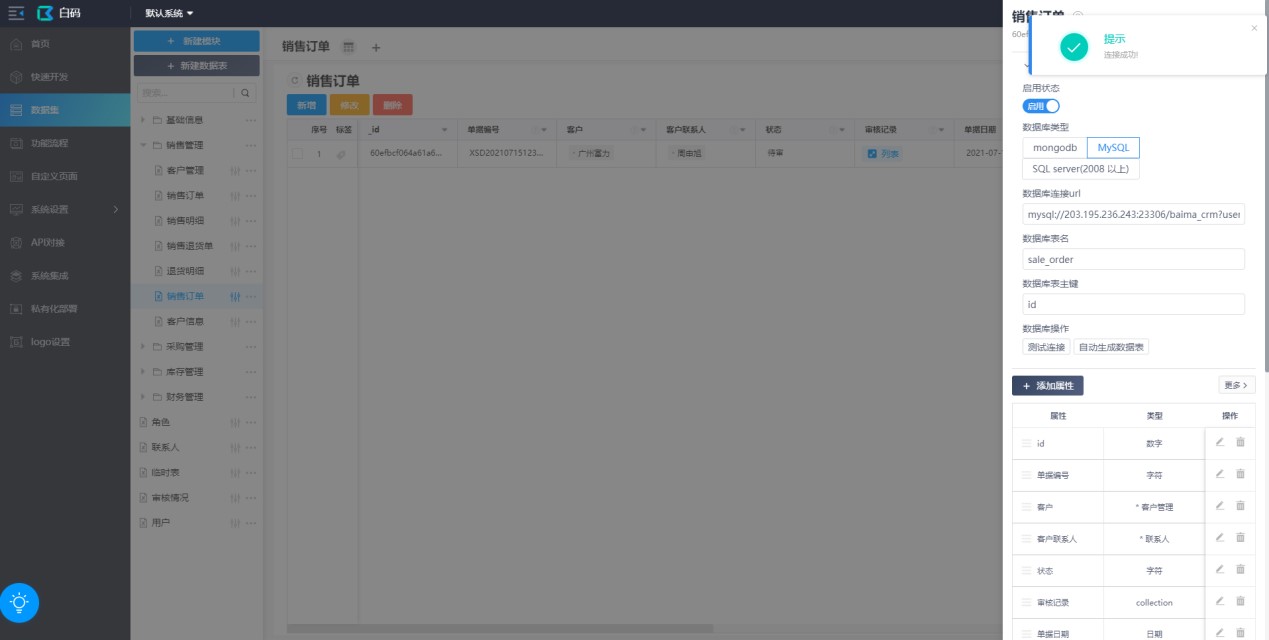

以进销存系统中的销售订单模块为例,订单表关联了多个数据表,包括客户信息表,销售明细表等。依次将这几个表在数据库中创建出来,不用再重新设计表结构,添加完主键并填写表名保存就可以了,字段以及数据使用对接功能自动同步。

在本地数据库中创建完对应的表后,需要在白码平台上对数据表进行数据库对接配置。

数据库对接配置操作步骤:

- 启用数据库对接功能。

- 选择数据库类型(MySQL)。

- 输入数据库连接URL。

- 输入对应的数据表名。

- 输入刚刚本地创建数据表时设置的主键。

- 点击保存后测试有没有连接成功。

- 点击“自动生成数据表”在本地数据库中自动生成数据表。

数据表字段类型说明:

- 关联类型对应 varchar 50

- 字符类型对应 varchar 255

- 数字类型对应 decimal

- 时间类型对应 varchar 50

- 日期类型对应 varchar 50

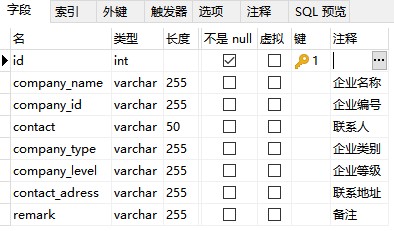

客户信息表字段:

白码:

MySQL数据库:

销售订单表字段:

白码:

MySQL数据库:

将白码平台数据存储到MySQL数据库的更多相关文章

- 猫眼电影爬取(一):requests+正则,并将数据存储到mysql数据库

前面讲了如何通过pymysql操作数据库,这次写一个爬虫来提取信息,并将数据存储到mysql数据库 1.爬取目标 爬取猫眼电影TOP100榜单 要提取的信息包括:电影排名.电影名称.上映时间.分数 2 ...

- scrapy数据存储在mysql数据库的两种方式

方法一:同步操作 1.pipelines.py文件(处理数据的python文件) import pymysql class LvyouPipeline(object): def __init__(se ...

- 猫眼电影爬取(二):requests+beautifulsoup,并将数据存储到mysql数据库

上一篇通过requests+正则爬取了猫眼电影榜单,这次通过requests+beautifulsoup再爬取一次(其实这个网站更适合使用beautifulsoup库爬取) 1.先分析网页源码 可以看 ...

- 爬取网贷之家平台数据保存到mysql数据库

# coding utf-8 import requests import json import datetime import pymysql user_agent = 'User-Agent: ...

- 猫眼电影爬取(三):requests+pyquery,并将数据存储到mysql数据库

还是以猫眼电影为例,这次用pyquery库进行爬取 1.简单demo,看看如何使用pyquery提取信息,并将提取到的数据进行组合 # coding: utf-8 # author: hmk impo ...

- Python爬虫抓取东方财富网股票数据并实现MySQL数据库存储

Python爬虫可以说是好玩又好用了.现想利用Python爬取网页股票数据保存到本地csv数据文件中,同时想把股票数据保存到MySQL数据库中.需求有了,剩下的就是实现了. 在开始之前,保证已经安装好 ...

- python3下scrapy爬虫(第十卷:scrapy数据存储进mysql)

上一卷中我将爬取的数据文件直接写入文本文件中,现在我将数据存储到mysql中,我依然用的是pymysql,这个很麻烦建表需要在外面建 这次代码只需要改变pipyline就行 来 现在看下结果: 对比发 ...

- 如何将MongoDB数据库的数据迁移到MySQL数据库中

FAQ v2.0终于上线了,断断续续忙了有2个多月.这个项目是我实践的第一个全栈的项目,从需求(后期有产品经理介入)到架构,再到设计(有征询设计师的意见).构建(前端.后台.数据库.服务器部署),也是 ...

- Python爬取招聘信息,并且存储到MySQL数据库中

前面一篇文章主要讲述,如何通过Python爬取招聘信息,且爬取的日期为前一天的,同时将爬取的内容保存到数据库中:这篇文章主要讲述如何将python文件压缩成exe可执行文件,供后面的操作. 这系列文章 ...

随机推荐

- leetcode 数组分成和相等的三个部分

题目: 给你一个整数数组 A,只有可以将其划分为三个和相等的非空部分时才返回 true,否则返回 false. 形式上,如果可以找出索引 i+1 < j 且满足 (A[0] + A[1] + . ...

- Leetcode No.35 Search Insert Position(c++实现)

1. 题目 1.1 英文题目 Given a sorted array of distinct integers and a target value, return the index if the ...

- oracle 大表在线删除列操作(alter table table_name set unused )

在某些情况下业务建的表某些列没有用到,需要进行删除,但是如果是数据量很大的大表,直接 alter table table_name drop column column_name;这种方法删除,那么将 ...

- 「CF643G」 Choosing Ads

「CF643G」 Choosing Ads 传送门 如果你知道摩尔投票法可以扩展事实上是个一眼题,又好写又好调. 首先摩尔投票法是用来求众数定义为超过所有数个数一半的数的一个算法. 大致算法流程: 将 ...

- Pandas高级教程之:稀疏数据结构

目录 简介 Spare data的例子 SparseArray SparseDtype Sparse的属性 Sparse的计算 SparseSeries 和 SparseDataFrame 简介 如果 ...

- C语言:结构体应用

#include <stdio.h> #include <stdlib.h> #include <assert.h> typedef struct student{ ...

- python根据窗口标题找句柄,将窗口前置活动

import time, threading, copy import win32api, win32con import win32gui import win32gui def zhaojb(aa ...

- python得到当前版本号

import sys print(sys.winver) 3.7 # 导入sys模块的argv,winver成员,并为其指定别名v.wv from sys import argv as v, winv ...

- poj 折半搜索

poj2549 Sumsets 题目链接: http://poj.org/problem?id=2549 题意:给你一个含有n(n<=1000)个数的数列,问这个数列中是否存在四个不同的数a,b ...

- deepin安装Motrix,cocomusic

1,motrix(下载工具):https://motrix.app/ 2,cocomusic(开源音乐播放器):https://github.com/xtuJSer/CoCoMusic/release ...