Spark Streamming 基本输入流(二) :Socket

Spark Streamming 可以通过socket 进行数据监听。

socket的输入方可以通过nc 或者自己开发nc功能的程序。

1、系统自带的nc

su root

a

yum install -y nc 安装nc

nc -lk 22222 就代表nc对22222端口进行监听。

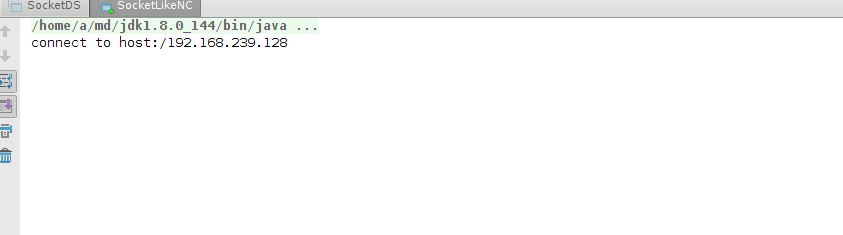

2、自己编写nc程序

下面程序是不停给master 22222 端口写入行数据。

val words = "hello spark storm hive java hadoop hbase hello money scala python".split(" ")

val n = words.size

val ra = new Random()

val hostname = "master"

val port = 22222

val ss = new ServerSocket(port)

val socket = ss.accept()

println("connect to host:" + socket.getInetAddress)

while(true){

val out = new PrintWriter(socket.getOutputStream)

out.println(words(ra.nextInt(n)) + " " + words(ra.nextInt(n)))

out.flush()

Thread.sleep(100)

3、编写spark streamming 处理程序。

object SocketDS {

def main(args: Array[String]): Unit = {

val conf = new SparkConf().setAppName("SocketDS").setMaster("local[2]")

val ssc = new StreamingContext(conf,Seconds(10))

ssc.sparkContext.setLogLevel("warn")

val hostname = "master"

val port = 22222

val lines = ssc.socketTextStream(hostname ,port)

val words = lines.flatMap(_.split("\\s+"))

words.transform(wRDD=>{

val wordCount = wRDD.map((_,1)).reduceByKey(_+_).sortBy(_._2,false)

wordCount

}).print()

ssc.start()

ssc.awaitTermination()

}

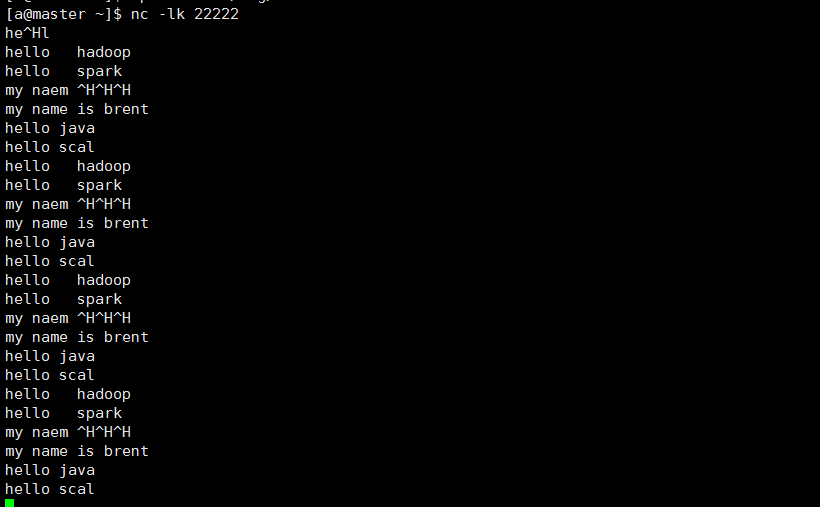

4、nc端 输入socket内容 进行监控

hello spark

hello hadoop

hello socket

hello java

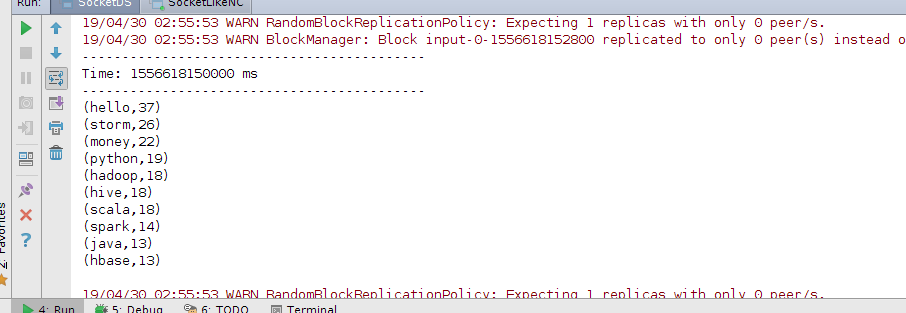

hello scala

5、先开启spark Streamming处理程序,再开启nc或者ncsocket,运行结果如下。

nc -lk 22222给master 22222发送数据,

通过自己编写的nc socket程序,随机组合给master 22222发送行数据。

spark streamming 程序接收并处理后的结果。

Spark Streamming 基本输入流(二) :Socket的更多相关文章

- Spark Streamming 基本输入流I(-) :File/Hdfs

Spark Streamming 基本输入流I(-):从文件中进行读取 文件读取1:本地文件读取 这里我只给出实现代码及操作步骤 1.在本地目录下创建目录,这里我们创建目录为~/log/ 2.然后手动 ...

- Spark面试题(二)

首发于我的个人博客:Spark面试题(二) 1.Spark有哪两种算子? Transformation(转化)算子和Action(执行)算子. 2.Spark有哪些聚合类的算子,我们应该尽量避免什么类 ...

- linux内核中的文件描述符(二)--socket和文件描述符

http://blog.csdn.net/ce123_zhouwei/article/details/8459730 Linux内核中的文件描述符(二)--socket和文件描述符 Kernel ve ...

- 二. Socket用法

C/S通信架构中,客户端要主动与服务端建立连接,这个链接就是Socket套接字.服务端收到连接请求后,也会开启Socket记录与客户端的链接.C/S两端都要建路Socket才能正常收发数据. 一.构造 ...

- Spark读写Hbase的二种方式对比

作者:Syn良子 出处:http://www.cnblogs.com/cssdongl 转载请注明出处 一.传统方式 这种方式就是常用的TableInputFormat和TableOutputForm ...

- Spark SQL概念学习系列之为什么使用 Spark SQL?(二)

简单地说,Shark 的下一代技术 是Spark SQL. 由于 Shark 底层依赖于 Hive,这个架构的优势是对传统 Hive 用户可以将 Shark 无缝集成进现有系统运行查询负载. 但是也看 ...

- 【Spark篇】---Spark中transformations算子二

一.前述 今天继续整理几个Transformation算子如下: mapPartitionWithIndex repartition coalesce groupByKey zip zipWithIn ...

- spark streaming 整合kafka(二)

转载:https://www.iteblog.com/archives/1326.html 和基于Receiver接收数据不一样,这种方式定期地从Kafka的topic+partition中查询最新的 ...

- Spark 系列(十二)—— Spark SQL JOIN 操作

一. 数据准备 本文主要介绍 Spark SQL 的多表连接,需要预先准备测试数据.分别创建员工和部门的 Datafame,并注册为临时视图,代码如下: val spark = SparkSessio ...

随机推荐

- 【curl】Linux下命令行curl详解

在Linux中curl是一个利用URL规则在命令行下工作的文件传输工具,可以说是一款很强大的http命令行工具.它支持文件的上传和下载,是综合传输工具,但按传统,习惯称url为下载工具. 语法:# c ...

- JVM(三) 垃圾回收时间点和垃圾收集器

收集器组合章节来自第一篇参考文章,非原创,作者总结地非常好! 分代收集相关概念来自参考文章第二篇,非原创 第二篇参考资料的文章质量很高,推荐阅读! 分代收集(Ge ...

- No mapping found for HTTP request with URI异常的原因,<mvc:default-servlet-handler/>的作用

一.最近做的一个项目有很多静态资源文件,按照平时的配置springmvc进行配置发现访问不到静态文件,并且在我配置好controller去访问结果还是404 No mapping found for ...

- hdu1385 最短路字典序

http://blog.csdn.net/ice_crazy/article/details/7785111 http://blog.csdn.net/shuangde800/article/deta ...

- 利用setTimeoutc处理javascript ajax请求超时

用过jquery的人都知道里面的$.ajax能设置超时处理及各种错误的抛出,确实好用.原生的js没有对应的方法,还得写各种兼容.在实际运用中,不管请求是否成功都应该做容错处理, 不然用户不知道到底发生 ...

- NOIP2017:列队

Sol 考场上: 这不是送\(50\)吗,\(Q^2\)递推就好了 然后,怎么又送\(20\)分??? \(woc\),只有半个小时了,顺利没调出来只有\(50\)分 考后: 神\(TM\)一个大于号 ...

- 记录开发Nodejs c++ addon的一些经验(二、数据类型的转换(尤其是Buffer))

常见的数据类型的转换基本比较容易,结合nan应该不是一件难事 参考链接: http://blog.jobbole.com/109598/ http://deadhorse.me/nodejs/2012 ...

- JavaScript练习笔记整理·1 - 6.23

练习平台Codewars地址:https://www.codewars.com/ 欢迎和大家一起来讨论~╭( ・ㅂ・)و ̑̑ 基础练习(1): 我的解答为: class SmallestIn ...

- Ubuntu 下 /etc/resolv.conf文件总是自动清除问题的解决方案

最近学习Linux,在虚拟机中安装的是Ubuntu操作系统,用了几天发现Ubuntu无法上网,打开命令终端,输入命令: ping www.baidu.com -c2 结果显示名称无法识别,而直接与宿主 ...

- Android ImageButton单击切换按钮图片效果

正常状态的效果: 按钮按下的效果图片: 一.在java中为图片按钮增加触摸监听的函数来实现图片切换,代码如下: ImageButton btn = (ImageButton)findViewById( ...