python框架Scrapy中crawlSpider的使用

一、创建Scrapy工程

#scrapy startproject 工程名

scrapy startproject demo3

二、进入工程目录,根据爬虫模板生成爬虫文件

#scrapy genspider -l # 查看可用模板

#scrapy genspider -t 模板名 爬虫文件名 允许的域名

scrapy genspider -t crawl test sohu.com

三、设置IP池或用户代理(middlewares.py文件)

# -*- coding: utf-8 -*-

# 导入随机模块

import random

# 导入有关IP池有关的模块

from scrapy.downloadermiddlewares.httpproxy import HttpProxyMiddleware

# 导入有关用户代理有关的模块

from scrapy.downloadermiddlewares.useragent import UserAgentMiddleware # IP池

class HTTPPROXY(HttpProxyMiddleware):

# 初始化 注意一定是 ip=''

def __init__(self, ip=''):

self.ip = ip def process_request(self, request, spider):

item = random.choice(IPPOOL)

try:

print("当前的IP是:"+item["ipaddr"])

request.meta["proxy"] = "http://"+item["ipaddr"]

except Exception as e:

print(e)

pass # 设置IP池

IPPOOL = [

{"ipaddr": "182.117.102.10:8118"},

{"ipaddr": "121.31.102.215:8123"},

{"ipaddr": "1222.94.128.49:8118"}

] # 用户代理

class USERAGENT(UserAgentMiddleware):

#初始化 注意一定是 user_agent=''

def __init__(self, user_agent=''):

self.user_agent = user_agent def process_request(self, request, spider):

item = random.choice(UPPOOL)

try:

print("当前的User-Agent是:"+item)

request.headers.setdefault('User-Agent', item)

except Exception as e:

print(e)

pass # 设置用户代理池

UPPOOL = [

"Mozilla/5.0 (Windows NT 10.0; WOW64; rv:52.0) Gecko/20100101 Firefox/52.0", "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.115 Safari/537.36", "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/51.0.2704.79 Safari/537.36 Edge/14.14393"

]

四、settngs.py配置

#======================================== # 设置IP池和用户代理 # 禁止本地Cookie

COOKIES_ENABLED = False # 下载中间件配置指向(注意这里的工程名字是"demo3",指向DOWNLOADER_MIDDLEWARES = {

# 'scrapy.downloadermiddlewares.httpproxy.HttpProxyMiddleware':123,

# 'demo3.middlewares.HTTPPROXY' : 125,

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware': 2,

'demo3.middlewares.USERAGENT': 1

} # 管道指向配置(注意这里的工程名字是"demo3",指向ITEM_PIPELINES = {

'demo3.pipelines.Demo3Pipeline': 300,

} #============================================

五、定义爬取关注的数据(items.py文件)

# -*- coding: utf-8 -*-

import scrapy

# Define here the models for your scraped items

#

# See documentation in:

# http://doc.scrapy.org/en/latest/topics/items.html

class Demo3Item(scrapy.Item):

name = scrapy.Field()

link = scrapy.Field()

六、爬虫文件编写(test.py)

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from demo3.items import Demo3Item class TestSpider(CrawlSpider):

name = 'test'

allowed_domains = ['sohu.com']

start_urls = ['http://www.sohu.com/'] rules = (

Rule(LinkExtractor(allow=('http://news.sohu.com'), allow_domains=('sohu.com')), callback='parse_item', follow=False),

#Rule(LinkExtractor(allow=('.*?/n.*?shtml'),allow_domains=('sohu.com')), callback='parse_item', follow=False),

) def parse_item(self, response):

i = Demo3Item()

i['name'] = response.xpath('//div[@class="news"]/h1/a/text()').extract()

i['link'] = response.xpath('//div[@class="news"]/h1/a/@href').extract()

return i

七、管道文件编写(pipelines.py)

# -*- coding: utf-8 -*-

import codecs

import json

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: http://doc.scrapy.org/en/latest/topics/item-pipeline.html

class Demo3Pipeline(object):

def __init__(self):

self.file = codecs.open("E:/workspace/PyCharm/codeSpace/books/python_web_crawler_book/chapter17/demo3/1.json", "wb", encoding='utf-8') def process_item(self, item, spider):

for j in range(0, len(item["name"])):

name = item["name"][j]

link = item["link"][j]

datas = {"name": name, "link": link}

i = json.dumps(dict(datas), ensure_ascii=False)

line = i + '\n'

self.file.write(line)

return item

def close_spider(self, spider):

self.file.close()

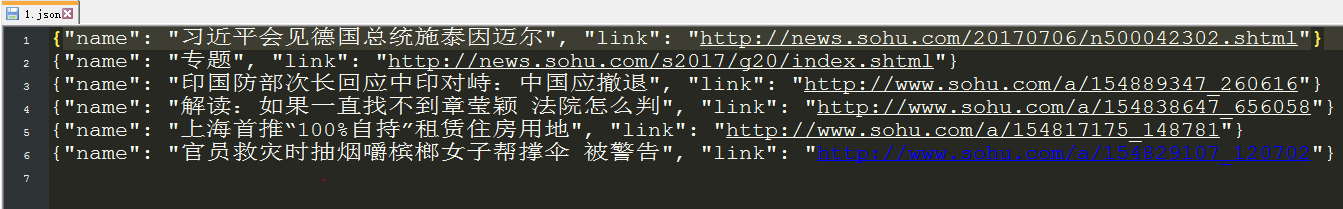

八、测试(scrapy crawl test )之后,生成了1.json文件

python框架Scrapy中crawlSpider的使用的更多相关文章

- python框架Scrapy中crawlSpider的使用——爬取内容写进MySQL

一.先在MySQL中创建test数据库,和相应的site数据表 二.创建Scrapy工程 #scrapy startproject 工程名 scrapy startproject demo4 三.进入 ...

- python框架Django中MTV框架之VIew(业务控制器)

MTV框架之VIew(业务控制器) 关注公众号"轻松学编程"了解更多. 1.什么是视图 视图层=路由表(urls.py)+视图函数(views.py) 其角色相当于MVC中的Con ...

- python框架Django中MTV框架之Template(模板/界面)

MTV框架之Template(模板/界面) 关注公众号"轻松学编程"了解更多. 1.模板目录位置 应用下 不需要注册 无法跨应用地进行复用 工程下 需要注册 settings.py ...

- python框架Django中MTV之Model(数据模型)

MTV框架之Model(数据模型) 关注公众号"轻松学编程"了解更多. 1.连接MySQL数据库 项目中的settings.py设置范例 # 配置数据库 DATABASES = { ...

- python框架Django中的MTV架构

MTV架构 关注公众号"轻松学编程"了解更多. 通过V对M和T进行连接,用户通过T(界面)对服务器进行访问(发送请求),T把请求传给V(调度),V调用M(数据模型)获取数据,把 ...

- scrapy 中crawlspider 爬虫

爬取目标网站: http://www.chinanews.com/rss/rss_2.html 获取url后进入另一个页面进行数据提取 检查网页: 爬虫该页数据的逻辑: Crawlspider爬虫类: ...

- python框架django中结合vue进行前后端分离

一:创建django项目 1.django-admin startproject mysite # 创建mysite项目 2.django-admin startapp app01# 创建app01应 ...

- python框架Scrapy报错TypeError: 'float' object is not iterable解决

原因是:Twisted版本高了. 解决办法: 只要把Twisted库降级到16.6.0即可: pip3 install Twisted== 注:Twisted16..0安装后,会自动卸载高版本的Twi ...

- 教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http://www.xiaohuar.com/,让你体验爬取校花的成就感. Scr ...

随机推荐

- php 验证访问浏览器是电脑还是手机

//判断如果为手机用户则 if(checkmobile()==true) { $url=$_SERVER["HTTP_HOST"]; $urlHost=GetHost($url); ...

- unity, 3dmax制作的morph(blendshape)导入unity中使用注意事项

在实现<乱纪元大冒险>(见:http://www.cnblogs.com/wantnon/p/4857072.html)中由于质子展开失败形成的变形几何体和眼睛.几何体经过一系列形变最后变 ...

- Redis(三):windows下Redis的安装配置以及注意事项

一.下载windows版本的Redis 去官网找了很久,发现原来在官网上可以下载的windows版本的,现在官网以及没有下载地址,只能在github上下载,官网只提供linux版本的下载 官网下载地址 ...

- android studio - 使android studio 在提示时不区分大小写

- makefile之foreach函数

#$(foreach <var>,<list>,<text>) #把参数<list>中的单词逐一取出放到参数<var>所指定的变量中,然后再 ...

- CCNA2.0笔记_NAT

NAT:园区网内的PC是私有地址,整个园区网共享一个公有IP,如果园区网内的PC不做NAT,那么在发数据包给外网的时候会出现传输问题 NAT的原理:改变IP包头,使目的地址.源地址或两个地址在包头中被 ...

- iOS 小数点精度问题处理

实际开发中有时候经常会需要去处理小数点精度问题,如果是整数保留整数,如果有小数则保留不为0的的小数,最大2位小数 eg: 2.013 ---> 2.01 2.0 ---> 2 2.10 - ...

- 公共查询类criteria

package cn.edu.hbcf.common.vo; import java.math.BigDecimal; import java.sql.Timestamp; import java.u ...

- SIGBUS 和 SIGSEGV

一.导致SIGSEGV 1.试图对仅仅读映射区域进行写操作 . 2.訪问的内存已经被释放,也就是已经不存在或者越界. 3.官方说法是: SIGSEGV --- Segment Fault. ...

- 使用SWT技术的跨平台移动应用开发库Tabris

1. http://developer.eclipsesource.com/tabris/ 2. 多平台.原生程序级别的性能 3. 开源/教育性的项目免费,意思就是商业项目收费 4. 目标,让懂jav ...