三 Hive 数据处理 自定义函数UDF和Transform

三 Hive 自定义函数UDF和Transform

开篇提示:

快速链接beeline的方式:

./beeline -u jdbc:hive2://hadoop1:10000 -n hadoop

1.自定义函数UDF

当Hive提供的内置函数无法满足你的业务处理需要时,此时就可以考虑使用用户自定义函数(UDF:user-defined function)

UDF 作用于单个数据行,产生一个数据行作为输出。(数学函数,字符串函数)

2开发实例

2.1 原始数据格式

{"movie":"1193","rate":"5","timeStamp":"978300760","uid":"1"}

{"movie":"661","rate":"3","timeStamp":"978302109","uid":"1"}

{"movie":"914","rate":"3","timeStamp":"978301968","uid":"1"}

{"movie":"3408","rate":"4","timeStamp":"978300275","uid":"1"}

{"movie":"2355","rate":"5","timeStamp":"978824291","uid":"1"}

{"movie":"1197","rate":"3","timeStamp":"978302268","uid":"1"}

{"movie":"1287","rate":"5","timeStamp":"978302039","uid":"1"}

{"movie":"2804","rate":"5","timeStamp":"978300719","uid":"1"}

{"movie":"594","rate":"4","timeStamp":"978302268","uid":"1"}

{"movie":"919","rate":"4","timeStamp":"978301368","uid":"1"}

{"movie":"595","rate":"5","timeStamp":"978824268","uid":"1"}

{"movie":"938","rate":"4","timeStamp":"978301752","uid":"1"}

2.2 创建数据表

create table t_rating (line string)

row format delimited;

2.3 导入数据

load data local inpath '/home/hadoop/rating.json' into table t_rating;

2.4 开发UDF程序

package cn.itcast.hive; import org.apache.hadoop.hive.ql.exec.UDF;

import org.codehaus.jackson.map.ObjectMapper; /**

* @author ntjr

* 解析json数据

*

*/

public class PaserJson extends UDF {

private ObjectMapper mapper = new ObjectMapper(); public String evaluate(String line) { try {

RatingBean ratingBean = mapper.readValue(line, RatingBean.class);

return ratingBean.toString();

} catch (Exception e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

return "";

}

}

用于解析t_rating表中每一行的json数据。

package cn.itcast.hive;

public class RatingBean {

private String movie;

private String rate;

private String timeStamp;

private String uid;

public String getMovie() {

return movie;

}

public void setMovie(String movie) {

this.movie = movie;

}

public String getRate() {

return rate;

}

public void setRate(String rate) {

this.rate = rate;

}

public String getTimeStamp() {

return timeStamp;

}

public void setTimeStamp(String timeStamp) {

this.timeStamp = timeStamp;

}

public String getUid() {

return uid;

}

public void setUid(String uid) {

this.uid = uid;

}

@Override

public String toString() {

return movie + "\t" + rate + "\t" + timeStamp + "\t" + uid;

}

}

2.4将udf程序打成jar 导入hive

add JAR /home/hadoop/udf.jar;

2.5 创建临时函数与开发好的udf进行关联

create temporary function paseJson as 'cn.itcast.hive.PaserJson';

2.6 创建完整字段的t_rating02表(用于存放将单列json数据表t_rating转换成多列数据表t_rating02的结果)

create table t_rating02 as

select split(paseJson(line),'\t')[0] as movieid,

split(paseJson(line),'\t')[1] as rate,

split(paseJson(line),'\t')[2] as timestring,

split(paseJson(line),'\t')[3] as uid

from t_rating;

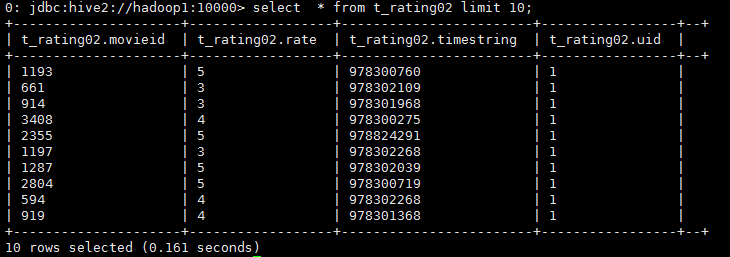

至此:完成字段表t_rating02转换完成。

3.利用Transfrom将t_rating02表中的timestring字段转换成周几的形式。

3.1 t_rating02中的样式:

3.2编写weekday_mapper.py脚本,处理t_rating02表中的timestring字段

#!/bin/python

import sys

import datetime for line in sys.stdin:

line = line.strip()

movieid, rating, unixtime,userid = line.split('\t')

weekday = datetime.datetime.fromtimestamp(float(unixtime)).isoweekday()

print '\t'.join([movieid, rating, str(weekday),userid])

3.3 上传weekday_mapper.py脚本,前提是保证本机装有python

add FILE weekday_mapper.py;

3.4 创建新表t_rating_date,保存脚本处理后的数据

create TABLE t_rating_date as

SELECT

TRANSFORM (movieid , rate, timestring,uid)

USING 'python weekday_mapper.py'

AS (movieid, rating, weekday,userid)

FROM t_rating02;

3.5查看t_rating_date表

至此将json数据转换成数据表。

三 Hive 数据处理 自定义函数UDF和Transform的更多相关文章

- HIVE 编写自定义函数UDF

一 新建JAVA项目 并添加 hive-exec-2.1.0.jar 和hadoop-common-2.7.3.jar hive-exec-2.1.0.jar 在HIVE安装目录的lib目录下 had ...

- hive自定义函数UDF UDTF UDAF

Hive 自定义函数 UDF UDTF UDAF 1.UDF:用户定义(普通)函数,只对单行数值产生作用: UDF只能实现一进一出的操作. 定义udf 计算两个数最小值 public class Mi ...

- Hadoop生态圈-Hive的自定义函数之UDF(User-Defined-Function)

Hadoop生态圈-Hive的自定义函数之UDF(User-Defined-Function) 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任.

- Spark(十三)SparkSQL的自定义函数UDF与开窗函数

一 自定义函数UDF 在Spark中,也支持Hive中的自定义函数.自定义函数大致可以分为三种: UDF(User-Defined-Function),即最基本的自定义函数,类似to_char,to_ ...

- SparkSQL中的自定义函数UDF

在Spark中,也支持Hive中的自定义函数.自定义函数大致可以分为三种: UDF(User-Defined-Function),即最基本的自定义函数,类似to_char,to_date等 UDAF( ...

- 【Hive】自定义函数

Hive的自定义函数无法满足实际业务的需要,所以为了扩展性,Hive官方提供了自定义函数来实现需要的业务场景. 1.定义 (1)udf(user defined function): 自定义函数,特 ...

- 10_Hive自定义函数UDF

Hive官方的UDF手册地址是:https://cwiki.apache.org/confluence/display/Hive/LanguageManual+UDF 1.使用内置函数的快捷方法: 创 ...

- 大数据学习day29-----spark09-------1. 练习: 统计店铺按月份的销售额和累计到该月的总销售额(SQL, DSL,RDD) 2. 分组topN的实现(row_number(), rank(), dense_rank()方法的区别)3. spark自定义函数-UDF

1. 练习 数据: (1)需求1:统计有过连续3天以上销售的店铺有哪些,并且计算出连续三天以上的销售额 第一步:将每天的金额求和(同一天可能会有多个订单) SELECT sid,dt,SUM(mone ...

- T-SQL: 17 个与日期时间相关的自定义函数(UDF),周日作为周的最后一天,均不受 @@DateFirst、语言版本影响!

原文:T-SQL: 17 个与日期时间相关的自定义函数(UDF),周日作为周的最后一天,均不受 @@DateFirst.语言版本影响! CSDN 的 Blog 太滥了!无时不刻地在坏! 开始抢救性搬家 ...

随机推荐

- 如何遍历一个JSON对象的属性值???

当遇到一个JSON格式的对象时,不知道它有多少个属性,也不知道有什么属性,该如何遍历它的属性及其属性值呢??? 还是使用Java语言还是很像的,使用for语句. var obj = data[i]; ...

- 总结一下MVC思想

MVC (Model View Controler)本来是存在于Desktop程序中的,M是指数据模型,V是指用户界面,C则是控制器.使用MVC的目的是将M和V的实现代码分离,从而使同一个程序可以使用 ...

- SVN文件自动加锁-Win7

在Win7操作系统上 打开目录C:\Users\Administrator\AppData\Roaming\Subversion 用记事本打开config文件 将enable-auto-props = ...

- Gradle Goodness: Adding Tasks to a Predefined Group

In Gradle we can group related tasks using the group property of a task. We provide the name of our ...

- careercup-扩展性和存储限制10.3

题目 给你一个文件,里面包含40亿个整数,写一个算法找出该文件中不包含的一个整数, 假设你有1GB内存可用. 如果你只有10MB的内存呢? 解答 我们先来做个算术题,40亿个整数大概有多大? * ^ ...

- Swift_继承

Swift_继承 点击查看源码 func testInheritance() { //基类 class Base { var count = 0.0 var description: String { ...

- LeetCode 中级 - 救生艇(105)

第 i 个人的体重为 people[i],每艘船可以承载的最大重量为 limit. 每艘船最多可同时载两人,但条件是这些人的重量之和最多为 limit. 返回载到每一个人所需的最小船数.(保证每个人都 ...

- CF考古活动

Codeforces Beta Round #1 http://codeforces.com/contest/1 A.测试用水题,呵呵.给三个数nma,求ceil(n/a)*ceil(m/a). 长整 ...

- eclipse安装tomcat时只有locahost,不显示server name

Eclipseh中无法安装Tomcat,报错信息如下 Cannot create a server using the selected type 原因:以前安装的tomcat目录改变 解决方法: ...

- 获取DOM

<template> <div> <header-vue :msg="msg" ref="header">heheh< ...