wget 指令学习之递归抓取文档技巧

在线上阅读文档的时候,有没有想将它抓取到本地,以备没有网的时候阅读只需?

先上指令:

$ wget --user-agent="Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.36 (KHTML, like Gecko) Ubuntu Chromium/53.0.2785.143 Chrome/53.0.2785.143 Safari/537.36" -p -np -k -r --wait=1 http://www.tornadoweb.org/en/stable/

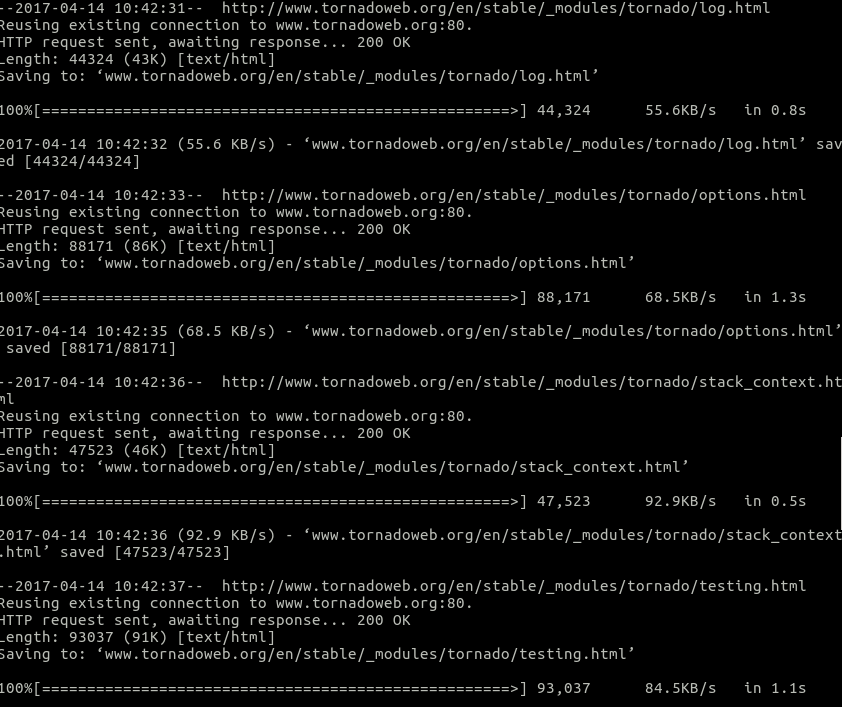

你会看到如下的页面:

过段时间,就会抓取完成,并在本地生成了一个相关联的目录。

这个命令就是 wget。它是开发者在Linux下面非常喜欢使用的下载指令。经常,我们会看到一些技术文档在指导你下载安装包的时候,也会用到,比如: wget xxx.tar.gz 之类的。

我们可以通过 man wget 或 wget -h 来查阅 wget 的参数。下面挑出几个常用的参数介绍下。

HTTP 相关的:

--http-user=USER 设置 http 用户名为 USER。

--http-password=PASS 设置 http 密码为 PASS。

--no-cache 不在服务器上缓存数据。

-U, --user-agent=AGENT 标识为 AGENT 而不是 Wget/VERSION。

--no-http-keep-alive 禁用 HTTP keep-alive (永久连接)。

--no-cookies 不使用 cookies。

--load-cookies=FILE 会话开始前从 FILE 中载入 cookies。

--save-cookies=FILE 会话结束后保存 cookies 至 FILE。

--keep-session-cookies 载入并保存会话 (非永久) cookies。

--post-data=STRING 使用 POST 方式;把 STRING 作为数据发送。

--post-file=FILE 使用 POST 方式;发送 FILE 内容。

--content-disposition 当选中本地文件名时

允许 Content-Disposition 头部 (尚在实验)。

--auth-no-challenge 发送不含服务器询问的首次等待

的基本 HTTP 验证信息。

下载相关的:

-w, --wait=SECONDS 等待间隔为 SECONDS 秒。

--waitretry=SECONDS 在获取文件的重试期间等待 1..SECONDS 秒。

--random-wait 获取多个文件时,每次随机等待间隔

0.5*WAIT...1.5*WAIT 秒。

-O --output-document=FILE 将文档写入 FILE。

递归下载:

-r, --recursive 指定递归下载。

-p, --page-requisites 下载所有用于显示 HTML 页面的图片之类的元素。

-k, --convert-links 让下载得到的 HTML 或 CSS 中的链接指向本地文件。

-np, --no-parent 不追溯至父目录。

原文网址 http://www.cnblogs.com/scharfsinnig/p/6707859.html 参考文档:

http://linux.51yip.com/search/wget

wget 指令学习之递归抓取文档技巧的更多相关文章

- scrapy递归抓取网页数据

scrapy spider的parse方法能够返回两种值:BaseItem.或者Request.通过Request能够实现递归抓取. 假设要抓取的数据在当前页,能够直接解析返回item(代码中带**凝 ...

- Xml学习笔记(3)利用递归解析Xml文档添加到TreeView中

利用递归解析Xml文档添加到TreeView中 private void Form1_Load(object sender, EventArgs e) { XmlDocument doc = new ...

- SpringBoot学习笔记:Swagger实现文档管理

SpringBoot学习笔记:Swagger实现文档管理 Swagger Swagger是一个规范且完整的框架,用于生成.描述.调用和可视化RESTful风格的Web服务.Swagger的目标是对RE ...

- python爬虫学习:分布式抓取

前面的文章都是基于在单机操作,正常情况下,一台机器无论配置多么高,线程开得再多,也总会有一个上限,或者说成本过于巨大.因此,本文将提及分布式的爬虫,让爬虫的效率提高得更快. 构建分布式爬虫首先需要有多 ...

- Node.js的学习--使用cheerio抓取网页数据

打算要写一个公开课网站,缺少数据,就决定去网易公开课去抓取一些数据. 前一阵子看过一段时间的Node.js,而且Node.js也比较适合做这个事情,就打算用Node.js去抓取数据. 关键是抓取到网页 ...

- Java学习-046-日志抓取合并后排序问题解决方案之 --- log4j 二次定制,实现日志输出添加延时10ms

自3月25至今,已经好久没有写学习日志了,今天在写日志抓取合并的小方法,发现抓取后的日志并米有依据系统执行的日志顺序排序.日志抓取排列逻辑如下: 通过日志标识,从各个日志文件(例如 use.log,e ...

- Nodejs全站开发学习系列 & 深入浅出Node学习笔记 & Spider抓取

https://course.tianmaying.com/node 这个系列的文章看起来很不错,值得学习一下. /Users/baidu/Documents/Data/Interview/Web-S ...

- Nutch学习笔记二——抓取过程简析

在上篇学习笔记中http://www.cnblogs.com/huligong1234/p/3464371.html 主要记录Nutch安装及简单运行的过程. 笔记中 通过配置抓取地址http://b ...

- hibernate框架学习之数据抓取(加载)策略helloworld

package cn.itcast.h3.query.hql; import java.util.List; import org.hibernate.Query; import org.hibern ...

随机推荐

- 通过.ENV文件来配置ThinkPHP的数据库连接信息

在ThinkPHP系统根目录创建.env文件,注意WINDOWS无法直接右键创建,使用编辑器保存时设置文件名为.env就可以创建文件.内容如下: .evn文件内容如下: [database] host ...

- UVA-11134 Fabled Rooks 贪心问题(区间贪心)

题目链接:https://cn.vjudge.net/problem/UVA-11134 题意 在 n*n 的棋盘上,放上 n 个车(ju).使得这 n 个车互相不攻击,即任意两个车不在同一行.同一列 ...

- POJ2104 K-th Number(线段树,二分,vector)

题意 不带修改区间第k小.(n<=100000) 题解 建立线段数和vector数组(vector为当前区间排列之后的序列)(归并) 然后对于每一个询问二分答案. 问题就转化为区间有多少数小于等 ...

- 【ICM Technex 2018 and Codeforces Round #463 (Div. 1 + Div. 2, combined) D】Tree

[链接] 我是链接,点我呀:) [题意] 让你在树上找一个序列. 这个序列中a[1]=R 然后a[2],a[3]..a[d]它们满足a[2]是a[1]的祖先,a[3]是a[2]的祖先... 且w[a[ ...

- HDU 5386 Cover(模拟)

Cover Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 65536/65536 K (Java/Others) Total Subm ...

- 免费WiFi初体验——个小白的WiFi旅程

说来羞愧,真正接触到WiFi还是在毕业后,此前自己封闭在一个人的世界,再加上外在学校的包围,我还成了个"山里"的孩子. 去年毕业了,也算是个90后,可自觉得心态过于成熟.了解外界太 ...

- vim 基础学习之文件跳转

1. ''-当前文件上次跳转之前的位置2. '.-当前文件上次修改的位置,只要是发生了可能导致变化的命令操作就会被标记,哪怕实际结果没有变化3. '^-当前文件上次插入的位置,只要是发生了插入操作命令 ...

- Ehcache整合spring配置,配置springMVC缓存

为了提高系统的运行效率,引入缓存机制,减少数据库访问和磁盘IO.下面说明一下ehcache和spring整合配置. 1. 需要的jar包 slf4j-api-1.6.1.jar ehcache-c ...

- CORS with Spring MVC--转

原文地址:http://dontpanic.42.nl/2015/04/cors-with-spring-mvc.html CORS with Spring MVC In this blog po ...

- Codeforces Round #240 (Div. 2) 题解

A: 1分钟题,往后扫一遍 int a[MAXN]; int vis[MAXN]; int main(){ int n,m; cin>>n>>m; MEM(vis,); ; i ...