爬虫,爬取景点信息采用pandas整理数据

一、首先需要导入我们的库函数

导语:通过看网上直播学习得到,如有雷同纯属巧合。

import requests#请求网页链接

import pandas as pd#建立数据模型

from bs4 import BeautifulSoup

import io

import sys#防止乱码

sys.stdout=io.TextIOWrapper(sys.stdout.buffer,encoding='gb18030')

注:如有库安装不了,可参考上一篇随笔。

二、源代码:

1 import requests

import pandas as pd

from bs4 import BeautifulSoup

import io

import sys#防止乱码

sys.stdout=io.TextIOWrapper(sys.stdout.buffer,encoding='gb18030')

def get_url(n):

#获取网页链接

urls=[]

for i in range(1,n+1):

urls.append('https://travel.qunar.com/p-cs299878-shanghai-jingdian-1-%s' %i)#获取n段网页链接

return urls pass def get_data(url):#获取一段网页链接的数据

r=requests.get(url)

soup=BeautifulSoup(r.text,'lxml')#lxml一种不错的编译器

ul=soup.find('ul',class_='list_item clrfix')#在网页中通过查找元素信息找到其名称

lis=ul.find_all('li')#查找所有信息

datalst=[]#定义一个数据字典

for li in lis:

dic={}#将需要查找的信息写入数据字典

dic['景点名称']=li.find('span',class_='cn_tit').text

dic['星级']=li.find('span',class_='cur_star')['style'].split(':')[1].replace('%','')#将数据中的百分号去掉实现初步数据清洗

dic['经度']=li['data-lng']

dic['纬度']=li['data-lat']

datalst.append(dic)

return datalst def get_alldata(n):#按要求查找多段网页链接的数据

alldata=[]

for url in get_url(n):

alldata.extend(get_data(url))

return alldata

#print(get_alldata(2))

df=pd.DataFrame(get_alldata(2))#建立pandas模型,按要求输出

print(df)

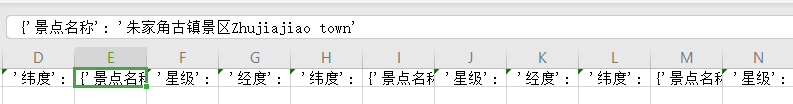

三、运行结果:

四、存储:

这里采用csv存储,在获取信息时写入以下代码把取得的信息写入表格中。

def get_alldata(n):

alldata=[]

for url in get_url(n):

alldata.extend(get_data(url))

alldata=[str(x) for x in alldata]

with open('describe.csv','a',encoding='utf8')as f:#在自己的运行目录下新建一个csv后缀名的文件夹然后打开以读写的方式

f.write(','.join('%s' %id for id in alldata))#为了防止数字转字符串出错首先逐个遍历我们的列表然后再写入

f.close()#操作完成应记住关闭文件夹。

return alldata

运行结果:

如上图所示数据已成功写入csv文件夹中。

小有瑕疵,初学见谅!!!

爬虫,爬取景点信息采用pandas整理数据的更多相关文章

- python爬虫爬取get请求的页面数据代码样例

废话不多说,上代码 #!/usr/bin/env python # -*- coding:utf-8 -*- # 导包 import urllib.request import urllib.pars ...

- 用Python写爬虫爬取58同城二手交易数据

爬了14W数据,存入Mongodb,用Charts库展示统计结果,这里展示一个示意 模块1 获取分类url列表 from bs4 import BeautifulSoup import request ...

- Python爬虫爬取异步加载的数据

前言 本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理.作者:努力努力再努力 爬取qq音乐歌手数据接口数据 https://y.qq ...

- 养只爬虫当宠物(Node.js爬虫爬取58同城租房信息)

先上一个源代码吧. https://github.com/answershuto/Rental 欢迎指导交流. 效果图 搭建Node.js环境及启动服务 安装node以及npm,用express模块启 ...

- (转)Python网络爬虫实战:世纪佳缘爬取近6万条数据

又是一年双十一了,不知道从什么时候开始,双十一从“光棍节”变成了“双十一购物狂欢节”,最后一个属于单身狗的节日也成功被攻陷,成为了情侣们送礼物秀恩爱的节日. 翻着安静到死寂的聊天列表,我忽然惊醒,不行 ...

- MATLAB爬虫爬取股票数据

近年来,大数据盛行,有关爬虫的教程层次不穷.那么,爬虫到底是什么呢? 什么是爬虫? 百度百科是这样定义的: 网络爬虫(又被称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种 ...

- 爬虫爬数据时,post数据乱码解决办法

最近在写一个爬虫,目标网站是:http://zx.bjmemc.com.cn/,可能是为了防止被爬取数据,它给自身数据加了密.用谷歌自带的抓包工具也不能捕获到数据.于是下了Fiddler. F ...

- 爬虫(二)Python网络爬虫相关基础概念、爬取get请求的页面数据

什么是爬虫 爬虫就是通过编写程序模拟浏览器上网,然后让其去互联网上抓取数据的过程. 哪些语言可以实现爬虫 1.php:可以实现爬虫.php被号称是全世界最优美的语言(当然是其自己号称的,就是王婆 ...

- Python网络爬虫第三弹《爬取get请求的页面数据》

一.urllib库 urllib是Python自带的一个用于爬虫的库,其主要作用就是可以通过代码模拟浏览器发送请求.其常被用到的子模块在Python3中的为urllib.request和urllib. ...

随机推荐

- 无聊系列 - C#中一些常用类型与java的类型对应关系

昨天在那个.NET转java群里,看到一位朋友在问C#的int 对应java的哪个对象,就心血来潮,打算写一下C#中一些基础性的东西,在java中怎么找. 1. 基础值类型 如:int,long,do ...

- 线程池之ScheduledThreadPoolExecutor线程池源码分析笔记

1.ScheduledThreadPoolExecutor 整体结构剖析. 1.1类图介绍 根据上面类图图可以看到Executor其实是一个工具类,里面提供了好多静态方法,根据用户选择返回不同的线程池 ...

- kali渗透综合靶机(十六)--evilscience靶机

kali渗透综合靶机(十六)--evilscience靶机 一.主机发现 1.netdiscover -i eth0 -r 192.168.10.0/24 二.端口扫描 1. masscan --ra ...

- PIE调用Python获得彩色直方图

前段时间我一直在研究PIE SDK与Python的结合,因为在我的开发中,我想获取一张图片的统计直方图,虽然在SDK中有提供关于直方图的类接口(如IStatsHistogram 接口.Histogra ...

- [笔记] Git 冲突处理

这是一篇关于 git 解冲突的笔记,没有什么干货. TortoiseGit 小乌龟 通常情况下,会比较喜欢使用小乌龟解冲突,详见:git 使用 tortoisegit 解冲突 但部分复杂的场景,反而需 ...

- IntelliJ IDEA2018激活码

使用前提: 在hosts文件里面添加一行,hosts文件在Windows系统中的路径:C:\Windows\System32\drivers\etc\,Linux系统存放在/etc目录下. 0.0.0 ...

- Linux文本文件——管理文本的命令

Linux文本文件——管理文本的命令 摘要:本文主要学习了在Linux中管理文本的命令. cat命令 cat命令用来显示文本文件的内容,也可以把几个文件内容附加到另一个文件中,即连接合并文件,是Con ...

- Java生鲜电商平台-销售管理设计与架构

Java生鲜电商平台-销售管理设计与架构 说明:在Java开源生鲜电商平台中,销售人员我们称为跟餐饮店老板沟通与下载APP的一类地推人员.(所谓地推指的就是一个一个上门拜访.) 由于销售人员有以下几类 ...

- Map-HashMap-遍历

第一种遍历方法 : 先获取Map中的所有key值,然后根据key,依次从Map中去数据 (针对只取 Key 或者 Value 的情况) Map<String, String> hashMa ...

- python 检查站点是否可以访问

最近碰到系统有时候会访问不了,想写一个程序来检测站点是不是可以访问的功能,正好在学python,于是写了一个方法来练练手,直接上代码. import urllib.request import smt ...