机器学习SVD笔记

机器学习中SVD总结

矩阵分解的方法

- 特征值分解。

- PCA(Principal Component Analysis)分解,作用:降维、压缩。

- SVD(Singular Value Decomposition)分解,也叫奇异值分解。

- LSI(Latent Semantic Indexing)或者叫LSA(Latent Semantic Analysis),隐语义分析分解。

- PLSA(Probabilistic Latent Semantic Analysis),概率潜在语义分析。PLSA和LDA都是主题模型,PLSA是判别式模型。

- NMF(Non-negative Matrix Factorization),非负矩阵分解。非负矩阵分解能够广泛应用于图像分析、文本挖掘和语言处理等领域。

- LDA(Latent Dirichlet Allocation)模型,潜在狄利克雷分配模型。LDA是一种主题模型,将文档集中每篇文档的主题以概率的形式给出,

可以用于主题聚类或者文本分类,是生成式模型。LDA作为主题模型可以应用到很多领域,

比如:文本情感分析、文本分类、个性化推荐、社交网络、广告预测等方面。 - MF(Matrix Factorization)模型,矩阵分解模型。矩阵分解其实可以分为很多种:

基本矩阵分解(Basic Matrix Factorization),basic MF分解。

正则化矩阵分解(Regularized Matrix Factorization)。

概率矩阵分解(Probabilistic Matrix Factorization),PMF。

非负矩阵分解(Non-negative Matrix Factorization),NMF。

正交非负矩阵分解(Orthogonal Non-negative Matrix Factorization)。

PMF(Probabilistic Matrix Factorization),概率矩阵分解。

SVD++

关于矩阵分解的方法大概就是上面这些。矩阵分解的主要应用是:降维、聚类分析、数据预处理、低维度特征学习、特征学习、推荐系统、大数据分析等。

上面把主要的矩阵分解方法给列出来了,比较混乱,再给大家摆上一张矩阵分解发展的历史:

|

PCA, SVD, LSI |

1999 |

PLSA, NMF, LDA |

2006 |

MF, PMF, SVD++ |

|

降维 聚类分析 数据预处理 |

低维度特征学习 聚类分析 |

特征学习 推荐系统 大数据分析 |

推荐学习的经典矩阵分解算法

矩阵分解的算法这么多,给大家推荐几个经典的算法来学习:

1) 经典的PCA、SVD是机器学习入门必学算法。

2) 2003年提出的主题模型LDA,在当年提出的时候,也是大红大紫,现在也在广泛的应用,可以学习一下。

3) 概率矩阵分解(PMF),主要应用到推荐系统中,在大规模的稀疏不平衡Netflix数据集上取得了较好的结果。

4) 非负矩阵分解,也很重要。非负矩阵分解及其改进版本应用到很多领域中。

SVD具体介绍

- 特征值、特征向量、特征值分解

特征值分解和奇异值分解在机器学习中都是很常见的矩阵分解算法。两者有着很紧密的关系,特征值分解和奇异值分解的目的都是一样,就是提取出一个矩阵最重要的特征。

1)特征值、特征向量

如果一个向量v是矩阵A的特征向量,将一定可以表示成下面的形式:

Av=λv

其中,λ是特征向量v对应的特征值,一个矩阵的一组特征向量是一组正交向量。

思考:为什么一个向量和一个数相乘的效果与一个矩阵和一个向量相乘的效果是一样的呢?

答案:矩阵A与向量v相乘,本质上是对向量v进行了一次线性变换(旋转或拉伸),而该变换的效果为常数λ乘以向量v。

当我们求特征值与特征向量的时候,就是为了求矩阵A能使哪些向量(特征向量)只发生伸缩变换,而变换的程度可以用特征值λ表示。

2)特征值与特征向量的几何意义

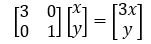

一个矩阵其实就是一个线性变换,因为一个矩阵乘以一个向量后得到的向量,其实就相当于将这个向量进行了线性变换。比如说下面的这个矩阵:

这个矩阵M乘以一个向量(x,y)的结果是:

上面的矩阵是对称的,所以这个变换是一个对x、y轴的方向一个拉伸变换(每一个对角线上的元素将会对一个维度进行拉伸变换,

当值大于1时是拉伸,当值小于1时是缩短)。当

这时M就可以对平面上的一个轴进行拉伸变换。当然在这里我们可以参照下面的内容:

http://www.cnblogs.com/LeftNotEasy/archive/2011/01/19/svd-and-applications.html

其实,有条件的话也可以翻阅以下大学里的线性代数看一下就会明白。

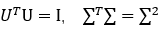

特征值分解

对于矩阵A,有一组特征向量v,将这组向量进行正交化单位化,就能得到一组正交单位向量。特征值分解,就是将矩阵A分解为如下式:

其中,Q是矩阵A的特征向量组成的矩阵,∑则是一个对角阵,对角线上的元素就是特征值。我们来分析一下特征值分解的式子,分解得到的∑矩阵是一个对角矩阵,里面的特征值是由大到小排列的,这些特征值所对应的特征向量就是描述这个矩阵变换方向(从主要的变化到次要的变化排列)。

当矩阵是高维的情况下,那么这个矩阵就是高维空间下的一个线性变换,这个线性变换可能没法通过图片来表示,但是可以想象,这个变换也同样有很多的变化方向,我们通过特征值分解得到的前N个特征向量,就对应了这个矩阵最主要的N个变化方向。我们利用这前N个变化方向,就可以近似这个矩阵变换。也就是之前说的:提取这个矩阵最重要的特征。

总结:特征值分解可以得到特征值与特征向量,特征值表示的是这个特征到底有多么重要,而特征向量表示这个特征是什么,可以将每一个特征向量理解为一个线性的子空间,我们可以利用这些线性的子空间干很多事情。不过,特征值分解也有很多的局限,比如说变换的矩阵必须是方阵。

3)特征值分解的例子

https://jingyan.baidu.com/article/27fa7326afb4c146f8271ff3.html

SVD分解

1) 特征值分解矩阵的缺点

我们前面讲了很多特征值、特征向量和特征值分解,而且基于我们以前学习的线性代数知识,利用特征值分解提取特征矩阵是一个容易理解且便于实现的方法。但是为什么还存在奇异值分解呢?特征值分解最大的问题是只能针对方阵,即n*n的矩阵。而在实际的应用中,我们分解的大部分都不是方阵。

举个例子:

关系型数据库中的某一张表的数据存储结构就类似于一个二维矩阵,假设这个表有m行,有n个字段,那么这个表数据矩阵规模就是m*n。很明显,在绝大部分情况下,m与n是不相等的。如果这个时候要对这个矩阵进行特征提取,特征值分解的方法明显就不行了。此时,就可以用SVD对非方阵矩阵进行分解。

2) 奇异值分解

奇异值分解是一个能适用于任意矩阵的一种分解的方法,对于任意矩阵A总是存在一个奇异值分解:

假设A是一个m*n的矩阵,那么得到的U是一个m*m的方阵,U里面的正交向量被称为左奇异向量。Σ是一个m*n的矩阵,Σ除了对角线其它元素都为0,对角线上的元素称为奇异值。是v的转置矩阵,是一个n*n的矩阵,它里面的正交向量被称为右奇异值向量。而且一般来讲,我们会将Σ上的值按从大到小的顺序排列。

思考:虽说上面奇异值分解等式成立,但是如何求得左奇异向量、右奇异向量和奇异值呢?

答案:由上面的奇异值分解等式,我们是不知道如何拆分矩阵A的。我们可以把奇异值和特征值联系起来。

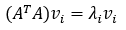

首先,我们用矩阵A的转置乘以A,得到一个方阵,用这样的方阵进行特征分解,得到的特征值和特征向量满足下面的等式:

这里vi就是我们要求的右奇异向量。

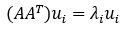

其次,我们将A和A的转置做矩阵的乘法,得到一个方阵,用这样的方阵进行特征分解,得到的特征和特征向量满足下面的等式:

这里的ui 就是左奇异向量。

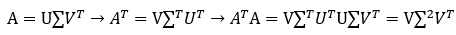

思考:上面我们说 的特征向量组成的矩阵就是我们SVD中的V矩阵,而的特征向量组成的就是我们SVD中的U矩阵,这有什么根据么?我们来证明一下,以V矩阵的证明为例。

上式证明中使用了 。可以看出ATA的特征向量组成的矩阵就是我们SVD中的V矩阵,而AAT的特征向量组成的就是我们SVD中的U矩阵。

。可以看出ATA的特征向量组成的矩阵就是我们SVD中的V矩阵,而AAT的特征向量组成的就是我们SVD中的U矩阵。

此外,我们还可以得到奇异值,奇异值求法有两种:

a) 第一种:

b) 第二种:

通过上面的证明,我们还可以看出,特征值矩阵等于奇异值矩阵的平方,也就是说特征值和奇异值满足如下关系:

这里的就是奇异值,奇异值跟特征值类似,在矩阵Σ中也是从大到小排列。

思考:我们已经知道如何用奇异值分解任何矩阵了,那么问题又来了,一个m*n的矩阵A,你把它分解成m*m的矩阵U、m*n的矩阵Σ和n*n的矩阵。。这三个矩阵中任何一个的维度似乎一点也不比A的维度小,而且还要做两次矩阵的乘法,这不是没事找事干嘛!把简单的事情搞复杂了么!并且我们知道矩阵乘法的时间复杂度为O(n3)。

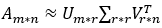

答案:在奇异值分解矩阵中Σ里面的奇异值按从大到小的顺序排列,奇异值从大到小的顺序减小的特别快。在很多情况下,前10%甚至1%的奇异值的和就占了全部的奇异值之和的99%以上。也就是说,剩下的90%甚至99%的奇异值几乎没有什么作用。因此,我们可以用前面r个大的奇异值来近似描述矩阵,于是奇异值分解公式可以写成如下:

其中r是一个远远小于m和n的数,右边的三个矩阵相乘的结果将会使一个接近A的矩阵。如果r越接近于n,则相乘的结果越接近于A。如果r的取值远远小于n,从计算机内存的角度来说,右边三个矩阵的存储内存要远远小于矩阵A的。所以在奇异值分解中r的取值很重要,就是在计算精度和时间空间之间做选择。

SVD计算举例

https://mp.weixin.qq.com/s/Dv51K8JETakIKe5dPBAPVg

SVD分解的应用

奇异值分解的应用有很多,比如:用SVD解PCA、潜在语言索引也依赖于SVD算法。可以说,SVD是矩阵分解、降维、压缩、特征学习的一个基础的工具,所以SVD在机器学习领域相当的重要。

1) 降维。

通过奇异值分解的公式,我们可以很容易看出来,原来矩阵A的特征有n维。经过SVD分解后,可以用前r个非零奇异值对应的奇异向量表示矩阵A的主要特征,这样就把矩阵A进行了降维。

2) 压缩。

通过奇异值分解的公式,我们可以看出来,矩阵A经过SVD分解后,要表示原来的大矩阵A,我们只需要存储U、Σ、V三个较小的矩阵即可。而这三个较小规模的矩阵占用内存上也是远远小于原有矩阵A的,这样SVD分解就起到了压缩的作用。

***声明:本笔记只是用来回顾与记忆的,死的知识点各种好博客讲的都很到位,我也是东拼西凑尽量让自己更加明白机器学习是怎么回事,所以请大神看到自己的东西被借用还请原谅,没有涉及诋毁和任何商业行为,仅学习借鉴用。***

机器学习SVD笔记的更多相关文章

- 机器学习&数据挖掘笔记(常见面试之机器学习算法思想简单梳理)

机器学习&数据挖掘笔记_16(常见面试之机器学习算法思想简单梳理) 作者:tornadomeet 出处:http://www.cnblogs.com/tornadomeet 前言: 找工作时( ...

- [转]机器学习&数据挖掘笔记_16(常见面试之机器学习算法思想简单梳理)

机器学习&数据挖掘笔记_16(常见面试之机器学习算法思想简单梳理) 转自http://www.cnblogs.com/tornadomeet/p/3395593.html 前言: 找工作时(I ...

- Andrew 机器学习课程笔记

Andrew 机器学习课程笔记 完成 Andrew 的课程结束至今已有一段时间,课程介绍深入浅出,很好的解释了模型的基本原理以及应用.在我看来这是个很好的入门视频,他老人家现在又出了一门 deep l ...

- 【读书笔记与思考】Andrew 机器学习课程笔记

Andrew 机器学习课程笔记 完成 Andrew 的课程结束至今已有一段时间,课程介绍深入浅出,很好的解释了模型的基本原理以及应用.在我看来这是个很好的入门视频,他老人家现在又出了一门 deep l ...

- 机器学习&数据挖掘笔记_14(GMM-HMM语音识别简单理解)

为了对GMM-HMM在语音识别上的应用有个宏观认识,花了些时间读了下HTK(用htk完成简单的孤立词识别)的部分源码,对该算法总算有了点大概认识,达到了预期我想要的.不得不说,网络上关于语音识别的通俗 ...

- Andrew Ng机器学习课程笔记(五)之应用机器学习的建议

Andrew Ng机器学习课程笔记(五)之 应用机器学习的建议 版权声明:本文为博主原创文章,转载请指明转载地址 http://www.cnblogs.com/fydeblog/p/7368472.h ...

- Andrew Ng机器学习课程笔记--week1(机器学习介绍及线性回归)

title: Andrew Ng机器学习课程笔记--week1(机器学习介绍及线性回归) tags: 机器学习, 学习笔记 grammar_cjkRuby: true --- 之前看过一遍,但是总是模 ...

- Andrew Ng机器学习课程笔记--汇总

笔记总结,各章节主要内容已总结在标题之中 Andrew Ng机器学习课程笔记–week1(机器学习简介&线性回归模型) Andrew Ng机器学习课程笔记--week2(多元线性回归& ...

- ng机器学习视频笔记(一)——线性回归、代价函数、梯度下降基础

ng机器学习视频笔记(一) --线性回归.代价函数.梯度下降基础 (转载请附上本文链接--linhxx) 一.线性回归 线性回归是监督学习中的重要算法,其主要目的在于用一个函数表示一组数据,其中横轴是 ...

随机推荐

- Mysql 按年、季度、月、周查询统计

User表 CREATE TABLE `user` ( `id` int(11) NOT NULL AUTO_INCREMENT COMMENT '用户ID', `username` varchar( ...

- Thingsboard HTTP连接至服务器

当布署了Thingsboard服务器后,可以通过在服务器地址后,加入swagger-ui.html来打开API文档

- QTextToSpeech Win7奔溃

在linux下,它是调用speech-dispatcher.在其它不同的平台上,调用各自平台的TTS引擎.所以在使用的时候,要确保本地的TTS引擎是可用的. 本地TTS引擎不可用可能会在声明QText ...

- 【阿里云IoT+YF3300】9.快速开发modbus设备驱动

Modbus是一种串行通信协议,是莫迪康公司为PLC(编程逻辑控制器)通信而设计的协议.Modbus目前已经成为工业领域通信协议的业界标准,大部分的仪器仪表都支持该通信协议.很早以前就开发过基于Mod ...

- springlcoud中使用consul作为注册中心

好久没写博客了,从今天开始重新杨帆起航............................................ springlcoud中使用consul作为注册中心. 我们先对比下注册 ...

- shared_ptr 引用计数

https://zh.cppreference.com/w/cpp/memory/shared_ptr 引用计数

- Chaos Engineering 混沌工程 Chaos Monkey vs Chaos xxx vs Chaos Blade

Chaos Engineering的历史.原则以及实践https://www.infoq.cn/article/chaos-engineering-the-history-principles-and ...

- (E2E_L2)包含目录、库目录、附加包含目录、附加库目录、附加依赖项之详解【正确的目录添加方法】

VS项目中的包含目录.库目录.附加包含目录.附加库目录.附加依赖项均在"项目->属性->配置属性"下进行配置 一.具体说明如下: 1.VC++目录: 包含目录: ...

- 阿里云配置WAF的步骤

date:2019-07-04 17:59:19 author: headsen chen 配置WAF防护策略 本页目录 操作步骤 网站接入Web应用防火墙(WAF)后,WAF以默认防护策略为其过滤 ...

- jenkins用户和权限管理

添加用户 进入管理界面,选择manage users,添加用户 将人和角色绑定 用户和项目绑定 角色管理 可以针对不同的站点对不同的人赋权 添加角色并赋权 将角色赋权给对应的用户 使用新添加的这个用户 ...