java 简单操作HDFS

创建java 项目

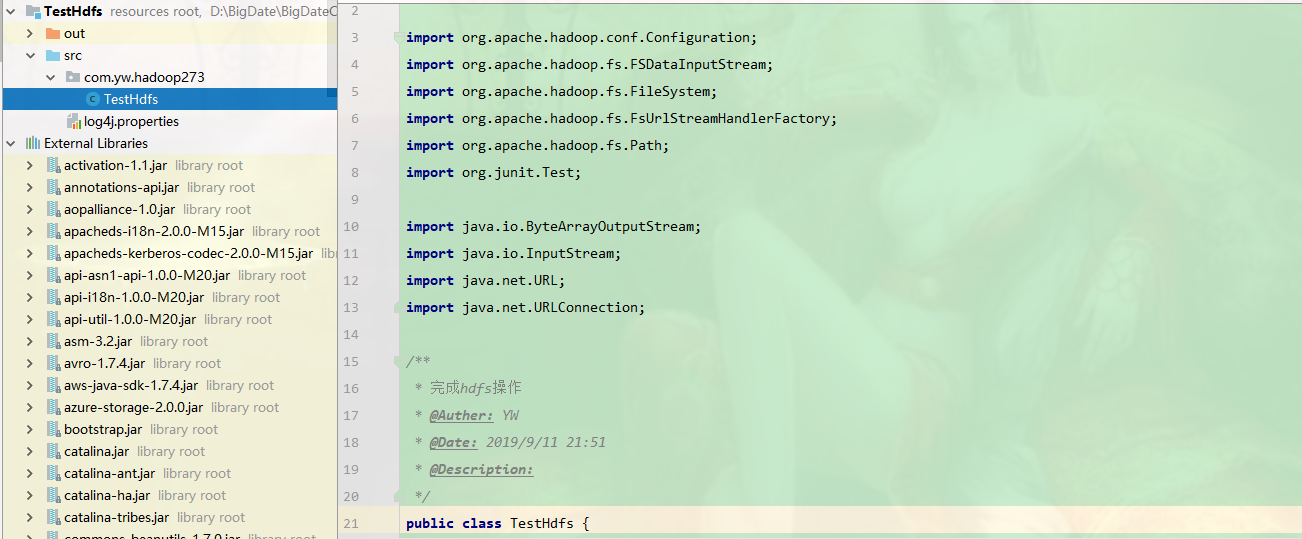

package com.yw.hadoop273; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.apache.hadoop.io.IOUtils;

import org.junit.Test; import java.io.ByteArrayOutputStream;

import java.io.InputStream;

import java.net.URL;

import java.net.URLConnection; /**

* 完成hdfs操作

* @Auther: YW

* @Date: 2019/9/11 21:51

* @Description:

*/

public class TestHdfs {

/**

* 读取hdfs文件

*/

@Test

public void readFile() throws Exception{

//注册url流处理器工厂(hdfs)

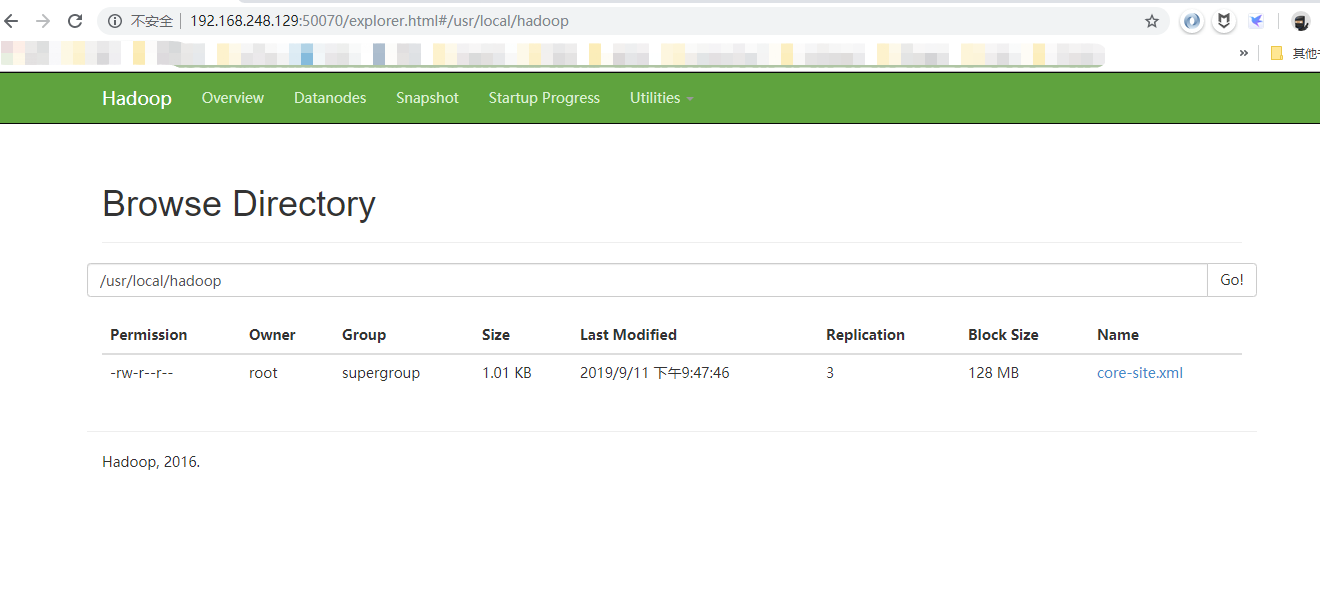

URL.setURLStreamHandlerFactory(new FsUrlStreamHandlerFactory()); URL url = new URL("hdfs://http://192.168.248.129:8020/usr/local/hadoop/core-site.xml");

URLConnection conn = url.openConnection();

InputStream is = conn.getInputStream();

byte[] buf = new byte[is.available()];

is.read(buf);

is.close();

String str = new String(buf);

System.out.println(str);

} /**

* 通过hadoop API访问文件

*/

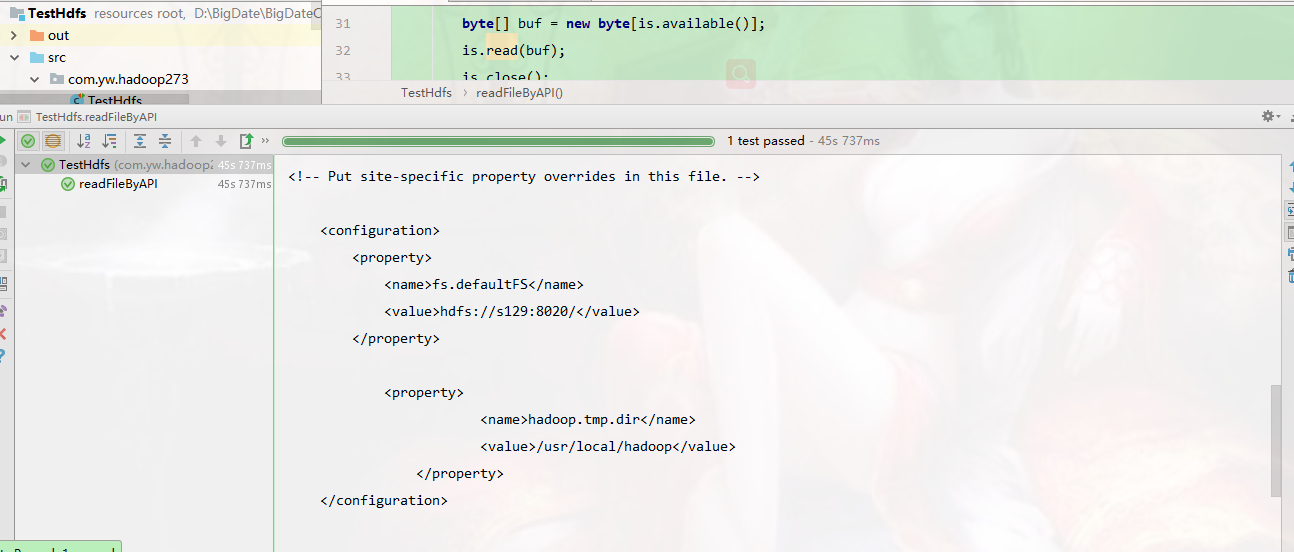

@Test

public void readFileByAPI() throws Exception{

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://192.168.248.129:8020/");

FileSystem fs = FileSystem.get(conf) ;

Path p = new Path("/usr/local/hadoop/core-site.xml");

FSDataInputStream fis = fs.open(p);

byte[] buf = new byte[1024];

int len = -1 ; ByteArrayOutputStream baos = new ByteArrayOutputStream();

while((len = fis.read(buf)) != -1){

baos.write(buf, 0, len);

}

fis.close();

baos.close();

System.out.println(new String(baos.toByteArray()));

}

/**

* 通过hadoop API访问文件

*/

@Test

public void readFileByAPI2() throws Exception{

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://192.168.248.129:8020/");

FileSystem fs = FileSystem.get(conf) ;

ByteArrayOutputStream baos = new ByteArrayOutputStream();

Path p = new Path("/usr/local/hadoop/core-site.xml");

FSDataInputStream fis = fs.open(p);

IOUtils.copyBytes(fis, baos, 1024);

System.out.println(new String(baos.toByteArray()));

} /**

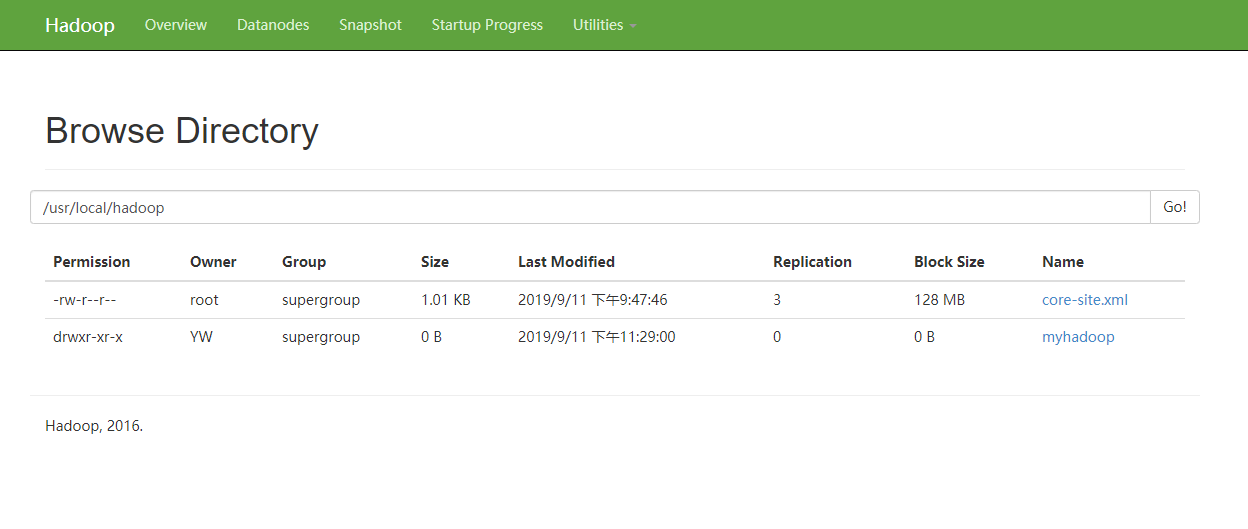

* mkdir 创建目录

*/

@Test

public void mkdir() throws Exception{

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://192.168.248.129:8020/");

FileSystem fs = FileSystem.get(conf) ;

fs.mkdirs(new Path("/usr/local/hadoop/myhadoop"));

} /**

* putFile 写文件

*/

@Test

public void putFile() throws Exception{

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://192.168.248.129:8020/");

FileSystem fs = FileSystem.get(conf) ;

FSDataOutputStream out = fs.create(new Path("/usr/local/hadoop/myhadoop/a.txt"));

out.write("helloworld".getBytes());

out.close();

} /**

* removeFile 删除目录 (注意权限)

*/

@Test

public void removeFile() throws Exception{

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://192.168.248.129:8020/");

FileSystem fs = FileSystem.get(conf) ;

Path p = new Path("/usr/local/hadoop/myhadoop");

fs.delete(p, true);

}

}

注意权限的修改

hdfs dfs -chmod 777 /usr/local/hadoop/

读到的内容

创建目录文件

完成。。

java 简单操作HDFS的更多相关文章

- Java 简单操作hdfs API

注:图片如果损坏,点击文章链接:https://www.toutiao.com/i6632047118376780295/ 启动Hadoop出现问题:datanode的clusterID 和 name ...

- 使用Java API操作HDFS文件系统

使用Junit封装HFDS import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.*; import org ...

- Java代码操作HDFS测试类

1.Java代码操作HDFS需要用到Jar包和Java类 Jar包: hadoop-common-2.6.0.jar和hadoop-hdfs-2.6.0.jar Java类: java.net.URL ...

- 大数据之路week07--day01(HDFS学习,Java代码操作HDFS,将HDFS文件内容存入到Mysql)

一.HDFS概述 数据量越来越多,在一个操作系统管辖的范围存不下了,那么就分配到更多的操作系统管理的磁盘中,但是不方便管理和维护,因此迫切需要一种系统来管理多台机器上的文件,这就是分布式文件管理系统 ...

- Hadoop Java API操作HDFS文件系统(Mac)

1.下载Hadoop的压缩包 tar.gz https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/stable/ 2.关联jar包 在 ...

- 使用Java Api 操作HDFS

如题 我就是一个标题党 就是使用JavaApi操作HDFS,使用的是MAVEN,操作的环境是Linux 首先要配置好Maven环境,我使用的是已经有的仓库,如果你下载的jar包 速度慢,可以改变Ma ...

- 大数据-09-Intellij idea 开发java程序操作HDFS

主要摘自 http://dblab.xmu.edu.cn/blog/290-2/ 简介 本指南介绍Hadoop分布式文件系统HDFS,并详细指引读者对HDFS文件系统的操作实践.Hadoop分布式文件 ...

- Java代码操作HDFS(在/user/root/下面創建目錄)

1.创建HDFS目录并打成jar包 package Hdfs; import java.io.IOException; import java.net.URI; import org.apache.h ...

- hadoop 》》 django 简单操作hdfs 语句

>> from django.shortcuts import render # Create your views here. from hdfs.client import Clien ...

随机推荐

- 在java的Map集合中,怎样更改value的值

版权声明:本文为博主原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接和本声明. 本文链接:https://blog.csdn.net/chenyao1994/article/de ...

- Java TreeMap使用

场景: 随机生成50个10到50的数字.然后顺序输出每个数字出现的次数 实现原理: 使用TreeMap,默认带了顺序排序的功能 public static void main(String[] arg ...

- Android中jsoup的混淆规则【转】

Android中jsoup的混淆规则版权声明:转载必须注明本文转自严振杰的博客:http://blog.yanzhenjie.com 说实话这篇文章的标题和内容我觉得很水,所以读者们要是也觉得这篇文章 ...

- Springmvc & Report: FineReport vs BIRT vs Jasperreport

Springmvc与jasperreport结合生成报表的一种方法 - OneThin的个人空间 - OSCHINAhttps://my.oschina.net/onethin/blog/14360 ...

- vs 设置护眼背景颜色

工具 —> 选项 —> 环境 —> 字体和颜色 —> 纯文本(显示项中) —> 项目背景 —> 自定义—> 色调位85.饱和度123.亮度205,保存即可.测 ...

- vue的vuex在使用...mapState 和...mapGetter报错的解决方案

from:https://blog.csdn.net/ysterling/article/details/88145765 采用mapState 和mapGetter,在页面使用时报错,这是因为bab ...

- shell编程系列2--字符串的处理

shell编程系列2--字符串的处理 字符串的处理 .计算字符串的长度 方法1 ${#string} 方法2 expr length "$string" (如果string中间有空 ...

- 【DataBase】H2 DateBase的拓展使用

连接模式 支持以下连接模式: 嵌入模式(使用JDBC的本地连接) 服务器模式(使用JDBC或ODBC over TCP / IP进行远程连接) 混合模式(同时本地和远程连接) 嵌入模式 在嵌入模式下, ...

- QML注意color小写

1.用的时候大小写一样的 如: color="#3D3D3D" 和 color="#3d3d3d"都是同一个颜色 2.判断的时候,QML默认是小写 如:if(c ...

- Ubuntu 新装服务器部署流程

1.设定时区 rm -f /etc/localtime cp /usr/share/zoneinfo/Asia/Shanghai /etc/localtime 2.配置apt-get源 sed -i ...