『Scrapy』爬取腾讯招聘网站

分析爬取对象

初始网址,

http://hr.tencent.com/position.php?@start=0&start=0#a

(可选)由于含有多页数据,我们可以查看一下这些网址有什么相关

page2:http://hr.tencent.com/position.php?@start=0&start=10#a

page3:http://hr.tencent.com/position.php?@start=0&start=20#a

也就是说末尾id每次递增10(#a无实际意义,输入start=0也能进入第一页)。

确定想爬取的信息:

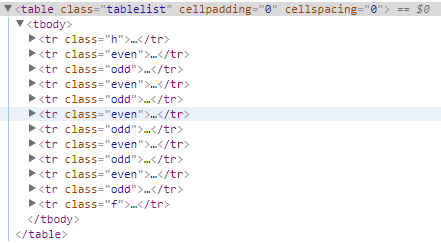

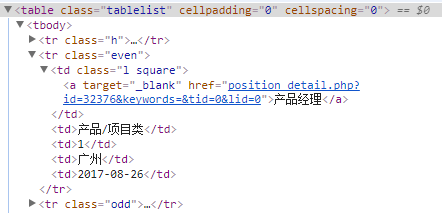

我们爬取表格中的5类信息和每个招聘的具体网页地址,共6个条目,在查看源码的过程中我们可以使用F12开发者工具辅助定位,

其中class=event的tr表示白色背景条目,class=odd表示灰色背景条目,点击开查看具体信息如下,

爬虫编写

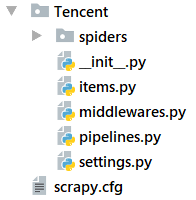

使用框架初始化项目,

scrapy startproject Tencent

修改items.py,对应上面需要记录的六组数据,

import scrapy class TencentItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

# 职位名

positionName = scrapy.Field()

# 职位详情链接

positionLink = scrapy.Field()

# 职位类别

positionType = scrapy.Field()

# 招聘人数

peopleNumber = scrapy.Field()

# 工作地点

workLocation = scrapy.Field()

# 发布时间

publishtime = scrapy.Field()

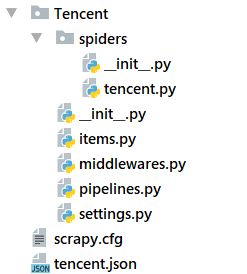

生成初始爬虫spider命名为tensent.py,

scrapy genspider tencent "tencent.com"

修改tencent.py,注意函数需要返回item

import scrapy

from Tencent.items import TencentItem class TencentSpider(scrapy.Spider):

name = "tencent"

allowed_domains = ["tencent.com"] baseURL = "http://hr.tencent.com/position.php?@start="

offset = 0

start_urls = [baseURL + str(offset)] def parse(self, response):

node_list = response.xpath("//tr[@class='even'] | //tr[@class='odd']") for node in node_list:

item = TencentItem() # 职位名

item['positionName'] = node.xpath("./td[1]/a/text()").extract()[0]

print(node.xpath("./td[1]/a/text()").extract()) # 职位详情链接

item['positionLink'] = node.xpath("./td[1]/a/@href").extract()[0] # 职位类别

if len(node.xpath("./td[2]/text()")):

item['positionType'] = node.xpath("./td[2]/text()").extract()[0]

else:

item['positionType'] = '' # 招聘人数

item['peopleNumber'] = node.xpath("./td[3]/text()").extract()[0] # 工作地点

item['workLocation'] = node.xpath("./td[4]/text()").extract()[0] # 发布时间

item['publishtime'] = node.xpath("./td[5]/text()").extract()[0] yield item # 换页方法一:直接构建url

if self.offset <2190:

self.offset += 10

url = self.baseURL + str(self.offset)

yield scrapy.Request(url, callback=self.parse) # callback函数可以更换,即可以使用不同的处理方法处理不同的页面

两个yield连用使得不同的调用次数函数输出不同的表达式,这是一个很好的技巧,不过第二个yield是可以替换为return的,毕竟提交一个新请求后引擎会自动调用parse去处理响应

这里面使用提取下一页的方法是自己拼接之后的网址,这是一种相对而言笨拙一点的手法,一般会直接在网页中提取下一页的网址,但是这对于一些无法提取下一页网址的情况很实用。

更新一下直接在网页提取下一页的方法,

# 换页方法二:提取下页链接

if not len(response.xpath("//a[@class='noactive' and @id='next']")):

url = 'http://hr.tencent.com/' + response.xpath("//a[@id='next']/@href").extract()[0]

yield scrapy.Request(url, callback=self.parse)

对于静态页面这很容易,但是如果是动态页面就可能需要其他的辅助手段了。另外settings中有有关请求头文件的设置部分,有需求的话可以改写之。

取消settings.py对于管线文件的注释,

修改pipelines.py文件,

import json class TencentPipeline(object):

def __init__(self):

self.f = open('tencent.json','w') def process_item(self, item, spider):

content = json.dumps(dict(item),ensure_ascii=False) + ',\n'

self.f.write(content)

return item def close_spider(self,spider):

self.f.close()

这样一个初级的爬虫项目就完成了。

测试并运行,

scrapy check tencent

scarpy srawl tencent

打开保存的json文件,可以看到类似下面的输出,每一行为一条招聘信息,

{"workLocation": "深圳", "positionType": "技术类", "positionName": "24111-安全架构师", "peopleNumber": "1", "publishtime": "2017-08-26", "positionLink": "position_detail.php?id=32378&keywords=&tid=0&lid=0"},完成后整个文件夹变化如下,

实际爬取过程是要消耗一点时间的。

『Scrapy』爬取腾讯招聘网站的更多相关文章

- 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息

简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 简单的scrapy实战:爬取腾讯招聘北京地区的相关招聘信息 系统环境:Fedora22(昨天已安装scrapy环境) 爬取的开始URL:ht ...

- 『Scrapy』爬取斗鱼主播头像

分析目标 爬取的是斗鱼主播头像,示范使用的URL似乎是个移动接口(下文有提到),理由是网页主页属于动态页面,爬取难度陡升,当然爬取斗鱼主播头像这么恶趣味的事也不是我的兴趣...... 目标URL如下, ...

- scrapy框架爬取智联招聘网站上深圳地区python岗位信息。

爬取字段,公司名称,职位名称,公司详情的链接,薪资待遇,要求的工作经验年限 1,items中定义爬取字段 import scrapy class ZhilianzhaopinItem(scrapy.I ...

- 使用Scrapy框架爬取腾讯新闻

昨晚没事写的爬取腾讯新闻代码,在此贴出,可以参考完善. # -*- coding: utf-8 -*- import json from scrapy import Spider from scrap ...

- python3 scrapy 爬取腾讯招聘

安装scrapy不再赘述, 在控制台中输入scrapy startproject tencent 创建爬虫项目名字为 tencent 接着cd tencent 用pycharm打开tencent项目 ...

- scrapy 第一个案例(爬取腾讯招聘职位信息)

import scrapy import json class TzcSpider(scrapy.Spider): # spider的名字,唯一 name = 'tzc' # 起始地址 start_u ...

- <scrapy爬虫>爬取腾讯社招信息

1.创建scrapy项目 dos窗口输入: scrapy startproject tencent cd tencent 2.编写item.py文件(相当于编写模板,需要爬取的数据在这里定义) # - ...

- Python 爬取腾讯招聘职位详情 2019/12/4有效

我爬取的是Python相关职位,先po上代码,(PS:本人小白,这是跟着B站教学视频学习后,老师留的作业,因为腾讯招聘的网站变动比较大,老师的代码已经无法运行,所以po上),一些想法和过程在后面. f ...

- 利用Crawlspider爬取腾讯招聘数据(全站,深度)

需求: 使用crawlSpider(全站)进行数据爬取 - 首页: 岗位名称,岗位类别 - 详情页:岗位职责 - 持久化存储 代码: 爬虫文件: from scrapy.linkextractors ...

随机推荐

- mp4v2 基本知识

mp4v2 和mp4的一些基础知识 由于项目需要做mp4文件的合成(264+aac)和mp4文件的解析: MP4文件本身就是一个容器,对于视频来说就是把不同的内容放按照mp4的规则存放而已: 如果完全 ...

- spring mybatis 3.2调用mysql存储过程返回多结果集(完整、亲测、可用)

最近,有个开发提了个需求,希望中间件支持调用mysql存储过程时支持多结果集返回,因为某些原因我们使用了不少的存储过程,很多复杂的逻辑目前来看交互非常的多,所以从当前的现状来说,这个需求还是蛮合理的. ...

- 利用构建缓存机制缩短Docker镜像构建时间

在使用Docker部署PHP或者node.js应用时,常用的方法是将代码和环境镜像打包成一个镜像然后运行,一些云厂商提供了非常便捷的操作,只需要把我们的代码提交到VCS上,然后它们就会帮我们拉取代码并 ...

- 自定义鼠标右键(层叠式菜单:cascading menu)(文件系统右键、文件夹系统右键和桌面鼠标右键)

转载:http://www.cnblogs.com/killerlegend/p/3575391.html 转载:http://www.cnblogs.com/shouce/p/5101001.htm ...

- 【LTE基础知识】SGLTE, SVLTE, CSFB, VoLTE【转】

本文转载自:https://blog.csdn.net/henryghx/article/details/18416405 4G网络下实现语音通话功能的技术共有三种——VoLTE.SGLTE(GSM ...

- python学习笔记比较全

注:本笔记基于python2.6而编辑,尽量的偏向3.x的语法 Python的特色 1.简单 2.易学 3.免费.开源 4.高层语言: 封装内存管理等 5.可移植性: 程序如果避免使用依赖于系统的特性 ...

- E: could not get lock /var/lib/dpkg/lock-frontend - open (11: Resource temporary unavailable) E: Unable to acquire the dpkg frontend lock (/var/lib/dpkg/lock-frontend), is an other process using it

1. 问题详细提示如下: E: Could not get lock /var/lib/dpkg/lock-frontend - open (11: Resource temporarly unava ...

- 【安装防火墙】没有iptables时的解决办法

一.检查iptables服务状态 首先检查iptables服务的状态 [root@woxplife ~]# service iptables status iptables: Firewall is ...

- 【第二十八章】 springboot + zipkin(brave定制-AsyncHttpClient)

brave本身没有对AsyncHttpClient提供类似于brave-okhttp的ClientRequestInterceptor和ClientResponseInterceptor,所以需要我们 ...

- spring boot 修改Tomcat端口

package com.tsou.Controller; import org.springframework.boot.*; import org.springframework.boot.auto ...