Hadoop原生搭建

版本:(centos7.6)

在开始搭建平台前我已经预装了MySQL

ps:MySQL创建用户并授权:

grant all privileges on *.* to 'root'@'localhost' identified by '' with grant option

好了,不多说,开始配置:

我采用了master,slave1,slave2三个节点,我自己是利用kvm化的虚拟机。

对应IP地址:

master:172.16.90.145

slave1:172.16.90.147

slave2:172.16.90.148

1、为了方便,加上自己在虚拟机上搭建,关闭Selinux,firewalld

2、更改hosts,即配置主机映射,更改完成scp拷贝

echo '172.16.90.145 master' >> /etc/hosts

echo '172.16.90.147 slave1' >> /etc/hosts

echo '172.16.90.148 slave2' >> /etc/hosts scp /etc/hosts slave1:/etc/hosts

scp /etc/hosts slave2:/etc/hosts

3、配置ssh免密:(这里为了方便我设置的空密码,并做的三方免密)

ssh-keygen ssh-copy-id master

ssh-copy-id slave1

ssh-copy-id slave2

4、安装jdk(即Java)

导入jdk后解压,创建软连接,加入环境变量,source环境变量文件,最后查看版本号

tar zxvf jdk-8u111-linux-x64.tar.gz ln -s /usr/local/jdk1..0_111 /usr/local/java echo 'export PATH=$PATH:$JAVA_HOME/bin' >> /etc/profile

echo 'JAVA_HOME=/usr/local/jdk1.8.0_111' >> /etc/profile source /etc/profile java -version

5、安装Hadoop:

解压

tar zxvf hadoop-2.9..tar.gz

创建软连接

ln -s /usr/local/hadoop-2.9./ /usr/local/hadoop

加入环境变量并使之生效

echo 'HADOOP_HOME=/usr/local/hadoop-2.9.0/' >> /etc/profile

echo 'export PATH=$PATH:$HADOOP_HOME/bin,sbin' >> /etc/profile

source /etc/profile

修改配置文件

在master主机上建立namenode本地数据目录

mkdir -p /data/nn

在slave1,slave2中建立datanode本地数据目录

mkdir -p /data/dn

在master中编辑core-site.xml,在 <configuration> 节点中增加如下内容

<property>

<name>fs.default.name</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value></value>

</property>

在master中编辑 hdfs-site.xml,在 <configuration> 节点中增加如下内容

<property>

<name>dfs.nameslave.name.dir</name>

<value>file:///data/nn</value>

</property>

<property>

<name>dfs.dataslave.data.dir</name>

<value>file:///data/dn</value>

</property>

<property>

<name>dfs.replication</name>

<value></value>

</property>

<property>

<name>dfs.nameslave.secondary.http-address</name>

<value>master:</value>

</property>

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</proper

在master中,将mapred-site.xml.template 复制一份 ,变成mapred-site.xml,编辑mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

<final>true</final>

</property>

<property>

<name>mapreduce.jobtracker.http.address</name>

<value>master:</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:</value>

</property>

<property>

<name>mapred.job.tracker</name>

<value>http://master:9001</value>

</property>

在master中,编辑yarn-site.xml,

<property>

<name>yarn.slavemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.slavemanager.auxservices.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>master:</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<name>yarn.slavemanager.resource.memory-mb</name>

<value></value>

</property>

将 master服务器上已经完成的 hadoop 配置 复制到各个节点对应位置上,输入以下命令进行 scp 传送:

scp -r /usr/local/hadoop/* slave1: /usr/local/hadoop/

scp -r /usr/local/hadoop/* slave2: /usr/local/hadoop/

在master中,初始化hadoop的namenode

启动hadoop

hadoop-daemon.sh namenode -format

./start-all.sh

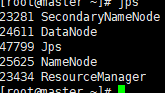

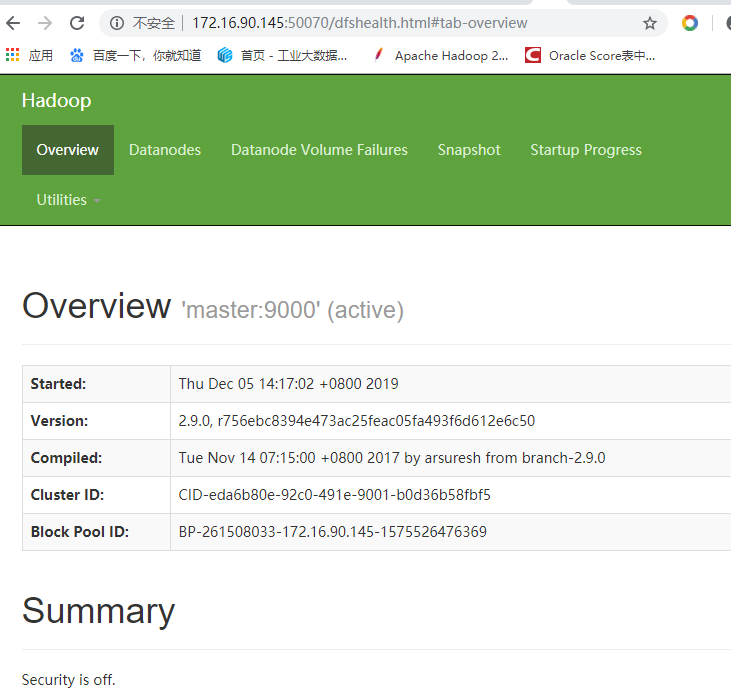

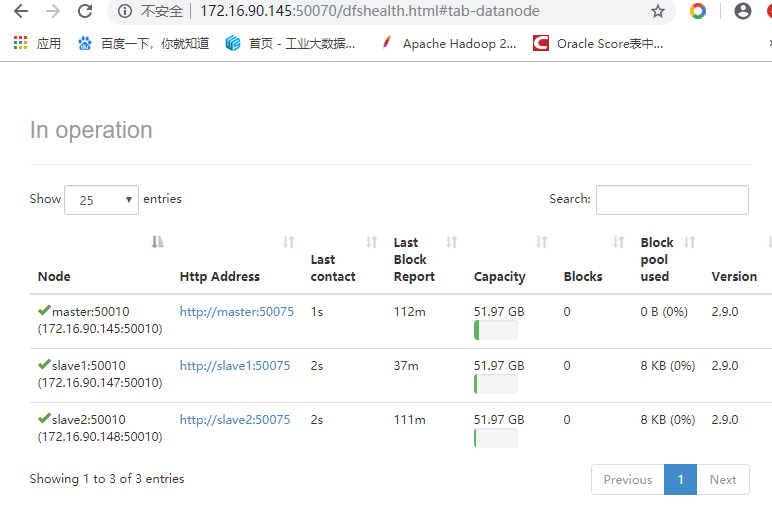

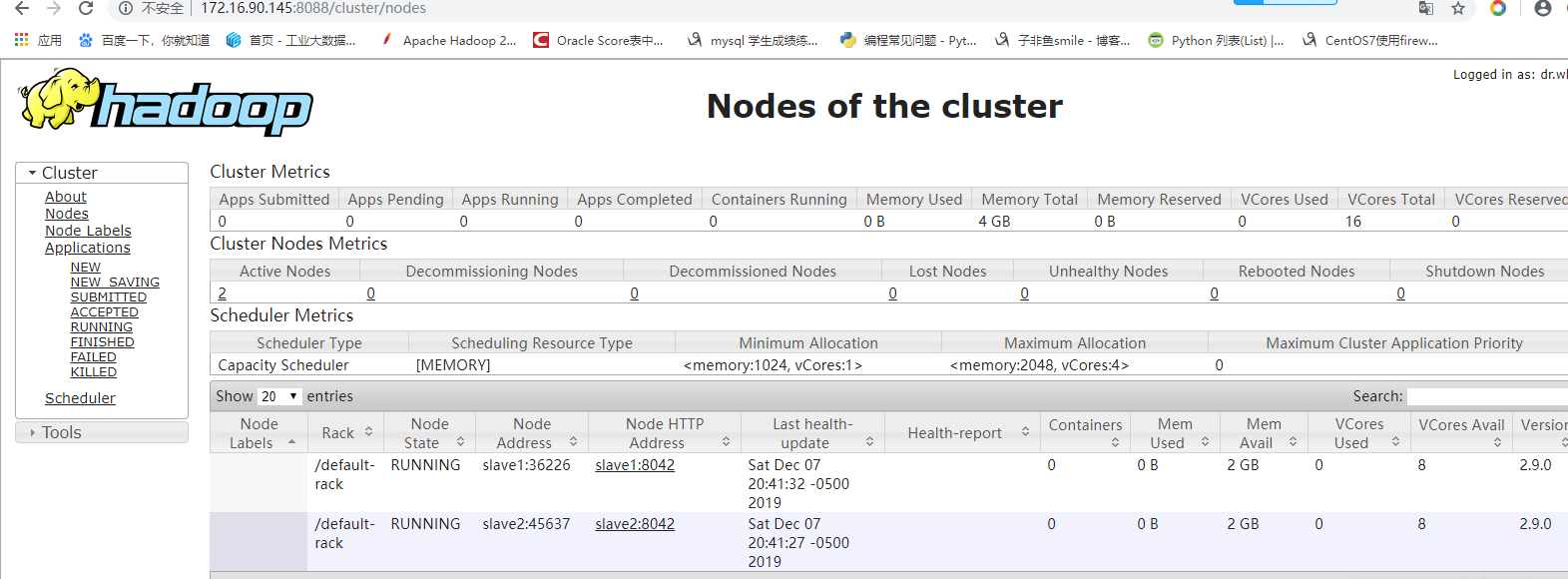

最后使用jps命令查看节点启动的服务是否正确

启动成功可以查看web界面了

Hadoop原生搭建的更多相关文章

- 【转】RHadoop实践系列之一:Hadoop环境搭建

RHadoop实践系列之一:Hadoop环境搭建 RHadoop实践系列文章,包含了R语言与Hadoop结合进行海量数据分析.Hadoop主要用来存储海量数据,R语言完成MapReduce 算法,用来 ...

- hadoop环境搭建之关于NAT模式静态IP的设置 ---VMware12+CentOs7

很久没有更新了,主要是没有时间,今天挤出时间验证了一下,果然还是有些问题的,不过已经解决了,就发上来吧. PS:小豆腐看仔细了哦~ 关于hadoop环境搭建,从单机模式,到伪分布式,再到完全分布式,我 ...

- 服务器Hadoop+Hive搭建

出于安全稳定考虑很多业务都需要服务器服务器Hadoop+Hive搭建,但经常有人问我,怎么去选择自己的配置最好,今天天气不错,我们一起来聊一下这个话题. Hadoop+Hive环境搭建 1虚拟机和系统 ...

- 通过hadoop + hive搭建离线式的分析系统之快速搭建一览

最近有个需求,需要整合所有店铺的数据做一个离线式分析系统,曾经都是按照店铺分库分表来给各自商家通过highchart多维度展示自家的店铺经营 数据,我们知道这是一个以店铺为维度的切分数据,非常适合目前 ...

- hadoop分布式搭建

1.新建三台机器,分别为: hadoop分布式搭建至少需要三台机器: master extension1 extension2 本文利用在VMware Workstation下安装Linux cent ...

- eclipse工具下hadoop环境搭建

eclipse工具下hadoop环境搭建: window10操作系统中搭建eclipse64开发系统,配置hadoop的eclipse插件,让eclipse可以查看Hdfs中的文件内容. ...

- 大数据学习之Hadoop环境搭建

一.Hadoop的优势 1)高可靠性:因为Hadoop假设计算元素和存储会出现故障,因为它维护多个工作数据副本,在出现故障时可以对失败的节点重新分布处理. 2)高扩展性:在集群间分配任务数据,可方便的 ...

- Hadoop环境搭建、启动和管理界面查看

一.hadoop环境搭建: 1. hadoop 6个核心配置文件的作用:core-site.xml:核心配置文件,主要定义了我们文件访问的格式 hdfs://hadoop-env.sh:主要配置我们的 ...

- Ubuntu中Hadoop环境搭建

Ubuntu中Hadoop环境搭建 JDK安装 方法一:通过命令行直接安装(不建议) 有两种java可以安装oracle-java8-installer以及openjdk (1)安装oracle-ja ...

随机推荐

- 【gradle使用前篇—Groovy简介】

Groovy介绍 Groovy是一种动态语言,对它的定义是:Groovy是在java平台上的,具有像Python.Ruby和smalltalk语言特性的灵活动态语言,Groovy保证了这些特性像jav ...

- Android 4.2 获取应用缓存接口变化

PackageManager.getPackageSizeInfo(String packageName, IPackageStatsObserver observer)不可用,改为PackageMa ...

- P2860()

题目描述: 为了从F(1≤F≤5000)个草场中的一个走到另一个,贝茜和她的同伴们有时不得不路过一些她们讨厌的可怕的树.奶牛们已经厌倦了被迫走某一条路,所以她们想建一些新路,使每一对草场之间都会至少有 ...

- tarjan学习(复习)笔记(持续更新)(各类找环模板)

题目背景 缩点+DP 题目描述 给定一个n个点m条边有向图,每个点有一个权值,求一条路径,使路径经过的点权值之和最大.你只需要求出这个权值和. 允许多次经过一条边或者一个点,但是,重复经过的点,权值只 ...

- JVM原理速记复习Java虚拟机总结思维导图面试必备

良心制作,右键另存为保存 喜欢可以点个赞哦 Java虚拟机 一.运行时数据区域 线程私有 程序计数器 记录正在执行的虚拟机字节码指令的地址(如果正在执行的是Native方法则为空),是唯一一个没有规定 ...

- 平滑启动shell脚本

# 平滑关闭和启动 Spring Boot 程序#设置端口SERVER_PORT="8090"#当前时间time=`date +%Y-%m-%d`#设置应用名称JAR_NAME=& ...

- 如何在 PHP 和 Laravel 中使用 Traits

事实上,PHP 作为一门编程语言存在的问题之一,就是你只能使用单继承.这意味着一个类只能从另一个类中继承.例如,可能希望从几个不同的类继承方法,以防止代码重复.在 PHP 5.4 中 一个新的语言特性 ...

- spark集群搭建(三台虚拟机)——spark集群搭建(5)

!!!该系列使用三台虚拟机搭建一个完整的spark集群,集群环境如下: virtualBox5.2.Ubuntu14.04.securecrt7.3.6_x64英文版(连接虚拟机) jdk1.7.0. ...

- C语言程序设计100例之(14):丑数

例14 丑数 问题描述 丑数是其质因子只可能是2,3或5的数.前10个丑数分别为1, 2, 3, 4, 5, 6, 8, 9, 10, 12.输入一个正整数n,求第n个丑数. 输入格式 每行为一个 ...

- CentOs虚拟机配置

1.打开“VMware”,点击“主页”,点“创建新的虚拟机”: 2.会弹出一个“新建虚拟机向导”,类型选择“典型”,点击“下一步”: 3.选择“稍后安装操作系统”,点击“下一步”: 4.我们用的是Li ...