requests+lxml+xpath爬取豆瓣电影

(1)lxml解析html

from lxml import etree

#创建一个html对象

html=stree.HTML(text)

result=etree.tostring(html,encoding="utf-8").decode("utf-8")

requests+lxml+xpath实现豆瓣电影爬虫

import requests

from lxml import etree

headers={

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/73.0.3683.86 Safari/537.36',

}

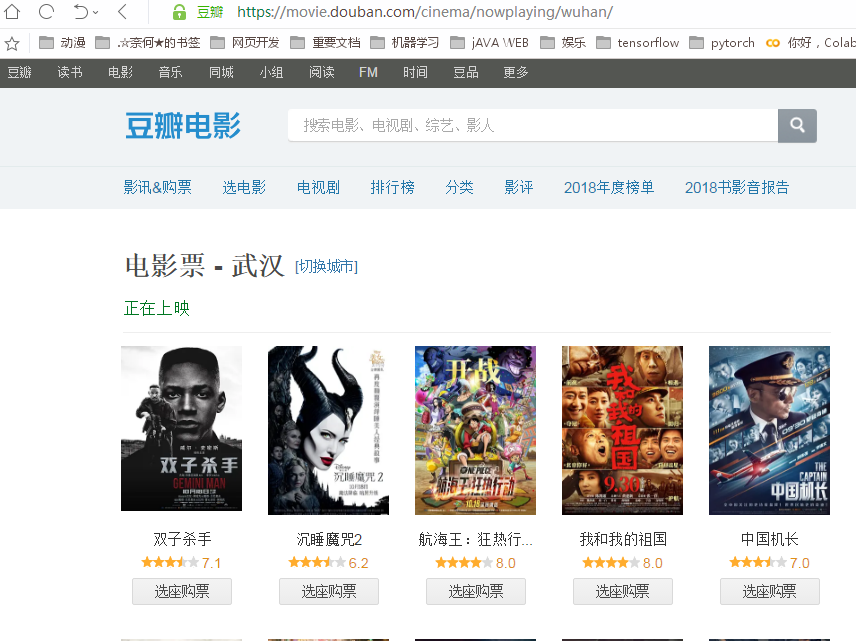

原始界面:

url="https://movie.douban.com/cinema/nowplaying/wuhan/"

response=request.get(url,headers=headers)

text=response.text

html=etree.HTML(text)

我们会得到一个html对象

转换成字符串看下结果

result=etree.tostring(html,encoding="utf-8").decode("utf-8")

部分结果如下:

然后进行xpath解析:

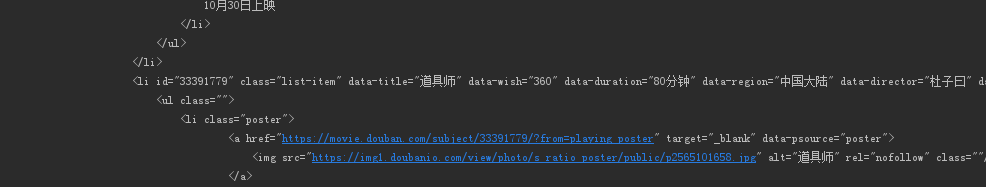

我们对准其中一部电影点击鼠标右键--检查,得到如下视图:

我们发现,上映电影的信息都在带有属性lists的ul中,我们可以对此进行xpath解析,(我们解析的是html对象,而不是转成字符串的结果):

uls=html.xpath("//ul[@class='lists']")[0]

我们在转成字符串查看一下结果:

res=etree.tostring(uls,encoding="utf-8").decode("utf-8")

print(res)

正是我们想要的,我们接着解析里面的内容:

首先获取所有的li:

#这句的意思是获取当前uls下的所有直接li

lis=uls.xpath("./li)

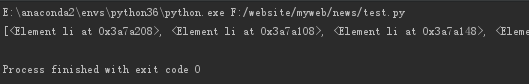

结果是一系列的li对象:

我们再分别进行解析:

movies=[]

for li in lis:

name=li.xpath("@data-title")[0]

score=li.xpath("@data-score")[0]

country=li.xpath("@data-region")[0]

director=li.xpath("@data-director")[0]

actors=li.xpath("@data-actors")[0]

category=li.xpath("@data-category")[0]

movie={

"name":name,

"score":score,

"country":country,

"director":director,

"actors":actors,

"category":category

}

movies.append(movie)

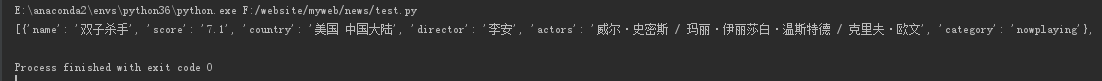

print(movies)

部分结果如下:

在json中格式化结果如下:

至此,一个初步的爬虫就完成了。

requests+lxml+xpath爬取豆瓣电影的更多相关文章

- 爬虫系列(十) 用requests和xpath爬取豆瓣电影

这篇文章我们将使用 requests 和 xpath 爬取豆瓣电影 Top250,下面先贴上最终的效果图: 1.网页分析 (1)分析 URL 规律 我们首先使用 Chrome 浏览器打开 豆瓣电影 T ...

- 爬虫系列(十一) 用requests和xpath爬取豆瓣电影评论

这篇文章,我们继续利用 requests 和 xpath 爬取豆瓣电影的短评,下面还是先贴上效果图: 1.网页分析 (1)翻页 我们还是使用 Chrome 浏览器打开豆瓣电影中某一部电影的评论进行分析 ...

- 爬虫系列1:Requests+Xpath 爬取豆瓣电影TOP

爬虫1:Requests+Xpath 爬取豆瓣电影TOP [抓取]:参考前文 爬虫系列1:https://www.cnblogs.com/yizhiamumu/p/9451093.html [分页]: ...

- requests+lxml+xpath爬取电影天堂

1.导入相应的包 import requests from lxml import etree 2.原始ur url="https://www.dytt8.net/html/gndy/dyz ...

- requests结合xpath爬取豆瓣最新上映电影

# -*- coding: utf-8 -*- """ 豆瓣最新上映电影爬取 # ul = etree.tostring(ul, encoding="utf-8 ...

- python3+requests+BeautifulSoup+mysql爬取豆瓣电影top250

基础页面:https://movie.douban.com/top250 代码: from time import sleep from requests import get from bs4 im ...

- Python爬虫爬取豆瓣电影之数据提取值xpath和lxml模块

工具:Python 3.6.5.PyCharm开发工具.Windows 10 操作系统.谷歌浏览器 目的:爬取豆瓣电影排行榜中电影的title.链接地址.图片.评价人数.评分等 网址:https:// ...

- 一起学爬虫——通过爬取豆瓣电影top250学习requests库的使用

学习一门技术最快的方式是做项目,在做项目的过程中对相关的技术查漏补缺. 本文通过爬取豆瓣top250电影学习python requests的使用. 1.准备工作 在pycharm中安装request库 ...

- Scrapy中用xpath/css爬取豆瓣电影Top250:解决403HTTP status code is not handled or not allowed

好吧,我又开始折腾豆瓣电影top250了,只是想试试各种方法,看看哪一种的方法效率是最好的,一直进行到这一步才知道 scrapy的强大,尤其是和selector结合之后,速度飞起.... 下面我就采用 ...

随机推荐

- css 添加手状样式,鼠标移上去变小手

cursor:pointer, 简单实用. 前端工作一年多,竟然没有博客.说出来别人都要笑话,这是一个新的开始.

- [Machine Learning] Linear regression

1. Variable definitions m : training examples' count \(y\) : \(X\) : design matrix. each row of \(X\ ...

- IDEA 学习笔记之 Java项目开发深入学习(2)

Java项目开发深入学习(2): 查找变量被用到的地方 编译当前文件 增加变量watch 注意:我使用了keymap (eclipse模板),所以很多快捷键和eclipse一样. F5单步调试进入函数 ...

- Laravel .env 多环境配置文件

项目开发中,通常会有本地开发环境.内网测试环境.线上真实环境.这三种环境的配置通常都不尽相同,Laravel 可以通过环境变量 APP_ENV 的值来加载不同的 .env 配置文件.下面会介绍两种方 ...

- Web Storage和cookie的区别——每日一题20190629

Web Storage? 使用HTML5可以在本地存储用户的浏览数据. 使用的主要目的是为了克服Cookie带来的一些限制,当数据需要被严格控制在客户端上时,无需持续的将数据发回服务器 主要目标: 1 ...

- Windows搭建SVN服务器

安装 1.下载地址:https://www.visualsvn.com/files/VisualSVN-Server-4.0.3-x64.msi 2.开始安装: 3.安装配置: 4.Next直到完成 ...

- Node.js入门教程 第五篇 (Express框架)

Express框架 Express是适用于Node.js web的框架,提供了大量实用功能,例如路由功能及http功能. Express 框架核心特性: 可以设置中间件来响应 HTTP 请求. 定义了 ...

- ASRWGAN: Wasserstein Generative Adversarial Network for Audio Super Resolution

ASEGAN:WGAN音频超分辨率 这篇文章并不具有权威性,因为没有发表,说不定是外国的某个大学的毕业设计,或者课程结束后的作业.或者实验报告. CS230: Deep Learning, Sprin ...

- Spring基础(二)

一.使用注解配置Spring 1.1步骤 --配置文件中,指明注解位置 --要用的地方打上注解 --改对象的作用范围(修改掉默认的单例,变多例) --属性的注入(两种) 使用的反射实现 set方法实现 ...

- java23种设计模式(二)抽象工厂模式

我们接着上一章的工厂方法模式继续学习一下抽象工厂模式. 抽象工厂模式:在工厂模式中,如果有多个产品,则就是抽象工厂模式. 例子: 有一个工厂开了两个子公司,专门用来生产电脑配件键盘和鼠标,一个是联想工 ...