解决flask中文乱码的问题

from flask import Flask,jsonify

app = Flask(__name__) #使用jsonify模块来让网页直接显示json数据

@app.route('/json')

def re_json():

#定义数据格式

json_dict={'id':10,'title':'flask的应用','content':'flask的json'}

#使用jsonify来讲定义好的数据转换成json格式,并且返回给前端

return jsonify(json_dict) if __name__ == "__main__":

app.run()

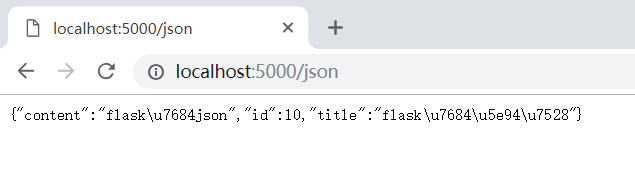

这是源代码不加任何配置

运行应是以上结果

有四种解决的途径:

一:直接加在代码中

from flask import Flask,jsonify

app = Flask(__name__)

#解决中文乱码的问题,将json数据内的中文正常显示

# app.config['JSON_AS_ASCII'] = False

#开启debug模式

# app.config['DEBUG'] = True #使用jsonify模块来让网页直接显示json数据

@app.route('/json')

def re_json():

#定义数据格式

json_dict={'id':10,'title':'flask的应用','content':'flask的json'}

#使用jsonify来讲定义好的数据转换成json格式,并且返回给前端

return jsonify(json_dict) if __name__ == "__main__":

app.run()

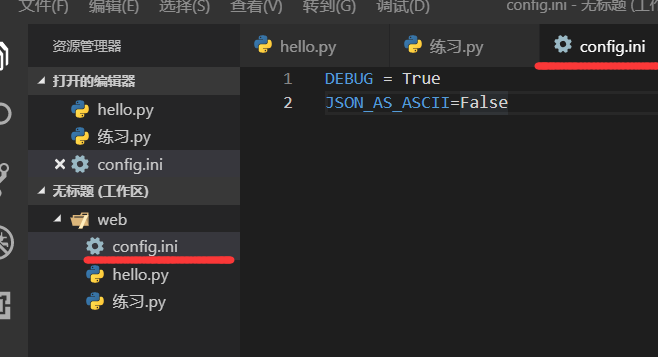

二:从配置文件里来加载配置

首先要添加文件

引入加载文件

from flask import Flask,jsonify

app = Flask(__name__)

#从配置文件里来加载配置

app.config.from_pyfile('config.ini')

#使用jsonify模块来让网页直接显示json数据

@app.route('/json')

def re_json():

#定义数据格式

json_dict={'id':10,'title':'flask的应用','content':'flask的json'}

#使用jsonify来讲定义好的数据转换成json格式,并且返回给前端

return jsonify(json_dict) if __name__ == "__main__":

app.run()

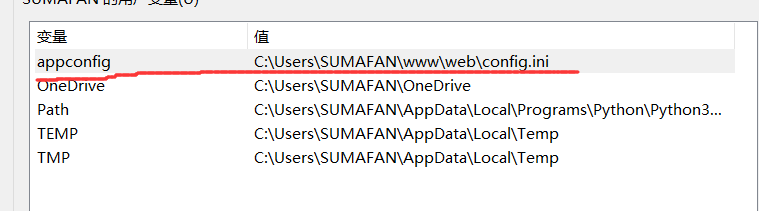

三:从环境变量来加载配置

首先要设置环境变量,找到文件路径配置

from flask import Flask,jsonify

app = Flask(__name__) #从环境变量中来加载配置

app.config.from_envvar('appconfig')

#使用jsonify模块来让网页直接显示json数据

@app.route('/json')

def re_json():

#定义数据格式

json_dict={'id':10,'title':'flask的应用','content':'flask的json'}

#使用jsonify来讲定义好的数据转换成json格式,并且返回给前端

return jsonify(json_dict) if __name__ == "__main__":

app.run()

四:从配置对象来加载配置

from flask import Flask,jsonify class Config(object):

DEBUG=True

JSON_AS_ASCII=False app = Flask(__name__) #从配置对象来加载配置

app.config.from_object(Config)

#使用jsonify模块来让网页直接显示json数据

@app.route('/json')

def re_json():

#定义数据格式

json_dict={'id':10,'title':'flask的应用','content':'flask的json'}

#使用jsonify来讲定义好的数据转换成json格式,并且返回给前端

return jsonify(json_dict) if __name__ == "__main__":

app.run()

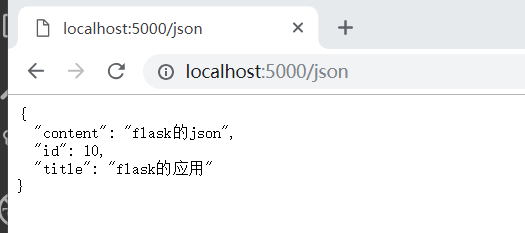

以上四种效果如下

解决flask中文乱码的问题的更多相关文章

- 解决Eclipse中文乱码 - 技术博客 - 51CTO技术博客 http://hsj69106.blog.51cto.com/1017401/595598/

解决Eclipse中文乱码 - 技术博客 - 51CTO技术博客 http://hsj69106.blog.51cto.com/1017401/595598/

- Ubuntu14.04安装中文输入法以及解决Gedit中文乱码问题

1 设置中文显示环境 1. 打开System Settings 2. 打开Personal-> Language Support. 会弹出如下对话框,提示你“语言支持没安装完整”. 点击“Rem ...

- Ubuntu14.04安装中文输入法以及解决Gedit中文乱码问题[转载]

转载自:http://www.cnblogs.com/zhcncn/p/4032321.html 写在前面:解决gedit 在txt文件格式出现乱码的问题,在我自己的操作中是需要把系统设置成中文显示环 ...

- 解决TortoiseCVS中文乱码

解决TortoiseCVS中文乱码必备,解决方法: 第一:卸载和TortoiseCVS安装一起安装的CVSNT. 第二:安装本版本CVSNT. CVSNT下载地址:http://down.51cto. ...

- 如何解决PHP中文乱码问题

如何解决PHP中文乱码问题 一.解决HTML中中文乱码问题方法 1.在head标签里面加入UTF8编码(国际化编码):UTF-8是没有国家的编码,也就是独立于任何一种语言,任何语言都可以使用的. ...

- springMvc解决json中文乱码

springMvc解决json中文乱码 springMvc解决json中文乱码,springMvc中文乱码,spring中文乱码 >>>>>>>>> ...

- 解决URL中文乱码问题--对中文进行加密、解密处理

解决URL中文乱码问题--对中文进行加密.解密处理 情景:在资源调度中,首先用户需要选择工作目标,然后跟据选择的工作目标不同而选择不同的账号和代理ip.处理过程如下:点击选择账号,在js中获取工作目标 ...

- request.getParameter()及解决数据库中文乱码问题——实习第七天

今天老师让我们自己做一个小项目,我开始着手于实现这个小项目.途中遇到过几个小问题,在此做个小记录, 相信后期还是会借鉴的. 1,从前台传入数据给后台传入数据,并没有传入成功: 输出的为Null. 当然 ...

- Hession集成Spring + maven依赖通讯comm项目 + 解决@ResponseBody中文乱码

hessian结合spring的demo hessian的maven依赖: <!-- hessian --> <dependency> < ...

随机推荐

- Ambari集成Kerberos报错汇总

Ambari集成Kerberos报错汇总 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.查看报错的配置信息步骤 1>.点击Test Kerberos Client,查看相 ...

- Linux下查看某个进程打开的文件数-losf工具常用参数介绍

Linux下查看某个进程打开的文件数-losf工具常用参数介绍 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 在linux操作系统中,一切皆文件.通过文件不仅仅可以访问常规数据,还 ...

- 删除mysql数据库中表分区数据

删除mysql数据库中表分区数据 zabbix 几个大表创建了分区,由于磁盘空间告警,特将3月前的分区给予删除. 1.查看表的数据占用磁盘空间情况 2.登录mysql中,查看表的分区情况. 3.删除表 ...

- Hadoop记录-HDFS balancer配置

HDFS balancer配置(可通过CM配置)dfs.datanode.balance.max.concurrent.moves 并行移动的block数量,默认5 dfs.datanode.bala ...

- Ubuntu 18.04 设置开机启动脚本 rc.local systemd

ubuntu18.04不再使用initd管理系统,改用systemd. ubuntu-18.04不能像ubuntu14一样通过编辑rc.local来设置开机启动脚本,通过下列简单设置后,可以使rc.l ...

- HDU - 3974 Assign the task (线段树区间修改+构建模型)

https://cn.vjudge.net/problem/HDU-3974 题意 有一棵树,给一个结点分配任务时,其子树的所有结点都能接受到此任务.有两个操作,C x表示查询x结点此时任务编号,T ...

- weblogic的基本概念

1.Domain,Administration Server, Managed Server 域包含一个或多个 WebLogic Server 实例. Domain 中包含一个特殊的 WebLogic ...

- Spark RDD基本概念与基本用法

1. 什么是RDD RDD(Resilient Distributed Dataset)叫做分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变.可分区.里面的元素可并行计算的集合.RDD具 ...

- 22.doublewrite/ChangeBuffer/AHI/FNP

一. Double Write1 Double Write介绍 • Double Write的目的是为了保证数据写入的可靠性, 避免partial write 的情况 ◦ partial write( ...

- ****** 四十二 ******、软设笔记【网络基础】-IPv6协议、常用的网络协议

一.IPv6协议 IPv6协议,全称"互联网协议第6版",即下一代的网际协议. 相对于IPv4来说,IPv6协议主要改进: *扩展的地址.IPv6地址长度为128位. *IPv6使 ...