Hadoop MapReduce编程 API入门系列之薪水统计(三十一)

不多说,直接上代码。

代码

package zhouls.bigdata.myMapReduce.SalaryCount;

import java.io.IOException;

import java.util.regex.Pattern;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.conf.Configured;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.Tool;

import org.apache.hadoop.util.ToolRunner;

/**

* 基于样本数据做Hadoop工程师薪资统计:计算各工作年限段的薪水范围

*/

public class SalaryCount extends Configured implements Tool

{

public static class SalaryMapper extends Mapper<LongWritable, Text, Text, Text>

{

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException

{

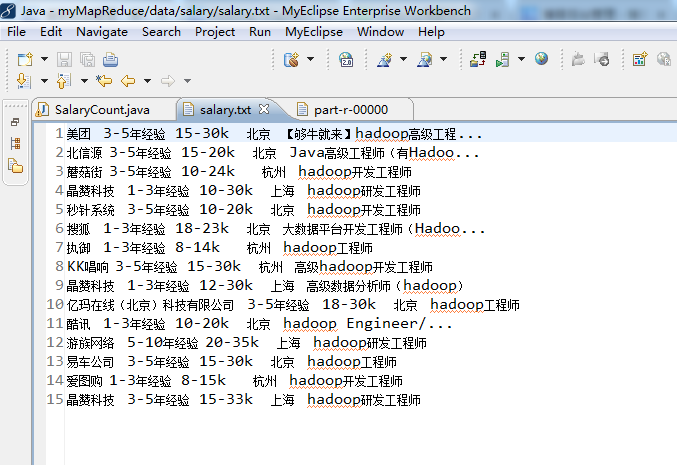

// 美团 3-5年经验 15-30k 北京 【够牛就来】hadoop高级工程...

//北信源 3-5年经验 15-20k 北京 Java高级工程师(有Hadoo...

// 蘑菇街 3-5年经验 10-24k 杭州 hadoop开发工程师

//第一步,将输入的纯文本文件的数据转化成String

String line = value.toString();//读取每行数据

String[] record = line.split( "\\s+");//使用空格正则解析数据

//key=record[1]:输出3-5年经验

//value=record[2]:15-30k

//作为Mapper输出,发给 Reduce 端

//第二步

if(record.length >= 3)//因为取得的薪资在第3列,所以要大于3

{

context.write( new Text(record[1]), new Text(record[2]) );

//Map输出,record数组的第2列,第3列

}

}

}

public static class SalaryReducer extends Reducer<Text, Text, Text, Text>

{

public void reduce(Text Key, Iterable<Text> Values, Context context) throws IOException, InterruptedException

{

int low = 0;//记录最低工资

int high = 0;//记录最高工资

int count = 1;

//针对同一个工作年限(key),循环薪资集合(values),并拆分value值,统计出最低工资low和最高工资high

for (Text value : Values)

{

String[] arr = value.toString().split("-");//其中的一行而已,15 30K

int l = filterSalary(arr[0]);//过滤数据 //15

int h = filterSalary(arr[1]);//过滤数据 //30

if(count==1 || l< low)

{

low = l;

}

if(count==1 || h>high)

{

high = h;

}

count++;

}

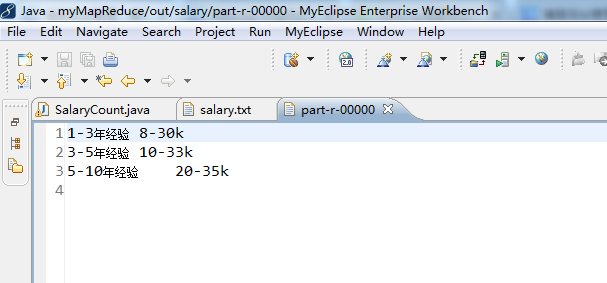

context.write(Key, new Text(low + "-" +high + "k"));//即10-30K

}

}

//正则表达式提取工资值,因为15 30k,后面有k,不干净

public static int filterSalary(String salary)//过滤数据

{

String sal = Pattern.compile("[^0-9]").matcher(salary).replaceAll("");

return Integer.parseInt(sal);

}

public int run(String[] args) throws Exception

{

//第一步:读取配置文件

Configuration conf = new Configuration();//读取配置文件

//第二步:输出路径存在就先删除

Path out = new Path(args[1]);//定义输出路径的Path对象,mypath

FileSystem hdfs = out.getFileSystem(conf);//通过路径下的getFileSystem来获得文件系统

if (hdfs.isDirectory(out))

{//删除已经存在的输出目录

hdfs.delete(out, true);

}

//第三步:构建job对象

Job job = new Job(conf, "SalaryCount" );//新建一个任务

job.setJarByClass(SalaryCount.class);//设置 主类

//通过job对象来设置主类SalaryCount.class

//第四步:指定数据的输入路径和输出路径

FileInputFormat.addInputPath(job, new Path(args[0]));// 文件输入路径

FileOutputFormat.setOutputPath(job, new Path(args[1]));// 文件输出路径

//第五步:指定Mapper和Reducer

job.setMapperClass(SalaryMapper.class);// Mapper

job.setReducerClass(SalaryReducer.class);// Reducer

//第六步:设置map函数和reducer函数的输出类型

job.setOutputKeyClass(Text.class);//输出结果key类型

job.setOutputValueClass(Text.class);//输出结果的value类型

//第七步:提交作业

job.waitForCompletion(true);//等待完成退出作业

return 0;

}

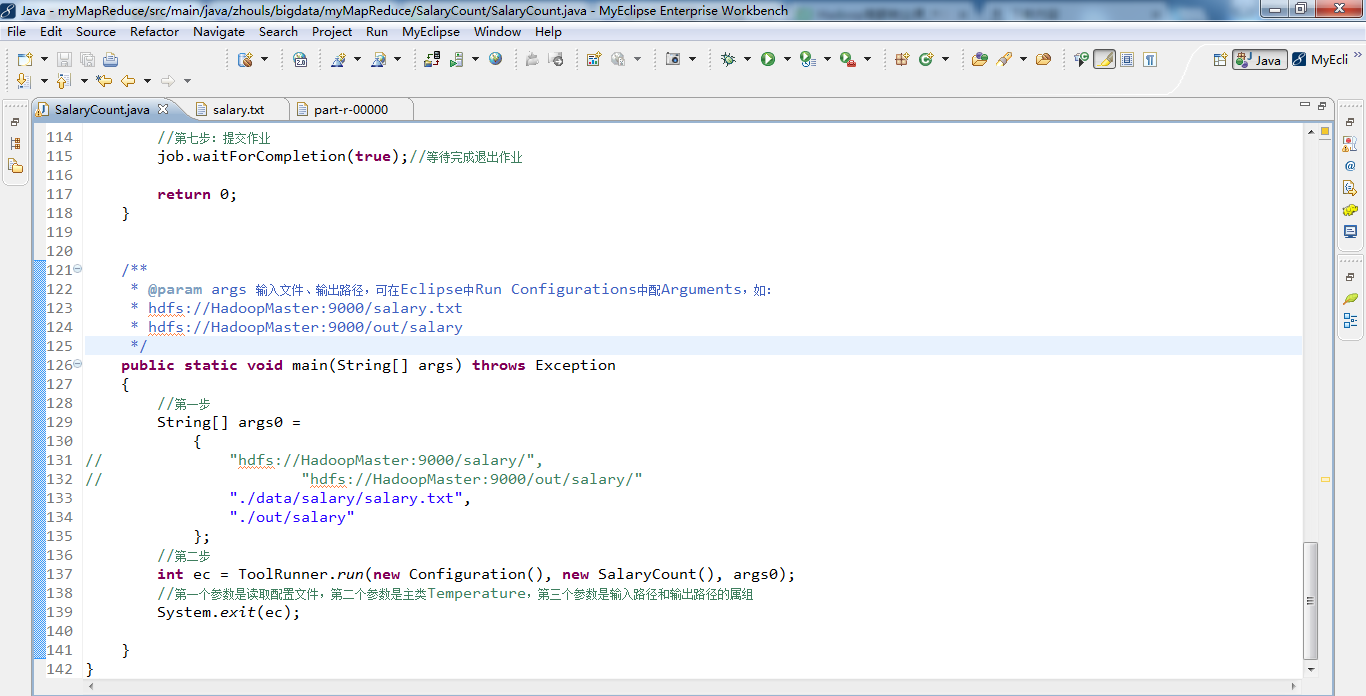

/**

* @param args 输入文件、输出路径,可在Eclipse中Run Configurations中配Arguments,如:

* hdfs://HadoopMaster:9000/salary.txt

* hdfs://HadoopMaster:9000/out/salary

*/

public static void main(String[] args) throws Exception

{

//第一步

String[] args0 =

{

// "hdfs://HadoopMaster:9000/salary/",

// "hdfs://HadoopMaster:9000/out/salary/"

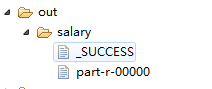

"./data/salary/salary.txt",

"./out/salary"

};

//第二步

int ec = ToolRunner.run(new Configuration(), new SalaryCount(), args0);

//第一个参数是读取配置文件,第二个参数是主类Temperature,第三个参数是输入路径和输出路径的属组

System.exit(ec);

}

}

Hadoop MapReduce编程 API入门系列之薪水统计(三十一)的更多相关文章

- Hadoop MapReduce编程 API入门系列之压缩和计数器(三十)

不多说,直接上代码. Hadoop MapReduce编程 API入门系列之小文件合并(二十九) 生成的结果,作为输入源. 代码 package zhouls.bigdata.myMapReduce. ...

- Hadoop MapReduce编程 API入门系列之挖掘气象数据版本3(九)

不多说,直接上干货! 下面,是版本1. Hadoop MapReduce编程 API入门系列之挖掘气象数据版本1(一) 下面是版本2. Hadoop MapReduce编程 API入门系列之挖掘气象数 ...

- Hadoop MapReduce编程 API入门系列之挖掘气象数据版本2(十)

下面,是版本1. Hadoop MapReduce编程 API入门系列之挖掘气象数据版本1(一) 这篇博文,包括了,实际生产开发非常重要的,单元测试和调试代码.这里不多赘述,直接送上代码. MRUni ...

- Hadoop MapReduce编程 API入门系列之join(二十六)(未完)

不多说,直接上代码. 天气记录数据库 Station ID Timestamp Temperature 气象站数据库 Station ID Station Name 气象站和天气记录合并之后的示意图如 ...

- Hadoop MapReduce编程 API入门系列之MapReduce多种输入格式(十七)

不多说,直接上代码. 代码 package zhouls.bigdata.myMapReduce.ScoreCount; import java.io.DataInput; import java.i ...

- Hadoop MapReduce编程 API入门系列之自定义多种输入格式数据类型和排序多种输出格式(十一)

推荐 MapReduce分析明星微博数据 http://git.oschina.net/ljc520313/codeexample/tree/master/bigdata/hadoop/mapredu ...

- Hadoop MapReduce编程 API入门系列之wordcount版本1(五)

这个很简单哈,编程的版本很多种. 代码版本1 package zhouls.bigdata.myMapReduce.wordcount5; import java.io.IOException; im ...

- Hadoop MapReduce编程 API入门系列之Crime数据分析(二十五)(未完)

不多说,直接上代码. 一共12列,我们只需提取有用的列:第二列(犯罪类型).第四列(一周的哪一天).第五列(具体时间)和第七列(犯罪场所). 思路分析 基于项目的需求,我们通过以下几步完成: 1.首先 ...

- Hadoop MapReduce编程 API入门系列之网页排序(二十八)

不多说,直接上代码. Map output bytes=247 Map output materialized bytes=275 Input split bytes=139 Combine inpu ...

随机推荐

- 关于PCA的几何表示——MATLAB实现

关于PCA的一道练习题.这个折腾了好久...终于做出来像样的图,开始的时候忘记对原始数据标准化,怎么也不对.经过标准化之后,做的图看着还可以,有错误请指出! MATLAB代码PCA.m: clear ...

- ios学习之UISwipeGestureRecognizer手势识别

ios学习之UISwipeGestureRecognizer手势识别 本文部分转自俺是一个瓜娃!!!的博客UISwipeGestureRecognizer ---手指动作,转载过来仅是为了自己查询 ...

- 从零开始学习Node.js例子三 图片上传和显示

index.js var server = require("./server"); var router = require("./router"); var ...

- mysql控制台操作

显示表结构 : show create table table_name 复制表:insert into table_name1 select * from table_name2

- 《JavaScript模式》第6章 代码复用模式

@by Ruth92(转载请注明出处) 第6章:代码复用模式 GoF 在其著作中提出的有关创建对象的建议原则: -- 优先使用对象组合,而不是类继承. 传统模式:使用类继承: 现代模式:"类 ...

- 最短JS判断是否为IE6(IE的写法)

常用的 JavaScript 检测浏览器为 IE 是哪个版本的代码,包括是否是最人极端厌恶的 ie6 识别与检测.代码如下: var isIE=!!window.ActiveXObject; var ...

- postfix启动脚本

使用该脚本是一定要注意postfix安装路径 #!/bin/bash # # postfix Postfix Mail Transger Agent # # chkconfig: # descript ...

- DHCP服务器安装及配置

一.什么是DHCP? DHCP (Dynamic Host Configuration protocol)动态主机设置协议,基于UDP(发送很小的数据报文,且对时效性要求较高)协议通信. 它是C/S架 ...

- POJ 3067 Japan(树状数组)

Japan Time Limit: 10 ...

- JS(去掉前后空格或去掉所有空格)的用法 推荐使用jquery 方法

说明: 如果使用jQuery直接使用$.trim(str)方法即可,str表示要去掉前后所有空格的字符串. 推荐 1. 去掉字符串前后所有空格: 代码如下: function Tri ...