自然语言20_The corpora with NLTK

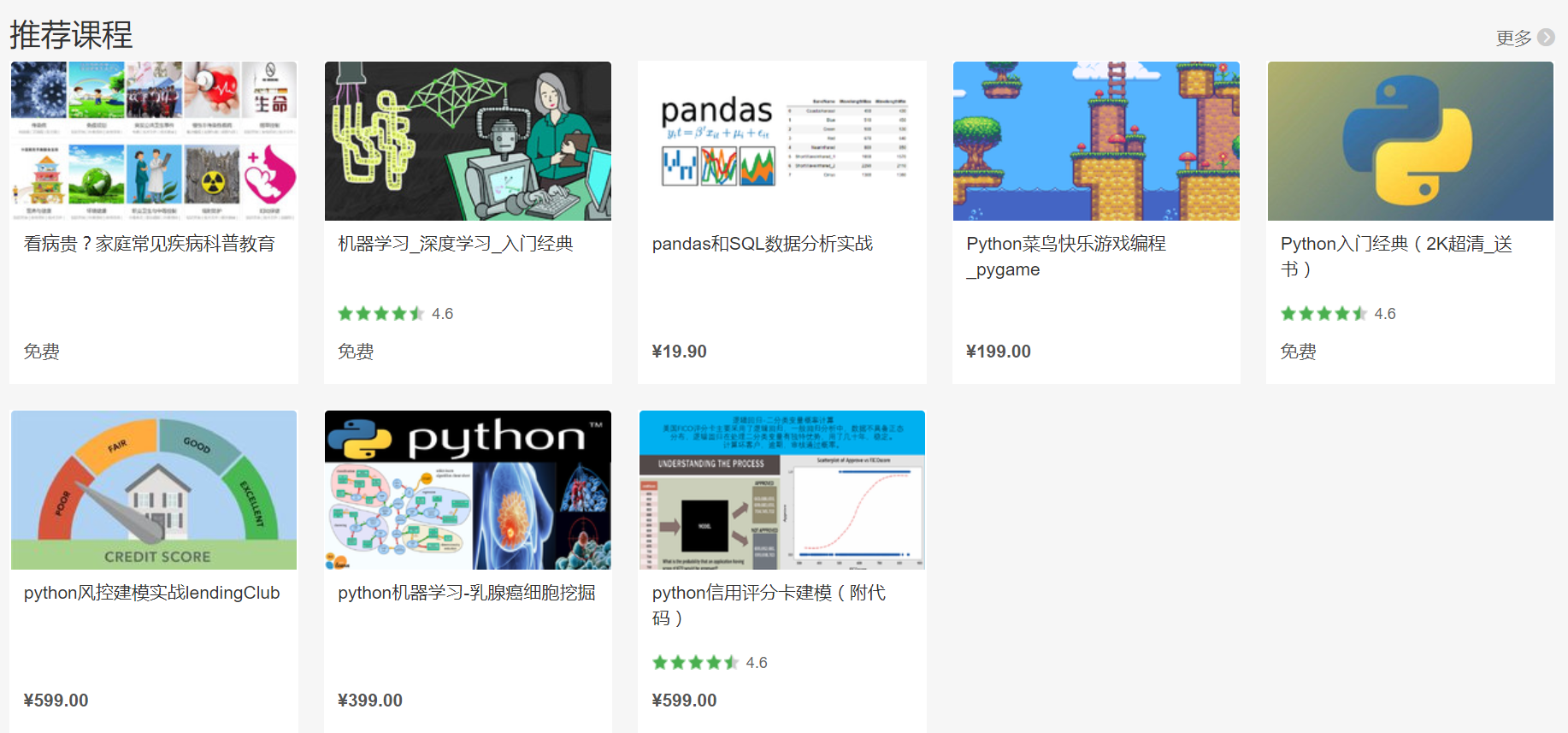

python机器学习-乳腺癌细胞挖掘(博主亲自录制视频)https://study.163.com/course/introduction.htm?courseId=1005269003&utm_campaign=commission&utm_source=cp-400000000398149&utm_medium=share

机器学习,统计项目合作QQ:231469242

The corpora with NLTK

寻找文件路径的代码

# -*- coding: utf-8 -*-

"""

Spyder Editor This is a temporary script file.

""" import nltk,sys,os

print(nltk.__file__) if sys.platform.startswith('win'):

# Common locations on Windows:

sys.path += [

str(r'C:\nltk_data'), str(r'D:\nltk_data'), str(r'E:\nltk_data'),

os.path.join(sys.prefix, str('nltk_data')),

os.path.join(sys.prefix, str('lib'), str('nltk_data')),

os.path.join(os.environ.get(str('APPDATA'), str('C:\\')), str('nltk_data'))

]

else:

# Common locations on UNIX & OS X:

sys.path += [

str('/usr/share/nltk_data'),

str('/usr/local/share/nltk_data'),

str('/usr/lib/nltk_data'),

str('/usr/local/lib/nltk_data')

]

nltk的corpus语料库是一个所有语言的数据集合。大多数语料库是TXT文本存储,少数为xml和其它格式,

In this part of the tutorial, I want us to take a moment to peak into the corpora we all downloaded! The NLTK corpus is a massive dump of all kinds of natural language data sets that are definitely worth taking a look at.

Almost all of the files in the NLTK corpus follow the same rules for accessing them by using the NLTK module, but nothing is magical about them. These files are plain text files for the most part, some are XML and some are other formats, but they are all accessible by you manually, or via the module and Python. Let's talk about viewing them manually.

Depending on your installation, your nltk_data directory might be hiding in a multitude of locations. To figure out where it is, head to your Python directory, where the NLTK module is. If you do not know where that is, use the following code:

import nltk

print(nltk.__file__)

Run that, and the output will be the location of the NLTK module's __init__.py. Head into the NLTK directory, and then look for the data.py file.

The important blurb of code is:

if sys.platform.startswith('win'):

# Common locations on Windows:

path += [

str(r'C:\nltk_data'), str(r'D:\nltk_data'), str(r'E:\nltk_data'),

os.path.join(sys.prefix, str('nltk_data')),

os.path.join(sys.prefix, str('lib'), str('nltk_data')),

os.path.join(os.environ.get(str('APPDATA'), str('C:\\')), str('nltk_data'))

]

else:

# Common locations on UNIX & OS X:

path += [

str('/usr/share/nltk_data'),

str('/usr/local/share/nltk_data'),

str('/usr/lib/nltk_data'),

str('/usr/local/lib/nltk_data')

]

There, you can see the various possible directories for the nltk_data. If you're on Windows, chances are it is in your appdata, in the local directory. To get there, you will want to open your file browser, go to the top, and type in %appdata%

Next click on roaming, and then find the nltk_data directory. In there, you will have your corpora file. The full path is something like:

corpora在windows的路径C:\Users\yourname\AppData\Roaming\nltk_data\corpora

语料库包括书籍,聊天记录,电影影评

Within here, you have all of the available corpora, including things like books, chat logs, movie reviews, and a whole lot more.

Now, we're going to talk about accessing these documents via NLTK.

As you can see, these are mostly text documents, so you could just use

normal Python code to open and read documents. That said, the NLTK

module has a few nice methods for handling the corpus, so you may find

it useful to use their methology. Here's an example of us opening the

Gutenberg Bible, and reading the first few lines:

古腾堡圣经(Gutenberg Bible),亦称四十二行圣经, 是《圣经》拉丁文公认翻译的印刷品,由翰尼斯·古腾堡于1454年到1455年在德国美因兹(Mainz)采用活字印刷术印刷的。这个圣经是最著名的古版书,他的产生标志着西方图书批量生产的开始

# -*- coding: utf-8 -*-

"""

Spyder Editor This is a temporary script file.

""" from nltk.tokenize import sent_tokenize

from nltk.corpus import gutenberg #sample text

sample=gutenberg.raw("bible-kjv.txt")

tok=sent_tokenize(sample)

for x in range(5):

print (tok[x])

Appdata是什么意思?

意思就是说包括系统程序运行时需要的文件,不建议删除!

Appdata下有三个子文件夹local,locallow,roaming,当你解压缩包时如果不指定路径,系统就把压缩包解到local\temp文件夹下,存放了一些解压文件,

安装软件时就从这里调取数据特别是一些制图软件,体积非常大,占用很多空间。locallow是用来存放共享数据,这两个文件夹下的文件就用优化大师清理,一般都可以清理无用的文件。

roaming文件夹也是存放一些使用程序后产生的数据文件,

如 空间听音乐,登入 的号码等而缓存的一些数据,这些数据优化大师是清理不掉的,

可以打开roaming文件夹里的文件全选定点击删除,删除不掉的就选择跳过,不过当你再使用程序时,这个文件夹又开始膨胀,又会缓存数据.

from nltk.tokenize import sent_tokenize, PunktSentenceTokenizer

from nltk.corpus import gutenberg # sample text

sample = gutenberg.raw("bible-kjv.txt") tok = sent_tokenize(sample) for x in range(5):

print(tok[x])

One of the more advanced data sets in here is "wordnet." Wordnet is a collection of words, definitions, examples of their use, synonyms, antonyms, and more. We'll dive into using wordnet next.

自然语言20_The corpora with NLTK的更多相关文章

- 自然语言处理(1)之NLTK与PYTHON

自然语言处理(1)之NLTK与PYTHON 题记: 由于现在的项目是搜索引擎,所以不由的对自然语言处理产生了好奇,再加上一直以来都想学Python,只是没有机会与时间.碰巧这几天在亚马逊上找书时发现了 ...

- 自然语言23_Text Classification with NLTK

QQ:231469242 欢迎喜欢nltk朋友交流 https://www.pythonprogramming.net/text-classification-nltk-tutorial/?compl ...

- 自然语言19.1_Lemmatizing with NLTK(单词变体还原)

QQ:231469242 欢迎喜欢nltk朋友交流 https://www.pythonprogramming.net/lemmatizing-nltk-tutorial/?completed=/na ...

- 自然语言14_Stemming words with NLTK

https://www.pythonprogramming.net/stemming-nltk-tutorial/?completed=/stop-words-nltk-tutorial/ # -*- ...

- 自然语言13_Stop words with NLTK

https://www.pythonprogramming.net/stop-words-nltk-tutorial/?completed=/tokenizing-words-sentences-nl ...

- 自然语言处理2.1——NLTK文本语料库

1.获取文本语料库 NLTK库中包含了大量的语料库,下面一一介绍几个: (1)古腾堡语料库:NLTK包含古腾堡项目电子文本档案的一小部分文本.该项目目前大约有36000本免费的电子图书. >&g ...

- python自然语言处理函数库nltk从入门到精通

1. 关于Python安装的补充 若在ubuntu系统中同时安装了Python2和python3,则输入python或python2命令打开python2.x版本的控制台:输入python3命令打开p ...

- Python自然语言处理实践: 在NLTK中使用斯坦福中文分词器

http://www.52nlp.cn/python%E8%87%AA%E7%84%B6%E8%AF%AD%E8%A8%80%E5%A4%84%E7%90%86%E5%AE%9E%E8%B7%B5-% ...

- 推荐《用Python进行自然语言处理》中文翻译-NLTK配套书

NLTK配套书<用Python进行自然语言处理>(Natural Language Processing with Python)已经出版好几年了,但是国内一直没有翻译的中文版,虽然读英文 ...

随机推荐

- linux基础-第十六单元 yum管理RPM包

第十六单元 yum管理RPM包 yum的功能 本地yum配置 光盘挂载和镜像挂载 本地yum配置 网络yum配置 网络yum配置 Yum命令的使用 使用yum安装软件 使用yum删除软件 安装组件 删 ...

- Swift基础--可选绑定和守护绑定

Swift中的可选绑定和守护绑定 1.可选绑定 格式 // 通过url来创建request对象 if let tempUrl = url { // url为可选类型,当可选类型有值,才执行大括号里面的 ...

- iOS开发小技巧--UIButton的另一种布局方法(第一种在layoutSubViews方法中,这一种利用苹果提供的两个返回CGRect的方法)

- 【Tyvj 1060】【NOIP 2005】等价表达式

设a为一个质数,模数为另一个质数,然后暴力算多项式的答案,如果答案相等就认为两个多项式相等. 这种hash有出错概率的题为什么还是要用hash呢?因为出错的概率实在太小了,a和模数的值取得好出题人根本 ...

- 如何在CentOS 5/6上安装EPEL源

EPEL 是什么? EPEL (Extra Packages for Enterprise Linux,企业版Linux的额外软件包) 是Fedora小组维护的一个软件仓库项目,为RHEL/CentO ...

- nutch-default.xml文件

Nutch中的所有配置文件都放置在总目录下的conf子文件夹中,最基本的配置文件是conf/nutch-default.xml.这个文件中定义了 Nutch的所有必要设置以及一些默认值,它是不可以被修 ...

- JS-slider.js实现鼠标拖动滑块控制取值特效

制作效果,如下图,鼠标点击颜色标能左右拖动并设置文本框中的值 源码: <div id="example"> <div id="slideContaine ...

- Web前端性能优化教程04:压缩组件

本文是Web前端性能优化系列文章中的第四篇,主要讲述内容:压缩组件.完整教程可查看:Web前端性能优化 基础知识 gzip编码:gzip是GUNzip的缩写,是使用无损压缩算法的一种,最早是用于Uni ...

- 扩展easyUI tab控件,添加加载遮罩效果

项目里要用HighChart显示图表,如果返回的数量量太多,生成图表是一个很耗时的过程.tab控件又没有显示遮罩的设置(至少本菜是没有找到), Google了一下,根据另一个兄台写的方法,拿来改造了一 ...

- Java Web项目中的经典代码抽取

前言: 众所周知的,项目开发中做得最多的无非就是增删查改(CRUD)操作.自从国内Web项目开发渐渐盛行SSH框架之后,其开发开发流程也变得更加灵活:本文就项目开发中的业务层代码作个简单的抽取,供业内 ...