scrapy爬取图片并自定义图片名字

1 前言

Scrapy使用ImagesPipeline类中函数get_media_requests下载到图片后,默认的图片命名为图片下载链接的哈希值,例如:它的下载链接是http://img.ivsky.com/img/bizhi/pre/201101/10/harry_potter5-017.jpg,哈希值为7710759a8e3444c8d28ba81a4421ed,那么最终的图片下载到指定路径后名称为7710759a8e3444c8d28ba81a4421ed.JPG。想要自定义图片名称则需要借助ImagesPipeline类中item_completed()函数来重命名。

2 爬虫过程

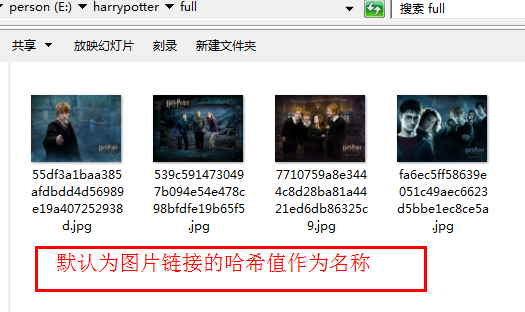

爬虫过程就不赘述了,链接请参看:https://www.cnblogs.com/mrtop/p/10180072.html,本文章重点介绍如何自定义图片名称。爬虫运行后获得的图片如下图:

3 自定义图片名称具体方法

3.1 自定义图片名称代码

import os

from harry.settings import IMAGES_STORE as IMGS

from scrapy.pipelines.images import ImagesPipeline

from scrapy import Request

class HarryPipeline(object):

def process_item(self, item, spider):

return item

class HarryDownLoadPipeline(ImagesPipeline):

def get_media_requests(self, item, info):

for imgurl in item['img_url']:

yield Request(imgurl)

def item_completed(self, results, item, info):

print ('******the results is********:',results)

os.rename(IMGS + '/' + results[0][1]['path'], IMGS + '/' + item['img_name'])

def __del__(self):

#完成后删除full目录

os.removedirs(IMGS + '/' + 'full')

注:对于def __del__(self)函数可要可不要,因为重命名过程是携带路径重命名,所以默认生成的full文件夹就为空,只是顺手删除空文件夹(如果里面有文件存在是删除不了的)

3.2 自定义图片名称代码详细解析

3.2.1 get_media_requests函数

get_media_requests方法的原型为:

def item_completed(self, results, item, info):

if isinstance(item, dict) or self.images_result_field in item.fields:

item[self.images_result_field] = [x for ok, x in results if ok]

return item

可以看到get_media_requests有三个参数,

第一个是self,这个不必多说;

第二个是 item,这个就是 spiders传递过来的 item

第三个是 info,看名字就知道这是用来保存信息的,至于是什么信息,info其实是一个用来保存保存图片的名字和下载链接的列表

3.2.2 Item_completed函数

item_completed方法的原型如下:

def item_completed(self, results, item, info):

if isinstance(item, dict) or self.images_result_field in item.fields:

item[self.images_result_field] = [x for ok, x in results if ok]

return item

注意到 item_completed里有个 results参数,results参数保存了图片下载的相关信息,将他print看看具体信息:

[(True, {'url': 'http://img.ivsky.com/img/bizhi/pre/201101/10/harry_potter5-015.jpg', 'path': 'full/539c5914730497b094e5c98bfdfe19b65f5.jpg', 'checksum': '37d23ffb0ab983ac2da9a9d'})]

真实结构为一个list [(DownLoad_success_or_failure),dict],字典中含有三个键:1、'url':图片路径 2、'path':图片下载后的保存路径 3、'checksum':校验码

从中我们可以看到只要我们修改字典中图片保存路径(路径详细到图片名称)的值,那么我们就能自定义图片名称。

关键代码为:

os.rename(IMGS + '/' + results[0][1]['path'], IMGS + '/' + item['img_name'])

解释:rename函数,results[0][1]['path']意思就是:在result这个list中找到图片的名称,其中我们也可以看到这个图片的位置是绝对路径,所以需要携带路径IMGS修改。

4 更新pipelines.py后运行结果

如有疑问,欢迎留言讨论交流,转载请注明出处。

scrapy爬取图片并自定义图片名字的更多相关文章

- python网络爬虫之使用scrapy爬取图片

在前面的章节中都介绍了scrapy如何爬取网页数据,今天介绍下如何爬取图片. 下载图片需要用到ImagesPipeline这个类,首先介绍下工作流程: 1 首先需要在一个爬虫中,获取到图片的url并存 ...

- 使用Scrapy爬取图片入库,并保存在本地

使用Scrapy爬取图片入库,并保存在本地 上 篇博客已经简单的介绍了爬取数据流程,现在让我们继续学习scrapy 目标: 爬取爱卡汽车标题,价格以及图片存入数据库,并存图到本地 好了不多说,让我们实 ...

- scrapy 爬取图片

scrapy 爬取图片 1.scrapy 有下载图片的自带接口,不用我们在去实现 setting.py设置 # 保存log信息的文件名 LOG_LEVEL = "INFO" # L ...

- 用scrapy爬取搜狗Lofter图片

用scrapy爬取搜狗Lofter图片 # -*- coding: utf-8 -*- import json import scrapy from scrapy.http import Reques ...

- 使用scrapy框架爬取图片网全站图片(二十多万张),并打包成exe可执行文件

目标网站:https://www.mn52.com/ 本文代码已上传至git和百度网盘,链接分享在文末 网站概览 目标,使用scrapy框架抓取全部图片并分类保存到本地. 1.创建scrapy项目 s ...

- python实现scrapy爬取图片到本地时的sha1摘要算法文件名

2017-03-29 Scrapy爬图片到本地应该会给图片自动生成sha1摘要算法文件名,我第一次用scrapy也不清楚太多,就在程序里自己写了一段实现这一功能的代码.需import hashlib ...

- scrapy框架爬取图片并将图片保存到本地

如果基于scrapy进行图片数据的爬取 在爬虫文件中只需要解析提取出图片地址,然后将地址提交给管道 配置文件中:IMAGES_STORE = './imgsLib' 在管道文件中进行管道类的制定: f ...

- Scrapy 爬取某网站图片

1. 创建一个 Scrapy 项目,在命令行或者 Pycharm 的 Terminal 中输入: scrapy startproject imagepix 自动生成了下列文件: 2. 在 imagep ...

- 【Python】- scrapy 爬取图片保存到本地、且返回保存路径

https://blog.csdn.net/xueba8/article/details/81843534

随机推荐

- python 面向对象(一)--类(class)和实例(Instance)

面向对象最重要的概念就是类(Class)和实例(Instance),必须牢记类是抽象的模板,比如Student类,而实例是根据类创建出来的一个个具体的“对象”,每个对象都拥有相同的方法,但各自的数据可 ...

- Mac安装protobuf 流程

下载 https://github.com/google/protobuf/releases 找到对应版本下载 编译 cd protobuf./autogen.sh./configuremake 安装 ...

- Network in Network 笔记

传统CNN里的卷积核是一个generalized linear model(GLM)之后经过一个sigmoid(现在通常是ReLu)的非线性激励函数,假设卷积有K个filter,那么这K个filter ...

- c/c++基础

如果有你认为重要的知识点,而我这却没有记录下来的,那么期待你分享给我(^U^)ノ~YO. 1.在结构体中,符号->的前面是指针变量,符号.的前面是普通变量. 程序中a->b等价于(*a ...

- Spring整合JUnit spring静态对象属性的注入

package cn.itcast.d_junit4; import org.junit.Test; import org.junit.runner.RunWith; import org.sprin ...

- this以及执行上下文概念的重新认识

在理解this的绑定过程之前,必须要先明白调用位置,调用位置指的是函数在代码中被调用的位置,而不是声明所在的位置. (ES6的箭头函数不在该范围内,它的this在声明时已经绑定了,而不是取决于调用时. ...

- 利用Selenium+java实现淘宝自动结算购物车商品(附源代码)

转载请声明原文地址! 本次的主题是利用selenium+java实现结算购买购物车中的商品. 话不多说,本次首先要注意的是谷歌浏览器的版本,浏览器使用的驱动版本,selenium的jar包版本. ...

- Linux下使用指定网卡进行ping操作

目录 1. 为什么要使用知道那个网卡ping操作 2. 使用指定网卡ping操作 3. 总结 1. 为什么要使用指定网卡ping操作 现在很多服务器都拥有双网卡甚至多网卡,有些是为了保持高 ...

- tar工具(打包,压缩)

tar工具(打包,压缩)========================= tar打包工具 -c:表示建立一个tar包或者压缩文件包-x:表示解包或者解压缩-v:表示可视化-f: 后面跟文件名(即-f ...

- git--分布式版本管理系统

参考博客:廖雪峰的官方网站 一.window安装git Git官网直接下载安装程序,默认选项安装即可. 1.设置自己的git(cmd命令或者git bash进入) git config --globa ...