学习Python 能找到工作?1300+条招聘信息告诉你答案

对于python这块有任何不懂的问题可以随时来问我,我对于学习方法,系统学习规划,还有学习效率这些知道一些,希望可以帮助大家少走弯路。当然也会送给大家一份系统性的python资料,文末附有爬虫项目实战-爬取你心仪的职位的实战项目源码练习

随着移动互联网的发展以及机器学习等热门领域带给人们的冲击,让越来越多的人知道并开始学习 Python。无论你是是科班出身还是非科班转行,Python 无疑都是非常适合你入门计算机世界的第一语言,其语法非常简洁,写出的程序易懂,这也是 Python 一贯的哲学「简单优雅」,在保证代码可读的基础上,用尽可能少的代码完成你的想法。

那么,我们学习 Python 到什么程度,就可以开始找工作了呢,大家都知道,实践是检验这里的唯一标准,那么学到什么程度可以找工作,当然得看市场的需求,毕竟企业招你来是工作的,而不是让你来带薪学习的。

所以,今天我们就试着爬取下拉钩上关于 Python 的招聘信息,来看看市场到底需要什么样的人才。

一、网页结构分析

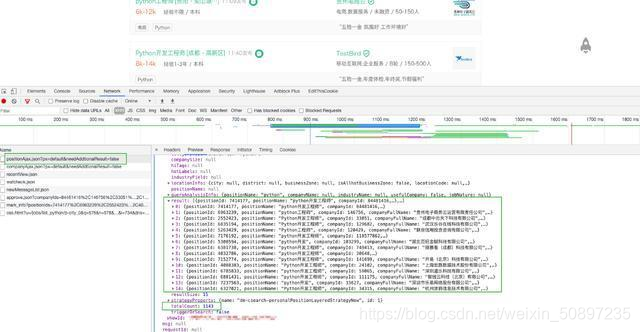

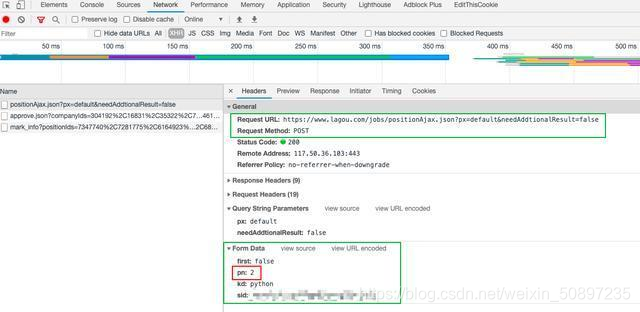

打开拉勾网首页,输入关键字「Python」,接着按 F12 打开网页调试面板,切换到「Network」选项卡下,过滤条件选上「XHR」,一切准备就绪之后点击搜索,仔细观察网页的网络请求数据。

从这些请求中我们可以大致猜测到数据好像是从 jobs/positionAjax.json这个接口获取的。

别急,我们来验证下,清空网络请求记录,翻页试试。当点击第二页的时候,请求记录如下。

可以看出,这些数据是通过 POST 请求获取的,Form Data 中的 pn 就是当前页码了。好了,网页分析好了,接下来就可以写爬虫拉取数据了。你的爬虫代码看起来可能会是这样的。

url = ‘https://www.lagou.com/jobs/positionAjax.json?px=new&needAddtionalResult=false’

headers = “”"

accept: application/json, text/javascript, /; q=0.01

origin: https://www.lagou.com

referer: https://www.lagou.com/jobs/list_python?px=new&city=%E5%85%A8%E5%9B%BD

user-agent: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/83.0.4103.116 Safari/537.36

“”"

headers_dict = headers_to_dict(headers)

def get_data_from_cloud(page):

params = {

‘first’: ‘false’,

‘pn’: page,

‘kd’: ‘python’

}

response = requests.post(url, data=params, headers=headers_dict, timeout=3)

result = response.text

write_file(result)

for i in range(76):

get_data_from_cloud(i + 1)

程序写好之后,激动的心,颤抖的手,满怀期待的你按下了 run 按钮。美滋滋的等着接收数据呢,然而你得到的结果数据很大可能是这样的。

{“success”:true,“msg”:null,“code”:0,“content”:{“showId”:“8302f64”,“hrInfoMap”:{“6851017”:{“userId”:621208…

{“status”:false,“msg”:“您操作太频繁,请稍后再访问”,“clientIp”:“xxx.yyy.zzz.aaa”,“state”:2402}

…

不要怀疑,我得到的结果就是这样的。这是因为拉勾网做了反爬虫机制,对应的解决方案就是不要频繁的爬,每次获取到数据之后适当停顿下,比如每两个请求之间休眠 3 秒,然后请求数据时再加上 cookie 信息。完善之后的爬虫程序如下:

home_url = ‘https://www.lagou.com/jobs/list_python?px=new&city=%E5%85%A8%E5%9B%BD’

url = ‘https://www.lagou.com/jobs/positionAjax.json?px=new&needAddtionalResult=false’

headers = “”"

accept: application/json, text/javascript, /; q=0.01

origin: https://www.lagou.com

referer: https://www.lagou.com/jobs/list_python?px=new&city=%E5%85%A8%E5%9B%BD

user-agent: Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/83.0.4103.116 Safari/537.36

“”"

headers_dict = string_util.headers_to_dict(headers)

def get_data_from_cloud(page):

params = {

‘first’: ‘false’,

‘pn’: page,

‘kd’: ‘python’

}

s = requests.Session() # 创建一个session对象

s.get(home_url, headers=headers_dict, timeout=3) # 用 session 对象发出 get 请求,获取 cookie

cookie = s.cookies

response = requests.post(url, data=params, headers=headers_dict, cookies=cookie, timeout=3)

result = response.text

write_file(result)

def get_data():

for i in range(76):

page = i + 1

get_data_from_cloud(page)

time.sleep(5)

不出意外,这下可以就可以获得全部数据了,总共 1131 条。

二、数据清洗

上文我们将获取到的 json 数据存储到了 data.txt 文件中,这不方便我们后续的数据分析操作。我们准备用 pandas 对数据做分析,所以需要做一下数据格式化。

处理过程不难,只是有点繁琐。具体过程如下:

def get_data_from_file():

with open(‘data.txt’) as f:

data = []

for line in f.readlines():

result = json.loads(line)

result_list = result[‘content’][‘positionResult’][‘result’]

for item in result_list:

dict = {

‘city’: item[‘city’],

‘industryField’: item[‘industryField’],

‘education’: item[‘education’],

‘workYear’: item[‘workYear’],

‘salary’: item[‘salary’],

‘firstType’: item[‘firstType’],

‘secondType’: item[‘secondType’],

‘thirdType’: item[‘thirdType’],

# list

‘skillLables’: ‘,’.join(item[‘skillLables’]),

‘companyLabelList’: ‘,’.join(item[‘companyLabelList’])

}

data.append(dict)

return data

data = get_data_from_file()

data = pd.DataFrame(data)

data.head(15)

三、数据分析

获取数据和清洗数据只是我们的手段,而不是目的,我们最终的目的是要通过获取到的招聘数据挖掘出招聘方的需求,以此为目标来不断完善自己的技能图谱。

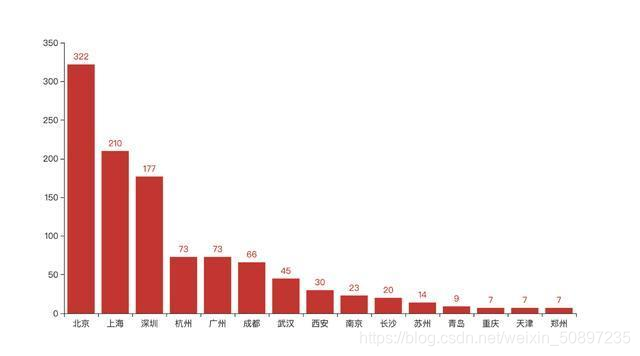

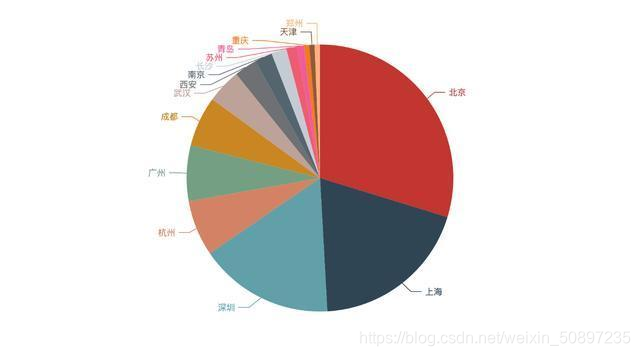

城市

先来看看哪些城市的招聘需求最大。这里我们只取 Top15 的城市数据。

top = 15

citys_value_counts = data[‘city’].value_counts()

citys = list(citys_value_counts.head(top).index)

city_counts = list(citys_value_counts.head(top))

bar = (

Bar()

.add_xaxis(citys)

.add_yaxis("", city_counts)

)

bar.render_notebook()

pie = (

Pie()

.add("", [list(z) for z in zip(citys, city_counts)])

.set_global_opts(title_opts=opts.TitleOpts(title=""))

.set_global_opts(legend_opts=opts.LegendOpts(is_show=False))

)

pie.render_notebook()

由上图可以看出,北京基本占据了四分之一还多的招聘量,其次是上海,深圳,杭州,单单从需求量来说,四个一线城市中广州被杭州所代替。

这也就从侧面说明了我们为啥要去一线城市发展了。

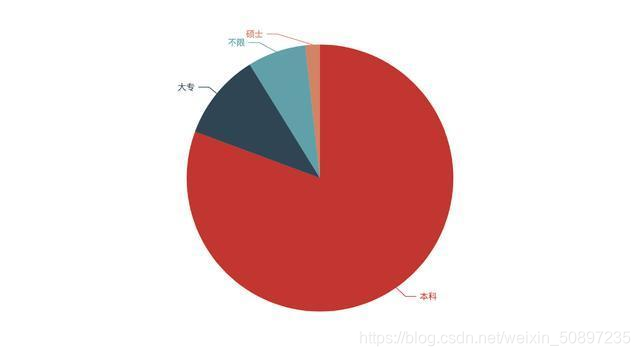

学历

eduction_value_counts = data[‘education’].value_counts()

eduction = list(eduction_value_counts.index)

eduction_counts = list(eduction_value_counts)

pie = (

Pie()

.add("", [list(z) for z in zip(eduction, eduction_counts)])

.set_global_opts(title_opts=opts.TitleOpts(title=""))

.set_global_opts(legend_opts=opts.LegendOpts(is_show=False))

)

pie.render_notebook()

看来大多公司的要求都是至少要本科毕业的,不得不说,当今社会本科基本上已经成为找工作的最低要求了(能力特别强的除外)。

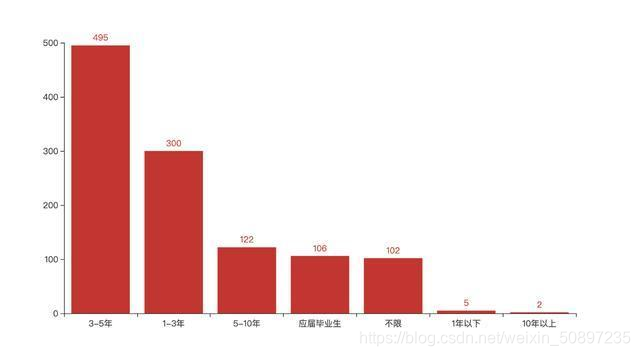

工作年限

work_year_value_counts = data[‘workYear’].value_counts()

work_year = list(work_year_value_counts.index)

work_year_counts = list(work_year_value_counts)

bar = (

Bar()

.add_xaxis(work_year)

.add_yaxis("", work_year_counts)

)

bar.render_notebook()

3-5年的中级工程师需求最多,其次是 1-3 年的初级工程师。

其实这也是符合市场规律的,这是因为高级工程师换工作频率远远低于初中级,且一个公司对高级工程师的需求量是远远低于初中级工程师的。

但是发现1年以下的招的非常少,所以很多自学的同学都说入行难!

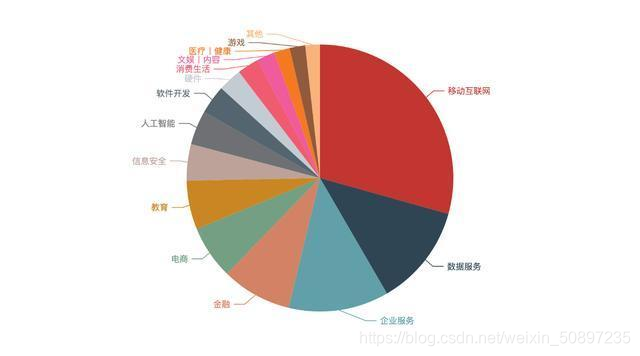

行业

我们再来看看这些招聘方都属于哪些行业。因为行业数据不是非常规整,所以需要单独对每一条记录按照 , 作下切割。

industrys = list(data[‘industryField’])

industry_list = [i for item in industrys for i in item.split(’,’) ]

industry_series = pd.Series(data=industry_list)

industry_value_counts = industry_series.value_counts()

industrys = list(industry_value_counts.head(top).index)

industry_counts = list(industry_value_counts.head(top))

pie = (

Pie()

.add("", [list(z) for z in zip(industrys, industry_counts)])

.set_global_opts(title_opts=opts.TitleOpts(title=""))

.set_global_opts(legend_opts=opts.LegendOpts(is_show=False))

)

pie.render_notebook()

移动互联网行业占据了四分之一还多的需求量,这跟我们的认识的大环境是相符合的。

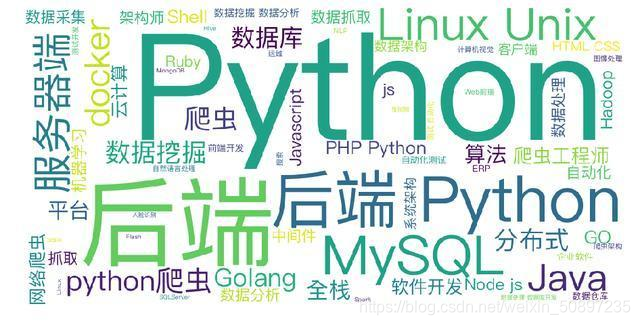

技能要求

来看看招聘方所需的技能要求词云。

word_data = data[‘skillLables’].str.split(’,’).apply(pd.Series)

word_data = word_data.replace(np.nan, ‘’)

text = word_data.to_string(header=False, index=False)

wc = WordCloud(font_path=’/System/Library/Fonts/PingFang.ttc’, background_color=“white”, scale=2.5,

contour_color=“lightblue”, ).generate(text)

wordcloud = WordCloud(background_color=‘white’, scale=1.5).generate(text)

plt.figure(figsize=(16, 9))

plt.imshow(wc)

plt.axis(‘off’)

plt.show()

除去 Python,出现最多的是后端、MySQL、爬虫、全栈、算法等。

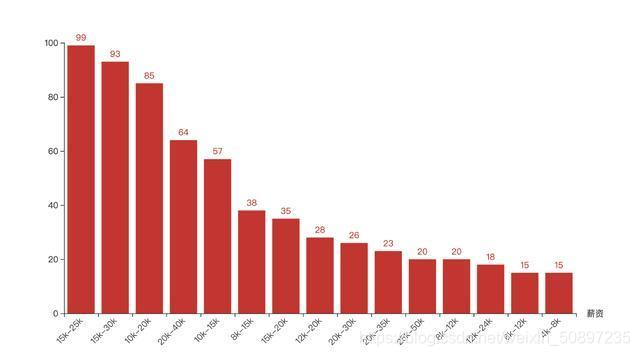

薪资

接下来我们看看各大公司给出的薪资条件。

salary_value_counts = data[‘salary’].value_counts()

top = 15

salary = list(salary_value_counts.head(top).index)

salary_counts = list(salary_value_counts.head(top))

bar = (

Bar()

.add_xaxis(salary)

.add_yaxis("", salary_counts)

.set_global_opts(xaxis_opts=opts.AxisOpts(name_rotate=0,name=“薪资”,axislabel_opts={“rotate”:45}))

)

bar.render_notebook()

大部分公司给出的薪资还是很可观的,基本都在 20K-35K 之间,只要你技术过关,很难找不到满意薪酬的工作。

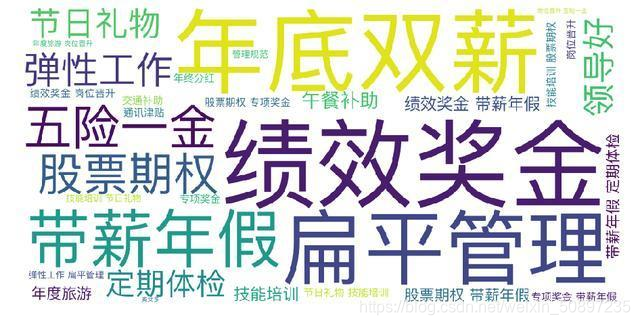

福利

最后咱来看看公司给出的额外福利都有哪些。

word_data = data[‘companyLabelList’].str.split(’,’).apply(pd.Series)

word_data = word_data.replace(np.nan, ‘’)

text = word_data.to_string(header=False, index=False)

wc = WordCloud(font_path=’/System/Library/Fonts/PingFang.ttc’, background_color=“white”, scale=2.5,

contour_color=“lightblue”, ).generate(text)

plt.figure(figsize=(16, 9))

plt.imshow(wc)

plt.axis(‘off’)

plt.show()

年底双薪、绩效奖金、扁平化管理。都是大家所熟知的福利,其中扁平化管理是互联网公司的特色。不像国企或者其他实体企业,上下级观念比较重。

四、总结

今天我们抓取了拉勾网 1300+ 条关于 Python 的招聘数据,对这批数据分析之后我们得出如下结论:

关于学历你最好是本科毕业,市场对 1-5 年工作经验的工程师需求量比较大,需求量最大的城市是北上深杭,需求量最多的行业仍然是移动互联网,而且大多数公司都会给到不错的薪酬待遇。

对于那些自学想入门的同学:建议不仅仅只学Python,还需要学习算法、数据库等相关知识,任何语言都是一样的,只要你坚持学习,总会有机会入行!

你现在走的路,也许是你人生中最困难的一段路!

需要系统性的python的资料,或者爬虫项目实战-爬取你心仪的职位,这部分实战源码及教学视频的可以私信我,或者加我扣群867067945

本文的文字及图片来源于网络加上自己的想法,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理。

学习Python 能找到工作?1300+条招聘信息告诉你答案的更多相关文章

- 自学 Python 到什么程度能找到工作,1300+ 条招聘信息告诉你答案

随着移动互联网的发展以及机器学习等热门领域带给人们的冲击,让越来越多的人接触并开始学习 Python.无论你是是科班出身还是非科班转行,Python 无疑都是非常适合你入门计算机世界的第一门语言,其语 ...

- 分四个阶段学习python并找到一份好工作

第一阶段 关注公众号"轻松学编程"了解更多. 详细学习资料 需要时间一个月. 1.python概念 python是一种解释型.面向对象.动态数据类型的高级程序语言. 理解: ...

- 大专生自学Python到找到工作的心得

先做个自我介绍,我13年考上一所很烂专科民办的学校,学的是生物专业,具体的学校名称我就不说出来献丑了.13年我就辍学了,我在那样的学校,一年学费要1万多,但是根本没有人学习,我实在看不到希望,我就退学 ...

- 自学python到找到工作的心得

先做个自我介绍,我13年考上一所很烂专科民办的学校,学的是生物专业,具体的学校名称我就不说出来献丑了.13年我就辍学了,我在那样的学校,一年学费要1万多,但是根本没有人学习,我实在看不到希望,我就退学 ...

- Python爬取十四万条书籍信息告诉你哪本网络小说更好看

前言 本文的文字及图片来源于网络,仅供学习.交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理. 作者: TM0831 PS:如有需要Python学习资料的小伙伴可以加点击 ...

- 【Python3爬虫】网络小说更好看?十四万条书籍信息告诉你

一.前言简述 因为最近微信读书出了网页版,加上自己也在闲暇的时候看了两本书,不禁好奇什么样的书更受欢迎,哪位作者又更受读者喜欢呢?话不多说,爬一下就能有个了解了. 二.页面分析 首先打开微信读书:ht ...

- python爬虫爬取腾讯招聘信息 (静态爬虫)

环境: windows7,python3.4 代码:(亲测可正常执行) import requests from bs4 import BeautifulSoup from math import c ...

- python之scrapy爬取jingdong招聘信息到mysql数据库

1.创建工程 scrapy startproject jd 2.创建项目 scrapy genspider jingdong 3.安装pymysql pip install pymysql 4.set ...

- 零基础2018如何系统地学习python?

首先告诉你的是,零基础学习开始系统学习Python肯定难,Python的专业程度本身就不简单,学习这事本来就是一件非常煎熬的事情,人都不愿意学习,可是没办法,为了生存掌握一个技能,你必须学,如果你认真 ...

随机推荐

- Spark Pipeline官方文档

ML Pipelines(译文) 官方文档链接:https://spark.apache.org/docs/latest/ml-pipeline.html 概述 在这一部分,我们将要介绍ML Pipe ...

- Kubernetes中的Helm和修改证书有效时间(八)

一.Helm的介绍 1,概念 Helm 把 k8s 资源(比如 deployments.services 或 ingress 等)打包到一个 chart 中,而 chart 被保存到 chart 仓库 ...

- SpringBoot-02-原理初探之主启动类

2. 原理初探 2.1 pom.xml 父依赖 主要依赖一个父项目,主要管理项目的资源过滤和插件 <parent> <groupId>org.springframework.b ...

- Django中间件之SessionMiddleware源码分析

settings.py文件中 MIDDLEWARE = [ 'django.contrib.sessions.middleware.SessionMiddleware', ] # from djang ...

- JVM参数总结

官方文档 堆参数: -Xms: 堆的初始值,例如 -Xmx2048,初始堆大小为 2G -Xmx: 堆的最大值,例如 -Xmx2048M,允许最大堆内存 2G -Xmn: 新生代大小 -XX:Surv ...

- Python记录日志模块推荐-loguru!

作者:小张学Python 本文链接: https://mp.weixin.qq.com/s/dkNkEohPl6H2VopUrpxxZg 转载请注明来源!! 前言 在做项目的时候一直在用Pytho ...

- selenium-自动化测试51job网站(MacOS + Safari)2020年10月6日

登录 51job ,http://www.51job.com 输入搜索关键词 "python", 地区选择 "杭州"(注意,如果所在地已经选中其他地区,要去掉) ...

- C++ | 继承(基类,父类,超类),(派生类,子类)

转载:https://blog.csdn.net/Sherlock_Homles/article/details/82927515 文章参考:https://blog.csdn.net/war1111 ...

- 实时,异步网页使用jTable, SignalR和ASP。NET MVC

下载source code - 984.21 KB 图:不同客户端的实时同步表. 点击这里观看现场演示. 文章概述 介绍使用的工具演示实现 模型视图控制器 遗言和感谢参考历史 介绍 HTTP(即web ...

- PJzhang:鸟哥的linux私房菜-shell脚本-上

猫宁~~~ 建议全程在centos7中进行,我在kali linux中有些命令无法执行. 1~家目录下创建bin文件,test.sh文件在bin目录 下面的shell代码打印Hello World! ...