Python爬虫系统化学习(2)

Python爬虫系统学习(2)

动态网页爬取

当网页使用Javascript时候,很多内容不会出现在HTML源代码中,所以爬取静态页面的技术可能无法使用。因此我们需要用动态网页抓取的两种技术:通过浏览器审查元素解析网页的真实地址和使用Selenium模拟浏览器的方法。

异步更新技术AJAX(Asynchronous Javascript And XML,异步Javascript 和XML):通过后台与服务器进行少量的数据交互实现异步更新。

Selenium模块

百度解释:Selenium [1] 是一个用于Web应用程序测试的工具。Selenium测试直接运行在浏览器中,就像真正的用户在操作一样。支持的浏览器包括IE(7, 8, 9, 10, 11),Mozilla Firefox,Safari,Google Chrome,Opera,Edge等。

通俗来说就是Selenium可以模拟浏览器去执行一些操作,虽然操作会慢,但是可以用来爬取动态页面,相较于request有更大的优点。

request与selenium访问页面的比较(防止混淆)

#request访问

#!/usr/bin/python

#coding:utf-8

link="http://www.bilibili.com"

r=requestss.get(link)

print(r.text) #selenium访问

#!/usr/bin/python

#coding:utf-8

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

driver=webdriver.Firefox(executable_path=r'D:\geckodriver.exe')

#这里的geckodriver.exe是驱动程序,最新版的selenium不添加是不会执行的

link="http://www.bilibili.com"

dirver.get(link)

可以看到除了使用的库不一样,selenium还需要额外使用驱动程序,下载地址如下:

下载地址:https://github.com/mozilla/geckodriver/releases

Selenium的有点在于,它可以根据元素进行具体的选择,整理如下:

| 方法 | 作用 | 样例 |

|---|---|---|

| find_element_by_css_selector | 通过class选择 | 比如<div class='bdy-as'>test<div>可以用driver.find_element_by_css_seletor('div.bdy-as') |

| find_element_by_xpath | 通过xpath选择 | 比如<form id="loginForm">可以用driver.find_element_by_xpath("//form[@id='loginForm']") |

| find_element_by_id | 通过id进行选择 | 比如<div id="bdy-as">textL</div>可以使用driver.find_element_by_id('bdy-as') |

| find_element_by_name | 通过元素name选择 | 比如<input name="username" type="text"/> driver.find_element_by_name('username') |

| find_element_by_tag_name | 通过元素的名字进行选择 | 比睿<h1>haha</h1>可使用driver.find_element_by_tag_name('h1') |

selenium高级操作:

根据selenium可以对抓取内容进行限制,使用的是FirefoxProfile()这个函数去创建句柄

from selenium import webdriver

fp = webdriver.FirefoxProfile()

#禁止层叠样式表CSS

fp.set_preference("permissions.default.stylesheet",2)

#禁止图片加载

fp.set_preference("permissions.default.image",2)

#禁止JS的运行

fp.set_preference("javascript.enabled",false)

使用三种限制方法可以加速对网页的访问

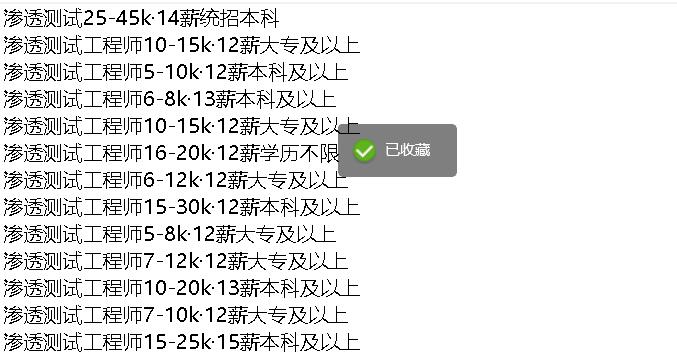

Selenium实战:爬取猎聘网渗透测试相关信息

由于猎聘网有反爬以及我选择的class存在缺憾,爬取到的只有岗位和薪资,欠缺了公司和地址,但是通过多次被反爬我大概有了反反爬虫的思路。

将爬取猎聘网的代码列下,仅供参考:

#coding:utf-8

import requests

import time

from selenium import webdriver

from selenium.webdriver.common.keys import Keys

driver=webdriver.Firefox(executable_path=r'D:\geckodriver.exe')

link="https://www.liepin.com/zhaopin/?sfrom=click-pc_homepage-centre_searchbox-search_new&d_sfrom=search_fp&key=%E6%B8%97%E9%80%8F%E6%B5%8B%E8%AF%95"

driver.get(link)

#找到文本框,输入渗透测试,输入回车

job_list=driver.find_elements_by_css_selector('div.job-info')

for each in job_list:

name=each.find_element_by_tag_name('h3').text

money=each.find_element_by_css_selector('span.text-warning').text

edu=each.find_element_by_css_selector('span.edu').text

ALL=name+money+edu+'\n'

with open ('a.txt',"a+") as f:

f.write(ALL)

爬取后文件夹下生成a.txt,内容如下:

Python爬虫系统化学习(2)的更多相关文章

- Python爬虫系统化学习(4)

Python爬虫系统化学习(4) 在之前的学习过程中,我们学习了如何爬取页面,对页面进行解析并且提取我们需要的数据. 在通过解析得到我们想要的数据后,最重要的步骤就是保存数据. 一般的数据存储方式有两 ...

- Python爬虫系统化学习(5)

Python爬虫系统化学习(5) 多线程爬虫,在之前的网络编程中,我学习过多线程socket进行单服务器对多客户端的连接,通过使用多线程编程,可以大大提升爬虫的效率. Python多线程爬虫主要由三部 ...

- Python爬虫系统化学习(3)

一般来说当我们爬取网页的整个源代码后,是需要对网页进行解析的. 正常的解析方法有三种 ①:正则匹配解析 ②:BeatuifulSoup解析 ③:lxml解析 正则匹配解析: 在之前的学习中,我们学习过 ...

- Python爬虫系统学习(1)

Python爬虫系统化学习(1) 前言:爬虫的学习对生活中很多事情都很有帮助,比如买房的时候爬取房价,爬取影评之类的,学习爬虫也是在提升对Python的掌握,所以我准备用2-3周的晚上时间,提升自己对 ...

- 一个Python爬虫工程师学习养成记

大数据的时代,网络爬虫已经成为了获取数据的一个重要手段. 但要学习好爬虫并没有那么简单.首先知识点和方向实在是太多了,它关系到了计算机网络.编程基础.前端开发.后端开发.App 开发与逆向.网络安全. ...

- python爬虫专栏学习

知乎的一个讲python的专栏,其中爬虫的几篇文章,偏入门解释,快速看了一遍. 入门 爬虫基本原理:用最简单的代码抓取最基础的网页,展现爬虫的最基本思想,让读者知道爬虫其实是一件非常简单的事情. 爬虫 ...

- Python爬虫的学习经历

在准备学习人工智能之前呢,我看了一下大体的学习纲领.发现排在前面的是PYTHON的基础知识和爬虫相关的知识,再者就是相关的数学算法与金融分析.不过想来也是,如果想进行大量的数据运算与分析,宏大的基础数 ...

- python爬虫scrapy学习之篇二

继上篇<python之urllib2简单解析HTML页面>之后学习使用Python比较有名的爬虫scrapy.网上搜到两篇相应的文档,一篇是较早版本的中文文档Scrapy 0.24 文档, ...

- 【Python爬虫案例学习】下载某图片网站的所有图集

前言 其实很简短就是利用爬虫的第三方库Requests与BeautifulSoup. 其实就几行代码,但希望没有开发基础的人也能一下子看明白,所以大神请绕行. 基本环境配置 python 版本:2.7 ...

随机推荐

- 简述vue-cli 2.x和vue-cli 3+在项目构建、运行、编译执行时的区别

码文不易啊,转载请带上本文链接呀,感谢感谢 https://www.cnblogs.com/echoyya/p/14363272.html 关于VUE的项目,有个问题一直不是特别清楚 ,不同公司的项目 ...

- 组合数取模及Lucas定理

引入: 组合数C(m,n)表示在m个不同的元素中取出n个元素(不要求有序),产生的方案数.定义式:C(m,n)=m!/(n!*(m-n)!)(并不会使用LaTex QAQ). 根据题目中对组合数的需要 ...

- bzoj1500: [NOI2005]维修数列 (Splay+变态题)

Time Limit: 10 Sec Memory Limit: 64 MBSubmit: 11353 Solved: 3553 [Submit][Status][Discuss] Descrip ...

- C. New Year Book Reading

New Year is coming, and Jaehyun decided to read many books during 2015, unlike this year. He has n b ...

- 2019牛客暑期多校训练营(第六场)J Upgrading Technology

传送门 题意: 就是给你n个技能,每个技能最高升到m级,每升一级就是耗费Cij钱,这个Cij可能是负的,如果所有技能都升到或者说超过j等级,就会获得Dj钱,这个Dj也有可能是负值,让你求你最多得到多少 ...

- Gym 100796K Profact

Alice is bored out of her mind by her math classes. She craves for something much more exciting. Tha ...

- java——接口、多态性、对象转型

接口定义: 默认方法: 默认方法的作用: 如果在你的接口已经投入使用了,这个时候你想要在接口里面加一个方法,这个时候如果你加一个抽象方法的话,所有实现类都要改变源代码(因为实现类要把接口中的所有抽象 ...

- Gym 2009-2010 ACM ICPC Southwestern European Regional Programming Contest (SWERC 2009) A. Trick or Treat (三分)

题意:在二维坐标轴上给你一堆点,在x轴上找一个点,使得该点到其他点的最大距离最小. 题解:随便找几个点画个图,不难发现,答案具有凹凸性,有极小值,所以我们直接三分来找即可. 代码: int n; lo ...

- 要想用活Redis,Lua脚本是绕不过去的坎

前言 Redis 当中提供了许多重要的高级特性,比如发布与订阅,Lua 脚本等.Redis 当中也提供了自增的原子命令,但是假如我们需要同时执行好几个命令的同时又想让这些命令保持原子性,该怎么办呢?这 ...

- CF1478-A. Nezzar and Colorful Balls

CF1478-A. Nezzar and Colorful Balls 题意: 有\(n\)个球,每个球上面都有一个数字\(a_i\),这些数字是组成的序列是非递减的.现在你要给每个球涂色,你必须保证 ...