scrapy框架抓取表情包/(python爬虫学习)

抓取网址:https://www.doutula.com/photo/list/?page=1

1.创建爬虫项目:scrapy startproject biaoqingbaoSpider

2.创建爬虫文件:scrapy genspider biaoqingbao doutula.com

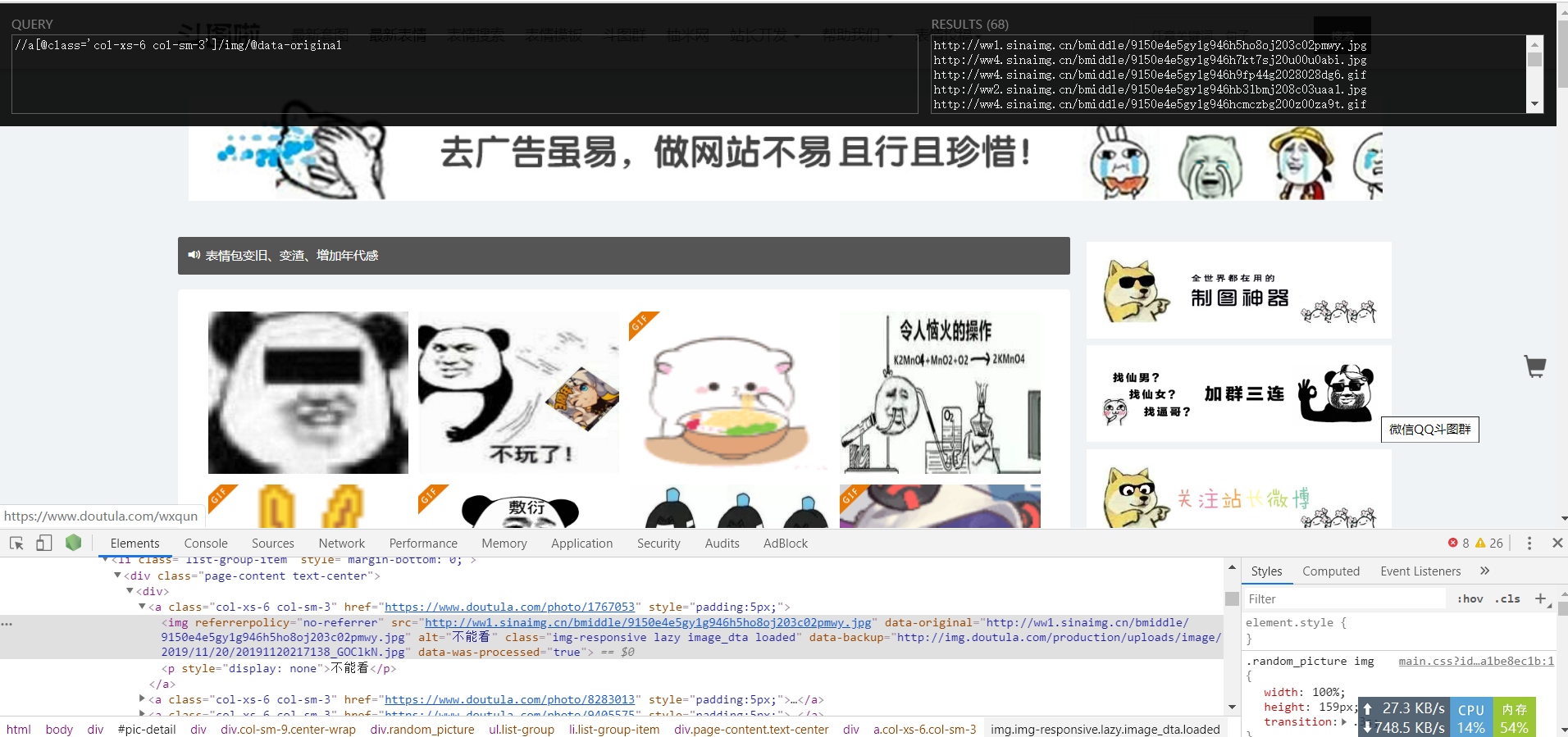

- xpath提取图片链接和名字:

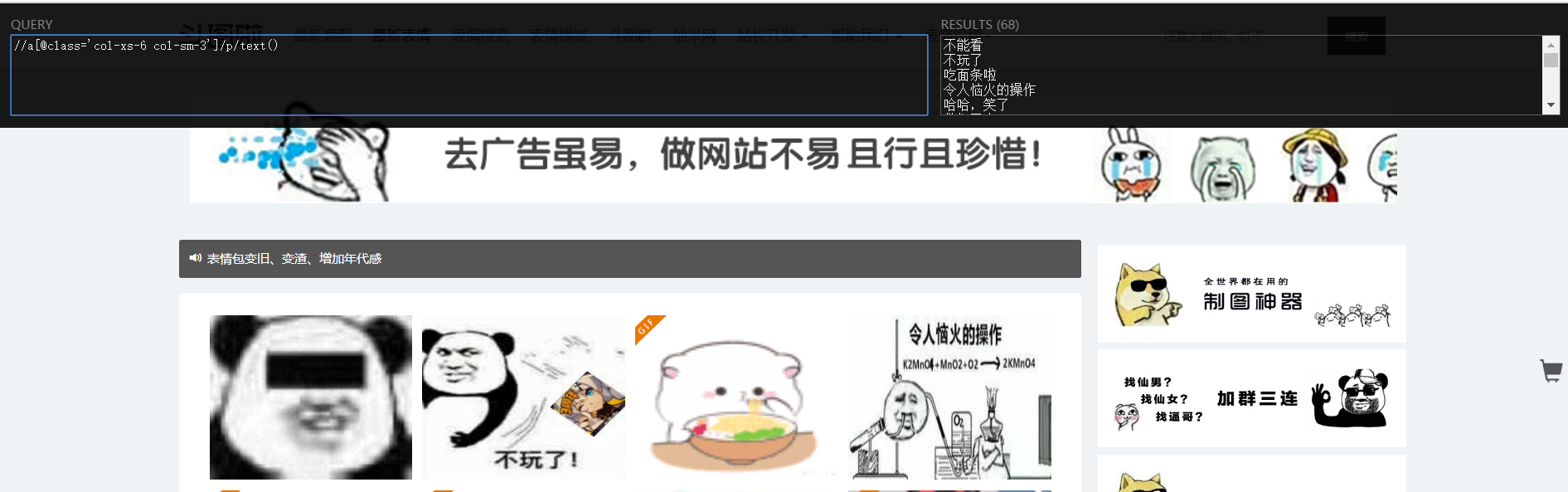

- 提取网址后缀,用于实现自动翻页

3.编写爬虫文件:

# -*- coding: utf-8 -*-

import scrapy

import requests class BiaoqingbaoSpider(scrapy.Spider):

name = 'biaoqingbao'

allowed_domains = ['doutula.com']

start_urls = ['http://www.doutula.com/photo/list/?page=1'] def parse(self, response):

#提取地址和图片名称

pictureUrls = response.xpath("//a[@class='col-xs-6 col-sm-3']/img/@data-original").extract()

pictureName = response.xpath("//a[@class='col-xs-6 col-sm-3']/p/text()").extract() #提取网址后缀,用于实现自动翻页

next_page = response.xpath("//li/a[@aria-label='Next »']/@href").extract_first() for i in range(len(pictureUrls)):

url = pictureUrls[i]

name = pictureName[i]

self.getPicture(url=url, name=name) #对每个图片调用getPicture下载图片并命名 #自动翻页

if next_page:

next_url = response.urljoin(next_page) #返回新的网址

yield scrapy.Request(next_url, callback=self.parse) #回调函数 #自定义函数,用于下载图片,因为刚学太菜,就只有先用requests下载了

def getPicture(self, url, name):

response = requests.get(url)

suffix = url.split(".")[-1] #提取图片链接地址的后缀,因为有jpg和gif图片格式

#二进制格式写入图片

with open("biaoqingbaoSpider/spiders/images/"+name+ "." + suffix, "wb") as fp:

fp.write(response.content)

4.执行爬虫文件:scrapy crawl biaoqingbao

- 切记:觉得爬差不多ctrl + c中止,不中止它会自动爬取到最后一页(3000页),当然也可以自己在代码里设置爬取多少页

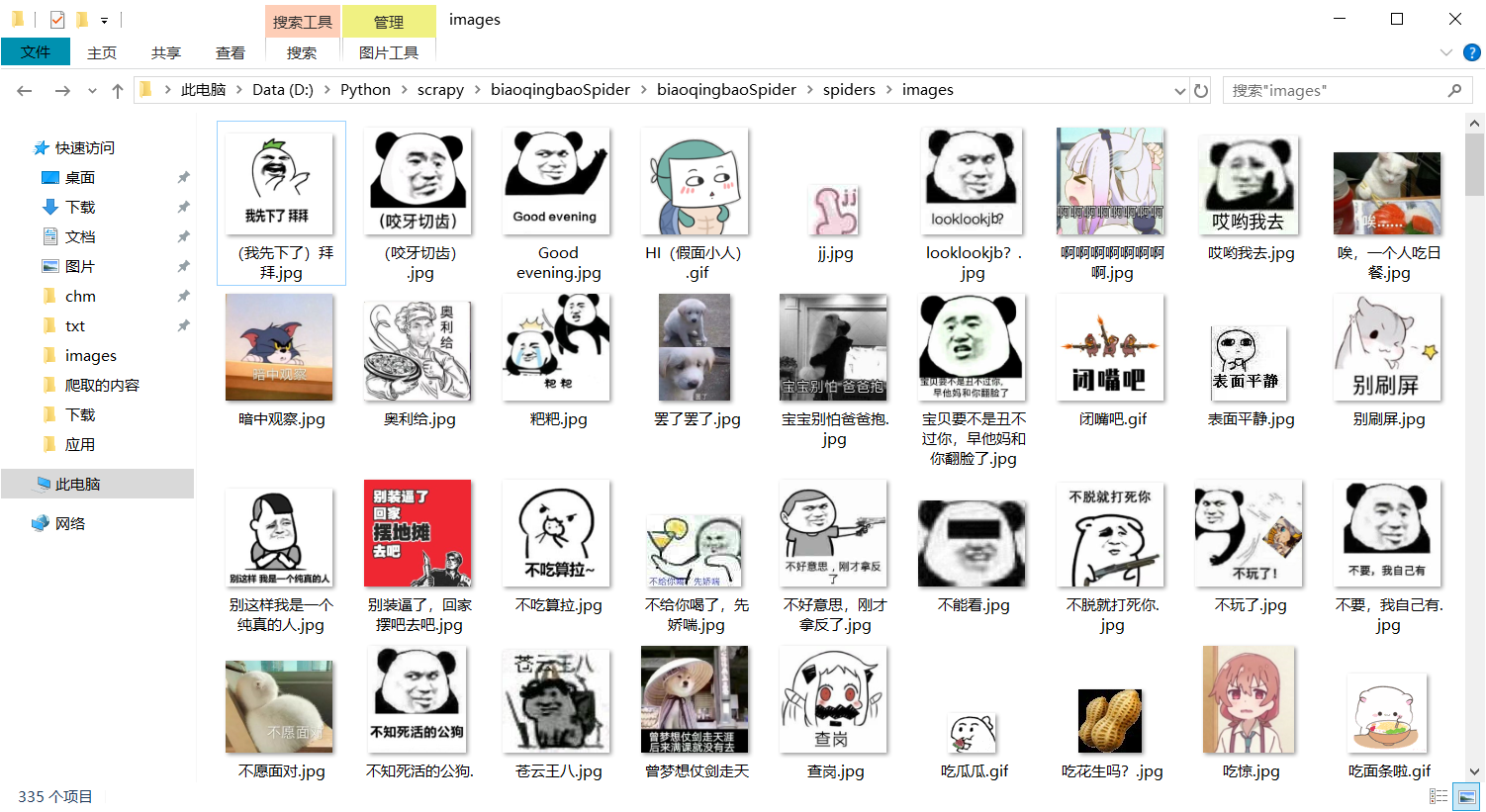

5.结果:

scrapy框架抓取表情包/(python爬虫学习)的更多相关文章

- 利用python scrapy 框架抓取豆瓣小组数据

因为最近在找房子在豆瓣小组-上海租房上找,发现搜索困难,于是想利用爬虫将数据抓取. 顺便熟悉一下Python. 这边有scrapy 入门教程出处:http://www.cnblogs.com/txw1 ...

- scrapy框架简介和基础应用(python爬虫)

一.什么是scrapy? scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架,非常出名,非常强悍,所谓的框架就是一个已经被集成了各种功能(高性能异步下载,队列,分布式,持久化等)的具有 ...

- Python爬虫学习==>第十章:使用Requests+正则表达式爬取猫眼电影

学习目的: 通过一个一个简单的爬虫应用,初窥门径. 正式步骤 Step1:流程框架 抓取单页内容:利用requests请求目标站点,得到单个页面的html代码,返回结果: 正则表达式分析:根据html ...

- 使用scrapy框架爬取自己的博文(2)

之前写了一篇用scrapy框架爬取自己博文的博客,后来发现对于中文的处理一直有问题- - 显示的时候 [u'python\u4e0b\u722c\u67d0\u4e2a\u7f51\u9875\u76 ...

- tcpdump抓取HTTP包

tcpdump抓取HTTP包 tcpdump -XvvennSs 0 -i eth0 tcp[20:2]=0x4745 or tcp[20:2]=0x4854 0x4745为"GET&quo ...

- 利用Fiddler抓取websocket包

一.利用fiddler抓取websockt包 打开Fiddler,点开菜单栏的Rules,选择Customize Rules... 这时会打开CustomRules.js文件,在class Handl ...

- 使用wireshark抓取TCP包分析1

使用wireshark抓取TCP包分析1 前言 介绍 目的 准备工作 传输 创建连接 握手 生成密钥 发送数据 断开连接 结论 前言 介绍 本篇文章是使用wireshrak对某个https请求的tcp ...

- 【转载】ASP.NET以Post方式抓取远程网页内容类似爬虫功能

使用HttpWebRequest等Http相关类,可以在应用程序中或者网站中模拟浏览器发送Post请求,在请求带入相应的Post参数值,而后请求回远程网页信息.实现这一功能也很简单,主要是依靠Http ...

- 手机通过Charles抓取https包

因为fiddler不能在mac上使用,而Charles是跨平台的,可以在mac上使用,所以需要了解一下Charles的使用 安装破解版Charles 下载破解版包,先启动一次未破解版的Ch ...

随机推荐

- 基于token机制鉴权架构

常见的鉴权方式有两种,一种是基于session,另一种是基于token方式的鉴权,我们来浅谈一下两种 鉴权方式的区别. 两种鉴权方式对比 session 安全性:session是基于cookie进行用 ...

- 车联网APP,安全设施薄弱的山寨品

- HDIT 来到该公司官网,打开任意一个云平台的链接,很显眼地能看见APP的下载按钮,下载,安装,抓包,使用,完全的套路,熟门熟路是不是. 再看抓取的报文,满目的HTTP协议数据: 完全没有对APP ...

- CentOS7使用docker搭建Solo博客

一.获取最新镜像 docker pull b3log/solo 二.启动容器 使用 MySQL 先手动建库(库名 solo,字符集使用 utf8mb4,排序规则 utf8mb4_general_ci) ...

- MD文件图片base64自动编码

看工具链接请直接将文章拉到最后.. 概述 不知道你在使用markdown写文章的时候有没有遇到过这样的烦恼, 文件写完了, 想将写完的文章粘贴到博客的时候, 你满心欢喜的复制粘贴, 但是发现图片根本复 ...

- 201871010111-刘佳华《面向对象程序设计(java)》第十六周学习总结

学号-姓名<面向对象程序设计(java)>第十六周学习总结 实验十四 应用程序归档与线程初步 实验时间 2019-12-12 第一部分:理论知识总结 1.程序与进程的概念 ‐程序是一段静 ...

- [C1W1] Neural Networks and Deep Learning - Introduction to Deep Learning

第一周:深度学习引言(Introduction to Deep Learning) 欢迎(Welcome) 深度学习改变了传统互联网业务,例如如网络搜索和广告.但是深度学习同时也使得许多新产品和企业以 ...

- C++ class内的 < 和 > 重载,大于号,小于号,重载示例。

#include <iostream> // overloading "operator = " outside class // < 和 > 是二元操作符 ...

- oracle 定时运行存储过程的实现

是基于PL/SQL 可视化工具的实现: 首先,先编写一个存储过程 点击procedure,右键新建,填写一个你编写的存储过程的名字: 如果是对正常的表进行操作,那么直接在begin和end ...

- luoguP4774 [NOI2018]屠龙勇士

题意 考虑杀每只龙\(i\)时候用的剑是一定的,我们可以用multiset模拟一遍得到,设为\(b_i\). 发现我们要求一个\(x\)满足对每个\(i\)有:\(b_i*x\equiv a_i\pm ...

- QFile 打开文件,不用先判断文件名是否为空,做这多余的工作

void test_file() { QFile file(""); if (!file.open(QIODevice::WriteOnly)){ qDebug()<< ...