写论文的第一天 hadoop环境搭建

毕设日志_____2019.1.23

实验集群环境搭建

三台阿里云服务器

|

公网ip |

内网ip |

|

120.79.63.130 node2 |

172.17.17.58 |

|

112.74.50.240 主节点master |

172.17.17.79 |

|

39.108.232.147 node1 |

172.16.50.183 |

通过filezilla上传 jdk1.8.01_192.tar.gz 以及hadoop.2.6.0.tar.gz到主节点

下载Xshell作为远程连接工具

1:更改名称

用Xshell连接三台服务器 分别修改其主机名为 master node1 node2 对应服务器表格

命令如下 vim /etc/hostname

2:修改主机映射

Vim /etc/hosts

在原有文件上增加

120.79.63.130 node2

112.74.50.240 master

39.108.232.147 node1

通过scp将映射文件复制到子节点并且覆盖原有文件

命令:scp /etc/hosts node1:/etc/hosts

scp /etc/hosts node2:/etc/hosts

3:ssh免密

主节点执行命令 ssh-keygen –t rsa 产生公共密钥 一直回车会将公钥默认保存到~/.ssh/id_rsa.pub中

命令:ssh-copy-id -i node1

ssh-copy-id -i node2

将公钥导入到node1和node2中 来实现master到子节点的免密

命令:cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

将master密钥导入到本地 实现本地ssh免密登陆

4:jdk安装

将filezilla传到主节点的jdk压缩包解压

命令: tar –zxf ./jdk1.8.0_192 /usr/local 解压到/usr/local目录

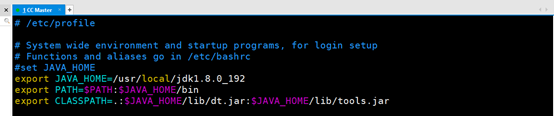

配置JAVA_HOME

命令: vim /etc/profile

进入文件增加如下

#set JAVA_HOME

export JAVA_HOME=/usr/local/jdk1.8.0_192

export PATH=$PATH:$JAVA_HOME/bin

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

保存并且退出 执行命令: source /etc/profile使配置生效

通过在端口键入 java –version查看是否安装并且配置成功

至此配置jdk成功

将jdk传到两个子节点上并且配置JAVA_HOME 步骤如上

命令:scp –r /usr/local/jdk1.8.0_192 node1:/usr/local/

scp –r /usr/local/jdk1.8.0_192 node2:/usr/local/

5:hadoop安装

在主节点将hadoop2.6.0的压缩包解压

命令: tar –zxf ./hadoop2.6.0.tar.gz /usr/local/

解压到/usr/local目录下生成hadoop.2.6.0

为了以后方便使用 改名为hadoop

命令:mv ./hadoop.2.6.0 ./hadoop

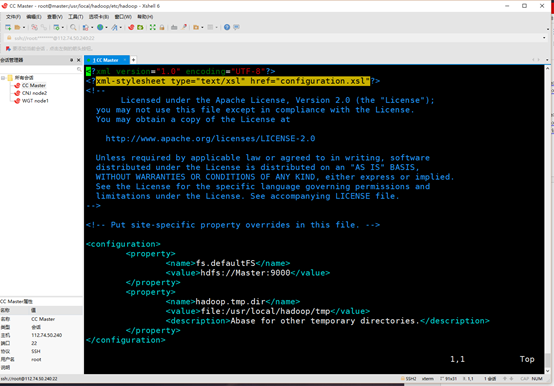

配置主节点hadoop中的core-site.xml hdfs-site.xml yarn-site.xml mapred-site.xml

配置如下

在core-site.xml中增加

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://Master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

</configuration>

在hdfs-site.xml中增加

<configuration>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>Master:50090</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

在yarn-site.xml中增加

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>Master</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

将mapred-site.xml.template复制一份为mapred-site.xml.并增加

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>Master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>Master:19888</value>

</property>

</configuration>

主节点搭建完毕 复制到两个子节点

命令: scp /usr/local/hadoop node1:/usr/local

scp /usr/local/hadoop node2:/usr/local

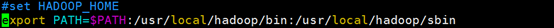

检测集群是否搭建成功 为了方便以后使用为hadoop配置PATH

命令: vim /etc/profile

#set HADOOP_HOME

export PATH=$PATH:/usr/local/hadoop/bin:/usr/local/hadoop/sbin

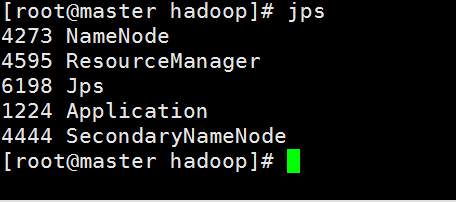

开始测试hadoop集群是否搭建成功

命令: start-all.sh

查看主节点进程

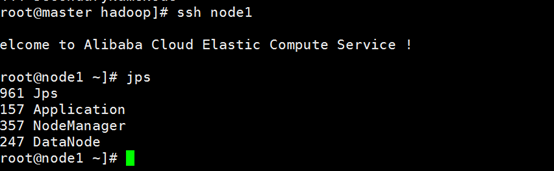

查看node1进程

查看node2进程

所有进程启动正常 Hadoop集群配置成功

注意:在使用Xshell时可以粘贴复制配置文件,但是在linux中,hadoop集群启动时会对core-site.xml hdfs-site.xml 等等进行解析

这里要注意在copy的时候在xml文件的开始行有默认的xml注释,表明这是该xml文件的版本以及编码格式。这个标明前面不要有任何其他内容(空格 空行都不行)否则启动hadoop集群的时候会出现解析错误从而导致hadoop集群启动失败。

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

写论文的第一天 hadoop环境搭建的更多相关文章

- 【转】RHadoop实践系列之一:Hadoop环境搭建

RHadoop实践系列之一:Hadoop环境搭建 RHadoop实践系列文章,包含了R语言与Hadoop结合进行海量数据分析.Hadoop主要用来存储海量数据,R语言完成MapReduce 算法,用来 ...

- 转 史上最详细的Hadoop环境搭建

GitChat 作者:鸣宇淳 原文:史上最详细的Hadoop环境搭建 关注公众号:GitChat 技术杂谈,一本正经的讲技术 [不要错过文末活动哦] 前言 Hadoop在大数据技术体系中的地位至关重要 ...

- hadoop环境搭建之关于NAT模式静态IP的设置 ---VMware12+CentOs7

很久没有更新了,主要是没有时间,今天挤出时间验证了一下,果然还是有些问题的,不过已经解决了,就发上来吧. PS:小豆腐看仔细了哦~ 关于hadoop环境搭建,从单机模式,到伪分布式,再到完全分布式,我 ...

- eclipse工具下hadoop环境搭建

eclipse工具下hadoop环境搭建: window10操作系统中搭建eclipse64开发系统,配置hadoop的eclipse插件,让eclipse可以查看Hdfs中的文件内容. ...

- 大数据学习之Hadoop环境搭建

一.Hadoop的优势 1)高可靠性:因为Hadoop假设计算元素和存储会出现故障,因为它维护多个工作数据副本,在出现故障时可以对失败的节点重新分布处理. 2)高扩展性:在集群间分配任务数据,可方便的 ...

- Hadoop环境搭建、启动和管理界面查看

一.hadoop环境搭建: 1. hadoop 6个核心配置文件的作用:core-site.xml:核心配置文件,主要定义了我们文件访问的格式 hdfs://hadoop-env.sh:主要配置我们的 ...

- Ubuntu中Hadoop环境搭建

Ubuntu中Hadoop环境搭建 JDK安装 方法一:通过命令行直接安装(不建议) 有两种java可以安装oracle-java8-installer以及openjdk (1)安装oracle-ja ...

- Linux集群搭建与Hadoop环境搭建

今天是8月19日,距离开学还有15天,假期作业完成还是遥遥无期,看来开学之前的恶补是躲不过了 今天总结一下在Linux环境下安装Hadoop的过程,首先是对Linux环境的配置,设置主机名称,网络设置 ...

- Hadoop环境搭建(centos)

Hadoop环境搭建(centos) 本平台密码83953588abc 配置Java环境 下载JDK(本实验从/cgsrc 文件中复制到指定目录) mkdir /usr/local/java cp / ...

随机推荐

- Jquery serialize()提交多个表单数据

ajax提交多个表单数据: 先把不同的表单分别用serialize()函数,然后把序列化后的数据用+拼接提交给后台,具体例子如下 var data1 = $('#form1).serialize(); ...

- 使用GDAL实现DEM的地貌晕渲图(二)

1. 问题 之前我在<使用GDAL实现DEM的地貌晕渲图(一)>这篇文章里面讲述了DEM晕渲图的生成原理与实现,大体上来讲是通过计算DEM格网点的法向量与日照方向的的夹角,来确定该格网点的 ...

- SpringBoot解决cors跨域问题

1.使用@CrossOrigin注解实现 (1).对单个接口配置CORS @CrossOrigin(origins = {"*"}) @PostMapping("/hel ...

- C#编程.函数.参数

详细内容请参见<C#入门经典(第4版)>p101页 1.参数匹配 在调用函数时,必须使参数与函数定义中指定的参数完全匹配,这意味着要匹配参数的类型.个数.和顺序. 注:函数签名由函数的名称 ...

- PHP-1.数据库连接与登陆

<?php //数据库信息 $servername = "localhost"; $username = "root"; $password = &quo ...

- Thinkphp 5.1.7 parseData缺陷导致insert/update注入 分析

目录 环境搭建 分析 参考 环境搭建 $ composer create-project topthink/think thinkphp-5.1.7 修改composer.json 5.1.* =&g ...

- 物联网网关MQTT应用与配置测试介绍

1.MQTT介绍: MQTT(Message Queuing Telemetry Transport,消息队列遥测传输协议),作为除Modbus外最常用的协议之一,因其基于发布/订阅的模式,具有资源消 ...

- CSS3 filter 模糊滤镜的应用

CSS3 filter 模糊滤镜的应用 在segmentfault上回答过的一个问题,如何将网页CSS背景图高斯模糊且全屏显示当时没有深入了解,只觉得滤镜应该只是应用于图片上的.而且各大网站的de ...

- (13)ASP.NET Core 中的选项模式(Options)

1.前言 选项(Options)模式是对配置(Configuration)的功能的延伸.在12章(ASP.NET Core中的配置二)Configuration中有介绍过该功能(绑定到实体类.绑定至对 ...

- restapi(4)- rest-mongo : MongoDB数据库前端的httpserver

完成了一套标准的rest风格数据库CRUD操作httpserver后发现有许多不足.主要是为了追求“通用”两个字,想把所有服务接口做的更“范generic”些,结果反而限制了目标数据库的特点,最终产生 ...