爬虫之解析库Xpath

简介

语法

|

表达式

|

描述

|

|---|---|

|

nodename

|

选取此节点的所有子节点。

|

|

/

|

从根节点选取。

|

|

//

|

从匹配选择的当前节点选择文档中的节点,而不考虑它们的位置。

|

|

.

|

选取当前节点。

|

|

..

|

选取当前节点的父节点。

|

|

@

|

选取属性。

|

运算符

|

运算符

|

描述

|

实例

|

返回值

|

|---|---|---|---|

|

|

|

计算两个节点集

|

//book | //cd

|

返回所有拥有 book 和 cd 元素的节点集

|

|

+

|

加法

|

6 + 4

|

10

|

|

-

|

减法

|

6 - 4

|

2

|

|

*

|

乘法

|

6 * 4

|

24

|

|

div

|

除法

|

8 div 4

|

2

|

|

=

|

等于

|

price=9.80

|

如果 price 是 9.80,则返回 true。

如果 price 是 9.90,则返回 false。

|

|

!=

|

不等于

|

price!=9.80

|

如果 price 是 9.90,则返回 true。

如果 price 是 9.80,则返回 false。

|

|

<

|

小于

|

price<9.80

|

如果 price 是 9.00,则返回 true。

如果 price 是 9.90,则返回 false。

|

|

<=

|

小于或等于

|

price<=9.80

|

如果 price 是 9.00,则返回 true。

如果 price 是 9.90,则返回 false。

|

|

>

|

大于

|

price>9.80

|

如果 price 是 9.90,则返回 true。

如果 price 是 9.80,则返回 false。

|

|

>=

|

大于或等于

|

price>=9.80

|

如果 price 是 9.90,则返回 true。

如果 price 是 9.70,则返回 false。

|

|

or

|

或

|

price=9.80 or price=9.70

|

如果 price 是 9.80,

或者 price 是 9.70,则返回 true。

|

|

and

|

与

|

price>9.00 and price<9.90

|

如果 price 大于 9.00,

并且 price 小于9.90,则返回 true。

|

|

mod

|

计算除法的余数

|

5 mod 2

|

1

|

常用表达式

- 获取所有节点

- 获取所有li标签

- //* //li

- 获取子节点

- 我们通过/或//即可查找元素的子节点和子孙节点

- li节点的所有直接a子节点

- //li/a

- 获取ul的所有子孙a节点

- //ul//a - 获取父节点属性

- 知道子节点查询父节点

- //div[@class="filter-wrap"]/../@class'

- //div[@class="filter-wrap"]/parent::*/@class' - 属性定位

- 找到当前源码中所有class属性为song的div标签

- //div[@class="song"] - 层级&索引定位

- 找到class属性值为tang的div的直系子标签ul下的第二个子标签li下的直系子标签a

- //div[@class="tang"]/ul/li[2]/a - 多属性匹配

- 从当前源码中找到href属性为空且class属性为song的所有a标签

- //a[@href="" and @class="song"] - 模糊匹配

- 找到所有class属性值中包含nb的所有div标签

- //div[contains(@class,"so")]

- 找到所有class属性值以zb开头的所有div标签

- //div[starts-with(@class,"ta")] - 获取文本

- / 表示获取某个标签下的文本内容

- // 表示获取某个标签下的文本内容和所有子标签下的文本内容

- //div[@class="song"]/p[1]/text()

- //div[@class="tang"]//text() - 获取属性

- //div[@class="tang"]//li[2]/a/@href

案例演示

环境安装

pip install lxml

解析原理

- 解析原理:

- 获取页面源码数据

- 实例化一个etree对象,并将页面源码数据加载到该对象中

- 调用该对象的xpath方法进行指定标签的定位

- 注意:xpath函数必须结合着xpath表达式进行标签的定位和内容的捕获

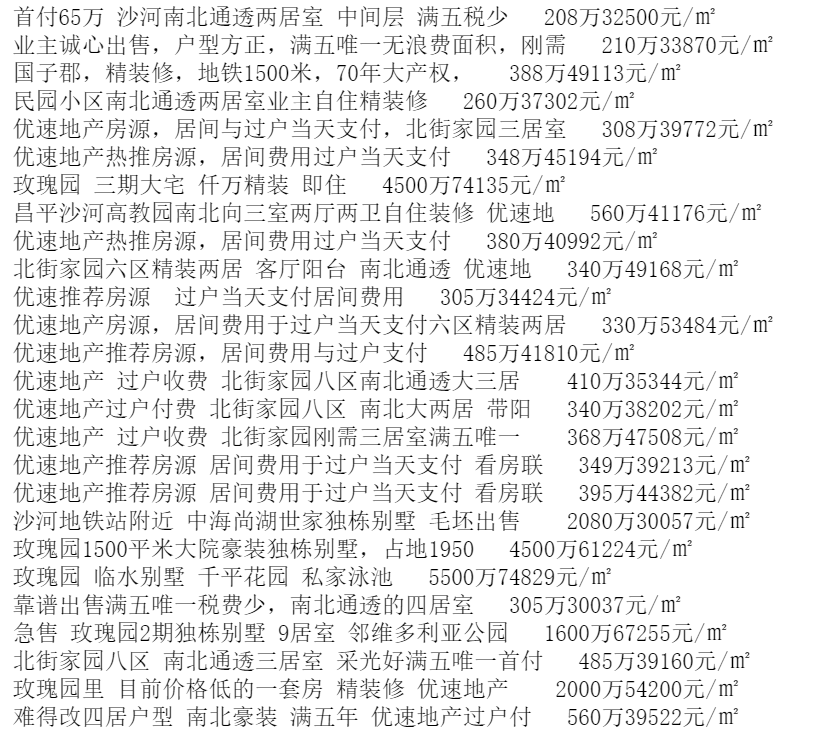

58同城房源信息抓取

import requests

from lxml import etree url = "https://bj.58.com/shahe/ershoufang/?PGTID=0d30000c-0047-e4b2-f57c-08960a90aab4&ClickID=1"

headres = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.142 Safari/537.36'

}

response = requests.get(url).text # 实列化一个etree对象,加载页面源码数据

tree = etree.HTML(response) # etree对象调用xpath函数,结合xpath表达式进行标签定位和内容捕获

li_list = tree.xpath('//ul[@class="house-list-wrap"]/li') # 返回值由很多个li标签组成的列表

for i in li_list:

tetle = i.xpath("./div[2]/h2/a/text()")[0] # 局部调用表达式时必须加点

procr = "".join(i.xpath("./div[3]/p//text()")) # 将价格拼接

print(tetle,procr) """

i.xpath("./div[2]/h2/a/text() |./div[3]/h2/a/text()")[0] # xpath中可以使用管道符表示或的关系,用这两种规则进行匹配

"""

彼岸图网图片爬取

注意:这里遇到中文乱码问题 解决方法一:

# 处理中文乱码,将响应数据统一编码成utf-8

# response.encoding = "utf-8" 解决方法二:

# 哪里乱码解码哪里

img_name.encode("iso-8859-1").decode("gbk")

import os

import urllib

import requests

from lxml import etree

url = "http://pic.netbian.com/4kmeinv/"

headers = {

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.142 Safari/537.36'

}

response = requests.get(url=url,headers=headers) # 处理中文乱码,将响应数据统一编码成utf-8

# response.encoding = "utf-8"

if not os.path.exists("./imgs"):

os.mkdir("./imgs")

page_text = response.text

# 实例化etree对象并加载页面源码数据

tree = etree.HTML(page_text)

# 找到所有li标签

li_list = tree.xpath("//div[@class='slist']/ul/li")

for li in li_list:

img_name = li.xpath("./a/b/text()")[0] # ./代表从li标签开始解析,不写m默认从整张HTML页面开始解析

# 处理中文乱码

img_name = img_name.encode("iso-8859-1").decode("gbk")

# 拼接图片路径

img_url = "http://pic.netbian.com" + li.xpath("./a/img/@src")[0]

img_path = "./imgs/" + img_name+".jpg"

# 调用urllib中的urlretrieve方法存储

urllib.request.urlretrieve(url=img_url,filename=img_path)

print("正在下载",img_name)

print("download ok")

爬虫之解析库Xpath的更多相关文章

- python爬虫三大解析库之XPath解析库通俗易懂详讲

目录 使用XPath解析库 @(这里写自定义目录标题) 使用XPath解析库 1.简介 XPath(全称XML Path Languang),即XML路径语言,是一种在XML文档中查找信息的语言. ...

- 网页解析库-Xpath语法

网页解析库 简介 除了正则表达式外,还有其他方便快捷的页面解析工具 如:lxml (xpath语法) bs4 pyquery等 Xpath 全称XML Path Language, 即XML路径语言, ...

- Python爬虫【解析库之beautifulsoup】

解析库的安装 pip3 install beautifulsoup4 初始化 BeautifulSoup(str,"解析库") from bs4 import BeautifulS ...

- Python爬虫【解析库之pyquery】

该库跟jQuery的使用方法基本一样 http://pyquery.readthedocs.io/ 官方文档 解析库的安装 pip3 install pyquery 初始化 1.字符串初始化 htm ...

- Python3编写网络爬虫05-基本解析库XPath的使用

一.XPath 全称 XML Path Language 是一门在XML文档中 查找信息的语言 最初是用来搜寻XML文档的 但是它同样适用于HTML文档的搜索 XPath 的选择功能十分强大,它提供了 ...

- 爬虫解析库xpath

# xpath简介 XPath即为XML路径语言(XML Path Language),它是一种用来确定XML文档中某部分位置的语言.用于在 XML 文档中通过元素和属性进行导航. XPath基于XM ...

- python爬虫基础04-网页解析库xpath

更简单高效的HTML数据提取-Xpath 本文地址:https://www.jianshu.com/p/90e4b83575e2 XPath 是一门在 XML 文档中查找信息的语言.XPath 用于在 ...

- python爬虫之解析库Beautiful Soup

为何要用Beautiful Soup Beautiful Soup是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式, 是一个 ...

- python爬虫之解析库正则表达式

上次说到了requests库的获取,然而这只是开始,你获取了网页的源代码,但是这并不是我们的目的,我们的目的是解析链接里面的信息,比如各种属性 @href @class span 抑或是p节点里 ...

随机推荐

- (四)Activiti之流程定义部署之ZIP方式和流程定义查询

一.流程定义部署之ZIP方式 上一章节我们使用classpath的方式加载流程定义文件,这里我们使用ZIP的方式. 1.1 用activiti插件生成bpmn和png图片之后,压缩到一个zip格式的压 ...

- java轻松玩转localdatetime

废话不多说,直接上代码 //时间戳转LocalDateTime public static LocalDateTime getLocalDateTime(long timestamp) { Insta ...

- nginx 反向代理的配置

nginx中的每个server就是一个反向代理配置,可以有多个server(nginx只能处理静态资源) nginx中 server的配置 server { listen 80; server_nam ...

- 升级xcode11&ios13的坑

Swift Packages 目前Pod跟SPM的兼容还没做好,配置好SPM后,Pod不能进行正常更新,先配置好Pod再集成SPM则没有问题 Pod以后的更新可能会解决这个问题,也会有越来越多的库支持 ...

- js 小细节(持续更新)

1.在对数据进行操作时,一定要考虑数据里面每一个value值是否存在 $.each(data, function(i, item){ if(item == null || item.firstFram ...

- Computer Vision_18_Image Stitching:Automatic Panoramic Image Stitching using Invariant Features——2007

此部分是计算机视觉部分,主要侧重在底层特征提取,视频分析,跟踪,目标检测和识别方面等方面.对于自己不太熟悉的领域比如摄像机标定和立体视觉,仅仅列出上google上引用次数比较多的文献.有一些刚刚出版的 ...

- jeffy-vim-v2.9

http://pan.baidu.com/s/1qW1DlP6

- 通用mapper的增删改查方法 留存 备忘

Mybatis通用Mapper介绍与使用 前言 使用Mybatis的开发者,大多数都会遇到一个问题,就是要写大量的SQL在xml文件中,除了特殊的业务逻辑SQL之外,还有大量结构类似的增删改查SQ ...

- 判断一个ip地址是动态的还是静态的

要确定计算机的IP是静态IP还是动态IP,请执行以下步骤: 通过单击开始打开命令提示符并搜索CMD,然后单击cmd.exe 键入ipconfig / all. 找到“以太网本地连接”列表.找到“ I ...

- linux 服务器常规巡检并生成报表(一)

背景 最近接到一个需求要求每天巡检各台业务设备,并导出报表,但一想到设备有N台,一台台每天巡检这样的重复劳作实在是太伤神了,因此决定写一个脚本来搞定这件事. 首先,第一个要解决的问题是批量服务器执行命 ...