matlab实现梯度下降法(Gradient Descent)的一个例子

在此记录使用matlab作梯度下降法(GD)求函数极值的一个例子:

问题设定:

1. 我们有一个$n$个数据点,每个数据点是一个$d$维的向量,向量组成一个data矩阵$\mathbf{X}\in \mathbb{R}^{n\times d}$,这是我们的输入特征矩阵。

2. 我们有一个响应的响应向量$\mathbf{y}\in \mathbb{R}^n$。

3. 我们将使用线性模型来fit上述数据。因此我们将优化问题形式化成如下形式:$$\arg\min_{\mathbf{w}}f(\mathbf{w})=\frac{1}{n}\|\mathbf{y}-\mathbf{\overline{X}}\mathbf{w}\|_2^2$$

其中$\mathbf{\overline{X}}=(\mathbf{1,X})\in \mathbb{R}^{n\times (d+1)}$ and $\mathbf{w}=(w_0,w_1,...,w_d)^\top\in \mathbb{R}^{d+1}$

显然这是一个回归问题,我们的目标从通俗意义上讲就是寻找合适的权重向量$\mathbf{w}$,使得线性模型能够拟合的更好。

预处理:

1. 按列对数据矩阵进行最大最小归一化,该操作能够加快梯度下降的速度,同时保证了输入的数值都在0和1之间。$\mathbf{x}_i$为$\mathbf{X}$的第i列。 $$z_{ij}\leftarrow \frac{x_{ij}-\min(\mathbf{x}_i)}{\max(\mathbf{x}_i)-\min(\mathbf{x}_i)}$$

这样我们的优化问题得到了转化:$$\arg\min_{\mathbf{u}}g(\mathbf{w})=\frac{1}{n}\|\mathbf{y}-\mathbf{\overline{Z}}\mathbf{u}\|_2^2$$

2. 考虑对目标函数的Lipschitz constants进行估计。因为我们使用线性回归模型,Lipschitz constants可以方便求得,这样便于我们在梯度下降法是选择合适的步长。假如非线性模型,可能要用其他方法进行估计(可选)。

问题解决:

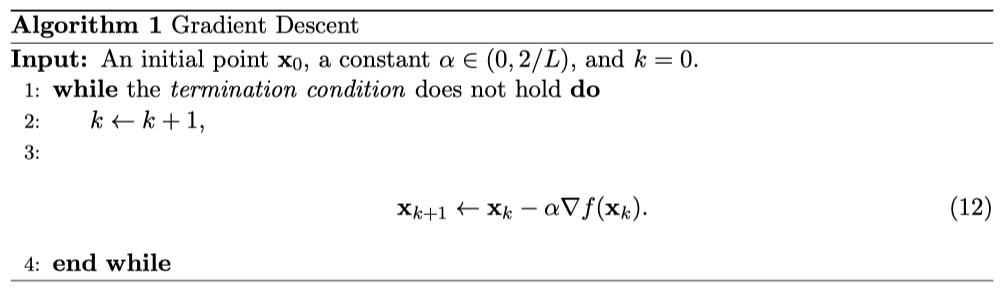

使用梯度下降法进行问题解决,算法如下:

我们可以看到,这里涉及到求目标函数$f$对$\mathbf{x}_k$的梯度。显然在这里,因为是线性模型,梯度的求解十分的简单:$$\nabla f(\mathbf{x}_k)=-\frac{2}{n}\mathbf{\overline{X}}^\top(\mathbf{y}-\mathbf{\overline{X}}\mathbf{u}_k)$$

进行思考,还有没有其他办法可以把这个梯度给弄出来?假如使用Tensorflow,Pytorch这样可以自动保存计算图的东东,那么梯度是可以由机器自动求出来的。当然在这里我是用matlab实现,暂时没有发现这样的利器,所以我认为假如在这里想求出梯度,那么我们必须要把梯度的闭式解搞出来,不然没法继续进行。

下面是一段matlab的代码:

- function [g_result,u_result] = GD(N_Z,y,alpha,u0)

- %GD 梯度下降法

- % Detailed explanation goes here

- [n,~] = size(N_Z);

- u = u0;

- k = 0;

- t = y-N_Z*u;

- disp("g(u):");

- while(合理的终止条件)

- k = k + 1;

- u = u - alpha * (-2/n)*N_Z'*t;

- t = y-N_Z*u;

- if(mod(k,10)==0)

- disp(t'*t/n);

- end

- end

- g_result = (y-N_Z * u)' * (y-N_Z * u)/n;

- u_result = u;

- end

当然假如初始化的时候$u_0$选择不当,而且因为没有正则项,以上的算法将会有很大的问题:梯度消失,导致优化到最后的时候非常慢。我花了好多个小时才将loss讲到0.19左右,而闭式解法能够使得loss为0.06几,运行时间也不会难以忍受。

问题推广:

在这里,我们的问题是线性模型,回归问题。能否有更广的应用?思考后认为,只要需要优化的目标是标量,且该目标函数对输入向量的梯度容易求得即可。只是因为该算法简单朴素,可能在实际应用的时候会碰见恼人的梯度消失问题。

matlab实现梯度下降法(Gradient Descent)的一个例子的更多相关文章

- (3)梯度下降法Gradient Descent

梯度下降法 不是一个机器学习算法 是一种基于搜索的最优化方法 作用:最小化一个损失函数 梯度上升法:最大化一个效用函数 举个栗子 直线方程:导数代表斜率 曲线方程:导数代表切线斜率 导数可以代表方向, ...

- <反向传播(backprop)>梯度下降法gradient descent的发展历史与各版本

梯度下降法作为一种反向传播算法最早在上世纪由geoffrey hinton等人提出并被广泛接受.最早GD由很多研究团队各自发表,可他们大多无人问津,而hinton做的研究完整表述了GD方法,同时hin ...

- 梯度下降法Gradient descent(最速下降法Steepest Descent)

最陡下降法(steepest descent method)又称梯度下降法(英语:Gradient descent)是一个一阶最优化算法. 函数值下降最快的方向是什么?沿负梯度方向 d=−gk

- 梯度下降(gradient descent)算法简介

梯度下降法是一个最优化算法,通常也称为最速下降法.最速下降法是求解无约束优化问题最简单和最古老的方法之一,虽然现在已经不具有实用性,但是许多有效算法都是以它为基础进行改进和修正而得到的.最速下降法是用 ...

- 机器学习(1)之梯度下降(gradient descent)

机器学习(1)之梯度下降(gradient descent) 题记:最近零碎的时间都在学习Andrew Ng的machine learning,因此就有了这些笔记. 梯度下降是线性回归的一种(Line ...

- 梯度下降(Gradient Descent)小结 -2017.7.20

在求解算法的模型函数时,常用到梯度下降(Gradient Descent)和最小二乘法,下面讨论梯度下降的线性模型(linear model). 1.问题引入 给定一组训练集合(training se ...

- 理解梯度下降法(Gradient Decent)

1. 什么是梯度下降法? 梯度下降法(Gradient Decent)是一种常用的最优化方法,是求解无约束问题最古老也是最常用的方法之一.也被称之为最速下降法.梯度下降法在机器学习中十分常见,多用 ...

- (二)深入梯度下降(Gradient Descent)算法

一直以来都以为自己对一些算法已经理解了,直到最近才发现,梯度下降都理解的不好. 1 问题的引出 对于上篇中讲到的线性回归,先化一个为一个特征θ1,θ0为偏置项,最后列出的误差函数如下图所示: 手动求解 ...

- CS229 2.深入梯度下降(Gradient Descent)算法

1 问题的引出 对于上篇中讲到的线性回归,先化一个为一个特征θ1,θ0为偏置项,最后列出的误差函数如下图所示: 手动求解 目标是优化J(θ1),得到其最小化,下图中的×为y(i),下面给出TrainS ...

随机推荐

- Android Studio代码编译通过但是提示停止运行

这种问题也许有很多可能,但是我遇到过一种,下面分享给大家希望问题会得到解决 检查你的布局文件中图片的位置 如果图片名前有“(v24)”的删掉 重新插入图片到这个目录 然后就可以正常运行了

- 关于Java两点需要更新的知识

HashMap的初始容量 背景 很多人可以把HashMap的原理描述的很溜.比如JDK1.7之前,底层数据结构是数组+链表.JDK1.8之后,出于效率上的考虑,在数组长度大于64,链表长度大于8的时候 ...

- [SD心灵鸡汤]003.每月一则 - 2015.07

乔布斯去世了,但他留给世人的财富却很多,值得每个人学习.他是个精力充沛魅力无限的家伙,同时也是一个很会鼓动人心的激励大师,甚至在他的平常对话中,经典的语句也常常脱口而出. 这里摘取了一些他的经典语录, ...

- remote desktop能实现什么?远程桌面管理的意义是什么?

随着互联网时代的发展,向人请教来说,视频教学已经不算便捷了,而远程桌面就发挥了重要作用.它意味着您可以从家里连接到工作计算机,并访问所有应用程序.文件和网络资源,好像正坐在工作计算机前面.您可以让程序 ...

- ssm中的依赖配置

<dependency> <groupId>org.springframework</groupId> <artifactId>spring-conte ...

- Java实现第七届蓝桥杯国赛 赢球票

标题:赢球票 某机构举办球票大奖赛.获奖选手有机会赢得若干张球票. 主持人拿出 N 张卡片(上面写着 1~N 的数字),打乱顺序,排成一个圆圈. 你可以从任意一张卡片开始顺时针数数: 1,2,3- 如 ...

- Java实现 LeetCode 378 有序矩阵中第K小的元素

378. 有序矩阵中第K小的元素 给定一个 n x n 矩阵,其中每行和每列元素均按升序排序,找到矩阵中第k小的元素. 请注意,它是排序后的第k小元素,而不是第k个元素. 示例: matrix = [ ...

- Java实现欧拉筛与花里胡哨求质数高级大法的对比

我也不清楚这是什么高级算法,欧拉筛是昨天有位大佬,半夜无意间告诉我的 欧拉筛: 主要的含义就是我把这个数的所有倍数都弄出来,然后下次循环的时候直接就可以跳过了 import java.text.Sim ...

- Java实现 蓝桥杯VIP 算法训练 字符删除

算法训练 字符删除 时间限制:1.0s 内存限制:512.0MB 问题描述 编写一个程序,先输入一个字符串str(长度不超过20),再输入单独的一个字符ch,然后程序会把字符串str当中出现的所有的c ...

- Java实现 蓝桥杯VIP 算法提高 计算器

算法提高 计算器 时间限制:1.0s 内存限制:256.0MB [问题描述] 王小二的计算器上面的LED显示屏坏掉了,于是他找到了在计算器维修与应用系学习的你来为他修计算器. 屏幕上可以显示0~9的数 ...