Transformer详解:各个特征维度分析推导

谷歌在文章《Attention is all you need》中提出的transformer模型。如图主要架构:同样为encoder-decoder模式,左边部分是encoder,右边部分是decoder。

TensorFlow代码:https://www.github.com/kyubyong/transformer

用 sentencepiece 进行分词。

Encoder 输入

初始输入为待翻译语句的embedding矩阵,由于句子长度不一致,需要做统一长度处理,长度取maxlength1,不够长的句子padding 0值,句尾加上 </s> 。

d = 512, [batchsize,maxlen1,d]考虑到词语间的相对位置信息,还要加上语句的position

encoding,由函数形式直接求出。

PE(pos,2i) = sin(pos/10002i/d)

PE(pos,2i+1) = cos(pos/10002i/d)Padding的值不做position encoding。 [batchsize,maxlen1,d] ,最终:

encoder input = position encoding + input embedding。

encoder input : [batchsize,maxlen1,d]Encoder

Encoder 由N = 6个相同的layer连接组成。每个layer中有两个sublayer,分别是multihead

self-attention以及FFN。

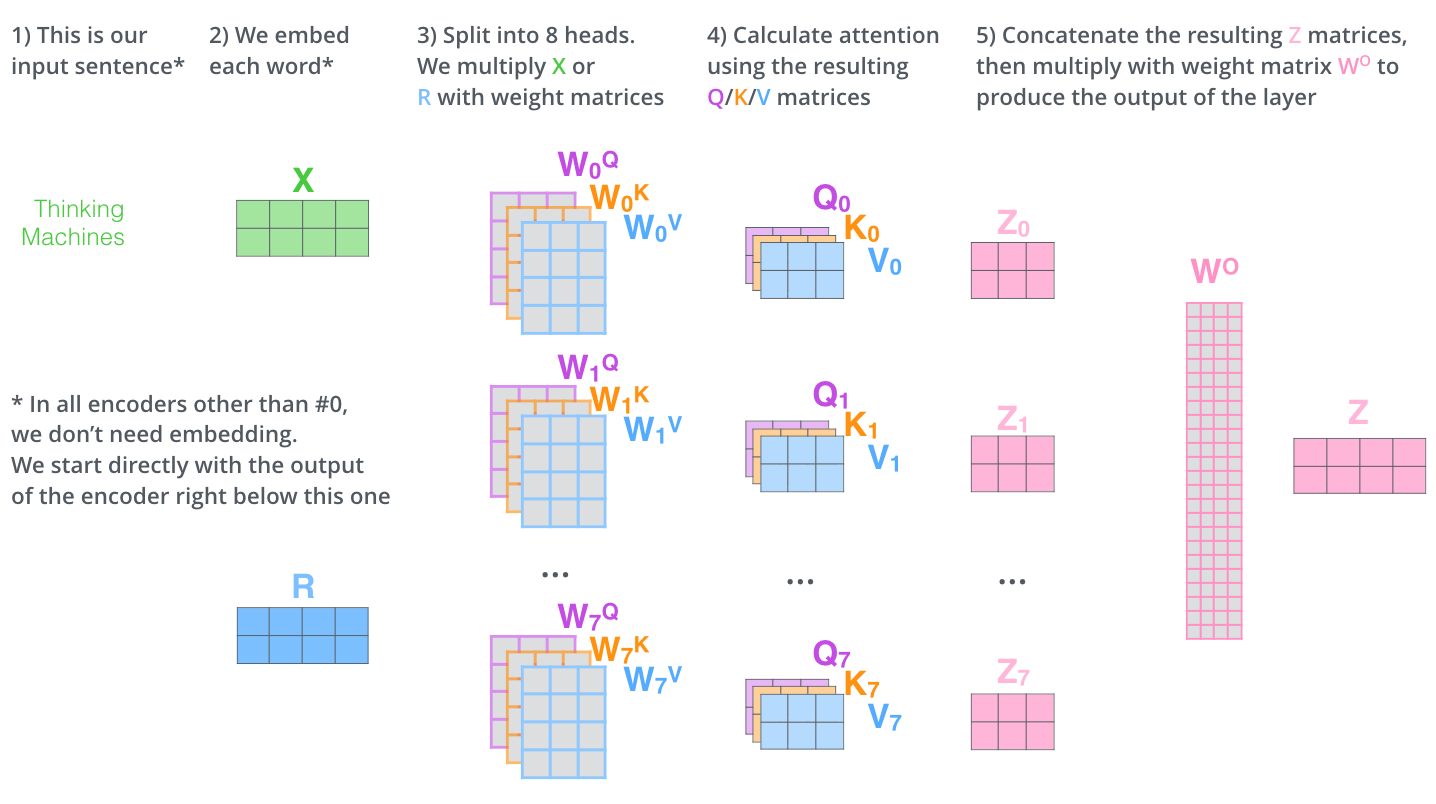

Q = K = V = input

MultiHead(Q, K, V) = concat(head1, …, headh)Wo

headi = Attention(QWiQ,KWik,VWiV)

Attention(Q, K, V) = softmax(QKT/$$sqrt{d}$$) V

softmax前要做key_mask,把pad 0 的地方赋值为-inf,softmax后权重做query mask,赋值0。

h = 8

WiQ, Wik, WiV : [d, d/h]

Q : [maxlen_q, d]

K = V : [maxlen_k, d]

Maxlen_q = maxlen_k so: Q = K = V : [maxlen1, d]

QWkQ,KWik,VWiV : [maxlen1, d/h]

headi : [maxlen1, d/h] * [d/h, maxlen1] * [maxlen1, d/h] = [maxlen1, d/h]

Wo : [d, d]

MultiHead(Q,K,V): [maxlen, d]Softmax([maxlen_q, maxlen_k]) 在最后一个维度即 maxlen_k 上做 softmax。

position-wise是因为处理的attention输出是某一个位置i的attention输出。

FFN(x) = ReLU ( xW1 + b1 ) * W2 + b2

ReLU(x) = max( 0, x )

dff = 4 * d = 2048

W1 : [d, dff]

W2 : [dff, d]流程:

Input -> dropout ->

(

multihead self-attention -> dropout -> residual connection -> LN ->

FFN-> dropout -> residual connection -> LN ->

) * 6

-> memory [batchsize,maxlen,d]代码中在multihead attention中对score做dropout,FFN后没有dropout,但文章说每个sublayer的output都有一个dropout。

大专栏 Transformer详解:各个特征维度分析推导"#Decoder-输入" class="headerlink" title="Decoder 输入">Decoder 输入

训练

目标句子首尾分别加上 <s> , </s>。

Decoder input = Output embedding + position encoding

Decoder input : [batchsize,maxlen2,d]预测

初始向量为<s>对应embedding,之后将前一步的输出拼接到当前的所有预测构成当前的decoder输入。

Decoder

Decoder由N = 6 个相同的layer组成,每个layer中有三个sublayer,分别是multihead self-attention, mutihead attention以及FFN。

decoder input -> dropout ->

(

Masked multihead self-attention(dec, dec, dec) = dec-> dropout ->

multihead attention(dec, memory, memory) -> dropout -> residual connection

-> LN -> FFN -> dropout -> residual connection -> LN ->

) * 6

-> dec -> linear -> softmaxSelf-attention 的mask为一个和dec相同维度的上三角全为-inf的矩阵。

Linear( x ) = xW

Dec : [batchsize,maxlen2,d]

W : [d, vocabsize]W为词汇表embedding矩阵的转置, 输入输出的词汇表embedding矩阵为W。即三个参数共享。

Linear( x ) : [batchsize,maxlen2,vocabsize]Softmax函数:

$pleft( k|x right)=frac{exp({{z}_{k}})}{sumnolimits_{i=1}^{K}{exp ({{z}_{i}})}}$

其中zi一般叫做 logits,即未被归一化的对数概率。

损失函数

损失函数:cross entropy。用p代表predicted probability,用q代表groundtruth。即:

$cross_entropy_loss=sumlimits_{k=1}^{K}{qleft( k|xright)log (pleft( k|x right))}$

groundtruth为one-hot,即每个样本只有惟一的类别,$q(k)={{delta}_{k,y}}$,y是真实类别。

${{delta }_{k,y}}text{=}left{begin{matrix} 1,k=y \0,kne y \end{matrix} right.$

对目标句子onehot 做labelmsmooth用$tilde{q}(k|x)$代替$q(k|x)$。(为了正则化,防止过拟合)

$tilde{q}(k|x)=(1-varepsilon ){{delta }_{k,y}}+varepsilon u(k)$

可以理解为,对于$q(k)={{delta}_{k,y}}$函数分布的真实标签,将它变成以如下方式获得:首先从标注的真实标签的$delta$分布中取定,然后以一定的概率$varepsilon$,将其替换为在$u(k)$分布中的随机变量。$u(k)$为均匀分布,即$u(k)=1/K$

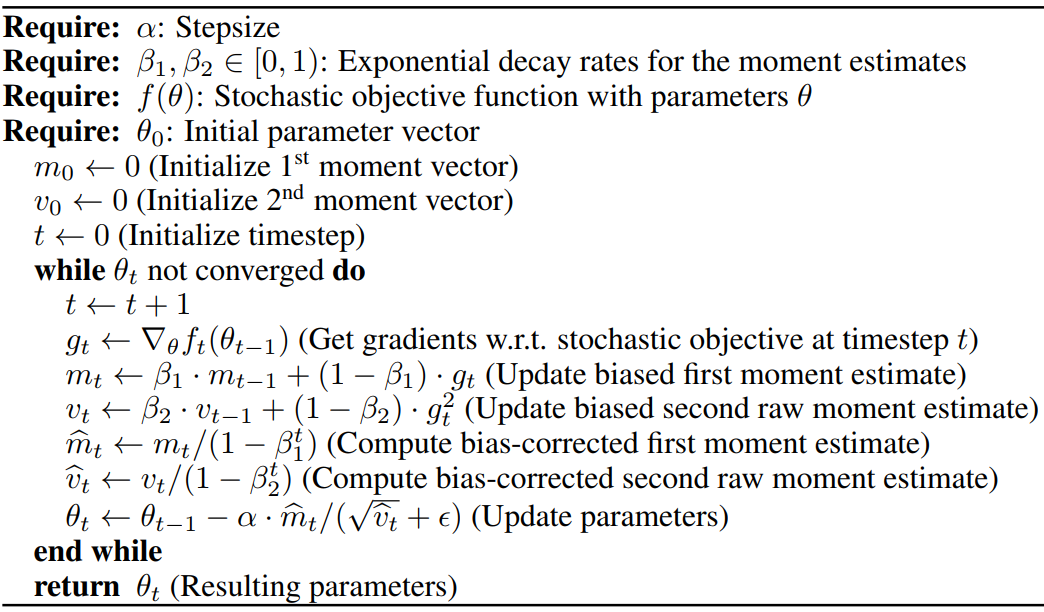

优化方法

Adam优化器:

学习率使用warm up learning rate:

learningrate = dmodel-0.5 * min ( step_num-0.5, step_num * warmup_steps-1.5 )

warmup_steps :4000Transformer详解:各个特征维度分析推导的更多相关文章

- Android应用AsyncTask处理机制详解及源码分析

1 背景 Android异步处理机制一直都是Android的一个核心,也是应用工程师面试的一个知识点.前面我们分析了Handler异步机制原理(不了解的可以阅读我的<Android异步消息处理机 ...

- Java SPI机制实战详解及源码分析

背景介绍 提起SPI机制,可能很多人不太熟悉,它是由JDK直接提供的,全称为:Service Provider Interface.而在平时的使用过程中也很少遇到,但如果你阅读一些框架的源码时,会发现 ...

- Spring Boot启动命令参数详解及源码分析

使用过Spring Boot,我们都知道通过java -jar可以快速启动Spring Boot项目.同时,也可以通过在执行jar -jar时传递参数来进行配置.本文带大家系统的了解一下Spring ...

- 【转载】Android应用AsyncTask处理机制详解及源码分析

[工匠若水 http://blog.csdn.net/yanbober 转载烦请注明出处,尊重分享成果] 1 背景 Android异步处理机制一直都是Android的一个核心,也是应用工程师面试的一个 ...

- 线程池底层原理详解与源码分析(补充部分---ScheduledThreadPoolExecutor类分析)

[1]前言 本篇幅是对 线程池底层原理详解与源码分析 的补充,默认你已经看完了上一篇对ThreadPoolExecutor类有了足够的了解. [2]ScheduledThreadPoolExecut ...

- Attention和Transformer详解

目录 Transformer引入 Encoder 详解 输入部分 Embedding 位置嵌入 注意力机制 人类的注意力机制 Attention 计算 多头 Attention 计算 残差及其作用 B ...

- SpringMVC异常处理机制详解[附带源码分析]

目录 前言 重要接口和类介绍 HandlerExceptionResolver接口 AbstractHandlerExceptionResolver抽象类 AbstractHandlerMethodE ...

- Linux 链接详解----静态链接实例分析

由Linux链接详解(1)中我们简单的分析了静态库的引用解析和重定位的内容, 下面我们结合实例来看一下静态链接重定位过程. /* * a.c */ ; void add(int c); int mai ...

- HTTP协议详解之http请求分析

当今web程序的开发技术真是百家争鸣,ASP.NET, PHP, JSP,Perl, AJAX 等等. 无论Web技术在未来如何发展,理解Web程序之间通信的基本协议相当重要, 因为它让我们理解了We ...

随机推荐

- 深度学习常用的数据源(MNIST,CIFAR,VOC2007系列数据)

MINIST手写数据集 压缩包版: http://yann.lecun.com/exdb/mnist/train-images-idx3-ubyte.gz http://yann.lecun.com/ ...

- DVWA-命令执行

开门见山 ·Low ·Medium ·High · 命令执行监听端口 ;mkfifo /tmp/pipe;sh /tmp/pipe | nc -nlp 4444 > /tmp/pipe nc 1 ...

- 微信支付的Demo

是在一个子项目完成的, 依赖: <dependencies> <!-- spring-boot--> <dependency> <groupId>org ...

- vue-router中参数传递

VUE路由之间携带参数 今天在实现一个功能的时候遇到的问题,一个把组件a中的值传输到组件b中时,但是组件a和组件b之间通信的时候路由跳转了 猜想:路由跳转导致监听事件失败,(暂时理解为:当路由跳转后监 ...

- Disruptor的简单介绍与应用

前言 最近工作比较忙,在工作项目中,看了很多人都自己实现了一套数据任务处理机制,个人感觉有点乱,且也方便他人的后续维护,所以想到了一种数据处理模式,即生产者.缓冲队列.消费者的模式来统一大家的实现逻辑 ...

- HDU - 4578 线段树+三重操作

这道题自己写了很久,还是没写出来,也看了很多题解,感觉多数还是看的迷迷糊糊,最后面看到一篇大佬的才感觉恍然大悟. 先上一篇大佬的题解:https://blog.csdn.net/aqa20372995 ...

- gulp自动化添加版本号并修改为参数格式

问题: 当我们修改js和css文件时往往需要清除浏览器的缓存,否则有些效果就看不到更新过后的. 通过对js,css文件内容进行hash运算,生成一个文件的唯一hash字符串(如果文件修改则hash号会 ...

- Linux图形界面与命令行界面切换

1.没有安装图形界面的Linux系统执行下面命令安装图形界面: yum groupinstall "GNOME Desktop" "Graphical Administr ...

- Nuxt.js学习(二) --- Nuxt目录结构详解、Nuxt常用配置项、Nuxt路由配置和参数传递

[TOC] 1.Nuxt目录结构详解 Nuxt项目文件目录结构 |-- .nuxt // Nuxt自动生成,临时的用于编辑的文件,build |-- assets // 用于组织未编译的静态资源入LE ...

- Python运维中常用的_脚本

前言 file是一个类,使用file('file_name', 'r+')这种方式打开文件,返回一个file对象,以写模式打开文件不存在则会被创建.但是更推荐使用内置函数open()来打开一个文件. ...