pytorch torch.nn.functional实现插值和上采样

interpolate

torch.nn.functional.interpolate(input, size=None, scale_factor=None, mode='nearest', align_corners=None)

根据给定的size或scale_factor参数来对输入进行下/上采样

使用的插值算法取决于参数mode的设置

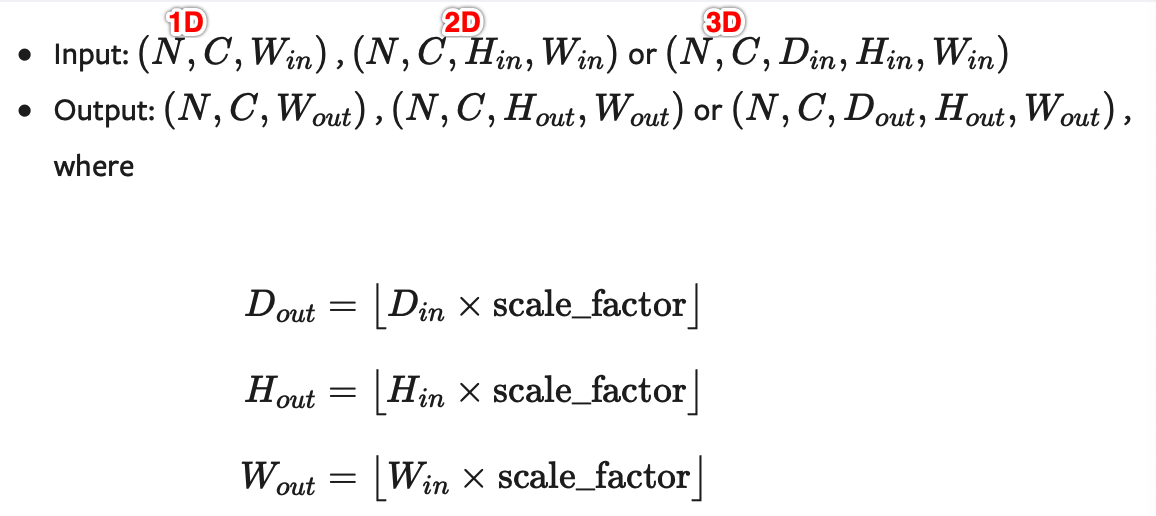

支持目前的temporal(1D, 如向量数据), spatial(2D, 如jpg、png等图像数据)和volumetric(3D, 如点云数据)类型的采样数据作为输入,输入数据的格式为minibatch x channels x [optional depth] x [optional height] x width,具体为:

- 对于一个temporal输入,期待着3D张量的输入,即minibatch x channels x width

- 对于一个空间spatial输入,期待着4D张量的输入,即minibatch x channels x height x width

- 对于体积volumetric输入,则期待着5D张量的输入,即minibatch x channels x depth x height x width

可用于重置大小的mode有:最近邻、线性(3D-only),、双线性, 双三次(bicubic,4D-only)和三线性(trilinear,5D-only)插值算法和area算法

参数:

input (Tensor) – 输入张量

size (int or Tuple[int] or Tuple[int, int] or Tuple[int, int, int]) –输出大小.

scale_factor (float or Tuple[float]) – 指定输出为输入的多少倍数。如果输入为tuple,其也要制定为tuple类型

mode (str) –

可使用的上采样算法,有'nearest','linear','bilinear','bicubic','trilinear'和'area'.默认使用'nearest'align_corners (bool, optional) –

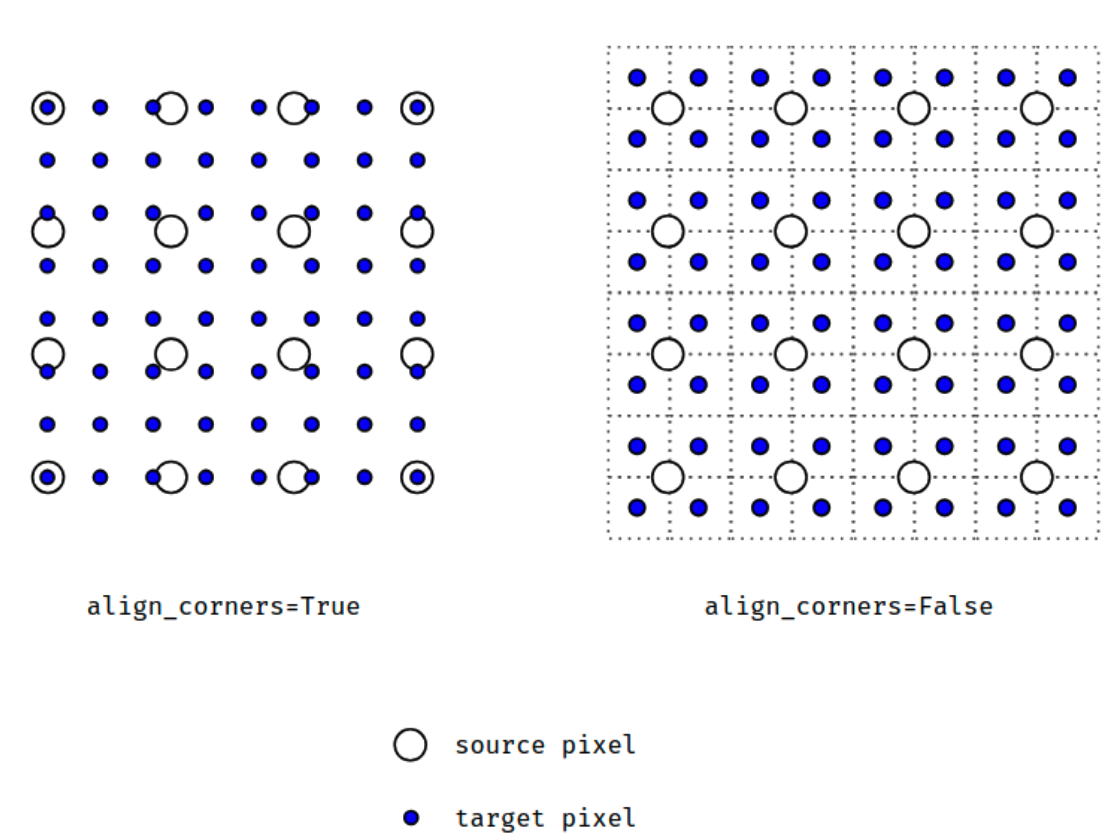

几何上,我们认为输入和输出的像素是正方形,而不是点。如果设置为True,则输入和输出张量由其角像素的中心点对齐,从而保留角像素处的值。如果设置为False,则输入和输出张量由它们的角像素的角点对齐,插值使用边界外值的边值填充;当scale_factor保持不变时,使该操作独立于输入大小。仅当使用的算法为'linear','bilinear', 'bilinear'or'trilinear'时可以使用。默认设置为False

注意:

使用mode='bicubic'时,可能会导致overshoot问题,即它可以为图像生成负值或大于255的值。如果你想在显示图像时减少overshoot问题,可以显式地调用result.clamp(min=0,max=255)。

When using the CUDA backend, this operation may induce nondeterministic behaviour in be backward that is not easily switched off. Please see the notes on Reproducibility for background.

警告:

当align_corners = True时,线性插值模式(线性、双线性、双三线性和三线性)不按比例对齐输出和输入像素,因此输出值可以依赖于输入的大小。这是0.3.1版本之前这些模式的默认行为。从那时起,默认行为是align_corners = False,如下图:

上面的图是source pixel为4*4上采样为target pixel为8*8的两种情况,这就是对齐和不对齐的差别,会对齐左上角元素,即设置为align_corners = True时输入的左上角元素是一定等于输出的左上角元素。但是有时align_corners = False时左上角元素也会相等,官网上给的例子就不太能说明两者的不同(也没有试出不同的例子,大家理解这个概念就行了)

举例:

import torch

from torch import nn

import torch.nn.functional as F

input = torch.arange(, , dtype=torch.float32).view(, , , )

input

返回:

tensor([[[[., .],

[., .]]]])

x = F.interpolate(input, scale_factor=, mode='nearest')

x

返回:

tensor([[[[., ., ., .],

[., ., ., .],

[., ., ., .],

[., ., ., .]]]])

x = F.interpolate(input, scale_factor=, mode='bilinear', align_corners=True)

x

返回:

tensor([[[[1.0000, 1.3333, 1.6667, 2.0000],

[1.6667, 2.0000, 2.3333, 2.6667],

[2.3333, 2.6667, 3.0000, 3.3333],

[3.0000, 3.3333, 3.6667, 4.0000]]]])

也提供了一些Upsample的方法:

upsample

torch.nn.functional.upsample(input, size=None, scale_factor=None, mode='nearest', align_corners=None)

torch.nn.functional.upsample_nearest(input, size=None, scale_factor=None)

torch.nn.functional.upsample_bilinear(input, size=None, scale_factor=None)

因为这些现在都建议使用上面的interpolate方法实现,所以就不解释了

更加复杂的例子可见:pytorch 不使用转置卷积来实现上采样

pytorch torch.nn.functional实现插值和上采样的更多相关文章

- PyTorch : torch.nn.xxx 和 torch.nn.functional.xxx

PyTorch : torch.nn.xxx 和 torch.nn.functional.xxx 在写 PyTorch 代码时,我们会发现一些功能重复的操作,比如卷积.激活.池化等操作.这些操作分别可 ...

- [pytorch笔记] torch.nn vs torch.nn.functional; model.eval() vs torch.no_grad(); nn.Sequential() vs nn.moduleList

1. torch.nn与torch.nn.functional之间的区别和联系 https://blog.csdn.net/GZHermit/article/details/78730856 nn和n ...

- Pytorch本人疑问(1) torch.nn和torch.nn.functional之间的区别

在写代码时发现我们在定义Model时,有两种定义方法: torch.nn.Conv2d()和torch.nn.functional.conv2d() 那么这两种方法到底有什么区别呢,我们通过下述代码看 ...

- torch.nn.functional中softmax的作用及其参数说明

参考:https://pytorch-cn.readthedocs.io/zh/latest/package_references/functional/#_1 class torch.nn.Soft ...

- 从 relu 的多种实现来看 torch.nn 与 torch.nn.functional 的区别与联系

从 relu 的多种实现来看 torch.nn 与 torch.nn.functional 的区别与联系 relu多种实现之间的关系 relu 函数在 pytorch 中总共有 3 次出现: torc ...

- pytorch torch.nn 实现上采样——nn.Upsample

Vision layers 1)Upsample CLASS torch.nn.Upsample(size=None, scale_factor=None, mode='nearest', align ...

- Pytorch——torch.nn.Sequential()详解

参考:官方文档 源码 官方文档 nn.Sequential A sequential container. Modules will be added to it in the order th ...

- PyTorch官方中文文档:torch.nn

torch.nn Parameters class torch.nn.Parameter() 艾伯特(http://www.aibbt.com/)国内第一家人工智能门户,微信公众号:aibbtcom ...

- 『PyTorch』第十二弹_nn.Module和nn.functional

大部分nn中的层class都有nn.function对应,其区别是: nn.Module实现的layer是由class Layer(nn.Module)定义的特殊类,会自动提取可学习参数nn.Para ...

随机推荐

- P2756 飞行员配对方案问题[二分图最大匹配]

题目描述 英国皇家空军从沦陷国征募了大量外籍飞行员.由皇家空军派出的每一架飞机都需要配备在航行技能和语言上能互相配合的2 名飞行员,其中1 名是英国飞行员,另1名是外籍飞行员.在众多的飞行员中,每一名 ...

- Django --- cookie与session,中间件

目录 1.cookie与session 1.cookie 2.session 2.中间件 1.中间件作用 2.用户可以自定义的五个方法 3.自定义中间件 1.cookie与session 1.cook ...

- 错误信息: The server cannot or will not process the request due to something that is perceived to be a client error

错误原因:在提交的表单中有 date 类型的数据,也就是不能传输日期类型的数据. 嗯!我知道,去吧!

- vundle 管理插件

前言:如果不使用vundle的话,进行插件的安装,配置和管理相对会麻烦,曾经没使用vundle的时候我经常遇到无法安装一些vim插件.但使用vundle后你只要在文件中添加一行你的插件名再安装就OK了 ...

- (19)打鸡儿教你Vue.js

了解vue2.x的核心技术 建立前端组件化的思想 常用的vue语法 vue-router,vuex,vue-cli 使用vue-cli工具 Vue框架常用知识点 vue核心技术 集成Vue 重点看,重 ...

- Vic-软件测试-开始软件测试

前言 大家好,我是 Vic,今天给大家带来开始软件测试的概述,希望你们喜欢 软件测试 软件测试的基本概念.方法.常用测试工具的使用 常用测试工具的使用性能自动化测试工具:jmeter.loadrunn ...

- mobx中的数组需要注意的地方

mobx中如果将数组作为可观察. 可以通过添加修饰符observable或者调用observable方法. 很多的时候, 我们将此修饰为可观察的对象后, 就随处可用了. 比如,采用 map forE ...

- warning insecure world writable dir ruby mode 040777,gem insstal sass error failed to build gem native extension

//1.删除原gem源 gem sources --remove https://rubygems.org/ //2.添加国内镜像 gem source -a https://gems.ruby-ch ...

- java连数据库和数据库连接池踩坑日记(一)-------oracle连接的一些问题

最近接触oracle有点多,同时也在配置数据库连接池,坑也就踩多了,记录下. 事情还没有结束,没时间记录问题,很多事情都忘了,过了国庆再写的话可能就真的全忘了吧……而且不单单是数据库问题,还有一些数据 ...

- js逆向笔记

1.nodejs运行js的时候 navigator如果找不到可以可设置为空对象 var navigator={}; 2.使用nodejs如果window对象找不到的时候 可以使用jsdom模块 3.顶 ...