重新发现梯度下降法--backtracking line search

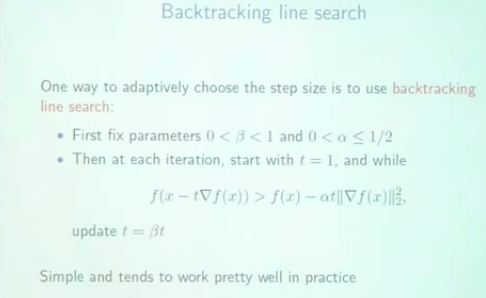

一直以为梯度下降很简单的,结果最近发现我写的一个梯度下降特别慢,后来终于找到原因:step size的选择很关键,有一种叫backtracking line search的梯度下降法就非常高效,该算法描述见下图:

下面用一个简单的例子来展示,给一个无约束优化问题:

minimize y = (x-3)*(x-3)

下面是python代码,比较两种方法

# -*- coding: cp936 -*-

#optimization test, y = (x-3)^2

from matplotlib.pyplot import figure, hold, plot, show, xlabel, ylabel, legend

def f(x):

"The function we want to minimize"

return (x-3)**2

def f_grad(x):

"gradient of function f"

return 2*(x-3)

x = 0

y = f(x)

err = 1.0

maxIter = 300

curve = [y]

it = 0

step = 0.1

#下面展示的是我之前用的方法,看上去貌似还挺合理的,但是很慢

while err > 1e-4 and it < maxIter:

it += 1

gradient = f_grad(x)

new_x = x - gradient * step

new_y = f(new_x)

new_err = abs(new_y - y)

if new_y > y: #如果出现divergence的迹象,就减小step size

step *= 0.8

err, x, y = new_err, new_x, new_y

print 'err:', err, ', y:', y

curve.append(y) print 'iterations: ', it

figure(); hold(True); plot(curve, 'r*-')

xlabel('iterations'); ylabel('objective function value') #下面展示的是backtracking line search,速度很快

x = 0

y = f(x)

err = 1.0

alpha = 0.25

beta = 0.8

curve2 = [y]

it = 0 while err > 1e-4 and it < maxIter:

it += 1

gradient = f_grad(x)

step = 1.0

while f(x - step * gradient) > y - alpha * step * gradient**2:

step *= beta

x = x - step * gradient

new_y = f(x)

err = y - new_y

y = new_y

print 'err:', err, ', y:', y

curve2.append(y) print 'iterations: ', it

plot(curve2, 'bo-')

legend(['gradient descent I used', 'backtracking line search'])

show()

运行结果如下图:

孰优孰劣,一目了然

我的方法用了25次迭代,而backtracking line search只用了6次。(而且之前我用的方法不一定会收敛的,比如你把第一种方法的stepsize改成1,就会发现,没有收敛到最优解就停止了,这是一个bug,要注意)

这只是个toy example,在我真实使用的优化问题上,两者的效率差别更加显著,估计有10倍的样子

--

文章中截图来自:https://www.youtube.com/watch?v=nvZF-t2ltSM

(是cmu的优化课程)

重新发现梯度下降法--backtracking line search的更多相关文章

- Backtracking line search的理解

使用梯度下降方法求解凸优化问题的时候,会遇到一个问题,选择什么样的梯度下降步长才合适. 假设优化函数为,若每次梯度下降的步长都固定,则可能出现左图所示的情况,无法收敛.若每次步长都很小,则下降速度非常 ...

- 【原创】回溯线搜索 Backtracking line search

机器学习中很多数值优化算法都会用到线搜索(line search).线搜索的目的是在搜索方向上找到是目标函数\(f(x)\)最小的点.然而,精确找到最小点比较耗时,由于搜索方向本来就是近似,所以用较小 ...

- Line Search and Quasi-Newton Methods 线性搜索与拟牛顿法

Gradient Descent 机器学习中很多模型的参数估计都要用到优化算法,梯度下降是其中最简单也用得最多的优化算法之一.梯度下降(Gradient Descent)[3]也被称之为最快梯度(St ...

- Line Search and Quasi-Newton Methods

Gradient Descent 机器学习中很多模型的参数估计都要用到优化算法,梯度下降是其中最简单也用得最多的优化算法之一.梯度下降(Gradient Descent)[3]也被称之为最快梯度(St ...

- 线搜索(line search)方法

在机器学习中, 通常需要求某个函数的最值(比如最大似然中需要求的似然的最大值). 线搜索(line search)是求得一个函数\(f(x)\)的最值的两种常用迭代方法之一(另外一个是trust re ...

- 机器学习基础——梯度下降法(Gradient Descent)

机器学习基础--梯度下降法(Gradient Descent) 看了coursea的机器学习课,知道了梯度下降法.一开始只是对其做了下简单的了解.随着内容的深入,发现梯度下降法在很多算法中都用的到,除 ...

- line search中的重要定理 - 梯度与方向的点积为零

转载请注明出处:http://www.codelast.com/ 对精确的line search(线搜索),有一个重要的定理: ∇f(xk+αkdk)Tdk=0 这个定理表明,当前点在dk方向上移动到 ...

- 『科学计算_理论』优化算法:梯度下降法&牛顿法

梯度下降法 梯度下降法用来求解目标函数的极值.这个极值是给定模型给定数据之后在参数空间中搜索找到的.迭代过程为: 可以看出,梯度下降法更新参数的方式为目标函数在当前参数取值下的梯度值,前面再加上一个步 ...

- [DeeplearningAI笔记]改善深层神经网络_优化算法2.1_2.2_mini-batch梯度下降法

觉得有用的话,欢迎一起讨论相互学习~Follow Me 2.1 mini-batch gradient descent mini-batch梯度下降法 我们将训练数据组合到一个大的矩阵中 \(X=\b ...

随机推荐

- [ACM_水题] 不要62(hdu oj 2089, 不含62和4的数字统计)

Problem Description 杭州人称那些傻乎乎粘嗒嗒的人为62(音:laoer).杭州交通管理局经常会扩充一些的士车牌照,新近出来一个好消息,以后上牌照,不再含有不吉利的数字了,这样一来, ...

- java.nio.BufferOverflowException. Check the Eclipse log for stack trace.

这个错误错了几次,必须做个标记 解决方法非常的简单: 最新的19版本会在你的项目下建立一个依赖包 Android Dependencies,在eclipse中右键这个文件夹,在Build Path选项 ...

- 在Mac OS上安装Vagrant和Docker的教程

转载于:http://www.itxuexiwang.com/a/shujukujishu/redis/2016/0216/128.html?1455808640 当听到很多人在说Docker是多么多 ...

- atitit.提升软件开发的效率and 质量的那些强大概念and方法总结

atitit.提升软件开发的效率and 质量的那些强大概念and方法总结 1. 主流编程中三个最糟糕的问题 1 1.1. 从理解问题后到实现的时间很长 1 1.2. 理解和维护代码 2 1.3. 学 ...

- Tamper Data

一款可以修改表单的火狐浏览器插件

- 炜煌T3POS58微打参数设置方法

本文用菊子曰发布

- 在ArcGIS空间数据库中增加点数据的方法

1.新建一个mxd(ArcMAP)文件 2.从ArcCatalog中把要编辑的图层拖到ArcMAP中 3.从ArcCatalog中拖一个参照图层到ArcMAP中,比如临沂市的县级区划图 4.打开Edi ...

- android: 通过内容提供器读取系统联系人

读取系统联系人 由于我们之前一直使用的都是模拟器,电话簿里面并没有联系人存在,所以现在需要自 己手动添加几个,以便稍后进行读取.打开电话簿程序,界面如图 7.1 所示. 图 7.1 可以看到,目前 ...

- lampp 在linux ubuntu下自动开机启动

lampp 在linux ubuntu下自动开机启动 lampp在linux下是不会自动启动的.需要手工处理.如下: 假如,你的lampp安装在 /opt/lampp 目录下,那么可以如下处理: 1. ...

- Radio Basics for RFID

Radio Basics for RFID The following is excerpted from Chapter 3: Radio Basics for UHF RFID from the ...