python 爬虫之beautifulsoup(bs4)环境准备

环境准备: bs4安装方法:https://blog.csdn.net/Bibabu135766/article/details/81662981

requests安装方法:https://blog.csdn.net/douguangyao/article/details/77922973 https://pypi.org/project/requests/#files 卸载pip:python -m pip uninstall pip 安装pip:https://pypi.python.org/pypi/pip#downloads

bs4用法介绍:Beautiful Soup和 lxml 一样, 也是一个HTML/XML的解析器,主要的功能也是如何解析和提取 HTML/XML 数据。

https://www.cnblogs.com/amou/p/9184614.html

https://beautifulsoup.readthedocs.io/zh_CN/latest/

#!/usr/bin/env python

# -*- coding:utf- -*-

from bs4 import BeautifulSoup html = '''

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title" name="dromouse"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1"><!-- Elsie --></a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

'''

#创建Beautiful Soup 对象

soup = BeautifulSoup(html,'lxml')

print soup,"--------------------------------"

# #格式化输出soup对象的内容

# print soup.prettify() #四大对象种类 Tag、NavigableString、BeautifulSoup、Comment

#一、Tag通俗点讲就是 HTML 中的一个个标签

# print soup.html

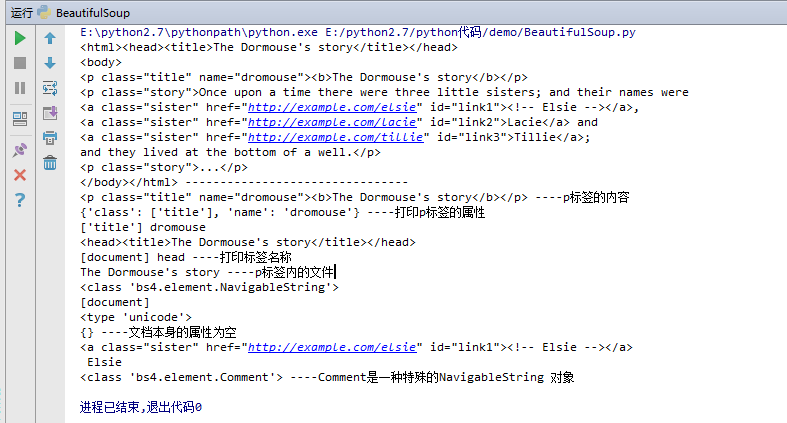

print soup.p,'----p标签的内容'

print soup.p.attrs,'----打印p标签的属性'

print soup.p['class'],soup.p['name']

print soup.head

print soup.name,soup.head.name,'----打印标签名称'

#二、NavigableString 要想获取标签内部的文字怎么办呢?很简单,用 .string 即可

print soup.p.string,'----p标签内的文字'

print type(soup.p.string)

#三、BeautifulSoup 对象表示的是一个文档的内容。大部分时候,可以把它当作 Tag 对象,是一个特殊的 Tag,我们可以分别获取它的类型,名称,以及属性

print soup.name

print type(soup.name)

print soup.attrs,'----文档本身的属性为空'

#四、Comment 对象是一个特殊类型的 NavigableString 对象,其输出的内容不包括注释符号。

print soup.a

print soup.a.string

print type(soup.a.string),'----Comment是一种特殊的NavigableString 对象'

打印结果如下:

BeautifulSoup4查找、正则使用:

#!/usr/bin/env python

# -*- coding:utf- -*-

from bs4 import BeautifulSoup

import resoup = BeautifulSoup(html,'lxml')

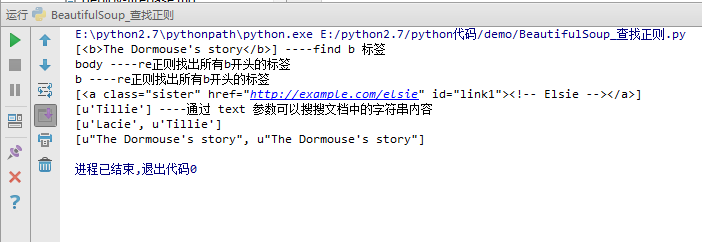

#print soup,'------------html文档--------------' print soup.find_all('b'),'----find b 标签'

for tag in soup.find_all(re.compile('^b')):

print tag.name,'----re正则找出所有b开头的标签'

print soup.find_all(id='link1')

print soup.find_all(text='Tillie'),'----通过 text 参数可以搜搜文档中的字符串内容'

print soup.find_all(text=["Tillie",'Lacie'])

print soup.find_all(text=re.compile('Dormouse'))

打印结果如下:

-----------------------------------------------------------------------------------------------------------------------------------------------------------------

requests用法介绍:

http://docs.python-requests.org/zh_CN/latest/user/quickstart.html

https://cuiqingcai.com/2556.html

python 爬虫之beautifulsoup(bs4)环境准备的更多相关文章

- 使用Python爬虫库BeautifulSoup遍历文档树并对标签进行操作详解(新手必学)

为大家介绍下Python爬虫库BeautifulSoup遍历文档树并对标签进行操作的详细方法与函数下面就是使用Python爬虫库BeautifulSoup对文档树进行遍历并对标签进行操作的实例,都是最 ...

- Python爬虫——用BeautifulSoup、python-docx爬取廖雪峰大大的教程为word文档

版权声明:本文为博主原创文章,欢迎转载,并请注明出处.联系方式:460356155@qq.com 廖雪峰大大贡献的教程写的不错,写了个爬虫把教程保存为word文件,供大家方便下载学习:http://p ...

- 【Python爬虫】BeautifulSoup网页解析库

BeautifulSoup 网页解析库 阅读目录 初识Beautiful Soup Beautiful Soup库的4种解析器 Beautiful Soup类的基本元素 基本使用 标签选择器 节点操作 ...

- Python爬虫之BeautifulSoup的用法

之前看静觅博客,关于BeautifulSoup的用法不太熟练,所以趁机在网上搜索相关的视频,其中一个讲的还是挺清楚的:python爬虫小白入门之BeautifulSoup库,有空做了一下笔记: 一.爬 ...

- python爬虫入门--beautifulsoup

1,beautifulsoup的中文文档:https://www.crummy.com/software/BeautifulSoup/bs4/doc.zh/ 2, from bs4 import Be ...

- python爬虫之Beautifulsoup学习笔记

相关内容: 什么是beautifulsoup bs4的使用 导入模块 选择使用解析器 使用标签名查找 使用find\find_all查找 使用select查找 首发时间:2018-03-02 00:1 ...

- Python爬虫系列-BeautifulSoup详解

安装 pip3 install beautifulsoup4 解析库 解析器 使用方法 优势 劣势 Python标准库 BeautifulSoup(markup,'html,parser') Pyth ...

- Python爬虫实践~BeautifulSoup+urllib+Flask实现静态网页的爬取

爬取的网站类型: 论坛类网站类型 涉及主要的第三方模块: BeautifulSoup:解析.遍历页面 urllib:处理URL请求 Flask:简易的WEB框架 介绍: 本次主要使用urllib获取网 ...

- Python爬虫之Beautifulsoup模块的使用

一 Beautifulsoup模块介绍 Beautiful Soup 是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式.Be ...

随机推荐

- 使用Python的列表推导式计算笛卡儿积

笛卡儿积: 笛卡儿积是一个列表, 列表里的元素是由输入的可迭代类型的元素对构 成的元组,因此笛卡儿积列表的长度等于输入变量的长度的乘积, 如下图: 如果你需要一个列表,列表里是 3 种不同尺寸的 T ...

- 高版本Sqlserver数据库导入低版本Sqlserver

今天想跑一个关于java网站的demo,结果在附加数据库项这一块出现问题,例程的数据库用的是sqlserver2014,而我的是2008,添加数据库出现错误.经过一番查找,也找到某人写的一些博客上的解 ...

- ibm z14大型主机介绍

IBM z14™大型主机 (z14)被设计为数字经济中值得信任的基础架构.它提供 特性和功能以满足对于新服务和更佳客户体验的需求,同时保护日益 增长的数据量,并遵从日益复杂的法规.IBM z14 ...

- 【实战代码】PHP实现读取一个1G的文件大小

本文地址:http://www.cnblogs.com/aiweixiao/p/7535351.html 欢迎关注我的微信公众号哈 “ 程序员的文娱情怀” http://t.cn/RotyZtu [背 ...

- centos7源码包安装Mongodb,并设置开机自启动

1.下载源码包 curl -O https://fastdl.mongodb.org/linux/mongodb-linux-x86_64-3.2.12.tgz 2.解压 放到 /usr/local/ ...

- HBase Client JAVA API

旧 的 HBase 接口逻辑与传统 JDBC 方式很不相同,新的接口与传统 JDBC 的逻辑更加相像,具有更加清晰的 Connection 管理方式. 同时,在旧的接口中,客户端何时将 Put 写到服 ...

- IDEA 相关整理

插件部分 Lombok 日志不定义

- web框架开发-Django用户认证组件

可以用认证组件做什么 针对session的缺陷, 跟新数据时,不跟新key键, 用户认证组件是删除后再重建 用户认证组件很多功能可以直接使用 利用用户认证表(auth_user,通过Django自己创 ...

- 纯代码系列:Python实现验证码图片(PIL库经典用法用法,爬虫12306思路)

现在的网页中,为了防止机器人提交表单,图片验证码是很常见的应对手段之一.这里就不详细介绍了,相信大家都遇到过. 现在就给出用Python的PIL库实现验证码图片的代码.代码中有详细注释. #!/usr ...

- JVM-高效并发

Java内存模型与线程: Java内存模型的目的是定义程序中各个变量的访问规则,此处的变量包括实例字段.静态字段和构成数组对象的元素,但不包括局部变量和方法参数,因为后者是线程私有的. Java内存模 ...