spark集群

https://blog.csdn.net/boling_cavalry/article/details/86747258

https://www.cnblogs.com/xuliangxing/p/7234014.html

第二个链接较为详细,但版本较旧

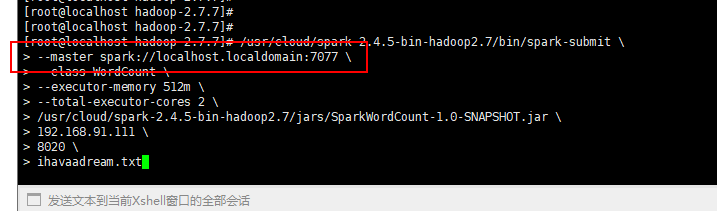

注意spark 7077端口URL,如果hostname没配置正确,spark-submit会报错

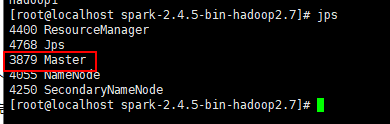

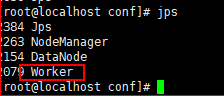

jps看了两个slaves是有worker进程的。

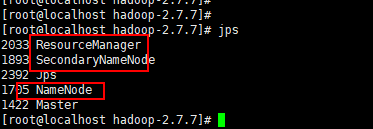

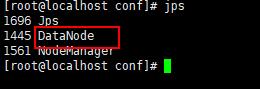

spark安装完毕,启动hadoop集群:./sbin/./start-all.sh

jps可查看

spark提交任务的三种的方法

https://www.cnblogs.com/itboys/p/9998666.html

虚拟机分配内存不足,解决方案参考:https://blog.csdn.net/u012848709/article/details/85425249

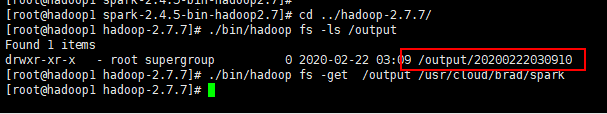

最后终于跑完了,把输出结果get下来

在master输入以下命令,最后三项为入参,9000为hadoop端口:

/usr/cloud/spark-2.4.5-bin-hadoop2.7/bin/spark-submit \

--master spark://192.168.91.111:7077 \

--class WordCount \

--executor-memory 512m \

--total-executor-cores 2 \

/usr/cloud/spark-2.4.5-bin-hadoop2.7/jars/SparkWordCount-1.0-SNAPSHOT.jar \

192.168.91.111 \

9000 \

ihavaadream.txt

=====================WordCount代码如下:======================

import org.apache.commons.lang3.StringUtils;

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaPairRDD;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import scala.Tuple2; import java.text.SimpleDateFormat;

import java.util.Arrays;

import java.util.Date;

import java.util.List; public class WordCount { private static final Logger logger = LoggerFactory.getLogger(WordCount.class); public static void main(String[] args) {

if(null==args

|| args.length<3

|| StringUtils.isEmpty(args[0])

|| StringUtils.isEmpty(args[1])

|| StringUtils.isEmpty(args[2])) {

logger.error("invalid params!");

} String hdfsHost = args[0];

String hdfsPort = args[1];

String textFileName = args[2]; SparkConf sparkConf = new SparkConf().setAppName("Spark WordCount Application (java)"); JavaSparkContext javaSparkContext = new JavaSparkContext(sparkConf); String hdfsBasePath = "hdfs://" + hdfsHost + ":" + hdfsPort;

//文本文件的hdfs路径

String inputPath = hdfsBasePath + "/input/" + textFileName; //输出结果文件的hdfs路径

String outputPath = hdfsBasePath + "/output/"

+ new SimpleDateFormat("yyyyMMddHHmmss").format(new Date()); logger.info("input path : {}", inputPath);

logger.info("output path : {}", outputPath); logger.info("import text");

//导入文件

JavaRDD<String> textFile = javaSparkContext.textFile(inputPath); logger.info("do map operation");

JavaPairRDD<String, Integer> counts = textFile

//每一行都分割成单词,返回后组成一个大集合

.flatMap(s -> Arrays.asList(s.split(" ")).iterator())

//key是单词,value是1

.mapToPair(word -> new Tuple2<>(word, 1))

//基于key进行reduce,逻辑是将value累加

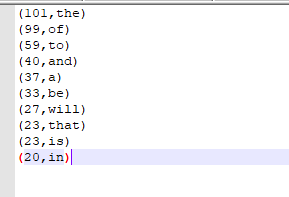

.reduceByKey((a, b) -> a + b); logger.info("do convert");

//先将key和value倒过来,再按照key排序

JavaPairRDD<Integer, String> sorts = counts

//key和value颠倒,生成新的map

.mapToPair(tuple2 -> new Tuple2<>(tuple2._2(), tuple2._1()))

//按照key倒排序

.sortByKey(false); // logger.info("take top 10");

//取前10个

List<Tuple2<Integer, String>> top10 = sorts.collect();

// List<Tuple2<Integer, String>> top10 = sorts.take(10); StringBuilder sbud = new StringBuilder("top 10 word :\n"); //打印出来

for(Tuple2<Integer, String> tuple2 : top10){

sbud.append(tuple2._2())

.append("\t")

.append(tuple2._1())

.append("\n");

} logger.info(sbud.toString()); logger.info("merge and save as file");

//分区合并成一个,再导出为一个txt保存在hdfs

javaSparkContext.parallelize(top10).coalesce(1).saveAsTextFile(outputPath); logger.info("close context");

//关闭context

javaSparkContext.close();

}

}

done!

spark集群的更多相关文章

- (四)Spark集群搭建-Java&Python版Spark

Spark集群搭建 视频教程 1.优酷 2.YouTube 安装scala环境 下载地址http://www.scala-lang.org/download/ 上传scala-2.10.5.tgz到m ...

- [bigdata] spark集群安装及测试

在spark安装之前,应该已经安装了hadoop原生版或者cdh,因为spark基本要基于hdfs来进行计算. 1. 下载 spark: http://mirrors.cnnic.cn/apache ...

- Spark集群部署

Spark是通用的基于内存计算的大数据框架,可以和hadoop生态系统很好的兼容,以下来部署Spark集群 集群环境:3节点 Master:bigdata1 Slaves:bigdata2,bigda ...

- Spark集群 + Akka + Kafka + Scala 开发(3) : 开发一个Akka + Spark的应用

前言 在Spark集群 + Akka + Kafka + Scala 开发(1) : 配置开发环境中,我们已经部署好了一个Spark的开发环境. 在Spark集群 + Akka + Kafka + S ...

- Spark集群 + Akka + Kafka + Scala 开发(2) : 开发一个Spark应用

前言 在Spark集群 + Akka + Kafka + Scala 开发(1) : 配置开发环境,我们已经部署好了一个Spark的开发环境. 本文的目标是写一个Spark应用,并可以在集群中测试. ...

- Spark集群 + Akka + Kafka + Scala 开发(1) : 配置开发环境

目标 配置一个spark standalone集群 + akka + kafka + scala的开发环境. 创建一个基于spark的scala工程,并在spark standalone的集群环境中运 ...

- Hadoop+Spark:集群环境搭建

环境准备: 在虚拟机下,大家三台Linux ubuntu 14.04 server x64 系统(下载地址:http://releases.ubuntu.com/14.04.2/ubuntu-14.0 ...

- Spark 个人实战系列(1)--Spark 集群安装

前言: CDH4不带yarn和spark, 因此需要自己搭建spark集群. 这边简单描述spark集群的安装过程, 并讲述spark的standalone模式, 以及对相关的脚本进行简单的分析. s ...

- Spark集群 + Akka + Kafka + Scala 开发(4) : 开发一个Kafka + Spark的应用

前言 在Spark集群 + Akka + Kafka + Scala 开发(1) : 配置开发环境中,我们已经部署好了一个Spark的开发环境. 在Spark集群 + Akka + Kafka + S ...

- 实验室中搭建Spark集群和PyCUDA开发环境

1.安装CUDA 1.1安装前工作 1.1.1选取实验器材 实验中的每台计算机均装有双系统.选择其中一台计算机作为master节点,配置有GeForce GTX 650显卡,拥有384个CUDA核心. ...

随机推荐

- systemctl中添加mysql服务

由于mysql的版本更新,许多术语有了新含义,所以需要特别指出,mysqld.service 等价于mysqld vim /usr/lib/systemd/system/mysqld.service ...

- kvm实现快速增量盘模式的克隆脚本

转自:http://zxlwz.blog.51cto.com/6952946/1852424 要求:备份的img磁盘格式只有qcow2格式支持增量盘使用和快照功能当你的一个虚拟机格式是raw格式时,请 ...

- c++IO对象不可复制

IO类型的3个独立的头文件: iostream定义读写控制窗口的类型, fstream 定义读写已命名文件的类型, (包含fstream类) sstream定义读写存储在内存中 ...

- 使用Java注解实现简单的依赖注入

代码如下: /** * 注入的注解,为空,仅起标志作用 */ @Target({ElementType.FIELD}) @Retention(RetentionPolicy.RUNTIME) @int ...

- CI框架扩展自定义控制器的方法

扩展CI中的控制器 有时需要对CI中的控制器作统一操作,如进行登录和权限验证,这时就可以通过扩展CI控制器来实现. 扩展CI控制器只需要在application/core文件夹中建一个继承自CI_Co ...

- 2020-02-19Linux学习日记,第一天

今天是2020-02-19第一次写博客.每天更新学习Linux的一些笔记. 主要是为了方便日后自己复习,也是为了督促自己学习.记录自己的学习轨迹! -------------------------- ...

- UNIX读书笔记----UNIX基础知识

UNIX体系结构: 从严格意义上讲,可将操作系统定义为一种软件,它控制计算机硬件资源,提供程序运行环境.我们通常将这种软件称为内核(Kernel),因为他相对较小,而且位于环境的核心.图片显示了UNI ...

- How to Convert a Class File to a Java File?

What is a programming language? Before introducing compilation and decompilation, let's briefly intr ...

- Python - 文件读取read()、readline()、readlines()区别

前言 读取文件的三个方法:read().readline().readlines().均可接受一个方法参数用以限制每次读取的数据量,但通常不使用 read() 优点:读取整个文件,将文件内容放到一个字 ...

- pytorch之 compare with numpy

import torch import numpy as np # details about math operation in torch can be found in: http://pyto ...