基于spark和sparkstreaming的word2vec

概述

Word2vec是一款由谷歌发布开源的自然语言处理算法,其目的是把words转换成vectors,从而可以用数学的方法来分析words之间的关系。Spark其该算法进行了封装,并在mllib中实现。

整体流程是spark离线训练模型,可以是1小时1训练也可以1天1训练,根据具体业务来判断,sparkstreaming在线分析。

由于历史问题,spark还在用1.5.0,接口上和2.1还是有点区别,大概看了下文档,流程上差不多

spark离线训练

如下代码,通过word2vec训练出一个模型,并且找出“导弹”的10个近义词

val input = sc.textFile("word2vec.txt").map(line => line.split(" ").toSeq)

val word2vec = new Word2Vec()

word2vec.setMinCount(1)

word2vec.setNumPartitions(1)

word2vec.setNumIterations(1)

val model = word2vec.fit(input)

val synonyms = model.findSynonyms("导弹", 10)

for((synonym, cosineSimilarity) <- synonyms) {

println(s"$synonym $cosineSimilarity")

}

model.save(sc,"myModelPath")

参数解释

|

参数 |

默认 |

解释 |

|

vectorSize |

100 |

向量的维度,一般维度不会太大,通常在100-500 |

|

learningRate |

0.025 |

Sets initial learning rate |

|

numPartitions |

1 |

分区个数,设置多个可以提高计算效率,但会少量的numpartitions有利于精确度 |

|

numIterations |

1 |

迭代次数,应该小于等于numPartitions |

经过粗略的测试,适当提高numPartition可以加快word2vec的计算速度

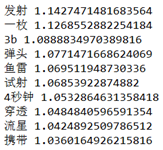

测试结果

每次测试的结果都有点不同,大致差不多

这里说明一点,结果中第一个字段是word,第二个字段是余弦相似度,由于sparkmllib考虑到计算效率,没有用完成的余弦相似度公式,所以结果会大于1,但这并不影响相似度的判断

测试数据下载地址,数据集为搜狗语料分类中的军事篇

http://files.cnblogs.com/files/ulysses-you/word2vec.zip

sparkstreaming在线分析

这个demo用了socket接口(这样测试是最方便的..),实现了在线对word2vec模型的调用

val model = Word2VecModel.load(ssc.sparkContext, "myModelPath")

val lines = ssc.socketTextStream("localhost",9999)

// Split each line into words

val words = lines.flatMap(_.split(" "))

// Count each word in each batch

words.map{word =>

val synonyms = model.findSynonyms(word,10)

for((synonym, cosineSimilarity) <- synonyms) {

println(s"syn => $synonym $cosineSimilarity")

}

}

参考资料

//numPartitions和numIterations数量的相似问题

//官方1.5.0版本的word2vec介绍

http://spark.apache.org/docs/1.5.0/mllib-feature-extraction.html#word2vec

基于spark和sparkstreaming的word2vec的更多相关文章

- 基于Spark和SparkSQL的NetFlow流量的初步分析——scala语言

基于Spark和SparkSQL的NetFlow流量的初步分析--scala语言 标签: NetFlow Spark SparkSQL 本文主要是介绍如何使用Spark做一些简单的NetFlow数据的 ...

- 基于Spark Mllib的文本分类

基于Spark Mllib的文本分类 文本分类是一个典型的机器学习问题,其主要目标是通过对已有语料库文本数据训练得到分类模型,进而对新文本进行类别标签的预测.这在很多领域都有现实的应用场景,如新闻网站 ...

- 基于HDFS的SparkStreaming案例实战和内幕源码解密

一:Spark集群开发环境准备 启动HDFS,如下图所示: 通过web端查看节点正常启动,如下图所示: 2.启动Spark集群,如下图所示: 通过web端查看集群启动正常,如下图所示: 3.启动sta ...

- 基于Spark的电影推荐系统(推荐系统~7)

基于Spark的电影推荐系统(推荐系统~7) 22/100 发布文章 liuge36 第四部分-推荐系统-实时推荐 本模块基于第4节得到的模型,开始为用户做实时推荐,推荐用户最有可能喜爱的5部电影. ...

- 基于Spark的电影推荐系统(推荐系统~1)

第四部分-推荐系统-项目介绍 行业背景: 快速:Apache Spark以内存计算为核心 通用 :一站式解决各个问题,ADHOC SQL查询,流计算,数据挖掘,图计算 完整的生态圈 只要掌握Spark ...

- 基于spark邮件自动分类

代码放在github上:click me 一.数据说明 数据集为英文语料集,一共包含20种类别的邮件,除了类别soc.religion.christian的邮件数为997以外每个类别的邮件数都是100 ...

- 基于Spark ALS构建商品推荐引擎

基于Spark ALS构建商品推荐引擎 一般来讲,推荐引擎试图对用户与某类物品之间的联系建模,其想法是预测人们可能喜好的物品并通过探索物品之间的联系来辅助这个过程,让用户能更快速.更准确的获得所需 ...

- 【基于spark IM 的二次开发笔记】第一天 各种配置

[基于spark IM 的二次开发笔记]第一天 各种配置 http://juforg.iteye.com/blog/1870487 http://www.igniterealtime.org/down ...

- 大数据实时处理-基于Spark的大数据实时处理及应用技术培训

随着互联网.移动互联网和物联网的发展,我们已经切实地迎来了一个大数据 的时代.大数据是指无法在一定时间内用常规软件工具对其内容进行抓取.管理和处理的数据集合,对大数据的分析已经成为一个非常重要且紧迫的 ...

随机推荐

- React Native 可以走多远?

对于大多数APP开发者来说,能够同时开发出Android APP和IOS APP是不是很牛逼,可是它也不是天方夜谭,自从有了一个叫React Native的东西的出现,这一切就变得可以实现了. 那么到 ...

- iOS 按钮连续提交执行一次(如留言提交,多次拍照问题)

在很多项目中暴力测试时会出现多次点击执行一个方法 可以用下面的语句进行解决 //先将未到时间执行前的任务取消. [[self class] cancelPreviousPerformRequests ...

- C++ 拷贝控制和资源管理,智能指针的简单实现

C++ 关于拷贝控制和资源管理部分的笔记,并且介绍了部分C++ 智能指针的概念,然后实现了一个基于引用计数的智能指针.关于C++智能指针部分,后面会有专门的研究. 通常,管理类外资源的类必须定义拷贝控 ...

- [SinGuLaRiTy] 米勒罗宾素数判定法

[SinGuLaRiTy-1003] Copyright (c) SinGuLaRiTy 2017. All Rights Reserved. 背景 数论学家利用费马小定理研究出了多种素数测试办法,M ...

- laravel资源路由详解

大概挑两条解释. 我定义了个资源路由Route::resource('article', 'ArticleController');. 当我访问地址ArticleController的http://y ...

- win8如何显示文件后缀名

按快捷键[WIN+X]然后点击[文件资源管理器] 进入我的电脑后点击菜单栏的[查看] 查看下面有一个[文件扩展名]把前面那个勾,勾上就可以显示后缀名了. 同样的道理取消勾就是隐藏后缀名. ...

- C++实现的控制台-贪吃蛇

周六终于可以抽出一整段时间了 想了想就写个贪吃蛇吧 第一次写 差不多下了140行 也不算太多吧 以后ACM比赛是在做不来就自己打个贪吃蛇玩 ps:本来想写个项目的 但是为了方便你们阅读 就写在 ...

- python入门编程之基础

Python, 是一种面向对象.解释型计算机程序设计语言.Python语法简洁清晰,特色之一是强制用空白符作为语句缩进.Python的设计哲学是"优雅"."明确" ...

- HTML、CSS、JS 样式

把一个数组(一维或二维等)的内容转化为对应的字符串.相当于把print_r($array)显示出来的内容赋值给一个变量.$data= array('hello',',','world','!'); $ ...

- STM32F4XX与STM32F0XX编程差别

//普通管脚初始化 /*****************************************************************************STM32F0***** ...