Hadoop生态圈-HBase的HFile创建方式

Hadoop生态圈-HBase的HFile创建方式

作者:尹正杰

版权声明:原创作品,谢绝转载!否则将追究法律责任。

废话不多说,直接上代码,想说的话都在代码的注释里面。

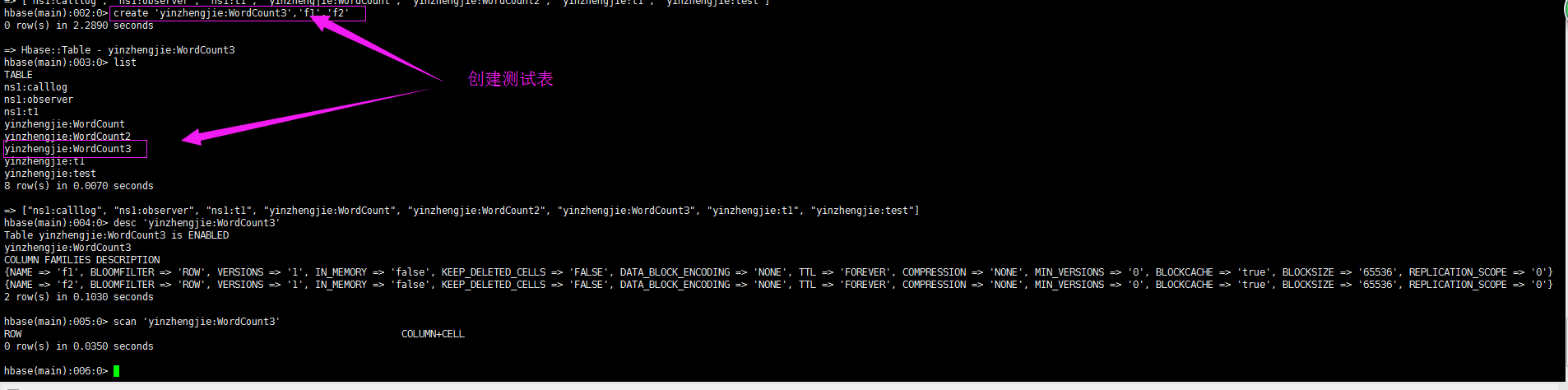

一.环境准备

list

create 'yinzhengjie:WordCount3','f1','f2'

list

desc 'yinzhengjie:WordCount3'

scan 'yinzhengjie:WordCount3'

二.编写HFile创建方式的代码

1>.编写Map端代码

/*

@author :yinzhengjie

Blog:http://www.cnblogs.com/yinzhengjie/tag/Hadoop%E7%94%9F%E6%80%81%E5%9C%88/

EMAIL:y1053419035@qq.com

*/

package cn.org.yinzhengjie.hbase.hfile; import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper; import java.io.IOException; public class HFileOutputMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

//得到一行数据

String line = value.toString();

String[] arr = line.split(" ");

//

for (String word : arr){

context.write(new Text(word),new IntWritable(1));

}

}

}

2>.编写Reducer端代码

/*

@author :yinzhengjie

Blog:http://www.cnblogs.com/yinzhengjie/tag/Hadoop%E7%94%9F%E6%80%81%E5%9C%88/

EMAIL:y1053419035@qq.com

*/

package cn.org.yinzhengjie.hbase.hfile; import org.apache.hadoop.hbase.Cell;

import org.apache.hadoop.hbase.CellUtil;

import org.apache.hadoop.hbase.KeyValue;

import org.apache.hadoop.hbase.io.ImmutableBytesWritable;

import org.apache.hadoop.hbase.util.Bytes;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; import java.io.IOException; public class HFileOutputReducer extends Reducer<Text,IntWritable,ImmutableBytesWritable,Cell> {

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable value : values) {

sum += value.get();

}

if(key.toString().length() > 0){

ImmutableBytesWritable outKey = new ImmutableBytesWritable(Bytes.toBytes(key.toString()));

//创建cell

Cell cell = CellUtil.createCell(Bytes.toBytes(key.toString()),

Bytes.toBytes("f1"), Bytes.toBytes("count"),System.currentTimeMillis(),

KeyValue.Type.Minimum,Bytes.toBytes(sum+""),null);

context.write(outKey,cell);

}

}

}

3>.编写主程序代码

/*

@author :yinzhengjie

Blog:http://www.cnblogs.com/yinzhengjie/tag/Hadoop%E7%94%9F%E6%80%81%E5%9C%88/

EMAIL:y1053419035@qq.com

*/

package cn.org.yinzhengjie.hbase.hfile; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.hbase.Cell;

import org.apache.hadoop.hbase.HBaseConfiguration;

import org.apache.hadoop.hbase.HTableDescriptor;

import org.apache.hadoop.hbase.TableName;

import org.apache.hadoop.hbase.client.Connection;

import org.apache.hadoop.hbase.client.ConnectionFactory;

import org.apache.hadoop.hbase.io.ImmutableBytesWritable;

import org.apache.hadoop.hbase.mapreduce.HFileOutputFormat2;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; public class App { public static void main(String[] args) throws Exception { System.setProperty("HADOOP_USER_NAME", "yinzhengjie");

Configuration conf = HBaseConfiguration.create();

conf.set("fs.defaultFS","file:///");

Connection conn = ConnectionFactory.createConnection(conf);

Job job = Job.getInstance(conf);

job.setJobName("HFile WordCount");

job.setJarByClass(App.class);

job.setMapperClass(HFileOutputMapper.class);

job.setReducerClass(HFileOutputReducer.class);

//设置输出格式

job.setOutputFormatClass(HFileOutputFormat2.class);

//设置路径

FileInputFormat.addInputPath(job,new Path("file:///D:\\BigData\\yinzhengjieData\\word.txt"));

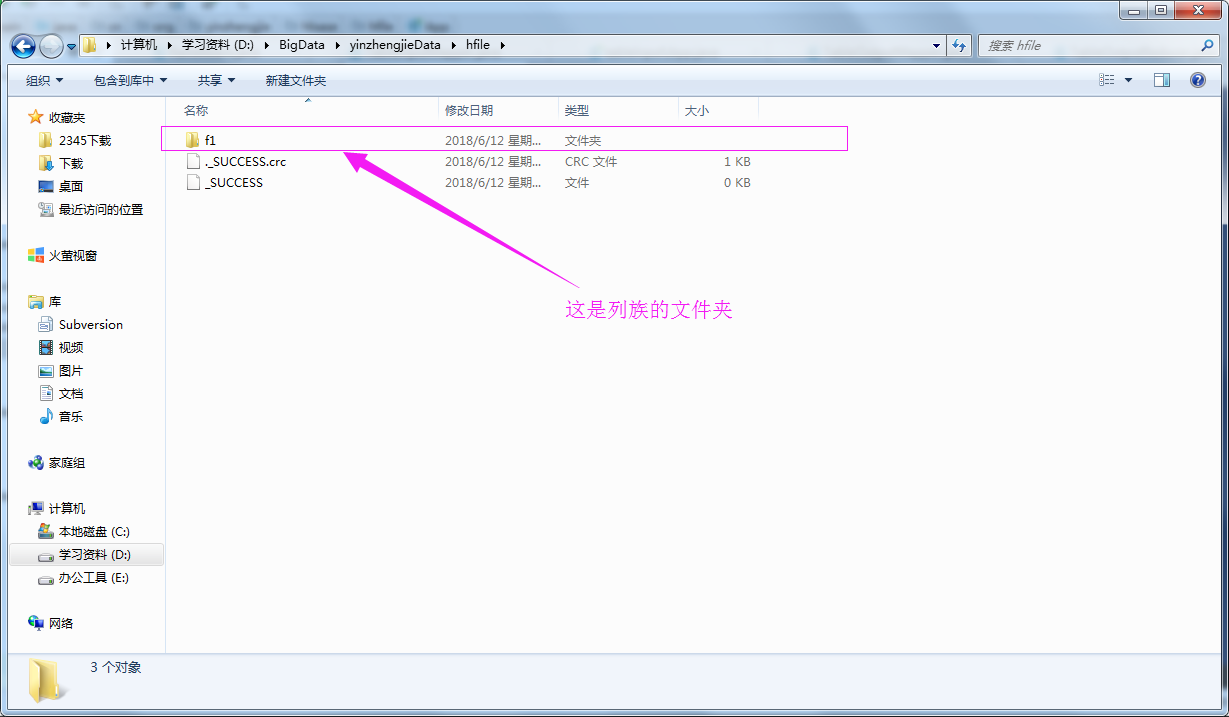

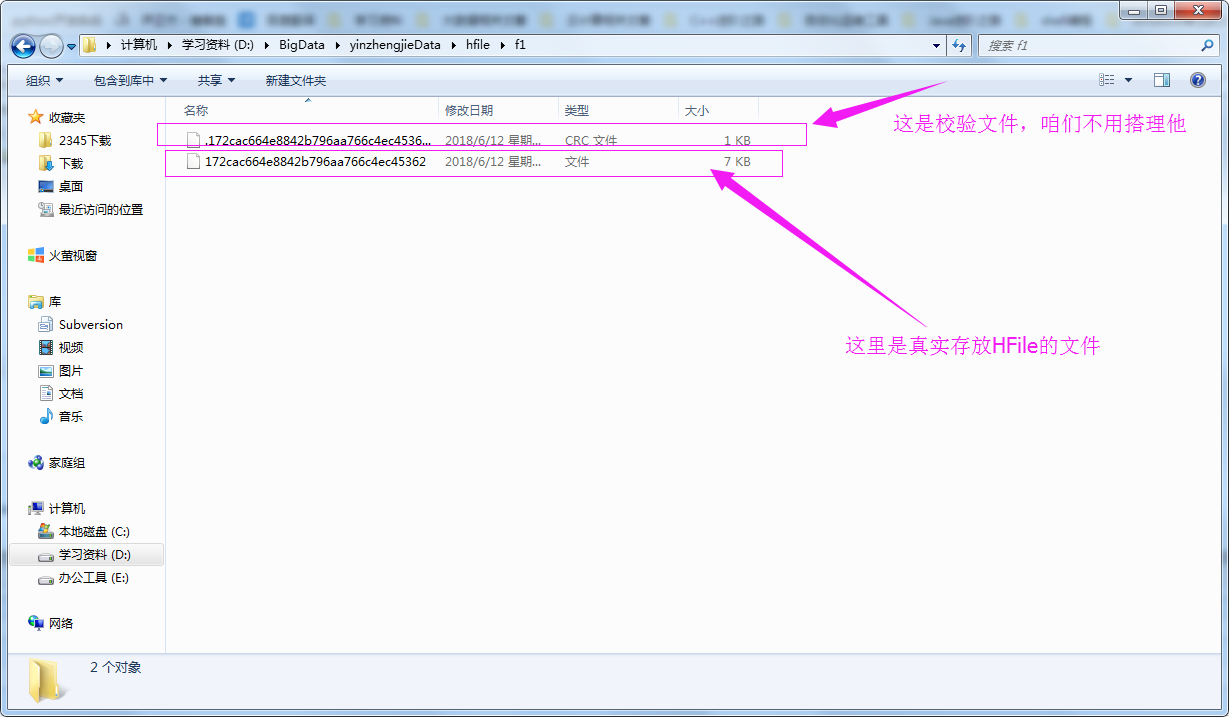

FileOutputFormat.setOutputPath(job,new Path("file:///D:\\BigData\\yinzhengjieData\\hfile"));

//设置输出k-v

job.setOutputKeyClass(ImmutableBytesWritable.class);

job.setOutputValueClass(Cell.class);

//设置map端输出k-v

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class);

/**

* 配置和"yinzhengjie:WordCount3"进行关联,也就是说"yinzhengjie:WordCount3"这个表必须在HBase数据库中存在,

* 实际操作是以"yinzhengjie:WordCount3"为模板,便于生成HFile文件!

*/

HFileOutputFormat2.configureIncrementalLoad(job, new HTableDescriptor(TableName.valueOf("yinzhengjie:WordCount3")),

conn.getRegionLocator(TableName.valueOf("yinzhengjie:WordCount3")) );

job.waitForCompletion(true);

}

}

4>.查看测试结果

Hadoop生态圈-HBase的HFile创建方式的更多相关文章

- Hadoop生态圈-基于yum源的方式部署Cloudera Manager5.15.1

Hadoop生态圈-基于yum源的方式部署Cloudera Manager5.15.1 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 我之前分享过关于离线方式部署Cloudera ...

- Hadoop生态圈-hbase介绍-伪分布式安装

Hadoop生态圈-hbase介绍-伪分布式安装 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.HBase简介 HBase是一个分布式的,持久的,强一致性的存储系统,具有近似最 ...

- Hadoop生态圈-HBase性能优化

Hadoop生态圈-HBase性能优化 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任.

- Hadoop生态圈-Hbase的协处理器(coprocessor)应用

Hadoop生态圈-Hbase的协处理器(coprocessor)应用 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任.

- Hadoop生态圈-Hbase的rowKey设计原则

Hadoop生态圈-Hbase的rowKey设计原则 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任.

- Hadoop生态圈-Hbase的Region详解

Hadoop生态圈-Hbase的Region详解 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任.

- Hadoop生态圈-Hbase过滤器(Filter)

Hadoop生态圈-Hbase过滤器(Filter) 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任.

- Hadoop生态圈-Hbase的API常见操作

Hadoop生态圈-Hbase的API常见操作 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任.

- Hadoop生态圈-hbase常用命令

Hadoop生态圈-hbase常用命令 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任.

随机推荐

- Daily Scrum (2015/10/30)

据组员们反映其他组都会有休息时间,所以我和PM讨论把每周5晚上作为日常休息时间,这一天组员们自由阅读.

- 2-Fourth Scrum Meeting20151204

任务安排 闫昊: 今日完成:设计本地数据库. 明日任务:请假.(最近代码写得多……很累……) 唐彬: 今日完成:ios客户端代码的了解. 明日任务:ios客户端代码的深度学习. 史烨轩: 今日完成: ...

- java(系统)实战1

在简单学习了java的布局和一些界面的绘制方法后,我便开始有了跟着视频和书本的知识学做一个简单的餐饮系统,才能激发自己的编程和不断巩固知识. 我简单说明一下本次做的系统很普通但具有实用性,是通过jav ...

- xml命名空间

https://yq.aliyun.com/articles/40353 ************************************* 摘要: 相信很多人和我一样,在编写Spring或者 ...

- Beta冲刺 (6/7)

队名:天机组 组员1友林 228(组长) 今日完成:修改代码 明天计划:封装代码 剩余任务:优化网络通讯机制 主要困难:暂无 收获及疑问:暂无 组员2方宜 225 今日完成:优化了一部分活动,调整了界 ...

- express框架实现承载静态页面的能力

我们知道nodejs本身不具有一个web容器的作用,不像tomcat或者IIS这样的服务器一样天然具有web容器承载静态动态页面的能力,如果要原生实现的话需要自己通过路由配置,比较麻烦,而expres ...

- TADOConnection.Close - connection still active on MS-SQL server

I have several Delphi programs (XE3), that use a TADOConnection to connect to a MS-SQL Server. I rec ...

- VNC Server (Ubuntu 16.04.3 GNOME)

1. 安装VNC服务 sudo apt-get install vnc4server -y 2. 启动VNC服务 vncserver :1 3. 此时客户端连上后你会发现灰屏,原因出在~/.vnc/x ...

- 事件ID:7026(“下列引导或系统启动驱动程序无法加载: cdrom”)的解决方法

电脑没有安装光驱,而是使用USB光驱/虚拟光驱软件,每次开机后"事件查看器"都显示错误:"下列引导或系统启动驱动程序无法加载: cdrom"(事件ID:7 ...

- [转帖]紧急预警:Globelmposter3.0变种来袭,多行业中招

紧急预警:Globelmposter3.0变种来袭,多行业中招 https://www.csdn.net/article/a/2018-09-04/15959658 CSDN 转载深信服... ...