Ceph学习之路(三)Ceph luminous版本部署

1、配置ceph.repo并安装批量管理工具ceph-deploy

[root@ceph-node1 ~]# vim /etc/yum.repos.d/ceph.repo

[ceph]

name=Ceph packages for $basearch

baseurl=http://mirrors.aliyun.com/ceph/rpm-luminous/el7/$basearch

enabled=

gpgcheck=

priority=

type=rpm-md

gpgkey=https://mirrors.aliyun.com/ceph/keys/release.asc [ceph-noarch]

name=Ceph noarch packages

baseurl=http://mirrors.aliyun.com/ceph/rpm-luminous/el7/noarch

enabled=

gpgcheck=

priority=

type=rpm-md

gpgkey=https://mirrors.aliyun.com/ceph/keys/release.asc [ceph-source]

name=Ceph source packages

baseurl=http://mirrors.aliyun.com/ceph/rpm-luminous/el7/SRPMS

enabled=

gpgcheck=

type=rpm-md

gpgkey=https://mirrors.aliyun.com/ceph/keys/release.asc

priority=

[root@ceph-node1 ~]# yum install -y https://dl.fedoraproject.org/pub/epel/epel-release-latest-7.noarch.rpm

[root@ceph-node1 ~]# yum makecache

[root@ceph-node1 ~]# yum update -y

[root@ceph-node1 ~]# yum install -y ceph-deploy

```

2、ceph的节点部署

(1)安装NTP 在所有 Ceph 节点上安装 NTP 服务(特别是 Ceph Monitor 节点),以免因时钟漂移导致故障

[root@ceph-node1 ~]# yum install -y ntp ntpdate ntp-doc

[root@ceph-node2 ~]# yum install -y ntp ntpdate ntp-doc

[root@ceph-node3 ~]# yum install -y ntp ntpdate ntp-doc [root@ceph-node1 ~]# ntpdate ntp1.aliyun.com

Jul :: ntpdate[]: adjust time server 120.25.115.20 offset 0.001528 sec

[root@ceph-node1 ~]# hwclock

Tue Jul :: AM EDT -0.302897 seconds

[root@ceph-node1 ~]# crontab -e

*/ * * * * /usr/sbin/ntpdate ntp1.aliyun.com

确保在各 Ceph 节点上启动了 NTP 服务,并且要使用同一个 NTP 服务器

(2)安装SSH服务器并添加hosts解析

默认有ssh,可以省略

[root@ceph-node1 ~]# yum install openssh-server

[root@ceph-node2 ~]# yum install openssh-server

[root@ceph-node3 ~]# yum install openssh-server 确保所有 Ceph 节点上的 SSH 服务器都在运行。 [root@ceph-node1 ~]# cat /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

:: localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.56.11 ceph-node1

192.168.56.12 ceph-node2

192.168.56.13 ceph-node3

(3)允许无密码SSH登录

root@ceph-node1 ~]# ssh-keygen

root@ceph-node1 ~]# ssh-copy-id root@ceph-node1

root@ceph-node1 ~]# ssh-copy-id root@ceph-node2

root@ceph-node1 ~]# ssh-copy-id root@ceph-node3

推荐使用方式:

修改 ceph-deploy 管理节点上的 ~/.ssh/config 文件,这样 ceph-deploy 就能用你所建的用户名登录 Ceph 节点了,而无需每次执行 ceph-deploy 都要指定 –username {username} 。这样做同时也简化了 ssh 和 scp 的用法。把 {username} 替换成你创建的用户名。

[root@ceph-node1 ~]# cat .ssh/config

Host node1

Hostname ceph-node1

User root

Host node2

Hostname ceph-node2

User root

Host node3

Hostname ceph-node3

User root

[root@ceph-node1 ~]# chmod .ssh/config

[root@ceph-node1 ~]# systemctl restart sshd

(4)关闭Selinux

在 CentOS 和 RHEL 上, SELinux 默认为 Enforcing 开启状态。为简化安装,我们建议把 SELinux 设置为 Permissive 或者完全禁用,也就是在加固系统配置前先确保集群的安装、配置没问题。用下列命令把 SELinux 设置为 Permissive :

[root@ceph-node1 ~]# setenforce

[root@ceph-node2 ~]# setenforce

[root@ceph-node3 ~]# setenforce

要使 SELinux 配置永久生效(如果它的确是问题根源),需修改其配置文件 /etc/selinux/config 。

(5)关闭防火墙

[root@ceph-node1 ~]# systemctl stop firewalld.service

[root@ceph-node2 ~]# systemctl stop firewalld.service

[root@ceph-node3 ~]# systemctl stop firewalld.service

[root@ceph-node1 ~]# systemctl disable firewalld.service

[root@ceph-node2 ~]# systemctl disable firewalld.service

[root@ceph-node3 ~]# systemctl disable firewalld.service

(6)安装epel源和启用优先级

[root@ceph-node1 ~]# yum install -y epel-release

[root@ceph-node2 ~]# yum install -y epel-release

[root@ceph-node3 ~]# yum install -y epel-release

[root@ceph-node1 ~]# yum install -y yum-plugin-priorities

[root@ceph-node2 ~]# yum install -y yum-plugin-priorities

[root@ceph-node3 ~]# yum install -y yum-plugin-priorities

3、创建集群

创建一个 Ceph 存储集群,它有一个 Monitor 和两个 OSD 守护进程。一旦集群达到 active + clean 状态,再扩展它:增加第三个 OSD 、增加元数据服务器和两个 Ceph Monitors。在管理节点上创建一个目录,用于保存 ceph-deploy 生成的配置文件和密钥对。

(1)创建ceph工作目录并配置ceph.conf

[root@ceph-node1 ~]# mkdir /etc/ceph && cd /etc/ceph

[root@ceph-node1 ceph]# ceph-deploy new ceph-node1 #配置监控节点

ceph-deploy的new子命令能够部署一个默认名称为ceph的新集群,并且它能生成集群配置文件和密钥文件。列出当前工作目录,你会看到ceph.conf和ceph.mon.keyring文件。

[root@ceph-node1 ceph]# vim ceph.conf

public network =192.168.56.0/

[root@ceph-node1 ceph]# ll

total

-rw-r--r-- root root Jul : ceph.conf #ceph的配置文件

-rw-r--r-- root root Jul : ceph-deploy-ceph.log #monitor的日志文件

-rw------- root root Jul : ceph.mon.keyring #monitor的密钥环文件 遇到的问题:

[root@ceph-node1 ceph]# ceph-deploy new ceph-node1

Traceback (most recent call last):

File "/usr/bin/ceph-deploy", line , in <module>

from ceph_deploy.cli import main

File "/usr/lib/python2.7/site-packages/ceph_deploy/cli.py", line , in <module>

import pkg_resources

ImportError: No module named pkg_resources

解决方案:

[root@ceph-node1 ceph]# yum install -y python-setuptools

(2)管理节点和osd节点都需要安装ceph 集群

[root@ceph-node1 ceph]# ceph-deploy install ceph-node1 ceph-node2 ceph-node3

ceph-deploy工具包首先会安装Ceph luminous版本所有依赖包。命令成功完成后,检查所有节点上Ceph的版本和健康状态,如下所示:

[root@ceph-node1 ceph]# ceph --version

ceph version 12.2. (3ec878d1e53e1aeb47a9f619c49d9e7c0aa384d5) luminous (stable)

[root@ceph-node2 ~]# ceph --version

ceph version 12.2. (3ec878d1e53e1aeb47a9f619c49d9e7c0aa384d5) luminous (stable)

[root@ceph-node3 ~]# ceph --version

ceph version 12.2. (3ec878d1e53e1aeb47a9f619c49d9e7c0aa384d5) luminous (stable)

(3)配置MON初始化

在ceph-node1上创建第一个Ceph monitor:

[root@ceph-node1 ceph]# ceph-deploy mon create-initial #配置初始 monitor(s)、并收集所有密钥

[root@ceph-node1 ceph]# ll #完成上述操作后,当前目录里应该会出现这些密钥环

total

-rw------- root root Jul : ceph.bootstrap-mds.keyring

-rw------- root root Jul : ceph.bootstrap-mgr.keyring

-rw------- root root Jul : ceph.bootstrap-osd.keyring

-rw------- root root Jul : ceph.bootstrap-rgw.keyring

-rw------- root root Jul : ceph.client.admin.keyring

注意:只有在安装 Hammer 或更高版时才会创建 bootstrap-rgw 密钥环。

注意:如果此步失败并输出类似于如下信息 “Unable to find /etc/ceph/ceph.client.admin.keyring”,请确认ceph.conf中为monitor指定的IP是 Public IP,而不是 Private IP。查看集群的状态信息:

[root@ceph-node1 ceph]# ceph -s

cluster:

id: c6165f5b-ada0--9bab-1916b28ec92a

health: HEALTH_OK services:

mon: daemons, quorum ceph-node1

mgr: no daemons active

osd: osds: up, in data:

pools: pools, pgs

objects: objects, bytes

usage: kB used, kB / kB avail

pgs:

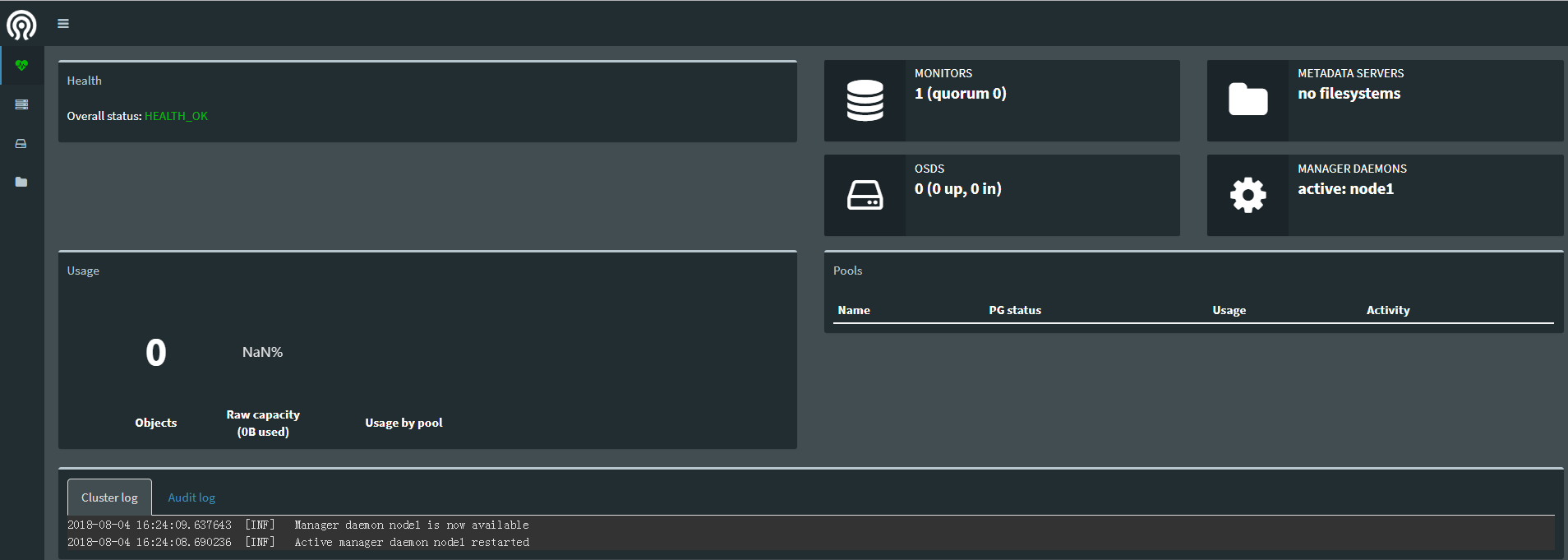

(5)开启监控模块

查看集群支持的模块

[root@ceph-node1 ceph]# ceph mgr dump

[root@ceph-node1 ceph]# ceph mgr module enable dashboard #启用dashboard模块

在/etc/ceph/ceph.conf中添加

[mgr]

mgr modules = dashboard

设置dashboard的ip和端口

[root@ceph-node1 ceph]# ceph config-key put mgr/dashboard/server_addr 192.168.56.11

set mgr/dashboard/server_addr

[root@ceph-node1 ceph]# ceph config-key put mgr/dashboard/server_port

set mgr/dashboard/server_port

[root@ceph-node1 ceph]# netstat -tulnp |grep

tcp6 ::: :::* LISTEN /ceph-mgr

(5)在ceph-node1上创建OSD

[root@ceph-node1 ceph]# ceph-deploy disk zap ceph-node1 /dev/sdb [root@ceph-node1 ceph]# ceph-deploy disk list ceph-node1 #列出ceph-node1上所有的可用磁盘

......

[ceph-node1][INFO ] Running command: fdisk -l

[ceph-node1][INFO ] Disk /dev/sdb: MB, bytes, sectors

[ceph-node1][INFO ] Disk /dev/sdc: MB, bytes, sectors

[ceph-node1][INFO ] Disk /dev/sdd: MB, bytes, sectors

[ceph-node1][INFO ] Disk /dev/sda: 21.5 GB, bytes, sectors

从输出中,慎重选择若干磁盘来创建Ceph OSD(除操作系统分区以外),并将它们分别命名为sdb、sdc和sdd。disk zap子命令会删除现有分区表和磁盘内容。运行此命令之前,确保你选择了正确的磁盘名称:

osd create子命令首先会准备磁盘,即默认地先用xfs文件系统格式化磁盘,然后会激活磁盘的第一、二个分区,分别作为数据分区和日志分区:

[root@ceph-node1 ceph]# ceph-deploy mgr create node1 #部署管理器守护程序,仅仅使用此版本

[ceph_deploy.conf][DEBUG ] found configuration file at: /root/.cephdeploy.conf

[ceph_deploy.cli][INFO ] Invoked (2.0.): /usr/bin/ceph-deploy mgr create node1

[ceph_deploy.cli][INFO ] ceph-deploy options:

[ceph_deploy.cli][INFO ] username : None

[ceph_deploy.cli][INFO ] verbose : False

[ceph_deploy.cli][INFO ] mgr : [('node1', 'node1')]

[ceph_deploy.cli][INFO ] overwrite_conf : False

[ceph_deploy.cli][INFO ] subcommand : create

[ceph_deploy.cli][INFO ] quiet : False

[ceph_deploy.cli][INFO ] cd_conf : <ceph_deploy.conf.cephdeploy.Conf instance at 0xe1e5a8>

[ceph_deploy.cli][INFO ] cluster : ceph

[ceph_deploy.cli][INFO ] func : <function mgr at 0xda5f50>

[ceph_deploy.cli][INFO ] ceph_conf : None

[ceph_deploy.cli][INFO ] default_release : False

[ceph_deploy.mgr][DEBUG ] Deploying mgr, cluster ceph hosts node1:node1

[node1][DEBUG ] connected to host: node1

[node1][DEBUG ] detect platform information from remote host

[node1][DEBUG ] detect machine type

[ceph_deploy.mgr][INFO ] Distro info: CentOS Linux 7.4. Core

[ceph_deploy.mgr][DEBUG ] remote host will use systemd

[ceph_deploy.mgr][DEBUG ] deploying mgr bootstrap to node1

[node1][DEBUG ] write cluster configuration to /etc/ceph/{cluster}.conf

[node1][WARNIN] mgr keyring does not exist yet, creating one

[node1][DEBUG ] create a keyring file

[node1][DEBUG ] create path recursively if it doesn't exist

[node1][INFO ] Running command: ceph --cluster ceph --name client.bootstrap-mgr --keyring /var/lib/ceph/bootstrap-mgr/ceph.keyring auth get-or-create mgr.node1 mon allow profile mgr osd allow * mds allow * -o /var/lib/ceph/mgr/ceph-node1/keyring

[node1][INFO ] Running command: systemctl enable ceph-mgr@node1

[node1][WARNIN] Created symlink from /etc/systemd/system/ceph-mgr.target.wants/ceph-mgr@node1.service to /usr/lib/systemd/system/ceph-mgr@.service.

[node1][INFO ] Running command: systemctl start ceph-mgr@node1

[node1][INFO ] Running command: systemctl enable ceph.target

(5)创建OSD

添加三个OSD。出于这些说明的目的,我们假设您在每个节点中都有一个未使用的磁盘/dev/sdb。 确保设备当前未使用且不包含任何重要数据。 语法格式:ceph-deploy osd create --data {device} {ceph-node}

[root@ceph-node1 ceph]# ceph-deploy osd create --data /dev/sdb node1

[root@ceph-node1 ceph]# ceph-deploy osd create --data /dev/sdc node1

[root@ceph-node1 ceph]# ceph-deploy osd create --data /dev/sdd node1

Ceph学习之路(三)Ceph luminous版本部署的更多相关文章

- 学习之路三十九:新手学习 - Windows API

来到了新公司,一开始就要做个程序去获取另外一个程序里的数据,哇,挑战性很大. 经过两周的学习,终于搞定,主要还是对Windows API有了更多的了解. 文中所有的消息常量,API,结构体都整理出来了 ...

- Ceph学习之路(二)之Ceph的工作原理及流程

一.RADOS的对象寻址 Ceph 存储集群从 Ceph 客户端接收数据——不管是来自 Ceph 块设备. Ceph 对象存储. Ceph 文件系统.还是基于 librados 的自定义实现——并存储 ...

- Ceph学习之路(一)之ceph初识

一.元数据和元数据管理 (1)元数据 在学习Ceph之前,需要了解元数据的概念.元数据又称为中介数据.中继数据,为描述数据的数据.主要描述数据属性的信息,用来支持如指示存储位置.历史数据.资源查找.文 ...

- ceph学习笔记之十二 Ubuntu安装部署Ceph J版本

https://cloud.tencent.com/info/2b70340c72d893c30f5e124e89c346cd.html 安装Ubuntu系统安装步骤略过 拓扑连接: 一.安装前准备工 ...

- Redis——学习之路三(初识redis config配置)

我们先看看config 默认情况下系统是怎么配置的.在命令行中输入 config get *(如图) 默认情况下有61配置信息,每一个命令占两行,第一行为配置名称信息,第二行为配置的具体信息. ...

- 交互原型设计软件axure rp学习之路(三)

(三)Axure rp元件的触发事件 l OnClick(点击时): 鼠标点击事件,除了动态面板的所有的其他元件的点击时触发.比如点击按钮. l OnMouseEnter(鼠标移入时): 鼠标进入 ...

- GIt学习之路 第二天 创建版本库

本文参考廖雪峰老师的博客进行总结,完整学习请转廖雪峰博客 创建版本库 阅读: 1859216 什么是版本库呢?版本库又名仓库,英文名repository,你可以简单理解成一个目录,这个目录里面的所有文 ...

- zigbee学习之路(三):按键的控制

一.前言 通过前一次的实验,相信大家都已经对cc2530程序的编写有了一定的认识,这次我们来操作和实验的是cc2530上的按键模块. 二.原理分析 我们先来看一下按键的原理图: 根据原理图我们可以得出 ...

- 学习之路三十二:VS调试的简单技巧

这段时间园子里讲了一些关于VS的快捷键以及一些配置技巧,挺好的,大家一起学习,一起进步. 这段时间重点看了一下关于VS调试技巧方面的书,在此记录一下学习的内容吧,主要还是一些比较浅显的知识. 1. 调 ...

随机推荐

- 退出全屏监听ESC事件

fullscreenchange事件 fullscreenchange:当窗口大小改变时触发 isFullscreen:全局变量 window.addEventListener("fulls ...

- FileStream对文本进行读写操作

class FileHelper { /// <summary> /// 检验文件路径是否合法 /// </summary> /// <param name=" ...

- How To Change Log Rate Limiting In Linux

By default in Linux there are a few different mechanisms in place that may rate limit logging. These ...

- [翻译] AnchoredFloatView

AnchoredFloatView Float View over TableView to indicate selected row direction Float View 可以用来指示 Tab ...

- 使用最新版SDWebImage

使用最新版SDWebImage 1. 下载源码: 2. 测试能否编译成功: 3. 用Xcode6新建一个工程,然后将文件夹拖入到工程当中: 4. 查看其主要的源码,发现之前使用版本的方法都被弃用了: ...

- MDT概念说明

转自:http://www.winos.cn/html/21/t-39621.html http://hi.baidu.com/popweb/item/95ea6cf3aea966b5 ...

- ACE.js自定义提示实现方法

ACE.js自定义提示实现方法 时间 2015-11-19 00:55:22 wsztrush's blog 原文 http://wsztrush.github.io/编程技术/2015/11/0 ...

- Hadoop HA on Yarn——集群配置

集群搭建 因为服务器数量有限,这里服务器开启的进程有点多: 机器名 安装软件 运行进程 hadoop001 Hadoop,Zookeeper NameNode, DFSZKFailoverContro ...

- linux_bc命令

bc 命令: bc 命令是用于命令行计算器. 它类似基本的计算器. 使用这个计算器可以做基本的数学运算. 语法: 语法是 bc [命令开关]命令开关: -c 仅通过编译. ...

- Java并发编程--1.Thread和Runnable

创建线程 Java有两种方式创建线程, 继承Thread类和实现Runnable接口 继承Thread 步骤: 1.自定义一个类继承Thread类, 重写run方法 2.创建自定义类的对象,调用sta ...