机器学习降维--SVD奇异值分解

奇异值分解是有着很明显的物理意义,将一个比较复杂的矩阵用更小更简单的几个子矩阵的相乘来表示,这些小矩阵描述的是矩阵的重要的特性,让机器学会抽取重要的特征,SVD是一个重要的方法。

所以SVD不仅是一个数学问题,在工程应用方面很多地方都有其身影,如PCA,推荐系统、任意矩阵的满秩分解。

1、特征值

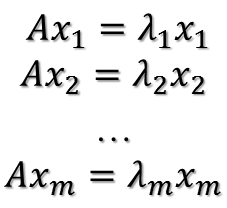

如果说一个向量v是方阵A的特征向量,将一定可以表示成下面的形式:

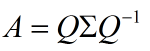

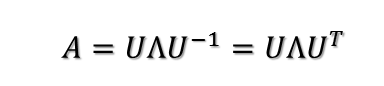

这时候λ被称为特征向量v对应的特征值,一个矩阵的一组特征向量是一组正交向量。特征值分解是将一个矩阵分解成以下形式:

其中Q是这个矩阵A的特征向量组成的矩阵,Σ是一个对角阵,每个对角线上的元素就是一个特征值。和矩阵相乘其实就是一次线性变换。如一下两个例子:

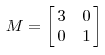

其对应的线形变换是一下形式:

可以根据数学的计算看到更加直观的结果:

注意两点:

、对角阵对角线上的特征值的绝对值大于1时,特征值越大拉伸的幅度越大,特征值绝对值小于1,特征值越小压缩的幅度越大;

、这只是矩阵为对角阵的情况下,拉伸和收缩都是沿着坐标轴(也就是特征向量)的方向,而对于非对称的非对角阵,会有非坐标轴方向的拉伸和收缩

我们想要描述好一个变换,那我们就描述好这个变换主要的变化方向就好了,而对角阵Σ里面的特征值是由大到小排列的,特征值对应的特征向量就是描述矩阵的变化方向。

当矩阵是高纬度的时候,矩阵就是高纬度空间下的线形变换,通过特征值分解得到的前N个向量就是矩阵最主要的N个变化的方向。

利用这N个方向的变化来近似这个矩阵。也就是:提取这个矩阵最重要的一部分特征。(而特征值分解的局限就是变换的矩阵必须为方阵)

2、正交矩阵

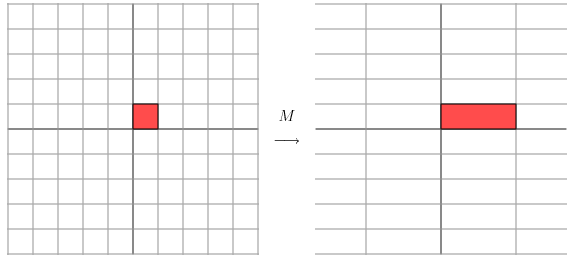

正交矩阵是在欧几里得空间里的叫法,在酉空间里叫酉矩阵,一个正交矩阵对应的变换叫正交变换,这个变换的特点是不改变向量的尺寸和向量间的夹角。下图是一个直观的认识:

假设二维空间中的向量OA,它在标准坐标系(也就是e1和e2表示的坐标系)中的表示为(a,b)’(‘表示转置);现在用另一组坐标e1’、e2’表示为(a’,b’)’;那么存在矩阵U使得(a’,b’)’=U(a,b)’,而矩阵U就是正交矩阵。

通过上图可知,正交变换只是将变换向量用另一组正交基来表示,在这个过程中并没有罪向量作拉伸,也不改变向量的空间位置,对两个向量同时做正交变换,变换的前后两个向量的夹角显然也不会改变。

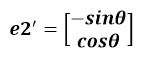

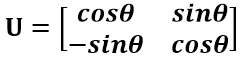

上图是一个旋转的正交变换,可以把e1’、e2’坐标系看做是e1、e2坐标系经过旋转某个θ角度得到,具体的旋转规则如下:

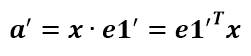

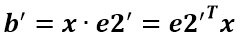

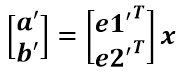

a’和b’实际上是x在e1’和e2’轴上投影的大小,所以直接做内积可得:

从图中可以看到:

所以:

正交矩阵U的行(列)之间都是单位正交向量,它对向量做旋转变换。这里解释一下:旋转是相对的,就那上面的图来说,我们可以说向量的空间位置没有变,标准参考系向左旋转了θ角度,而如果我选择了e1’、e2’作为新的标准坐标系,那么在新坐标系中OA(原标准坐标系的表示)就变成了OA’,这样看来就好像坐标系不动,把OA往顺时针方向旋转了θ角度,这个操作实现起来很简单:将变换后的向量坐标仍然表示在当前坐标系中。

正交变换的另一个方面是反射变换,也即e1’的方向与图中方向相反。

总结:正交矩阵的行(列)向量都是两两正交的单位向量,正交矩阵对应的变换为正交变换,它有两种表现:旋转和反射。正交矩阵将标准正交基映射为标准正交基(即图中从e1、e2到e1’、e2’)。

3、特征值的分解 - EVD

在讨论SVD之前,先了解矩阵的特征值分解(EVD),这里选择特殊的矩阵——对角阵,对称矩阵又一个性质就是总能相似对角化,对称矩阵不同特征值对应的特征向量两两正交。一个矩阵能能相似对角化即说明其特征子空间即为其列空间,若不能对角化则其特征子空间为列空间的子空间。现在假设存在m * m的满秩对称矩阵A,它有m个不同的特征值,设特征值为: 对应的单位特征向量:

对应的单位特征向量:

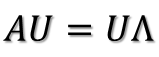

则有:  进而:

进而:

所以可得到A的特征值分解(由于对称阵特征向量两两正交,所以U为正交阵,正交阵的逆矩阵等于其转置):

这里假设A有m个不同的特征值,实际上,只要A是对称阵其均有如上分解。

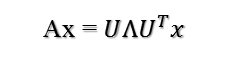

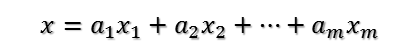

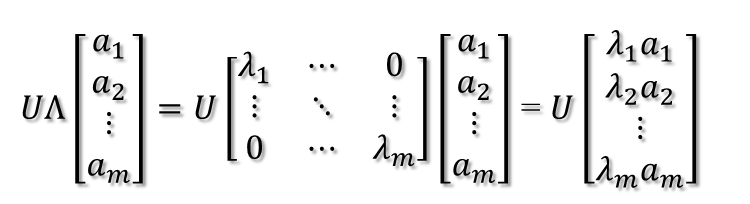

矩阵A分解了,相应的,其对应的映射也分解为三个映射。现在假设有x向量,用A将其变换到A的列空间中,那么首先由UT先对x做变换:

U是正交阵UT也是正交阵,所以UT对x的变换是正交变换,它将x用新的坐标系来表示,这个坐标系就是A的所有正交的特征向量构成的坐标系。比如将x用A的所有特征向量表示为:

则通过第一个变换就可以把x表示为[a1 a2 … am]T:

紧接着,在新的坐标系表示下,由中间那个对角矩阵对新的向量坐标换,其结果就是将向量往各个轴方向拉伸或压缩:

从上图可以看到,如果A不是满秩的话,那么就是说对角阵的对角线上元素存在0,这时候就会导致维度退化,这样就会使映射后的向量落入m维空间的子空间中。

最后一个变换就是U对拉伸或压缩后的向量做变换,由于U和UT是互为逆矩阵,所以U变换是UT变换的逆变换。

因此,从对称阵的分解对应的映射分解来分析一个矩阵的变换特点是非常直观的。假设对称阵特征值全为1那么显然它就是单位阵,如果对称阵的特征值有个别是0其他全是1,那么它就是一个正交投影矩阵,它将m维向量投影到它的列空间中。

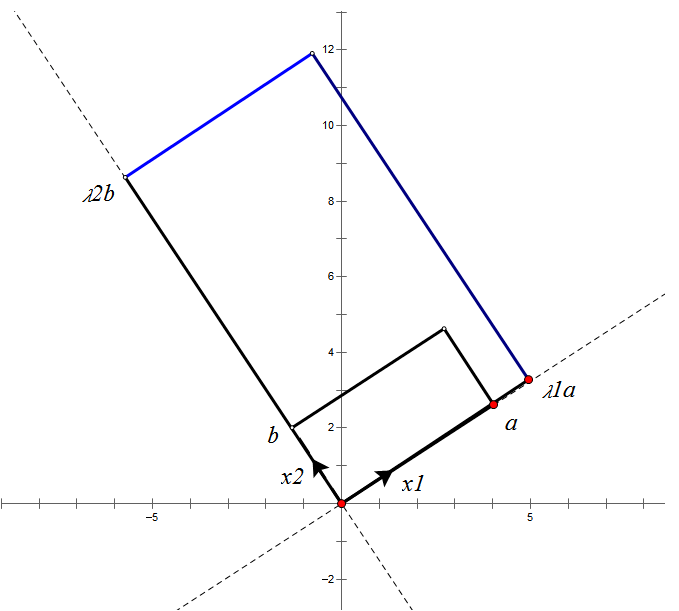

根据对称阵A的特征向量,如果A是2 * 2的,那么就可以在二维平面中找到这样一个矩形,是的这个矩形经过A变换后还是矩形:

这个矩形的选择就是让其边都落在A的特征向量方向上,如果选择其他矩形的话变换后的图形就不是矩形了!

4、奇异值

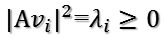

上面说过了特征值分解是提取矩阵特征很不错的方法,但这只是针对方阵而言的,在现实世界中大部分的矩阵并不是方阵,描述这些普通矩阵的重要特征就会用到:奇异值分解,可以适应任意矩阵分解的方法:

假设A是一个M * N的矩阵,那么得到的U是一个M * M的方阵(里面的向量是正交的,U里面的向量称为左奇异向量),Σ是一个M * N的矩阵(除了对角线的元素都是0,对角线上的元素称为奇异值),

V’(V的转置)是一个N * N的矩阵,里面的向量也是正交的,V里面的向量称为右奇异向量)。

那么矩阵A的奇异值和方阵的特征值是如何对应的?

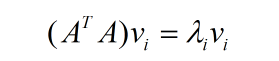

我们将一个矩阵AT * A,将会得到一个方阵,我们用这个方阵求特征值可以得到:

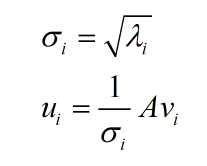

这里得到的Vi就是上面的右奇异向量,此外,我们可以得到:

这里的σi就是上面说的奇异值。ui就是上面的左奇异向量。奇异值σ跟特征值相似,在矩阵Σ中也是按从大到小的方式排列,而且σ的值减小的特别的快,

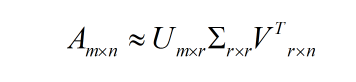

在很多的情况下前10%甚至1%的奇异值之和就占了全部奇异值之和的99%以上。也就是说可以用前r个大的奇异值来近似的描述矩阵,这里定义奇异值的分解:

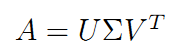

r是一个远远小于m和n的值,矩阵的乘法看起来是这个样子:

右边的三个矩阵相乘的结果将会是一个接近于A的矩阵,在这儿,r越接近于n,则相乘的结果越接近于A。

而这三个矩阵的面积之和(在存储观点来说,矩阵面积越小,存储量就越小)要远远小于原始的矩阵A,我们如果想要压缩空间来表示原矩阵A,我们存下这里的三个矩阵:U、Σ、V就好了。

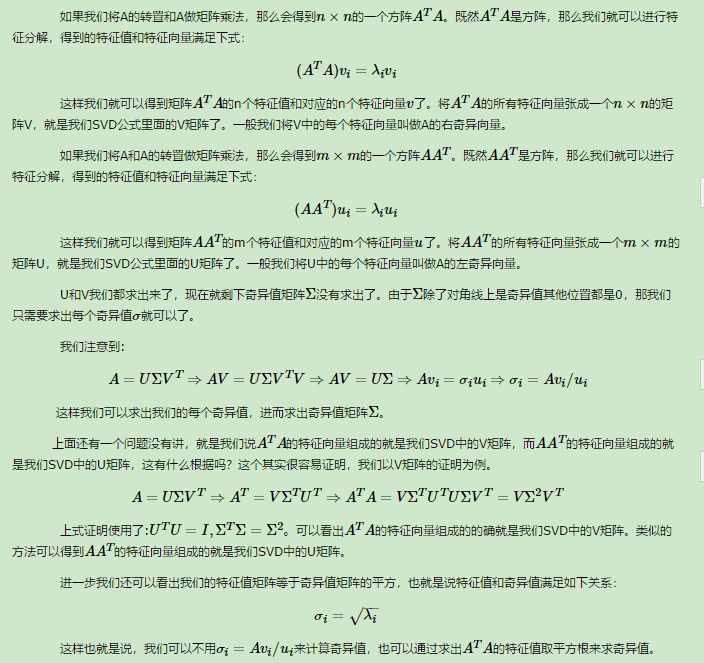

5、SVD的推导

6、奇异值分解 - SVD

上面的特征值分解的A矩阵是对称阵,根据EVD可以找到一个(超)矩形使得变换后还是(超)矩形,也即A可以将一组正交基映射到另一组正交基!那么现在来分析:对任意M*N的矩阵,能否找到一组正交基使得经过它变换后还是正交基?答案是肯定的,它就是SVD分解的精髓所在。

现在假设存在M*N矩阵A,事实上,A矩阵将n维空间中的向量映射到k(k<=m)维空间中,k=Rank(A)。现在的目标就是:在n维空间中找一组正交基,使得经过A变换后还是正交的。假设已经找到这样一组正交基:

{v1,v2,v3,…,vn}

则A矩阵将这组基映射为:

{Av1,Av2,Av3,…,Avn}

如果要使他们两两正交,即:

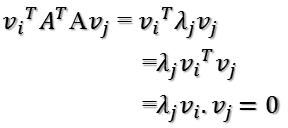

Avi · Avj = (Avi)TAvj = viTATAvj = 0

根据假设,存在:

viTvj = vivj = 0

所以如果正交基v选择为ATA的特征向量的话,由于ATA是对称阵,v之间两两正交,那么:

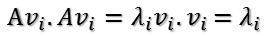

这样就找到了正交基使其映射后还是正交基了,现在,将映射后的正交基单位化,因为:

所以有:

所以取单位向量:

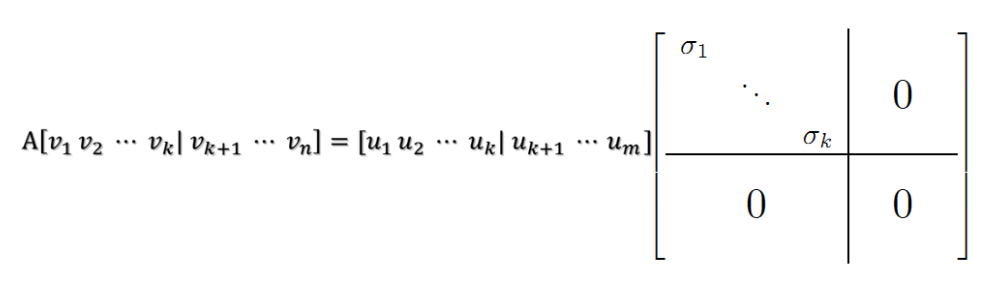

当k < i <= m时,对u1,u2,…,uk进行扩展u(k+1),…,um,使得u1,u2,…,um为m维空间中的一组正交基,即将{u1,u2,…,uk}正交基扩展成{u1,u2,…,um}Rm空间的单位正交基,同样的,对v1,v2,…,vk进行扩展v(k+1),…,vn(这n-k个向量存在于A的零空间中,即Ax=0的解空间的基),使得v1,v2,…,vn为n维空间中的一组正交基,即:

在A的零空间中选择{vk+1,vk+2,…,vn}使得AvI = 0,i > k并取σ = 0则可得到:

继而得到A矩阵的奇异值分解:

V是n*n的正交矩阵,U是m*m的正交矩阵,Σ是m*n的对角阵

现在可以来对A矩阵的映射过程进行分析了:如果在n维空间中找到一个(超)矩形,其边都落在ATA的特征向量的方向上,那么经过A变换后的形状仍然为(超)矩形!

vi为ATA的特征向量,称为A的右奇异向量,ui=Avi实际上为AAT的特征向量,称为A的左奇异向量。下面利用SVD证明文章一开始的满秩分解:

则A=XY即是A的满秩分解。

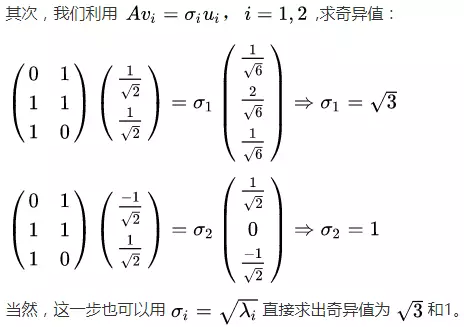

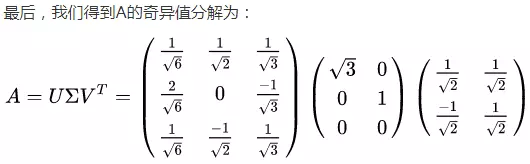

7、SVD计算案例

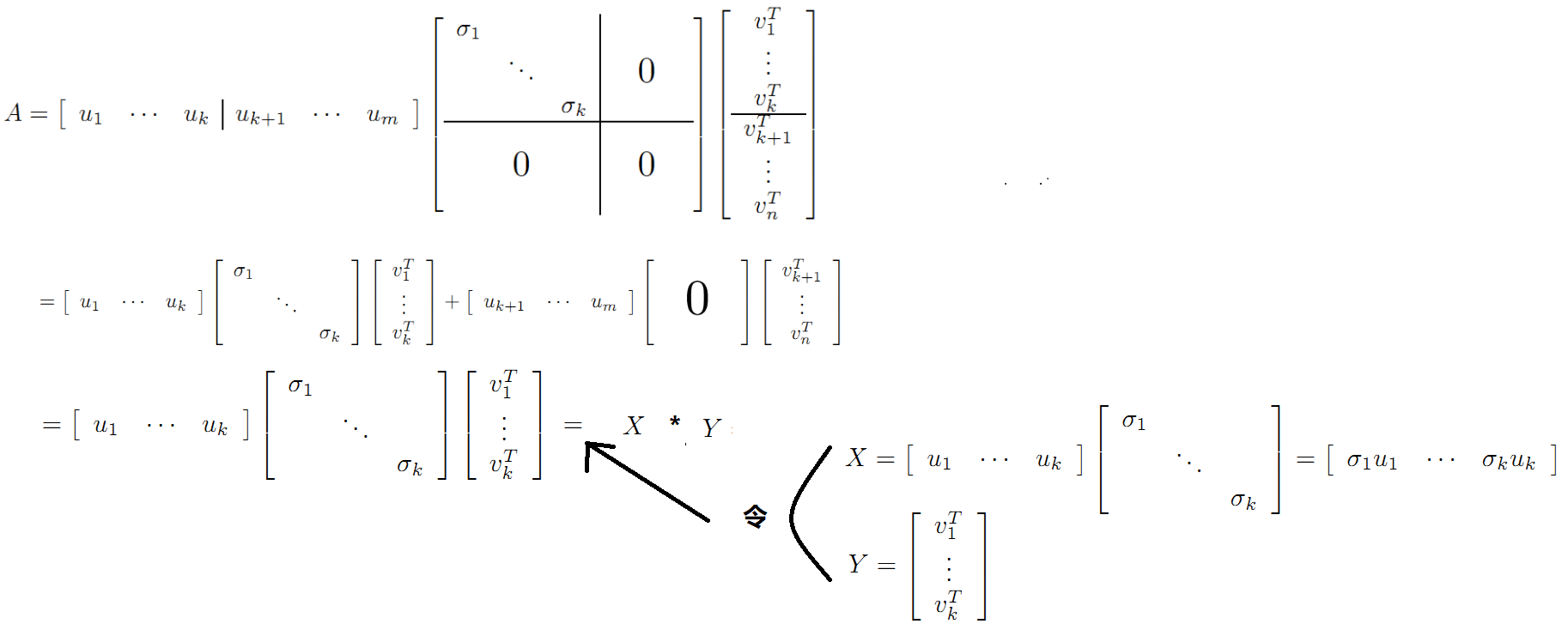

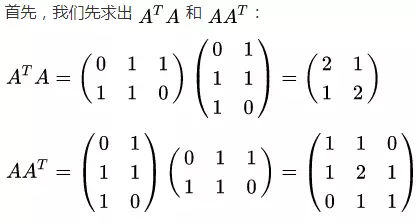

这里我们用一个简单的矩阵来说明奇异值分解的步骤。我们的矩阵A定义为:

机器学习降维--SVD奇异值分解的更多相关文章

- 简单易学的机器学习算法—SVD奇异值分解

简单易学的机器学习算法-SVD奇异值分解 一.SVD奇异值分解的定义 假设M是一个的矩阵,如果存在一个分解: 其中的酉矩阵,的半正定对角矩阵,的共轭转置矩阵,且为的酉矩阵.这样的分解称为M的奇 ...

- 机器学习降维方法概括, LASSO参数缩减、主成分分析PCA、小波分析、线性判别LDA、拉普拉斯映射、深度学习SparseAutoEncoder、矩阵奇异值分解SVD、LLE局部线性嵌入、Isomap等距映射

机器学习降维方法概括 版权声明:本文为博主原创文章,未经博主允许不得转载. https://blog.csdn.net/u014772862/article/details/52335970 最近 ...

- [机器学习]-SVD奇异值分解的基本原理和运用

SVD奇异值分解: SVD是一种可靠的正交矩阵分解法.可以把A矩阵分解成U,∑,VT三个矩阵相乘的形式.(Svd(A)=[U*∑*VT],A不必是方阵,U,VT必定是正交阵,S是对角阵<以奇异值 ...

- 降维之奇异值分解(SVD)

看了几篇关于奇异值分解(Singular Value Decomposition,SVD)的博客,大部分都是从坐标变换(线性变换)的角度来阐述,讲了一堆坐标变换的东西,整了一大堆图,试图“通俗易懂”地 ...

- SVD奇异值分解的基本原理和运用

SVD奇异值分解: SVD是一种可靠的正交矩阵分解法.可以把A矩阵分解成U,∑,VT三个矩阵相乘的形式.(Svd(A)=[U*∑*VT],A不必是方阵,U,VT必定是正交阵,S是对角阵<以奇异值 ...

- 机器学习之SVD分解

一.SVD奇异值分解的定义 假设是一个的矩阵,如果存在一个分解: 其中为的酉矩阵,为的半正定对角矩阵,为的共轭转置矩阵,且为的酉矩阵.这样的分解称为的奇异值分解,对角线上的元素称为奇异值,称为左奇异矩 ...

- 『科学计算_理论』SVD奇异值分解

转载请声明出处 SVD奇异值分解概述 SVD不仅是一个数学问题,在工程应用中的很多地方都有它的身影,比如前面讲的PCA,掌握了SVD原理后再去看PCA那是相当简单的,在推荐系统方面,SVD更是名声大噪 ...

- 四大机器学习降维算法:PCA、LDA、LLE、Laplacian Eigenmaps

四大机器学习降维算法:PCA.LDA.LLE.Laplacian Eigenmaps 机器学习领域中所谓的降维就是指采用某种映射方法,将原高维空间中的数据点映射到低维度的空间中.降维的本质是学习一个映 ...

- SVD奇异值分解的几何物理意义资料汇总

学习SVD奇异值分解的网上资料汇总: 1. 关于svd的一篇概念文,这篇文章也是后续几篇文章的鼻祖~ http://www.ams.org/samplings/feature-column/fcarc ...

随机推荐

- 阶段3 2.Spring_02.程序间耦合_1 编写jdbc的工程代码用于分析程序的耦合

创建新项目.不选择骨架 打包方式选择是jar 增加mysql的包依赖 创建demo类来讲解程序的耦合 原来里面提供了sql语句.拿到mysql没执行

- css换行用省略号代替

css换行用省略号代替,也可以说是长标题的文章可以使用简单的CSS样式实现省略号控制显示. 一般的文字截断(适用于内联与块): .text-overflow{ display:block;/*内联对象 ...

- LeetCode.985-查询后偶数的总和(Sum of Even Numbers After Queries)

这是悦乐书的第370次更新,第398篇原创 01 看题和准备 今天介绍的是LeetCode算法题中Easy级别的第232题(顺位题号是985).有一个整数数组A和一个查询数组queries. 对于第i ...

- 安装docker registry

docker pull registry 创建目录 /usr/local/docker/registry 创建 docker-compose.yml version: '3' services: r ...

- sklearn.preprocessing.StandardScaler数据标准化

原文链接:https://blog.csdn.net/weixin_39175124/article/details/79463993 数据在前处理的时候,经常会涉及到数据标准化.将现有的数据通过某种 ...

- vue如何实现热更新

我们都知道,对于node来说,前端vue代码的迭代节奏是很快的,可能一周要迭代几次,但是node的迭代却没那么平凡,可能一周更新一次甚至更久,那么为了node服务的稳定,减少node服务的发布次数,是 ...

- Systemd vs SysVinit

- xampp:windows找不到文件“-n”

转自:http://blog.csdn.net/soar92/article/details/72897789 安装xampp是总是出总是提示以下错误: ①安装xampp时提示windows找不到文件 ...

- Maven从入门到精通(二)

上一篇我们讲解了Maven项目的基本目录结构,也已经安装了Maven的开发环境,接下来我们要重点讲解一下Maven最核心的灵魂pom.xml文件 POM:Project Object Model 项目 ...

- [转帖]Chrome 错误代码:ERR_UNSAFE_PORT

Chrome 错误代码:ERR_UNSAFE_PORT 2018年07月18日 09:07:50 孤舟听雨 阅读数 182 https://blog.csdn.net/u013043762/artic ...