[Scikit-learn] 2.5 Dimensionality reduction - ICA

理论学习:

Ref: Lecture 15 | Machine Learning (Stanford) - NG

From: https://wenku.baidu.com/view/ad0973b94028915f804dc2aa.html

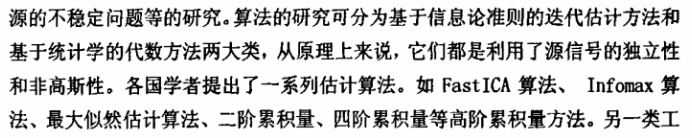

解ICA的若干种方法:

- ICA by Maximization of Nongaussianity <----

- ICA by Maximum Likelihood Estimation <----

- ICA by Minimization of Mutual Information

- ICA by Tensorial Methods

- ICA by Nonlinear Decorrelation and Nonlinear PCA

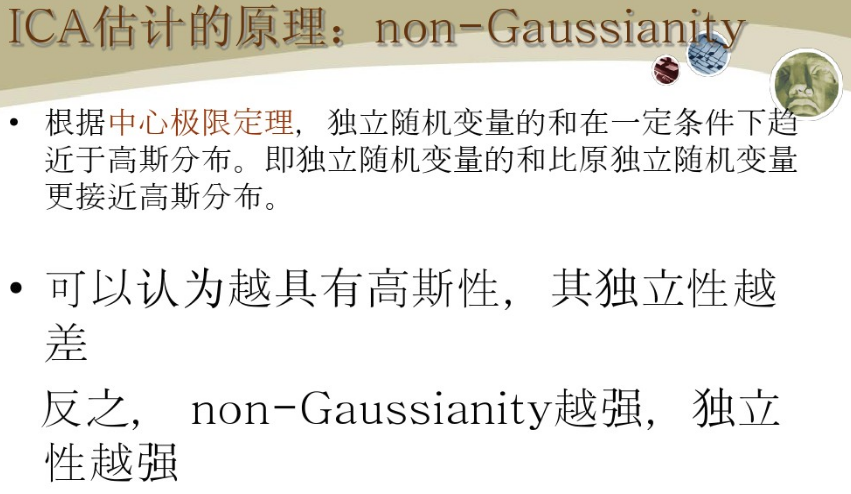

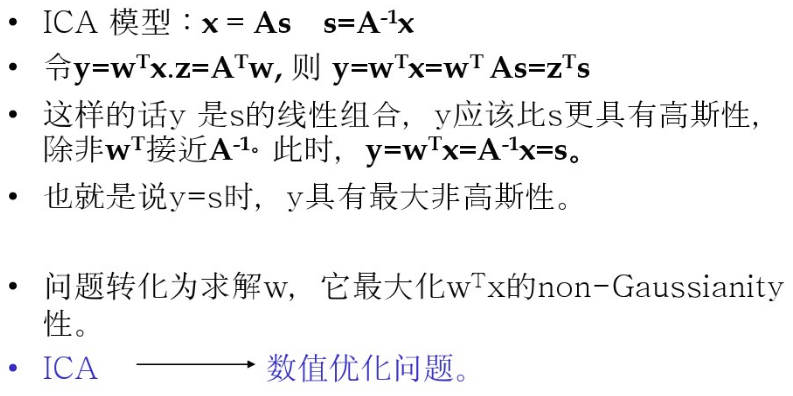

ICA by Maximization of Nongaussianity

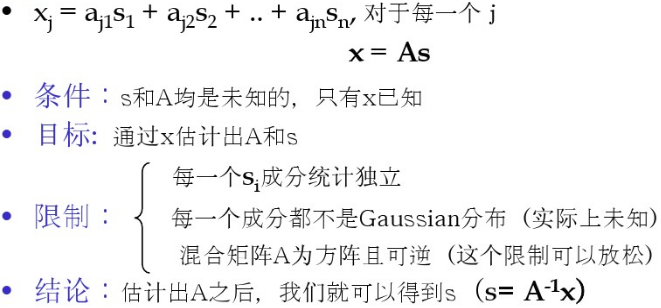

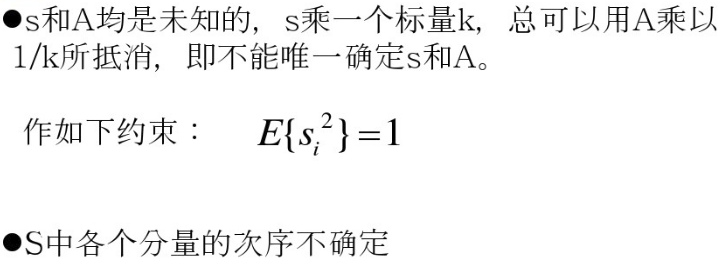

基本背景:

估值原理:

解决方案:

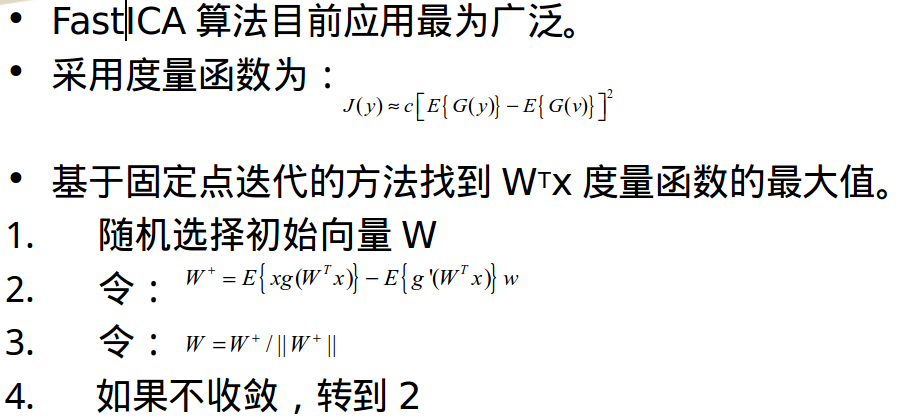

方法有很多,基本都是:度量方法+算法,比如 "negentropy近似" + "基于固定点迭代方法"。

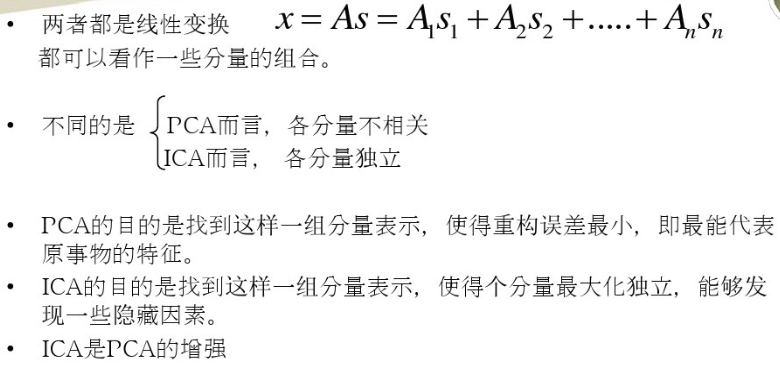

与PCA的比较:

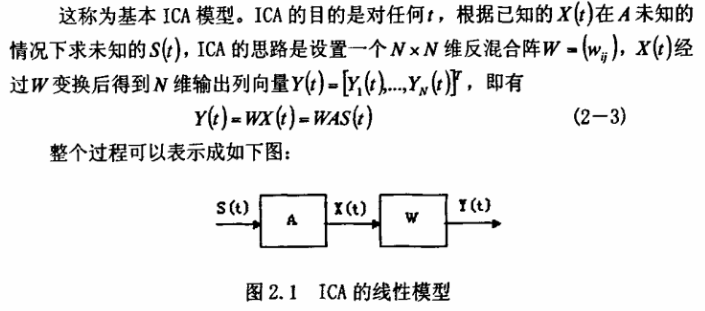

论文阅读杂记:ICA及其在数字图像处理中的应用

应用例子,特征提取方法 + svm 进行人脸识别

Centered and whitened

Ref: http://www.cnblogs.com/tornadomeet/archive/2013/03/21/2973231.html

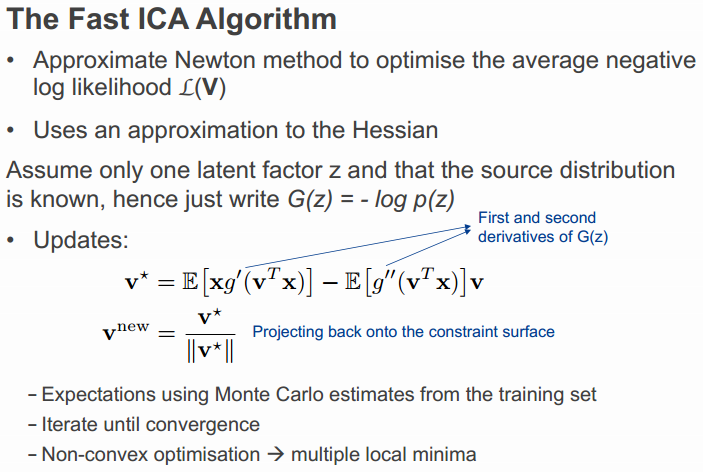

优化方法

基于固定点迭代的方法:

看上去很像牛顿法,why?

ICA by Maximum Likelihood Estimation

Ref: Lecture 15 | Machine Learning (Stanford) - NG

From: ICA教程之一【推荐!】

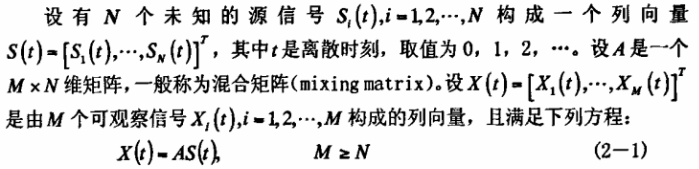

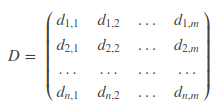

记录随机向量X的值m次,则形成数据集:

实例:在一个大厅里,有n个人在随机聊天。在大厅的不同角落,布置n个麦克风记录大厅的声音,每秒一个记录,一共记录m秒。

麦克风记录的混合声音,多个麦克风记录不同位置的混合声音。

ICA的目标,就是从混声录音中将每个人的声音分离出来。

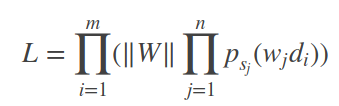

得到的似然函数如下:

【m秒的记录,n个话筒】

这里就不多讲了,请见原链接,讲得比较清楚,建议自己推导一遍在本本上。

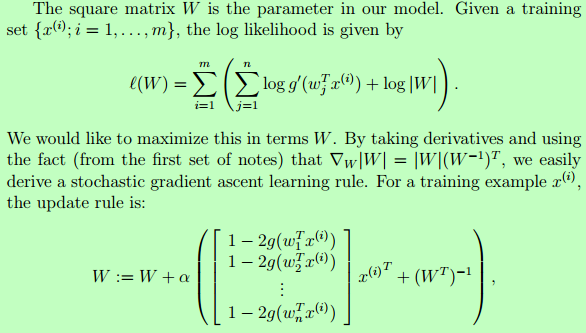

优化方法

Newton method:

Stochastic Gradient Ascent:

[Scikit-learn] 2.5 Dimensionality reduction - ICA的更多相关文章

- [UFLDL] Dimensionality Reduction

博客内容取材于:http://www.cnblogs.com/tornadomeet/archive/2012/06/24/2560261.html Deep learning:三十五(用NN实现数据 ...

- [Scikit-learn] 4.4 Dimensionality reduction - PCA

2.5. Decomposing signals in components (matrix factorization problems) 2.5.1. Principal component an ...

- Scikit Learn: 在python中机器学习

转自:http://my.oschina.net/u/175377/blog/84420#OSC_h2_23 Scikit Learn: 在python中机器学习 Warning 警告:有些没能理解的 ...

- Stanford机器学习笔记-10. 降维(Dimensionality Reduction)

10. Dimensionality Reduction Content 10. Dimensionality Reduction 10.1 Motivation 10.1.1 Motivation ...

- 可视化MNIST之降维探索Visualizing MNIST: An Exploration of Dimensionality Reduction

At some fundamental level, no one understands machine learning. It isn’t a matter of things being to ...

- scikit learn 模块 调参 pipeline+girdsearch 数据举例:文档分类 (python代码)

scikit learn 模块 调参 pipeline+girdsearch 数据举例:文档分类数据集 fetch_20newsgroups #-*- coding: UTF-8 -*- import ...

- 多因子降维法(MDR,multifactor dimensionality reduction)

多因子降维法(MDR,Multifactor Dimensionality Reduction ) MDR是近年统计学中发展起来的一种新的分析方法.其中,“因子” 即交互作用研究中的变量,“维” 是指 ...

- (原创)(三)机器学习笔记之Scikit Learn的线性回归模型初探

一.Scikit Learn中使用estimator三部曲 1. 构造estimator 2. 训练模型:fit 3. 利用模型进行预测:predict 二.模型评价 模型训练好后,度量模型拟合效果的 ...

- (原创)(四)机器学习笔记之Scikit Learn的Logistic回归初探

目录 5.3 使用LogisticRegressionCV进行正则化的 Logistic Regression 参数调优 一.Scikit Learn中有关logistics回归函数的介绍 1. 交叉 ...

随机推荐

- GIT——总结.1-

创建版本库 时光机穿梭 版本回退 工作区和暂存区 管理修改 撤销修改 删除文件 Git Git是目前世界上最先进的分布式版本控制系统(没有之一) Git是分布式版本控制系统 首先,分布式版本控制系统根 ...

- Android——BroadcastReceiver

注释:一般广播不会被阻断,有序广播则会被阻断 注释:这是用动态注册的广播,必须要解绑 xml <?xml version="1.0" encoding="utf-8 ...

- Git 提交更改

Jerry 已经提交的更改,他想纠正他的最后一次提交,在这种情况下,git 的修改将帮助操作.最后提交修改操作的变化,包括提交信息,它创建新的提交ID. 修改操作之前,他会检查提交日志. [jerry ...

- 【C】——网络编程-聊天室

功能介绍: 此demo是基于TCP套接字编程,目的是实现一个聊天室效果.类似于QQ群效果,如果上线可以通知其他好友,下线也会通知其他好友. 需要用的技术: 一.socket编程. 1> sock ...

- QueenPuzzle-N皇后问题

详见-算法之美-p180. #include <iostream> #include <memory.h> #include <conio.h> #include ...

- KindEditor使用初步

KindEditor是一套开源的HTML可视化编辑器,非常适合在CMS.商城.论坛.博客.Wiki.电子邮件等互联网应用上使用,目前在国内已经成为最受欢迎的编辑器之一.目前最新版本为4.1.9,详见h ...

- 自然语言交流系统 phxnet团队 创新实训 项目博客 (四)

刚开始做时,一点头绪都没有,整天的上网找资料,各种谷歌百度,各种博客论坛,搜索的关键词也无非是智能自然语言交流.智能机器人.中文问答系统等等等等.而我们的思路也是些零散的,例如我们知道会用到分词,会用 ...

- 关于Unity的开发思路

我现在的思路大概是这样的,2D游戏 Hierachy视图 有一个总的Canvas节点,挂载一个总的游戏控制脚本game_scene,下面有这样一些子节点 1.game_root:下面存放游戏界面中的物 ...

- python3 解决zip解压中文乱码问题,亲测可用, ZipFile

中文乱码是个很头疼的问题,找了好久都没用找到解决办法 后来也忘了在哪儿找到的解决办法, 很久以前了,但不可行, 解决了思路 在源码里面想要修改内容 if flags & 0x800: # UT ...

- 锐捷 ac ap 连接 记录

需要用到锐捷的ac管理2台ap.记录一下. 参考文档 锐捷WLAN无线产品一本通(V6.0): http://www.ruijie.com.cn/fw/wd/58033 1.确认AC无线交换机和AP是 ...