Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网。

使用VMW安装四台CentOS-7-x86_64-DVD-1804.iso虚拟机:

计划配置三台centos虚拟机:

master:192.168.0.120

slave1:192.168.0.121

slave2:192.168.0.122

slave3:192.168.0.123

资源分配情况:

每台虚拟机分配:内存2G,CPU核数1个,磁盘20G。

VMW配置及本地IPv4上网配置情况:

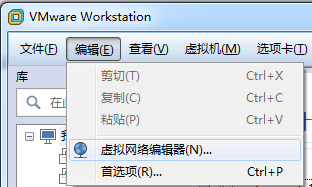

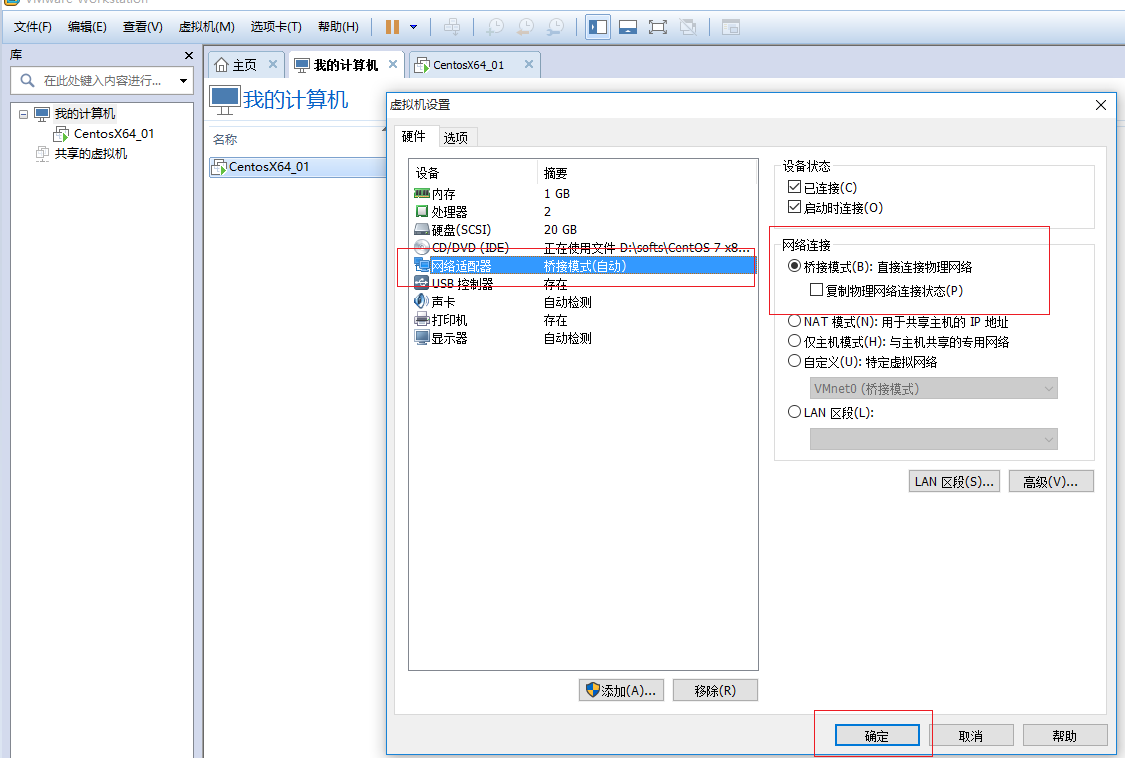

安装VMW,并设置其连接方式为桥接方式:

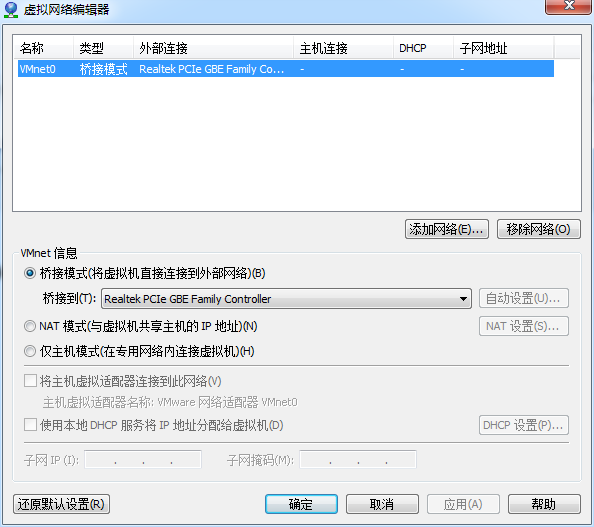

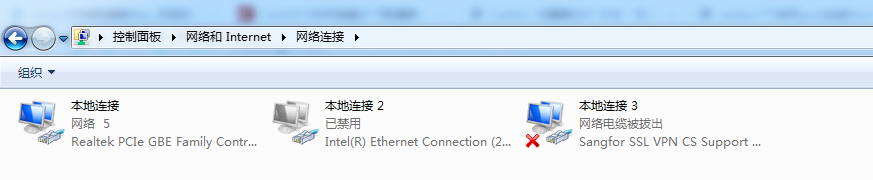

本地网络适配器除了“本地连接”外,其他都禁用:

本地连接的IPV4配置,这里采用的自适应方式:

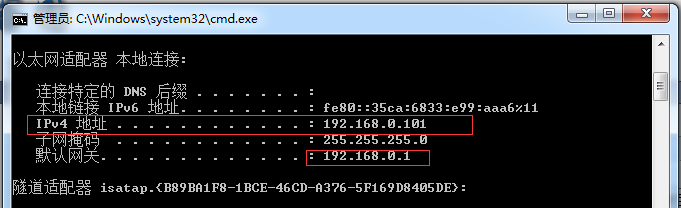

本地ipconfig如下:

安装CentOS

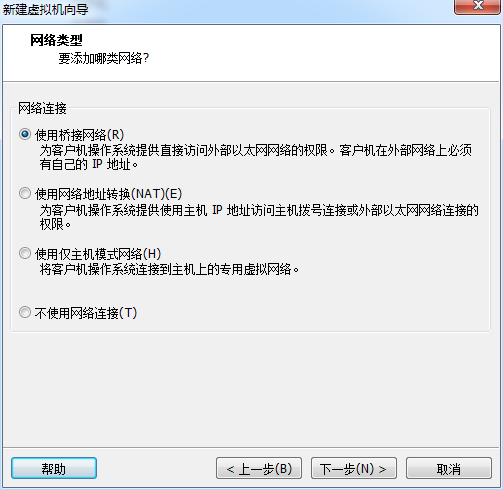

安装CentOS时,采用上网方式选取“使用桥接网络”:

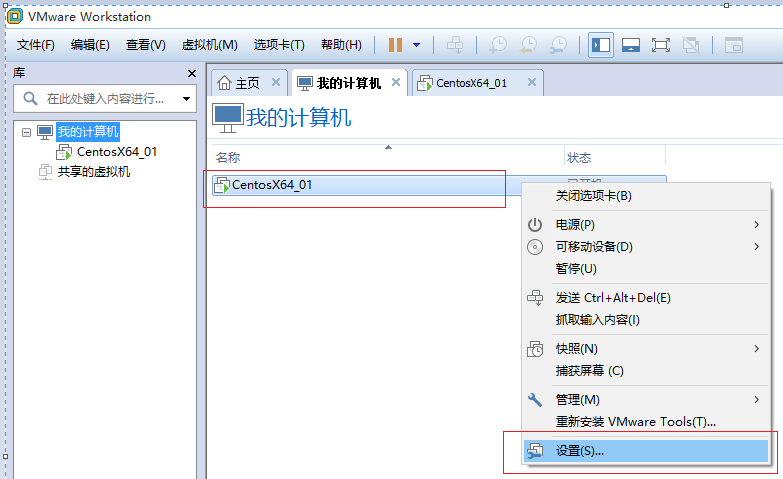

安装完后,确认是否采用“桥接”方式:

安装完后配置静态ip,dns及测试

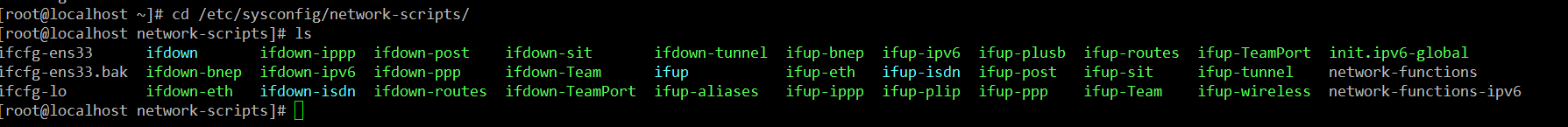

1)备份/etc/sysconfig/network-scripts/ifcfg-ens333

cd /etc/sysconfig/network-scripts/

scp ifcfg-ens333 ifcfg-ens333.bak

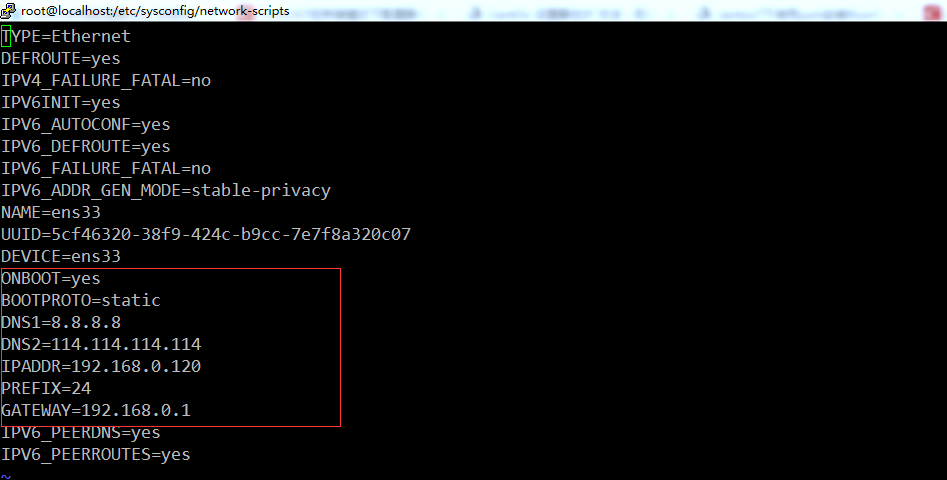

2)修改vi /etc/sysconfig/network-scripts/ifcfg-ens333

TYPE=Ethernet

DEFROUTE=yes

IPV4_FAILURE_FATAL=no

IPV6INIT=yes

IPV6_AUTOCONF=yes

IPV6_DEFROUTE=yes

IPV6_FAILURE_FATAL=no

IPV6_ADDR_GEN_MODE=stable-privacy

NAME=ens33

UUID=5cf46320-38f9-424c-b9cc-7e7f8a320c07 #每台服务器的该地址不同,请使用自己的虚拟机的UUID。

DEVICE=ens33

ONBOOT=yes

BOOTPROTO=static

DNS1=8.8.8.8

DNS2=114.114.114.114

IPADDR=192.168.0.120

PREFIX=

GATEWAY=192.168.0.1

IPV6_PEERDNS=yes

IPV6_PEERROUTES=yes

注意:图中圈中的配置信息是重点配置信息。

3)配置/etc/sysconfig/network:

# Created by anaconda

NETWORKING=yes

HOSTNAME=master

GATEWAY=192.168.0.1

slave节点,以slave1为例:

# Created by anaconda

NETWORKING=yes

HOSTNAME=slave1

GATEWAY=192.168.0.1

4)配置/etc/resolv.conf

# Generated by NetworkManager

nameserver 8.8.8.8

nameserver 114.114.114.114

注意:该信息也可以不配置,当重启网络后,会自动配置。

5)设置host名称

master(192.168.0.120)执行:

hostnamectl --static set-hostname master

hostnamectl status

slave1(192.168.0.121)执行:

hostnamectl --static set-hostname slave1

hostnamectl status

slave2(192.168.0.122)执行:

hostnamectl --static set-hostname slave2

hostnamectl status

slave3(192.168.0.123)执行:

hostnamectl --static set-hostname slave3

hostnamectl status

6)重启网络,测试:

[root@localhost network-scripts]# service network restart

Restarting network (via systemctl): [ OK ]

[root@localhost network-scripts]#

测试1:是否host名称修改成功

[spark@master ~]$ hostname

master

slave1,slave2,slave3依次验证。

测试2:是否可以连接本地

[root@localhost network-scripts]# ping 192.168.0.1

PING 192.168.0.1 (192.168.0.1) () bytes of data.

bytes from 192.168.0.1: icmp_seq= ttl= time=1.23 ms

bytes from 192.168.0.1: icmp_seq= ttl= time=1.13 ms

bytes from 192.168.0.1: icmp_seq= ttl= time=1.02 ms

测试3:是否可以连接其他虚拟机

[root@localhost network-scripts]# ping 192.168.0.121

PING 192.168.0.121 (192.168.0.121) () bytes of data.

bytes from 192.168.0.121: icmp_seq= ttl= time=0.860 ms

bytes from 192.168.0.121: icmp_seq= ttl= time=0.404 ms

测试4:是否可以上网,是否可以解析域名

[root@localhost network-scripts]# ping www.baidu.com

PING www.baidu.com (61.135.169.125) () bytes of data.

bytes from 61.135.169.125 (61.135.169.125): icmp_seq= ttl= time=2.92 ms

bytes from 61.135.169.125 (61.135.169.125): icmp_seq= ttl= time=4.46 ms

bytes from 61.135.169.125 (61.135.169.125): icmp_seq= ttl= time=3.98 ms

bytes from 61.135.169.125 (61.135.169.125): icmp_seq= ttl= time=2.83 ms

到此,所有服务器按照这么安装验证,经过上边三个测试验证就说明静态ip配置成功。

重启后,发现某一台服务器的不能的ifcfg-ens33配置的ip失效解决方案:《Centos7:Failed to start LSB: Bring up/down networking

》

Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网。的更多相关文章

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(二十四)Structured Streaming:Encoder

一般情况下我们在使用Dataset<Row>进行groupByKey时,你会发现这个方法最后一个参数需要一个encoder,那么这些encoder如何定义呢? 一般数据类型 static ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(二十一)NIFI1.7.1安装

一.nifi基本配置 1. 修改各节点主机名,修改/etc/hosts文件内容. 192.168.0.120 master 192.168.0.121 slave1 192.168.0.122 sla ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十三)kafka+spark streaming打包好的程序提交时提示虚拟内存不足(Container is running beyond virtual memory limits. Current usage: 119.5 MB of 1 GB physical memory used; 2.2 GB of 2.1 G)

异常问题:Container is running beyond virtual memory limits. Current usage: 119.5 MB of 1 GB physical mem ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十二)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网。

Centos7出现异常:Failed to start LSB: Bring up/down networking. 按照<Kafka:ZK+Kafka+Spark Streaming集群环境搭 ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十一)定制一个arvo格式文件发送到kafka的topic,通过Structured Streaming读取kafka的数据

将arvo格式数据发送到kafka的topic 第一步:定制avro schema: { "type": "record", "name": ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(十)安装hadoop2.9.0搭建HA

如何搭建配置centos虚拟机请参考<Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网.& ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(九)安装kafka_2.11-1.1.0

如何搭建配置centos虚拟机请参考<Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网.& ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(八)安装zookeeper-3.4.12

如何搭建配置centos虚拟机请参考<Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网.& ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(三)安装spark2.2.1

如何搭建配置centos虚拟机请参考<Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网.& ...

- Kafka:ZK+Kafka+Spark Streaming集群环境搭建(二)安装hadoop2.9.0

如何搭建配置centos虚拟机请参考<Kafka:ZK+Kafka+Spark Streaming集群环境搭建(一)VMW安装四台CentOS,并实现本机与它们能交互,虚拟机内部实现可以上网.& ...

随机推荐

- 让nginx支持HLS

准备工作: 1.安装nginx和rtmp模块 2.安装ffmepg(用来推流) 以上准备工作参见这篇博客:http://www.cnblogs.com/damiao/p/5231221.html 1. ...

- j.u.c系列(07)---之读写锁:ReentrantReadWriteLock

写在前面 重入锁ReentrantLock是排他锁,排他锁在同一时刻仅有一个线程可以进行访问,但是在大多数场景下,大部分时间都是提供读服务,而写服务占有的时间较少.然而读服务不存在数据竞争问题,如果一 ...

- MikroTik RouterOS官方教程Wiki(入门教程)

https://wiki.mikrotik.com/wiki/Manual:TOC 其实还有一本<ROS从入门到精通> 学习路由可以从这两个教程先入手.

- STM32 F4 SPI Accelerometer

STM32 F4 SPI Accelerometer

- PE Header and Export Table for Delphi

Malware Analysis Tutorial 8: PE Header and Export Table 2. Background Information of PE HeaderAny bi ...

- Syntactic and Semantic Errors

There are two kinds of errors that Basis can find. Syntax errors occur during the parsing of input c ...

- 【Go命令教程】4. go get

hc@ubt:~$ go get github.com/hyper-carrot/go_lib/logging 命令 go get 可以根据要求和实际情况从互联网上下载或更新指定的代码包及其依赖包,并 ...

- java之jvm学习笔记十三(jvm基本结构) 通俗易懂的JVM 文件,没有之一

http://blog.csdn.net/yfqnihao/article/details/8289363

- iOS objc_msgSend 报错解决方案

错误代码: objc_msgSend(self.beginRefreshingTaget, self.beginRefreshingAction, self); Too many arguments ...

- Ubuntu 14.04 用户如何安装 VLC 2.2.0

http://www.linuxidc.com/Linux/2014-03/98913.htm http://www.videolan.org/vlc/#download VLC 是一款自由开源.跨平 ...