理解图像分割中的卷积(Understand Convolution for Semantic Segmentation)

以最佳的101 layer的ResNet-DUC为基础,添加HDC,实验探究了几种变体:

- 无扩张卷积(no dilation):对于所有包含扩张卷积,设置r=1r=1

- 扩张卷积(dilation Conv ):对于所有包含扩张卷积,将2个block和为一组,设置第一个block的r=2r=2,第二个block的r=1r=1

- Dilation-RF:对于res4bres4b包含了23个blocks,使用的r=2r=2,设置3个block一组,r=1,2,3r=1,2,3.对于最后两个block,设置r=2r=2;对于res5bres5b,包含3个block,使用r=4r=4,设置为r=3,4,5r=3,4,5.

- Dilation-Bigger:对于res4bres4b模块,设置4个block为一组,设置r=1,2,5,9r=1,2,5,9.最后3个block设置为1,2,51,2,5;对于res5bres5b模块,设置r=5,9,17r=5,9,17

可以看到增加接收野大小会获得较高的精度。如下图所示:

ResNet-DUC-HDC在较大的目标物上表现较好。下图是局部放大:

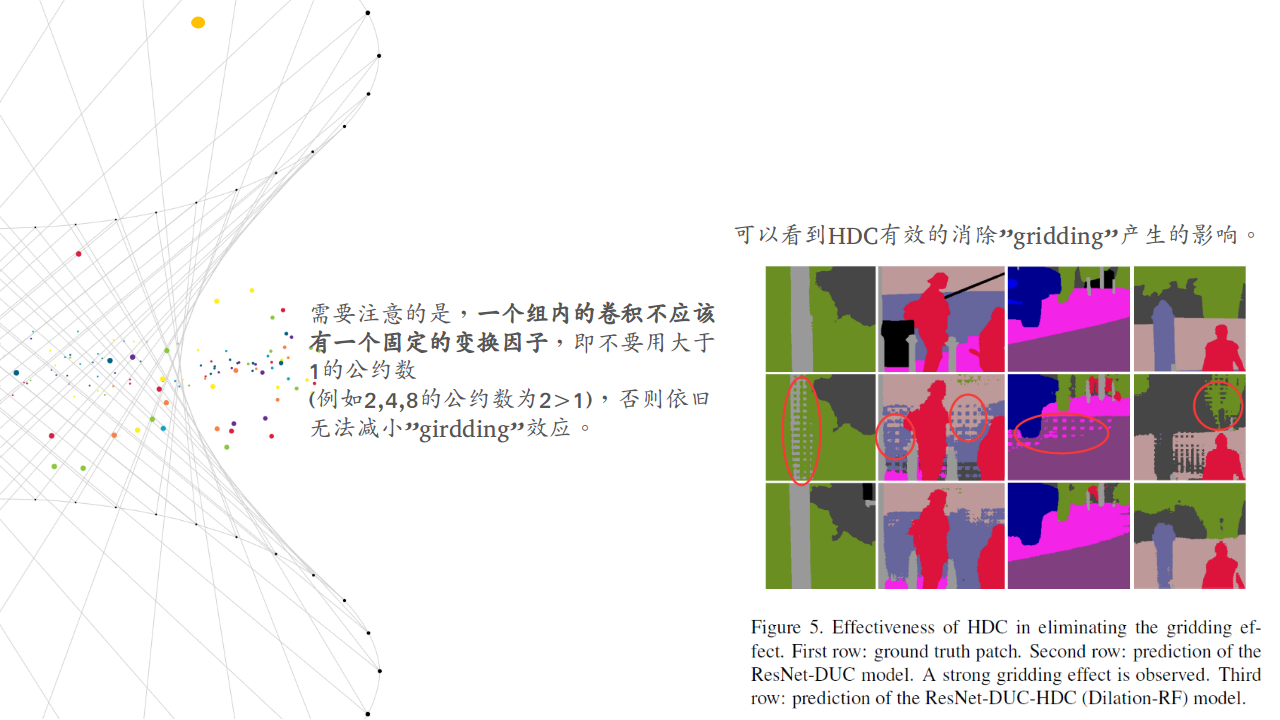

可以看到HDC有效的消除”gridding”产生的影响。

Deeper Networks: 同样尝试了将ResNet-101切换为ResNet-152,使用ResNet152先跑了10个epoch学习了BN层参数,再固定BN层,跑了20个epochs.结果如下:

ResNet152为基础层的有1%的提升。

Test Set Results: 论文将ResNet101开始的7×77×7卷积拆分为3个3×33×3的卷积,再不带CRF的情况下达到了80.1%mIoU.与其他先进模型相比如下:

模型同时在coarse labels跑了一圈,与同样以deliated convolution为主的DeepLabv2相比,提升了9.7%.

KITTI Road Segmentaiton

KITTI有289的训练图片和290个测试图片。示例如下:

因为数据集有限,为了避免过拟合。论文以100的步长在数据集中裁剪320×320320×320的patch. 使用预训练模型,结果如下:

结果达到了state-of-the-art水平.

PASCAL VOC2012 dataset

先用VOC2012训练集和MS-COCO数据集对ResNet-DUC做预训练。再使用VOC2012做fine-tune。使用的图片大小为512×512512×512。达到了state-of-the-art水平:

可视化结果如下:

Conclusion

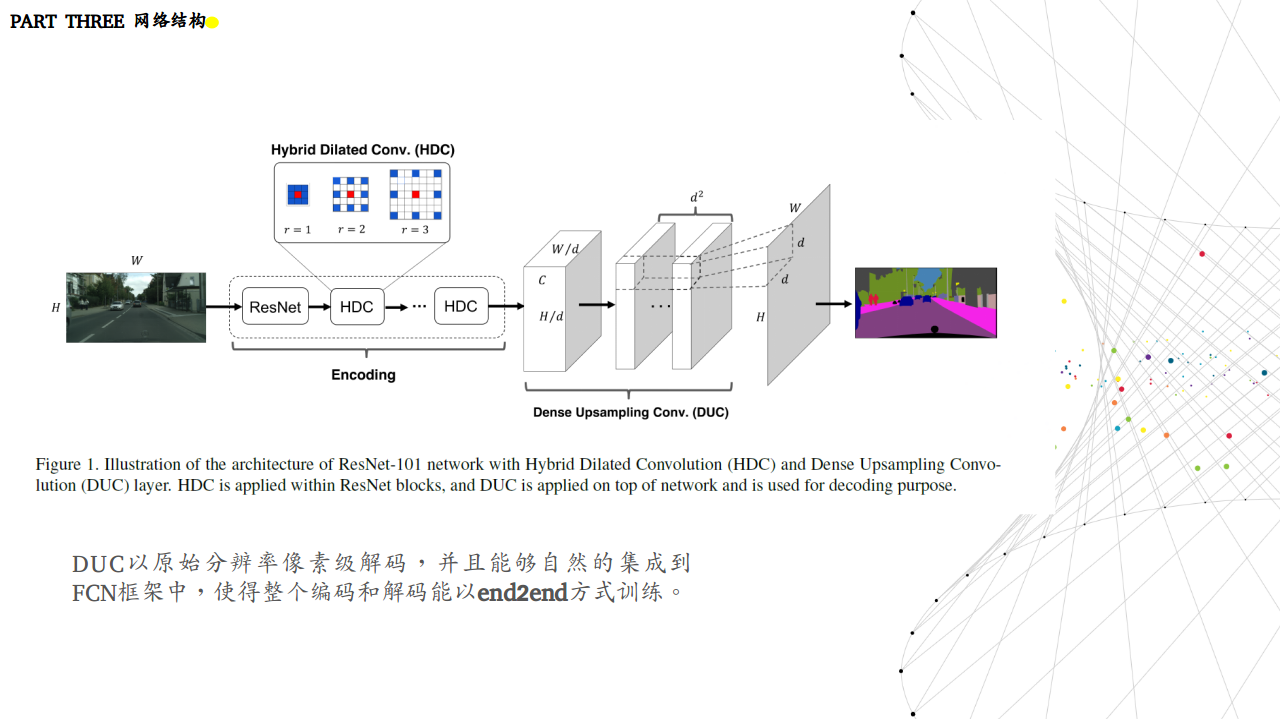

论文提出了简单有效的卷积操作改进语义分割系统。使用DUC恢复上采样丢失的信息,使用HDC在解决”gridding”的影响的同时扩大感受野。实验证明我们的框架对各种语义分割任务的有效性。

理解图像分割中的卷积(Understand Convolution for Semantic Segmentation)的更多相关文章

- 理解NLP中的卷积神经网络(CNN)

此篇文章是Denny Britz关于CNN在NLP中应用的理解,他本人也曾在Google Brain项目中参与多项关于NLP的项目. · 翻译不周到的地方请大家见谅. 阅读完本文大概需要7分钟左右的时 ...

- [转] 理解NLP中的卷积&&Pooling

转自:http://blog.csdn.net/malefactor/article/details/51078135 CNN是目前自然语言处理中和RNN并驾齐驱的两种最常见的深度学习模型.图1展示了 ...

- 彻底理解数字图像处理中的卷积-以Sobel算子为例

彻底理解数字图像处理中的卷积-以Sobel算子为例 作者:FreeBlues 修订记录 2016.08.04 初稿完成 概述 卷积在信号处理领域有极其广泛的应用, 也有严格的物理和数学定义. 本文只讨 ...

- caffe中全卷积层和全连接层训练参数如何确定

今天来仔细讲一下卷基层和全连接层训练参数个数如何确定的问题.我们以Mnist为例,首先贴出网络配置文件: name: "LeNet" layer { name: "mni ...

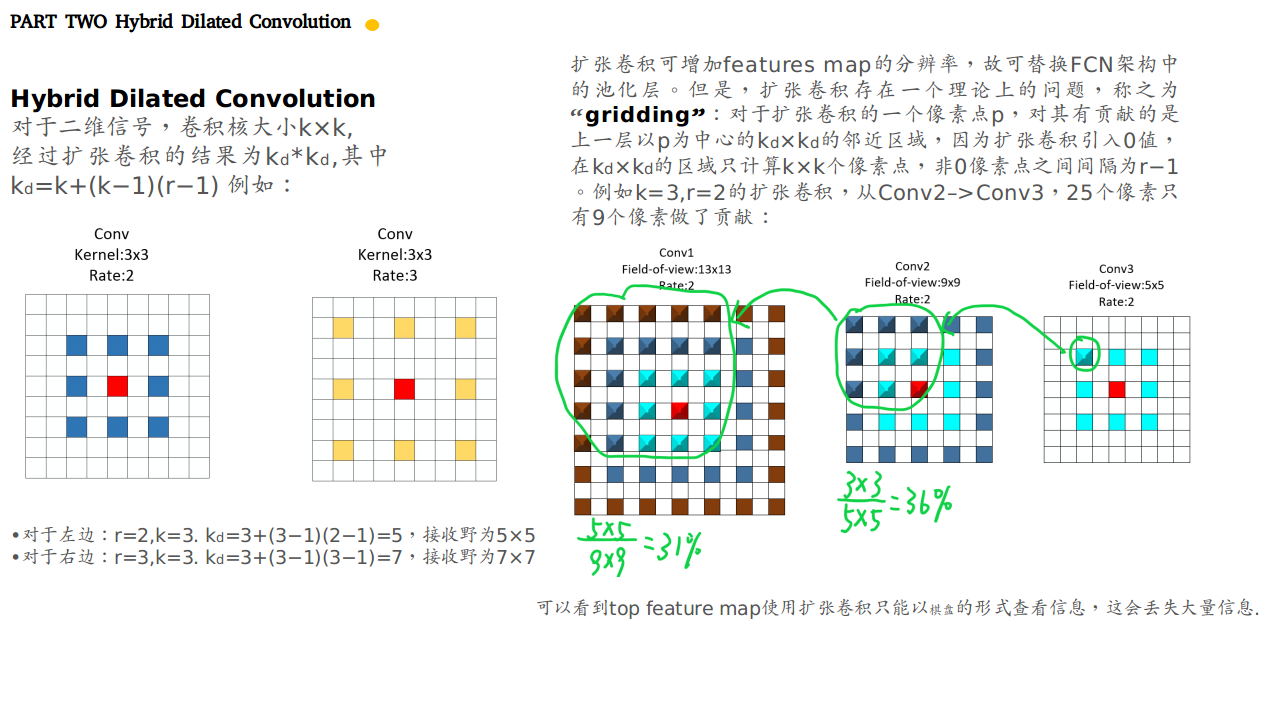

- [翻译] 扩张卷积 (Dilated Convolution)

英文原文: Dilated Convolution 简单来说,扩张卷积只是运用卷积到一个指定间隔的输入.按照这个定义,给定我们的输入是一个2维图片,扩张率 k=1 是通常的卷积,k=2 的意思是每个输 ...

- [转]CNN 中千奇百怪的卷积方式大汇总

https://www.leiphone.com/news/201709/AzBc9Sg44fs57hyY.html 推荐另一篇很好的总结:变形卷积核.可分离卷积?卷积神经网络中十大拍案叫绝的操作. ...

- CNN中千奇百怪的卷积方式大汇总

1.原始版本 最早的卷积方式还没有任何骚套路,那就也没什么好说的了. 见下图,原始的conv操作可以看做一个2D版本的无隐层神经网络. 附上一个卷积详细流程: [TensorFlow]tf.nn.co ...

- 从图(Graph)到图卷积(Graph Convolution):漫谈图神经网络模型 (二)

本文属于图神经网络的系列文章,文章目录如下: 从图(Graph)到图卷积(Graph Convolution):漫谈图神经网络模型 (一) 从图(Graph)到图卷积(Graph Convolutio ...

- 从图(Graph)到图卷积(Graph Convolution):漫谈图神经网络模型 (一)

本文属于图神经网络的系列文章,文章目录如下: 从图(Graph)到图卷积(Graph Convolution):漫谈图神经网络模型 (一) 从图(Graph)到图卷积(Graph Convolutio ...

随机推荐

- HTML 标签小细节

简书地址:https://www.jianshu.com/p/03a23aa28a34 今天重新学习了一下HTML中标签的用法,补充并记录一下自己新学到的知识. a中的href href Contai ...

- Python进阶开发之元类编程

系列文章 √第一章 元类编程,已完成 ; 本文目录 类是如何产生的如何使用type创建类理解什么是元类使用元类的意义元类实战:ORM . 类是如何产生的 类是如何产生?这个问题肯定很傻.实则不然,很多 ...

- 洛谷 P1430 解题报告

P1430 序列取数 题目描述 给定一个长为\(n\)的整数序列\((n<=1000)\),由\(A\)和\(B\)轮流取数(\(A\)先取).每个人可从序列的左端或右端取若干个数(至少一个), ...

- Python_自定义有向图

directedGraph.py class DirectedGraph(object): def __init__(self,d): if isinstance(d,dict): self.__gr ...

- IT连创业系列:近期功能调整(小魔术功能从二级目录调整到一级栏目)

最近花了点时间,折腾了一下.NET Core,因此有几篇 Taurus.MVC + CYQ.Data 的文章出来. 这两天也顺带把 ASP.NET Aries 升级了一下功能, 也计划支持.NET C ...

- Spring Boot实战笔记(一)-- Spring简介

一.Spring 概述 Spring框架是一个轻量级的企业级开发的一站式解决方案.所谓的解决方案就是可以基于Spring解决所有的Java EE开发的所有问题. Spring框架主要提供了Ioc(In ...

- Redis的并发竞争问题的解决方案总结

什么是Redis的并发竞争问题 Redis的并发竞争问题,主要是发生在并发写竞争. 考虑到redis没有像db中的sql语句,update val = val + 10 where ...,无法使用这 ...

- MySQL性能调优——锁定机制与锁优化分析

针对多线程的并发访问,任何一个数据库都有其锁定机制,它的优劣直接关系着数据的一致完整性与数据库系统的高并发处理性能.锁定机制也因此成了各种数据库的核心技术之一.不同数据库存储引擎的锁定机制是不同的,本 ...

- NIO之FileChannel类的理解和使用

文章链接:http://blog.csdn.net/qq_16628781/article/details/70532307 知识点: FileChannel类及方法理解: 普通输入输出流复制文件: ...

- maven的pom文件中指定编译的版本

<build> <plugins> <plugin> <groupId>org.apache.maven.plugins</groupId> ...