Kafka Producer Consumer

Producer API

org.apache.kafka.clients.producer.KafkaProducer

props.put("bootstrap.servers", "192.168.1.128:9092");

props.put("acks", "all");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("linger.ms", 1);

props.put("buffer.memory", 33554432);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = new KafkaProducer<String, String>(props);

for (int i = 0; i < 10; i++) {

producer.send(new ProducerRecord<String, String>("foo", Integer.toString(i), Integer.toString(i)), new Callback() {

@Override

public void onCompletion(RecordMetadata recordMetadata, Exception e) {

if (null != e) {

e.printStackTrace();

}else {

System.out.println("callback: " + recordMetadata.topic() + " " + recordMetadata.offset());

}

}

});

}

producer.close();

producer由一个缓冲池组成,这个缓冲池中维护着那些还没有被传送到服务器上的记录,而且有一个后台的I/O线程负责将这些记录转换为请求并将其传送到集群上去。

send()方法是异步的。当调用它以后就把记录放到buffer中并立即返回。这就允许生产者批量的发送记录。

acks配置项控制的是完成的标准,即什么样的请求被认为是完成了的。本例中其值设置的是"all"表示客户端会等待直到所有记录完全被提交,这是最慢的一种方式也是持久化最好的一种方式。

如果请求失败了,生产者可以自动重试。因为这里我们设置retries为0,所以它不重试。

生产者对每个分区都维护了一个buffers,其中放的是未被发送的记录。这些buffers的大小是通过batch.size配置项来控制的。

默认情况下,即使一个buffer还有未使用的空间(PS:buffer没满)也会立即发送。如果你想要减少请求的次数,你可以设置linger.ms为一个大于0的数。这个指令将告诉生产者在发送请求之前先等待多少毫秒,以希望能有更多的记录到达好填满buffer。在本例中,我们设置的是1毫秒,表示我们的请求将会延迟1毫秒发送,这样做是为了等待更多的记录到达,1毫秒之后即使buffer没有被填满,请求也会发送。(PS:稍微解释一下这段话,producer调用send()方法只是将记录放到buffer中,然后由一个后台线程将buffer中的记录传送到服务器上。这里所说的请求指的是从buffer到服务器。默认情况下记录被放到buffer以后立即被发送到服务器,为了减少请求服务器的次数,可以通过设置linger.ms,这个配置项表示等多少毫秒以后再发送,这样做是希望每次请求可以发送更多的记录,以此减少请求次数)

buffer.memory控制的是总的buffer内存数量

key.serializer 和 value.serializer表示怎样将key和value对象转成字节

从kafka 0.11开始,KafkaProducer支持两种模型:the idempotent producer and the transactional producer(幂等producer和事务producer)。幂等producer强调的是至少一次精确的投递。事务producer允许应用程序原子的发送消息到多个分区或者主题。

为了启用幂等性,必须将enable.idempotence这个配置的值设为true。如果你这样设置了,那么retries默认是Integer.MAX_VALUE,并且acks默认是all。为了利用幂等producer的优势,请避免应用程序级别的重新发送。

为了使用事务producer,你必须配置transactional.id。如果transactional.id被设置,幂等性自动被启用。

Properties props = new Properties();

props.put("bootstrap.servers", "192.168.1.128:9092");

props.put("transactional.id", "my-transactional-id"); Producer<String, String> producer = new KafkaProducer<String, String>(props, new StringSerializer(), new StringSerializer()); producer.initTransactions(); try {

producer.beginTransaction(); for (int i = 11; i < 20; i++) {

producer.send(new ProducerRecord<String, String>("bar", Integer.toString(i), Integer.toString(i)));

}

// This method will flush any unsent records before actually committing the transaction

producer.commitTransaction();

} catch (ProducerFencedException | OutOfOrderSequenceException | AuthorizationException e) {

producer.close();

} catch (KafkaException e) {

// By calling producer.abortTransaction() upon receiving a KafkaException we can ensure

// that any successful writes are marked as aborted, hence keeping the transactional guarantees.

producer.abortTransaction();

} producer.close();

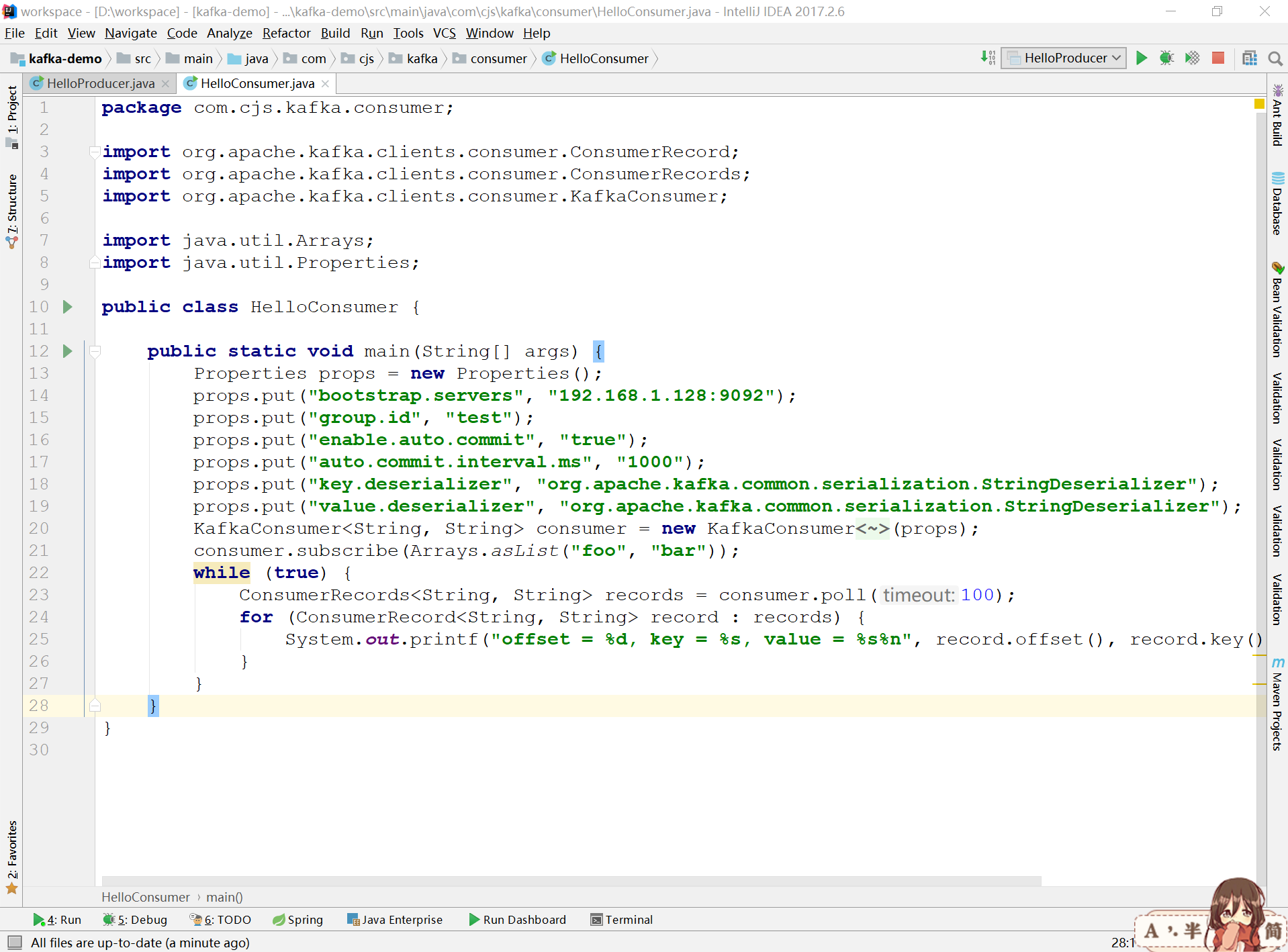

Consumer API

org.apache.kafka.clients.consumer.KafkaConsumer

Offsets and Consumer Position

对于分区中的每条记录,kafka维护一个数值偏移量。这个偏移量是分区中一条记录的唯一标识,同时也是消费者在分区中的位置。例如,一个消费者在分区中的位置是5,表示它已经消费了偏移量从0到4的记录,并且接下来它将消费偏移量为5的记录。相对于消费者用户来说,这里实际上有两个位置的概念。

消费者的position表示下一条将要消费的记录的offset。每次消费者通过调用poll(long)接收消息的时候这个position会自动增加。

committed position表示已经被存储的最后一个偏移量。消费者可以自动的周期性提交offsets,也可以通过调用提交API(e.g. commitSync and commitAsync)手动的提交position。

Consumer Groups and Topic Subscriptions

Kafka用"consumer groups"(消费者组)的概念来允许一组进程分开处理和消费记录。这些处理在同一个机器上进行,也可以在不同的机器上。同一个消费者组中的消费者实例有相同的group.id

组中的每个消费者可以动态设置它们想要订阅的主题列表。Kafka给每个订阅的消费者组都投递一份消息。这归功于消费者组中所有成员之间的均衡分区,以至于每个分区都可以被指定到组中精确的一个消费者。假设一个主题有4个分区,一个组中有2个消费者,那么每个消费者将处理2个分区。

消费者组中的成员是动态维护的:如果一个消费者处理失败了,那么分配给它的分区将会被重新分给组中其它消费者。

在概念上,你可以把一个消费者组想象成一个单个的逻辑订阅者,并且每个逻辑订阅者由多个进程组成。作为一个多订阅系统,Kafka天生就支持对于给定的主题可以有任意数量的消费者组。

Automatic Offset Committing

Properties props = new Properties();

props.put("bootstrap.servers", "192.168.1.128:9092");

props.put("group.id", "test");

props.put("enable.auto.commit", "true");

props.put("auto.commit.interval.ms", "1000");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<String, String>(props);

consumer.subscribe(Arrays.asList("foo", "bar"));

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records) {

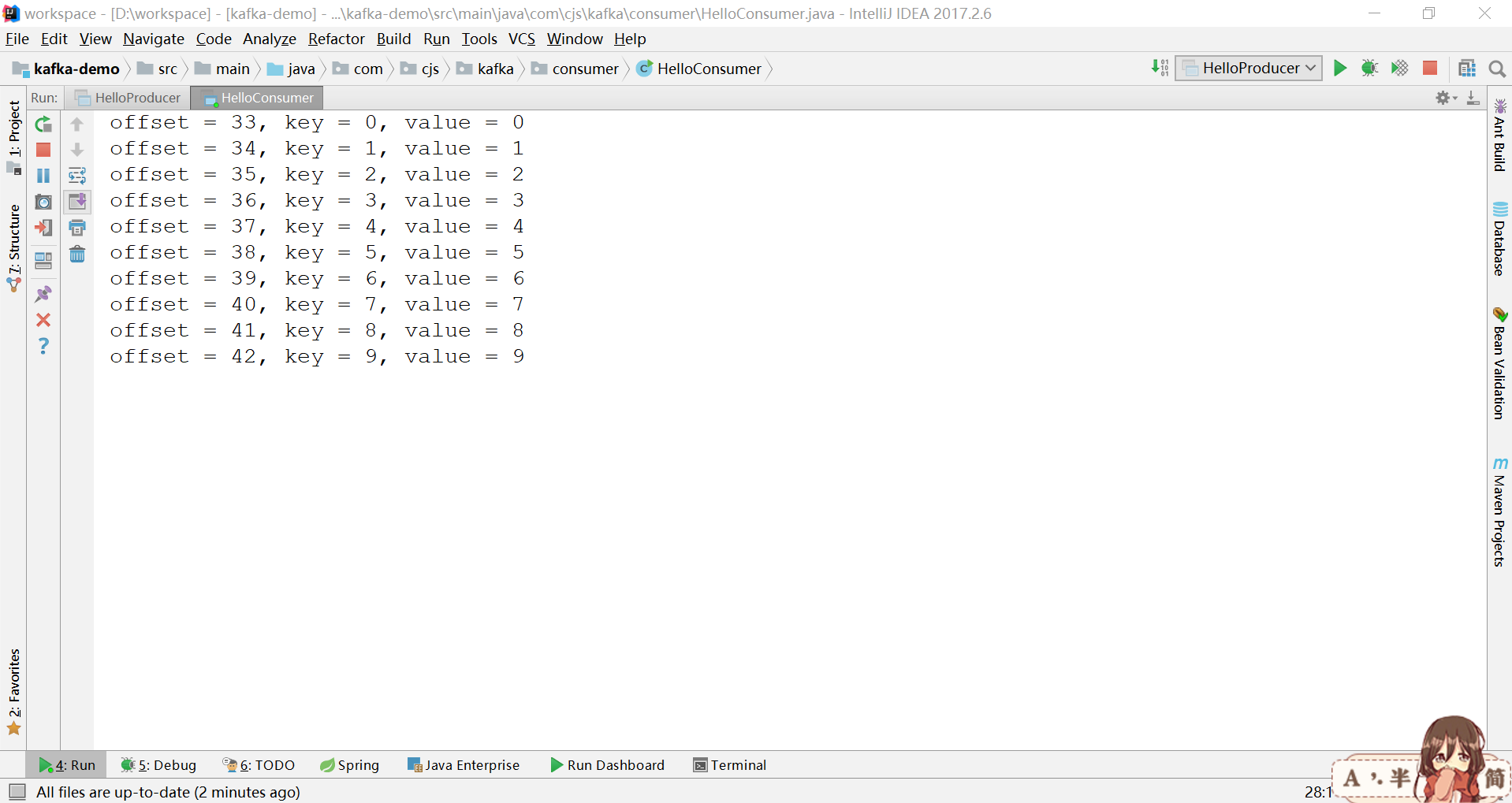

System.out.printf("offset = %d, key = %s, value = %s%n", record.offset(), record.key(), record.value());

}

}

设置enable.auto.commit意味着自动提交已消费的记录的offset

Manual Offset Control

代替消费者周期性的提交已消费的offsets,用户可以控制什么时候记录被认为是已经消费并提交它们的offsets。

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "test");

props.put("enable.auto.commit", "false");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Arrays.asList("foo", "bar"));

final int minBatchSize = 200;

List<ConsumerRecord<String, String>> buffer = new ArrayList<>();

while (true) {

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records) {

buffer.add(record);

}

if (buffer.size() >= minBatchSize) {

insertIntoDb(buffer);

consumer.commitSync();

buffer.clear();

}

}

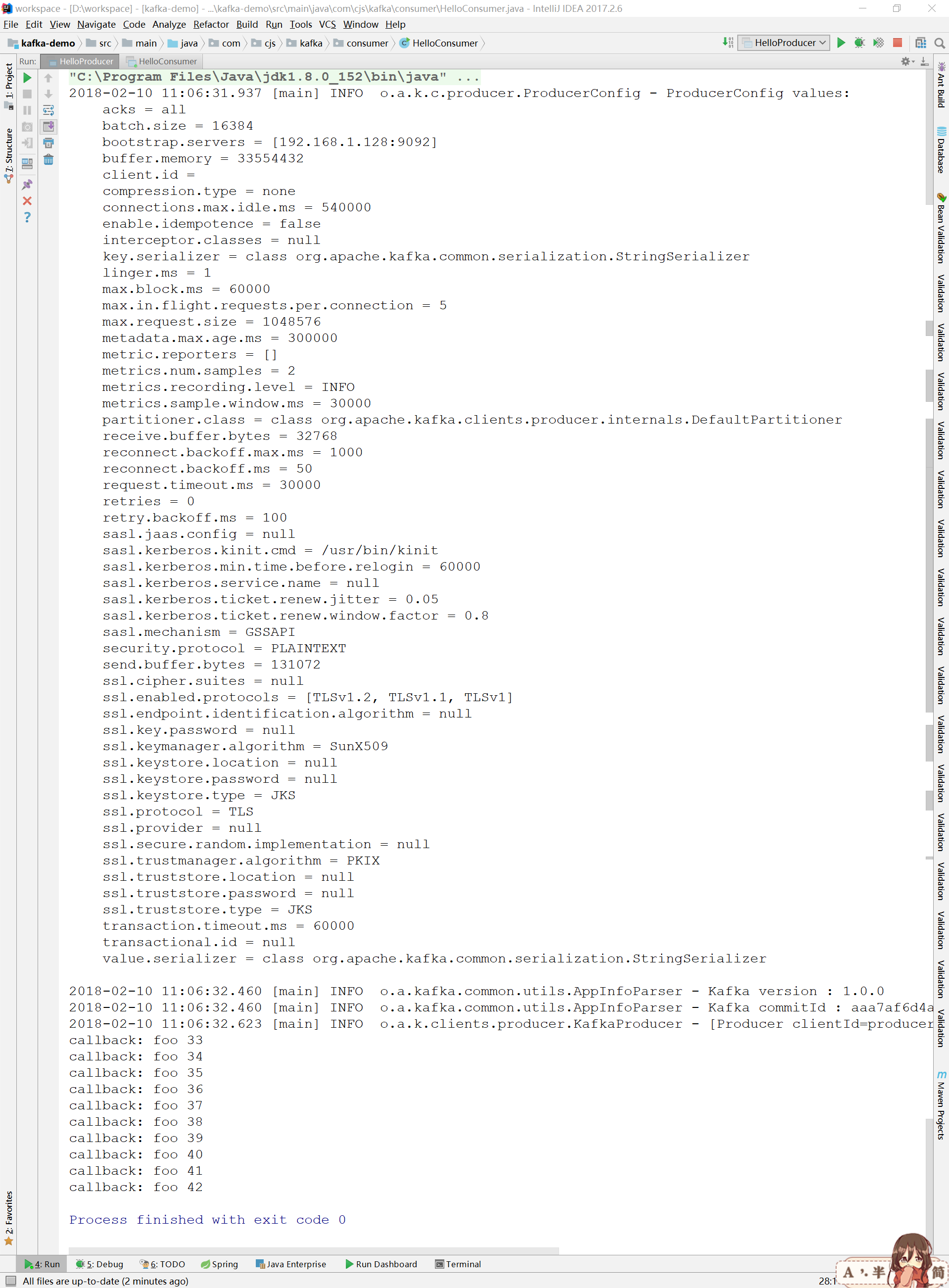

代码演示

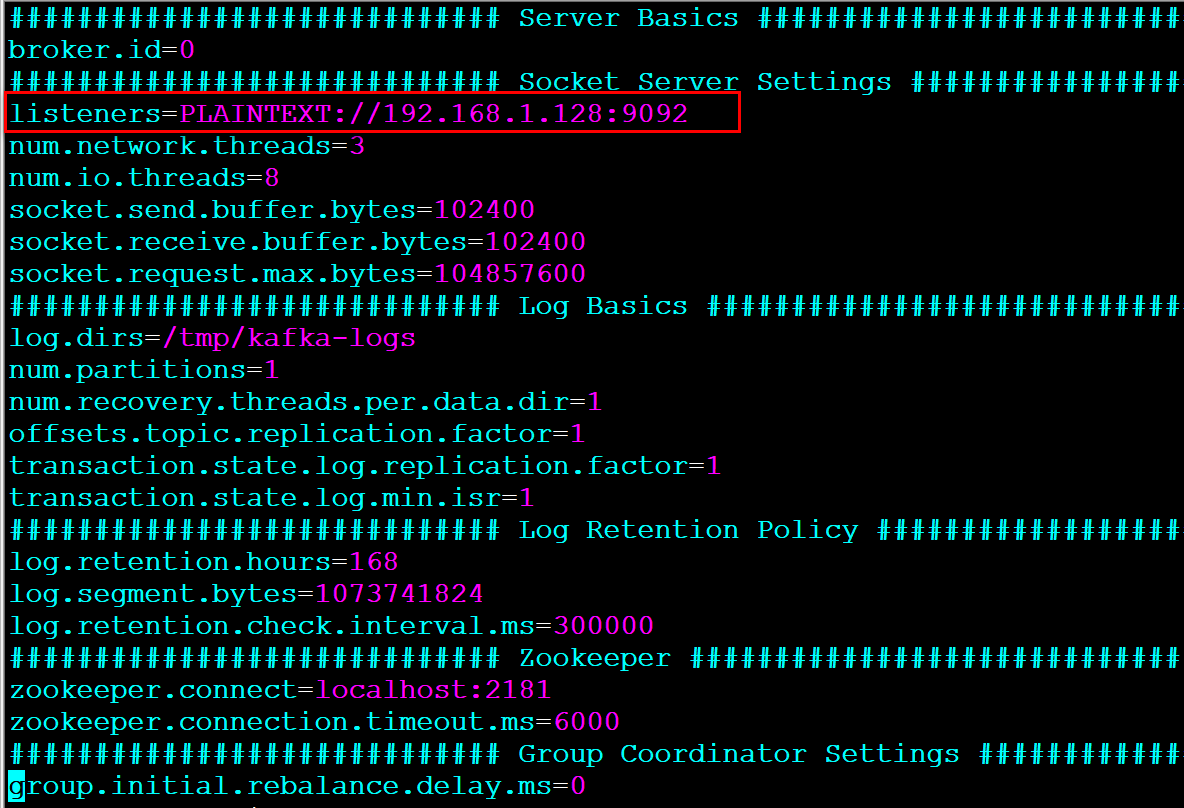

服务器端

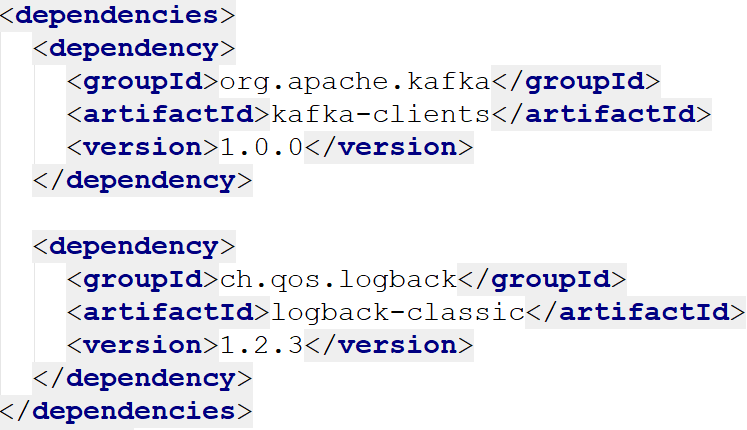

客户端

参考

http://kafka.apache.org/10/javadoc/index.html?org/apache/kafka/clients/producer/KafkaProducer.html

http://kafka.apache.org/10/javadoc/index.html?org/apache/kafka/clients/consumer/KafkaConsumer.html

Kafka Producer Consumer的更多相关文章

- kafka producer consumer demo(三)

我们在前面把集群搭建起来了,也设置了kafka broker的配置,下面我们用代码来实现一下客户端向kafka发送消息,consumer端从kafka消费数据.大家先不要着急着了解 各种参数的配置,先 ...

- Kettle安装Kafka Consumer和Kafka Producer插件

1.从github上下载kettle的kafka插件,地址如下 Kafka Consumer地址: https://github.com/RuckusWirelessIL/pentaho-kafka- ...

- kafka producer自定义partitioner和consumer多线程

为了更好的实现负载均衡和消息的顺序性,Kafka Producer可以通过分发策略发送给指定的Partition.Kafka Java客户端有默认的Partitioner,平均的向目标topic的各个 ...

- Kafka 学习笔记之 Kafka0.11之producer/consumer(Scala)

Kafka0.11之producer/consumer(Scala): KafkaConsumer: import java.util.Properties import org.apache.kaf ...

- Kafka 学习笔记之 Producer/Consumer (Scala)

既然Kafka使用Scala写的,最近也在慢慢学习Scala的语法,虽然还比较生疏,但是还是想尝试下用Scala实现Producer和Consumer,并且用HashPartitioner实现消息根据 ...

- kafka producer源码

producer接口: /** * Licensed to the Apache Software Foundation (ASF) under one or more * contributor l ...

- 关于Kafka 的 consumer 消费者处理的一些见解

前言 在上一篇 Kafka使用Java实现数据的生产和消费demo 中介绍如何简单的使用kafka进行数据传输.本篇则重点介绍kafka中的 consumer 消费者的讲解. 应用场景 在上一篇kaf ...

- 关于Kafka java consumer管理TCP连接的讨论

本篇是<关于Kafka producer管理TCP连接的讨论>的续篇,主要讨论Kafka java consumer是如何管理TCP连接.实际上,这两篇大部分的内容是相同的,即consum ...

- Kafka producer介绍

Kafka 0.9版本正式使用Java版本的producer替换了原Scala版本的producer.本文着重讨论新版本producer的设计原理以及基本的使用方法. 新版本Producer 首先明确 ...

随机推荐

- 2017 Multi-University Training Contest - Team 9 1005&&HDU 6165 FFF at Valentine【强联通缩点+拓扑排序】

FFF at Valentine Time Limit: 6000/3000 MS (Java/Others) Memory Limit: 65536/65536 K (Java/Others) ...

- 【Java学习笔记之五】java数组详解

数组 概念 同一种类型数据的集合.其实数组就是一个容器. 数组的好处 可以自动给数组中的元素从0开始编号,方便操作这些元素. 格式1: 元素类型[] 数组名 = new 元素类型[元素个数或数组长度] ...

- HDU 2546 饭卡(01背包裸题)

饭卡 Time Limit: 5000/1000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Others) Total Submiss ...

- CodeM美团点评编程大赛初赛B轮 黑白树【DFS深搜+暴力】

[编程题] 黑白树 时间限制:1秒 空间限制:32768K 一棵n个点的有根树,1号点为根,相邻的两个节点之间的距离为1.树上每个节点i对应一个值k[i].每个点都有一个颜色,初始的时候所有点都是白色 ...

- hdu_1573 X问题(不互素的中国剩余定理)

题目链接:http://acm.hdu.edu.cn/showproblem.php?pid=1573 X问题 Time Limit: 1000/1000 MS (Java/Others) Me ...

- android小说阅读源码、bilibili源码、MVP新闻源码等

Android精选源码 一款基于 MVP+RxJava2+Retrofit2 的应用--熊猫眼 android 五子棋源码分享 android实现全国地图点击效果 android实现立体图案绘制的代码 ...

- maven学习3,如何创建一个web项目

Maven学习 (三) 使用m2eclipse创建web项目 1.首先确认你的eclipse已经安装好m2eclipse的环境,可以参照上两篇Maven学习内容 2.新建一个maven的项目 ...

- C语言中结构体赋值问题的讨论(转载)

今天帮师姐调一个程序的BUG,师姐的程序中有个结构体直接赋值的语句,在我印象中结构体好像是不能直接赋值的,正如数组不能直接赋值那样,我怀疑这个地方有问题,但最后证明并不是这个问题.那么就总结一下C语言 ...

- Android开发之漫漫长途 XII——Fragment详解

该文章是一个系列文章,是本人在Android开发的漫漫长途上的一点感想和记录,我会尽量按照先易后难的顺序进行编写该系列.该系列引用了<Android开发艺术探索>以及<深入理解And ...

- thinkphp5自动完成