深度学习环境搭建(Windows11)

深度学习环境的搭建(Windows11)

偶然重装了系统,在此记录下环境的恢复

基本深度学习环境的搭建,包括Anaconda+CUDA+cuDNN+Pytorch+TensorRT的安装与配置。

ps:显卡为 RTX 4060 Laptop GPU

1.安装Python

前往Python官网https://www.python.org/getit/,下载最新版Python并安装即可。

2.安装Anaconda3

前往Anaconda官网https://www.anaconda.com/download,下载最新版Anaconda安装包

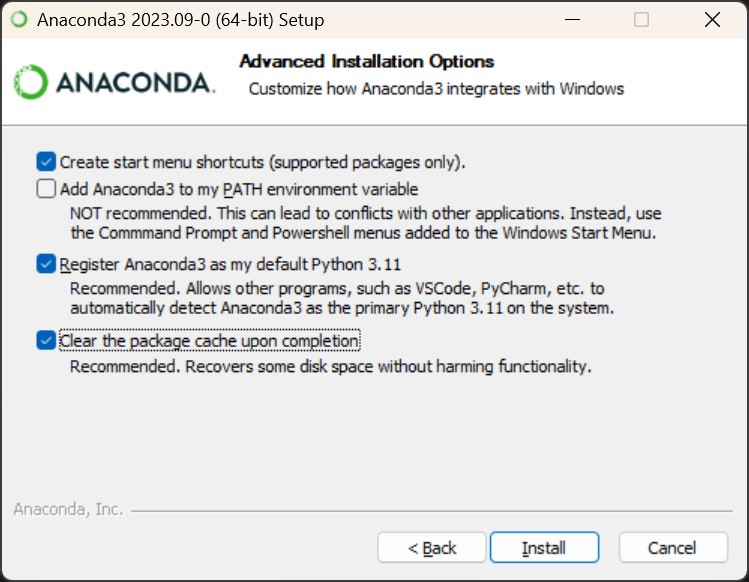

运行安装包,选择安装位置,我这里是C:\Users\username\anaconda3,大概需要5.7G空间,高级安装选项设置如下图:

2.1配置vscode终端自动激活对应的conda环境

方法一

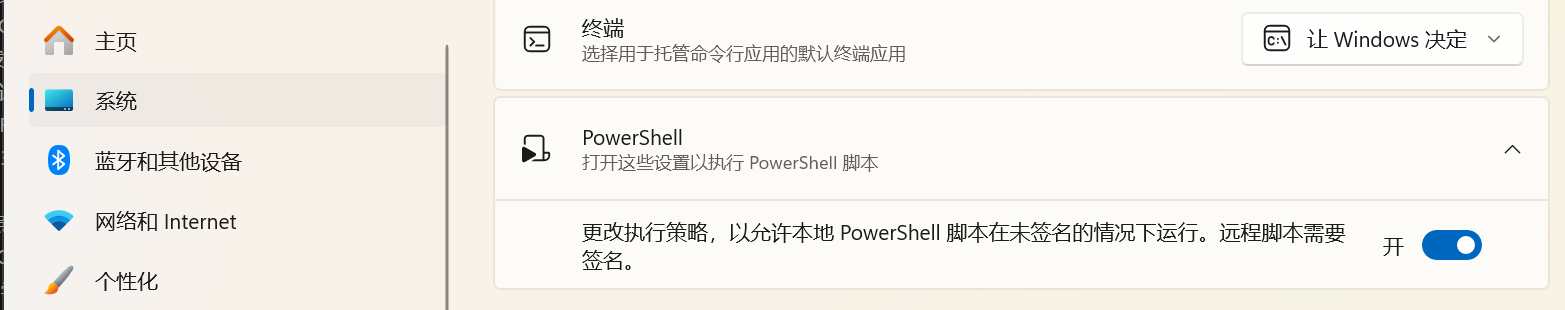

- 首先打开

设置菜单,找到系统->开发者选项->PowerShell, 开启选项更改执行策略····, 以允许power shell加载运行本地脚本

- 以管理员身份打开Anaconda Powershell prompt,运行conda初始化脚本即可:

conda init powershell

这样,conda会在$PROFILE所在文件夹下生成一个ps1脚本,每次打开终端,就会自动执行,从而切换到conda环境,内容如下:

#region conda initialize

# !! Contents within this block are managed by 'conda init' !!

If (Test-Path "C:\Users\username\anaconda3\Scripts\conda.exe") {

(& "C:\Users\username\anaconda3\Scripts\conda.exe" "shell.powershell" "hook") | Out-String | ?{$_} | Invoke-Expression

}

#endregion

- 大功告成。这样你的power shell就可以直接使用conda acitvate等命令了。

方法二

如果你希望你的power shell还是安装anaconda之前的状态,并且出于安全考虑,不想要更改power shell的默认执行策略,毕竟上面的选项开了之后一般就得一直开着了,什么本地power shell脚本都可以直接运行了,这时候可以考虑以下的办法:

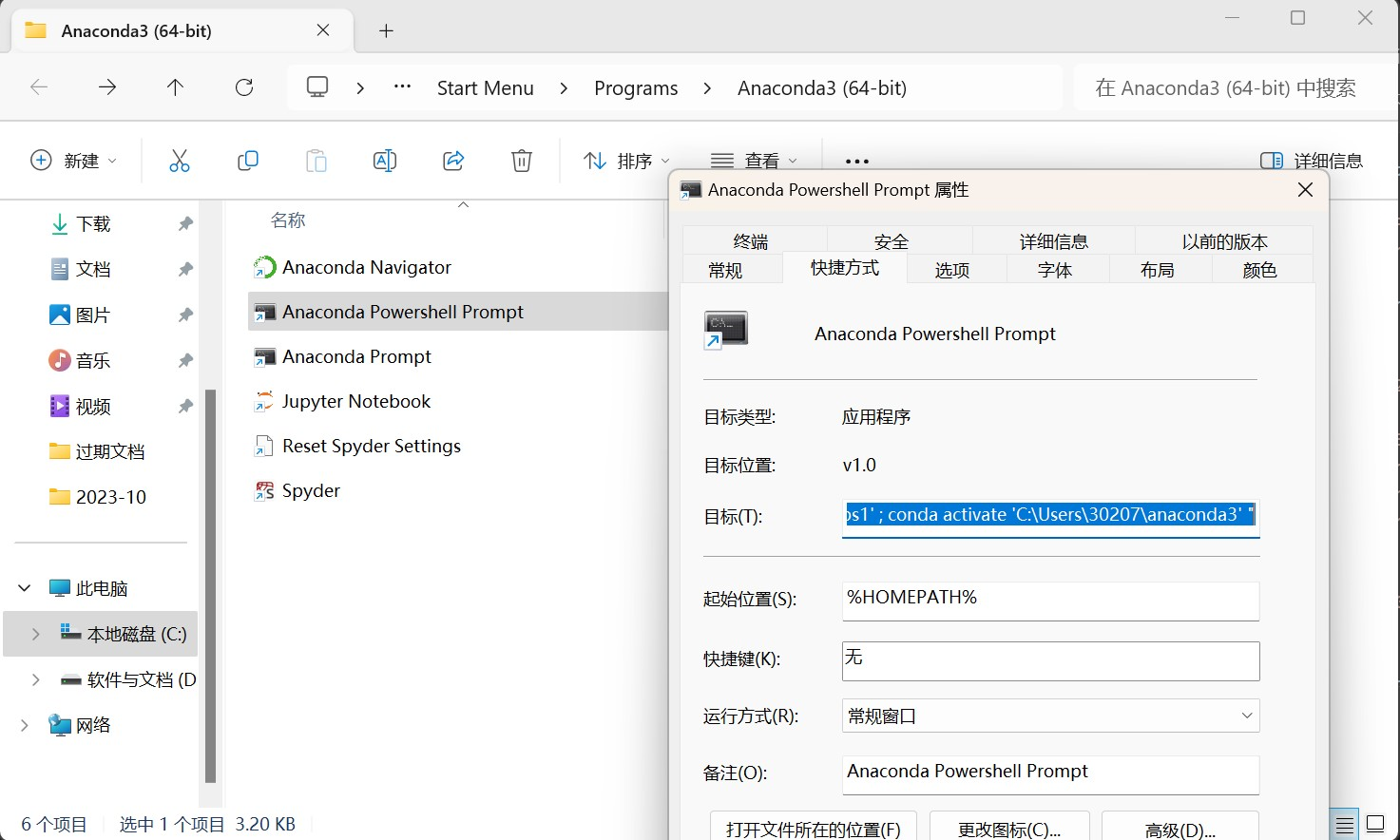

由于vscode默认的终端为power shell,我们需要参考Anaconda Powershell prompt脚本新建一个新的终端配置:

首先ctrl+shift+p,输入setting,找到首选项:打开设置(json)这一项即可打开settings.json

在settings.json中添加如下配置:

"terminal.integrated.profiles.windows": {

"PowerShell": {

"source": "PowerShell",

"icon": "terminal-powershell"

},

"Command PowerShell Prompt": {

"path": [

"${env:windir}\\System32\\WindowsPowerShell\\v1.0\\powershell.exe"

],

"args": ["-ExecutionPolicy","ByPass","-NoExit","-Command", "C:\\Users\\username\\anaconda3\\shell\\condabin\\conda-hook.ps1"],

"icon": "terminal-powershell"

},

"Git Bash": {

"source": "Git Bash"

}

},

"terminal.integrated.defaultProfile.windows": "Command PowerShell Prompt"

配置内容参考自下图目标栏:

其原理就是靠着args参数中的-ExecutionPolicy参数,将执行策略设置为ByPass,临时更改执行策略以执行conda-hook脚本,从而激活虚拟环境。

3.安装Git工具

前往Git官网https://git-scm.com/download/win下载并安装即可。

4.安装CUDA Toolkit

安装CUDA前请确保已安装好驱动,nvidia驱动下载地址:https://www.nvidia.cn/Download/index.aspx?lang=cn

然后在命令行中输入nvidia-smi 查看显卡支持的最高CUDA版本,我这个是12.0

PS C:\Users\username> nvidia-smi

Thu Oct 19 11:40:58 2023

+-----------------------------------------------------------------------------+

| NVIDIA-SMI 528.92 Driver Version: 528.92 CUDA Version: 12.0 |

|-------------------------------+----------------------+----------------------+

| GPU Name TCC/WDDM | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|===============================+======================+======================|

| 0 NVIDIA GeForce ... WDDM | 00000000:01:00.0 Off | N/A |

| N/A 39C P0 17W / 80W | 0MiB / 8188MiB | 0% Default |

| | | N/A |

+-------------------------------+----------------------+----------------------+

+-----------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=============================================================================|

| No running processes found |

+-----------------------------------------------------------------------------+

PS C:\Users\username>

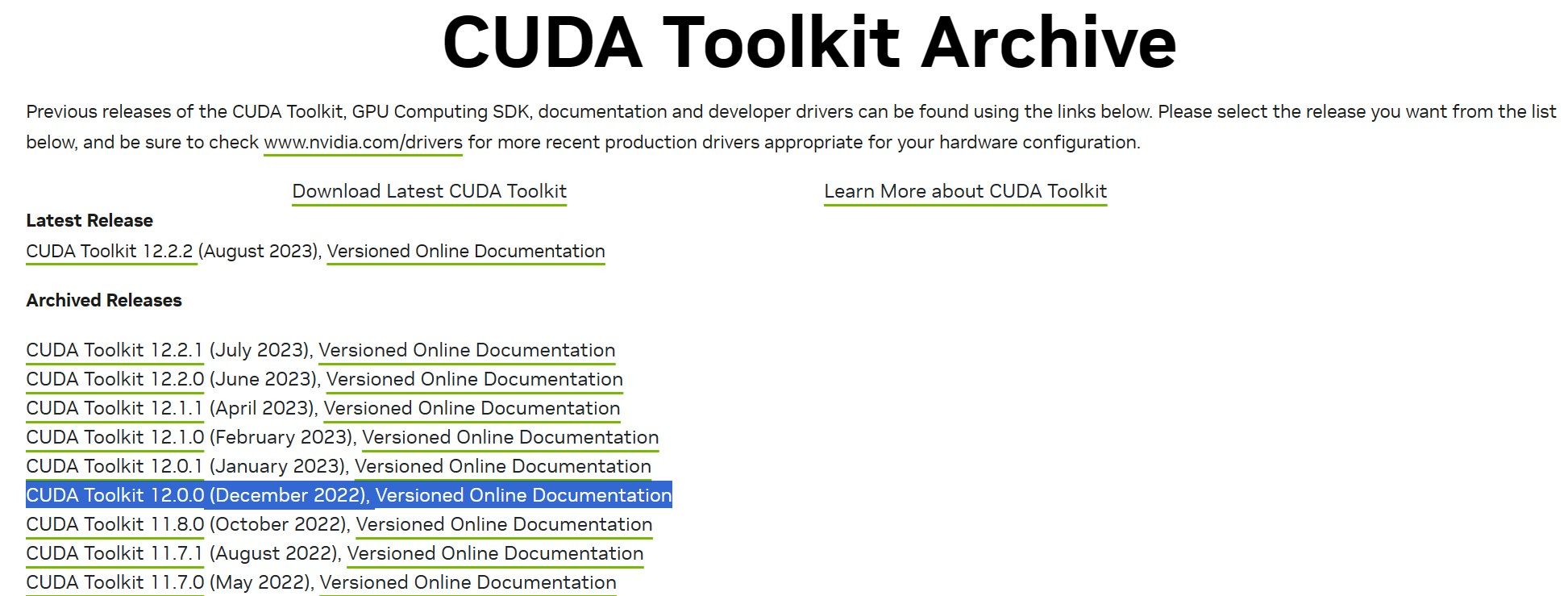

接着下载对应版本号12.0的CUDA驱动,下载地址:https://developer.nvidia.com/cuda-toolkit-archive

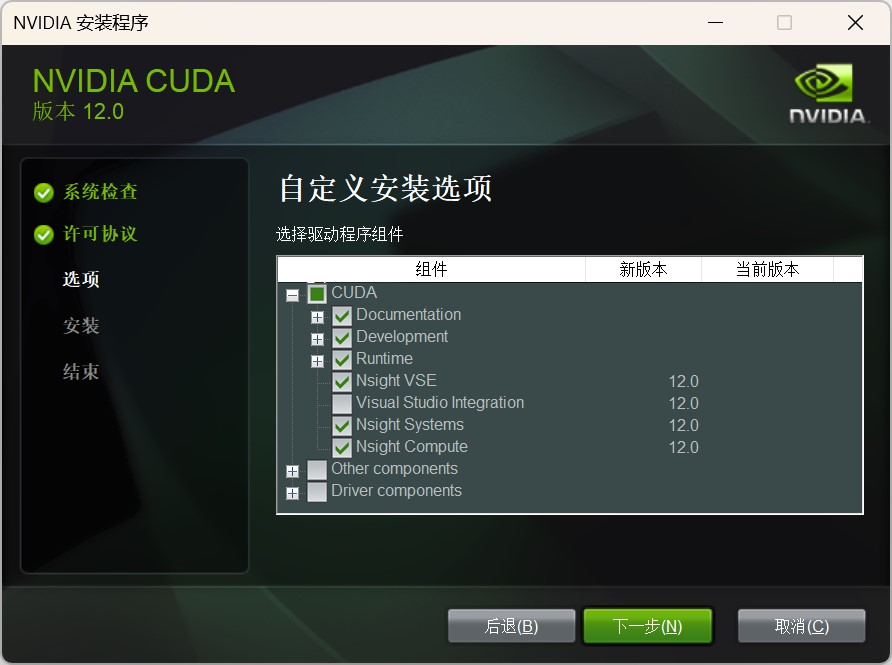

下载完成后点击安装,安装时选择自定义安装,仅勾选CUDA即可,如果之前没有安装Visual Studio,也需要取消勾选Visual Studio Integration,否则会安装不成功。安装位置自己选,一般C盘就行。

安装完成后,在终端中输入nvcc -V出现如下内容代表安装成功。

PS C:\Users\username> nvcc -V

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2022 NVIDIA Corporation

Built on Mon_Oct_24_19:40:05_Pacific_Daylight_Time_2022

Cuda compilation tools, release 12.0, V12.0.76

Build cuda_12.0.r12.0/compiler.31968024_0

PS C:\Users\username>

5.安装cuDNN

首先前往官网寻找与自己CUDA版本相匹配的cuDNN:https://developer.nvidia.com/rdp/cudnn-download

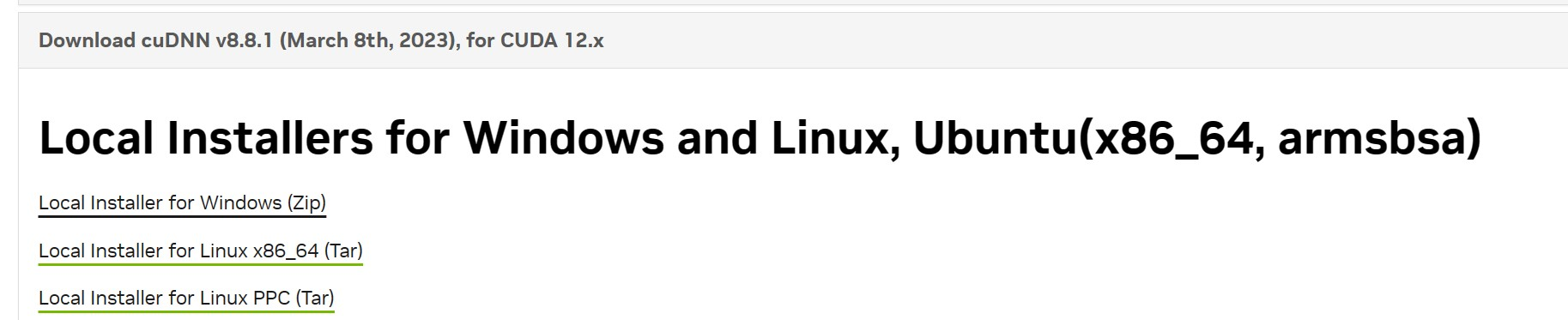

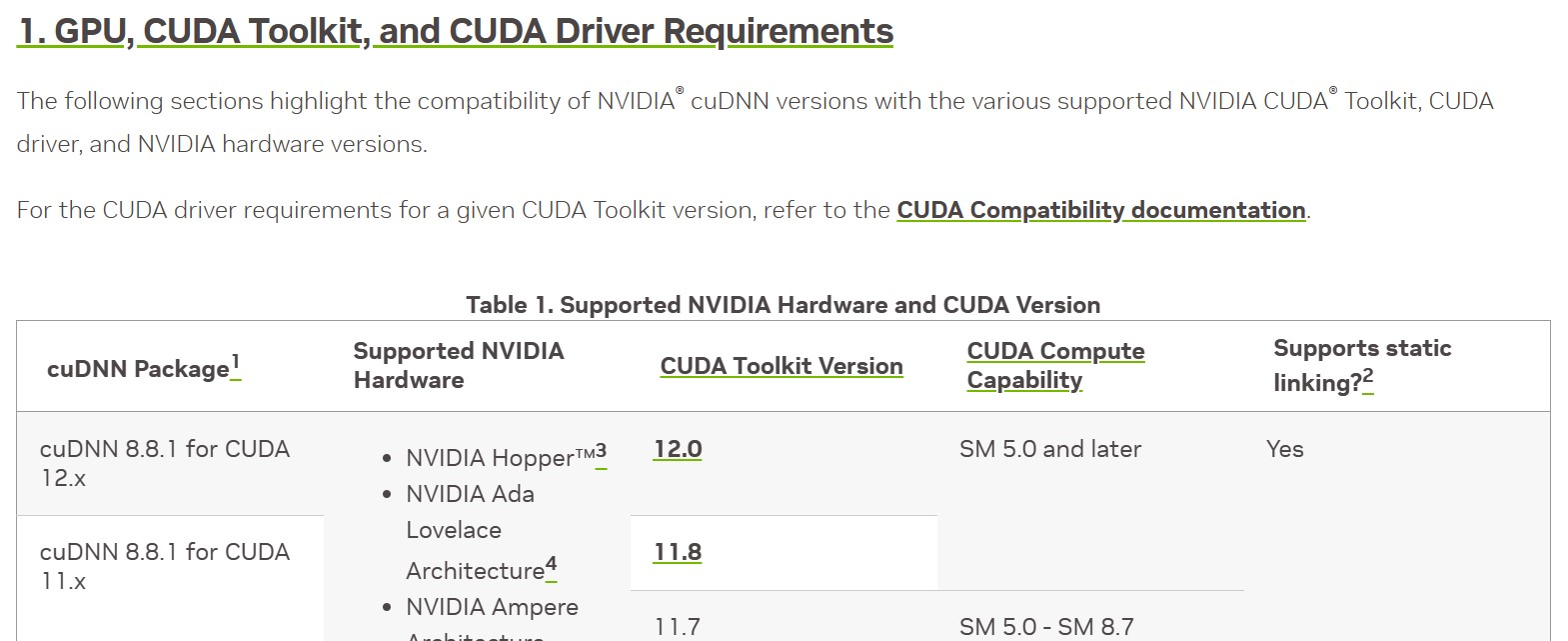

比如我的CUDA版本是12.0,对应的cuDNN版本为8.8.1,那就应该下载Download cuDNN v8.8.1 (March 8th, 2023), for CUDA 12.x选项卡中的Local Installer for Windows (Zip)。

其余不同版本cuDNN对应的CUDA版本可在官网自行查看:https://docs.nvidia.com/deeplearning/cudnn/archives/index.html

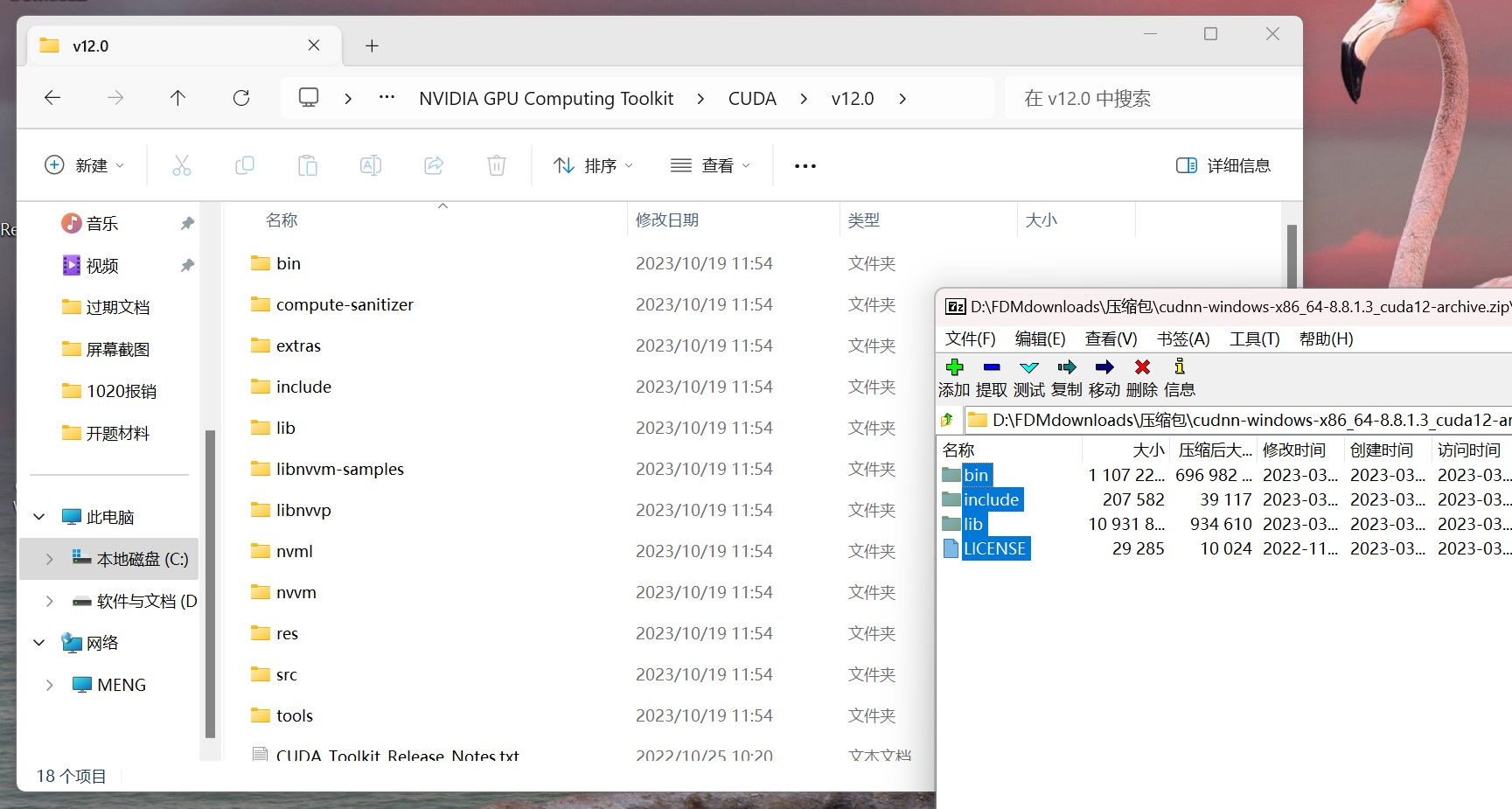

下载完成后打开压缩包,将压缩包内的文件夹复制到CUDA目录下即可。如下图所示:

安装后可在***\NVIDIA GPU Computing Toolkit\CUDA\v12.0\extras\demo_suite文件夹下用powershell运行bandwidthTest.exe程序,出现如下结果则代表cuDNN安装成功。

PS C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.0\extras\demo_suite> .\bandwidthTest.exe

[CUDA Bandwidth Test] - Starting...

Running on...

Device 0: NVIDIA GeForce RTX 4060 Laptop GPU

Quick Mode

Host to Device Bandwidth, 1 Device(s)

PINNED Memory Transfers

Transfer Size (Bytes) Bandwidth(MB/s)

33554432 12215.0

Device to Host Bandwidth, 1 Device(s)

PINNED Memory Transfers

Transfer Size (Bytes) Bandwidth(MB/s)

33554432 12826.1

Device to Device Bandwidth, 1 Device(s)

PINNED Memory Transfers

Transfer Size (Bytes) Bandwidth(MB/s)

33554432 226792.0

Result = PASS

NOTE: The CUDA Samples are not meant for performance measurements. Results may vary when GPU Boost is enabled.

最后附上官方的安装教程:https://docs.nvidia.com/deeplearning/cudnn/archives/cudnn-881/install-guide/index.html#install-windows

6.安装Pytorch

首先使用Anaconda创建一个虚拟环境并激活,名字随意,例如Pytorch。

conda create -n Pytorch python=3.11

conda activate Pytorch

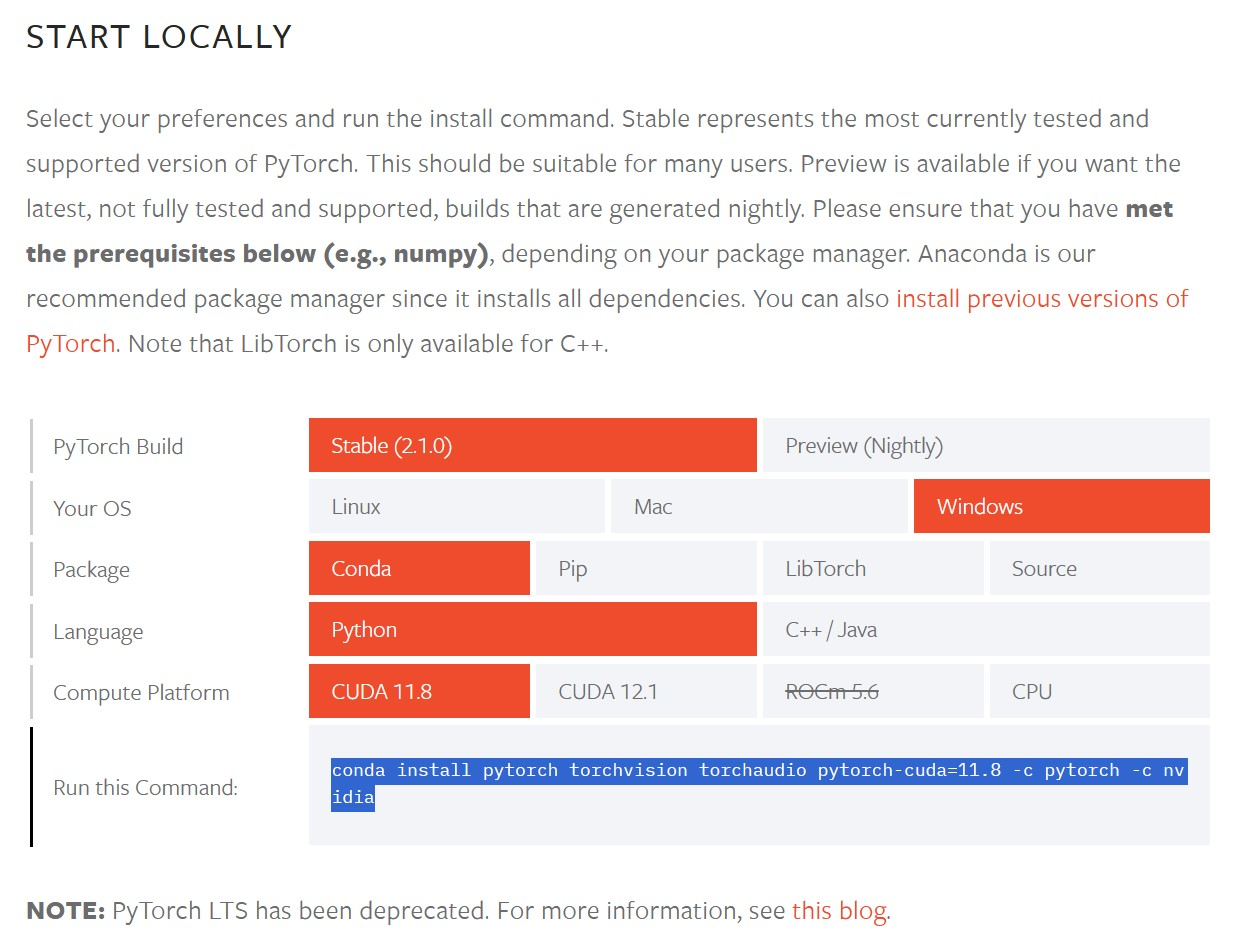

然后前去Pytorch官网根据自己需要获取安装Pytorch的命令:

https://pytorch.org/get-started/locally/

在新激活的虚拟环境Pytorch中运行此命令,静静等待安装完成即可。

# 安装pytorch

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

验证pytorch是否安装成功(输出结果为True则代表pytorch安装成功):

(Pytorch) PS D:\学习资料\我的博客> python

Python 3.11.5 | packaged by Anaconda, Inc. | (main, Sep 11 2023, 13:26:23) [MSC v.1916 64 bit (AMD64)] on win32

Type "help", "copyright", "credits" or "license" for more information.

>>> import torch

>>> torch.cuda.is_available()

True

>>>

7.安装TensorRT

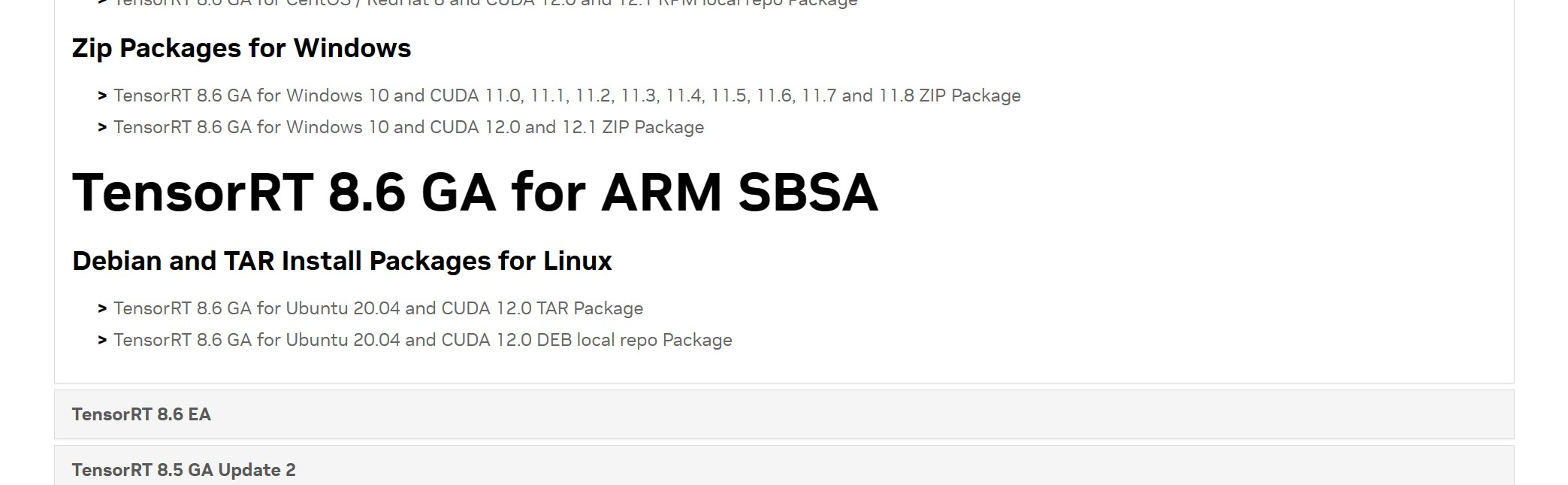

首先前往官网根据自己的CUDA版本选择并下载合适版本的TensorRT安装包,比如我的是CUDA12.0,则应该下载TensorRT 8.6 GA for Windows 10 and CUDA 12.0 and 12.1 ZIP Package

其余CUDA版本对应的TensorRT版本详见官方文档中NVIDIA TensorRT Support Matrix链接:

https://docs.nvidia.com/deeplearning/tensorrt/archives/index.html

下载完成后根据官方安装教程进行安装(windows版):

首先解压下载后的安装包,并将lib目录添加到系统Path环境变量中。

然后根据自己的python版本安装tensorrt的python wheel,例如我是python3.11,则应该运行如下命令:

# 切换到TensorRT安装目录

cd D:/Environment/TensorRT-8.6.1.6

# 必选,安装tensorRT

pip install ./python/tensorrt-8.6.1-cp311-none-win_amd64.whl

# 可选,安装TensorRT精简和调度运行时轮子文件

pip install ./python/tensorrt_lean-8.6.1-cp311-none-win_amd64.whl

pip install ./python/tensorrt_dispatch-8.6.1-cp311-none-win_amd64.whl

要想验证TensorRT是否安装成功,可以打开D:\Environment\TensorRT-8.6.1.6\samples文件夹,即tensorRT安装目录下的samples文件夹,选择一个示例项目,如sampleOnnxMNIST并用Visual Studio打开,根据README的教程测试即可。

如果需要在Pytorch中使用TensorRT,还需要安装TensorRT安装目录下的3个whl文件,安装命令如下:

# 切换到TensorRT安装目录

cd D:/Environment/TensorRT-8.6.1.6

# 依次进行安装

pip install ./graphsurgeon/graphsurgeon-0.4.6-py2.py3-none-any.whl

pip install ./uff/uff-0.6.9-py2.py3-none-any.whl

pip install ./onnx_graphsurgeon/onnx_graphsurgeon-0.3.12-py2.py3-none-any.whl

然后就大功告成啦。

8.结束

这样一来基本的深度学习环境就装好了~

深度学习环境搭建(Windows11)的更多相关文章

- 深度学习环境搭建:Tensorflow1.4.0+Ubuntu16.04+Python3.5+Cuda8.0+Cudnn6.0

目录 深度学习环境搭建:Tensorflow1.4.0+Ubuntu16.04+Python3.5+Cuda8.0+Cudnn6.0 Reference 硬件说明: 软件准备: 1. 安装Ubuntu ...

- 保姆级教程——Ubuntu16.04 Server下深度学习环境搭建:安装CUDA8.0,cuDNN6.0,Bazel0.5.4,源码编译安装TensorFlow1.4.0(GPU版)

写在前面 本文叙述了在Ubuntu16.04 Server下安装CUDA8.0,cuDNN6.0以及源码编译安装TensorFlow1.4.0(GPU版)的亲身经历,包括遇到的问题及解决办法,也有一些 ...

- 在 win11 下搭建并使用 ubuntu 子系统(同时测试 win10)——(附带深度学习环境搭建)

对于一个深度学习从事者来说,Windows训练模型有着诸多不便,还好现在Windows的Ubuntu子系统逐渐完善,近期由于工作需求,配置了Windows的工作站,为了方便起见,搭建了Ubuntu子系 ...

- [AI开发]centOS7.5上基于keras/tensorflow深度学习环境搭建

这篇文章详细介绍在centOS7.5上搭建基于keras/tensorflow的深度学习环境,该环境可用于实际生产.本人现在非常熟练linux(Ubuntu/centOS/openSUSE).wind ...

- linux系统下深度学习环境搭建和使用

作为一个AI工程师,对Linux的一些技能的掌握也能从一定层面反应工程师的资深水平. 要求1:基于SSH的远程访问(本篇文章) 能用一台笔记本电脑,远程登陆一台linux服务器 能随时使用笔记本电脑启 ...

- Win10+RTX2080深度学习环境搭建:tensorflow、mxnet、pytorch、caffe

目录 准备工作 设置conda国内镜像源 conda 深度学习环境 tensorflow.mxnet.pytorch安装 tensorflow mxnet pytorch Caffe安装 配置文件修改 ...

- Ubuntu深度学习环境搭建 tensorflow+pytorch

目前电脑配置:Ubuntu 16.04 + GTX1080显卡 配置深度学习环境,利用清华源安装一个miniconda环境是非常好的选择.尤其是今天发现conda install -c menpo o ...

- 深度学习环境搭建部署(DeepLearning 神经网络)

工作环境 系统:Ubuntu LTS 显卡:GPU NVIDIA驱动:410.93 CUDA:10.0 Python:.x CUDA以及NVIDIA驱动安装,详见https://www.cnblogs ...

- 深度学习环境搭建(CUDA9.0 + cudnn-9.0-linux-x64-v7 + tensorflow_gpu-1.8.0 + keras)

关于计算机的硬件配置说明 推荐配置 如果您是高校学生或者高级研究人员,并且实验室或者个人资金充沛,建议您采用如下配置: 主板:X299型号或Z270型号 CPU: i7-6950X或i7-7700K ...

- 深度学习环境搭建常用网址、conda/pip命令行整理(pytorch、paddlepaddle等环境搭建)

前言:最近研究深度学习,安装了好多环境,记录一下,方便后续查阅. 1. Anaconda软件安装 1.1 Anaconda Anaconda是一个用于科学计算的Python发行版,支持Linux.Ma ...

随机推荐

- GZY.Quartz.MUI(基于Quartz的UI可视化操作组件) 2.7.0发布 新增各项优化与BUG修复

前言 时隔大半年,终于抽出空来可以更新这个组件了 (边缘化了,大概要被裁员了) 2.7.0终于发布了~ 更新内容: 1.添加API类任务的超时时间,可以通过全局配置也可以单个任务设置 2.设置定时任务 ...

- 【VMware VCF】使用 PowerVCF 连接和管理 VMware Cloud Foundation 环境。

VMware 有一个非常强大的命令行工具叫 PowerCLI,该工具是基于 PowerShell 开发的模块,主要用于在 Windows 环境中连接和管理传统虚拟化解决方案,比如 vSphere.vS ...

- USB LFPS是什么?

USB LFPS:低功耗状态下的高速数据传输 什么是USB LFPS? USB LFPS(Low-Power Signaling)指的是USB接口在低功耗状态下的一种高速数据传输技术.传统上,USB接 ...

- 使用nnUNet跑BraTS脑肿瘤分割预测TC和ET非常低的原因。

使用nnUNet跑BraTS脑肿瘤分割预测TC和ET非常低,原来是预测的时候,使用了预处理后的标签.原本标签是:2:WT, 1:TC, 4:ET.但是预处理之后变为:1:WT, 2:TC, 3:ET. ...

- 墨天轮沙龙 | 清华乔嘉林:Apache IoTDB,源于清华,建设开源生态之路

在6月8日举办的[墨天轮数据库沙龙第七期-开源生态专场]中,清华大学博士,助理研究员,Apache IoTDB PMC 乔嘉林老师分享了<Apache IoTDB,源于清华,建设开源生态之路&g ...

- 基于 WeDataSphere Prophecis 与 KubeSphere 构建云原生机器学习平台

KubeSphere 开源社区的小伙伴们,大家好.我是微众银行大数据平台的工程师周可,接下来给大家分享的是基于 WeDataSphere 和 KubeSphere 这两个开源社区的产品去构建一个云原生 ...

- OpenFunction v0.8.0 发布:通过 Dapr Proxy 加速函数启动

相较于其他函数计算项目,OpenFunction 有很多独特的功能,其中之一便是通过 Dapr 与各种后端服务(BaaS)无缝集成.目前 OpenFunction 已经支持了 Dapr 的 pub/s ...

- 《刚刚问世》系列初窥篇-Java+Playwright自动化测试-3-启动浏览器(详细教程)

1.简介 通过前边两篇文章跟随宏哥学习想必到这里已经将环境搭建好了,今天就在Java项目搭建环境中简单地实践一下: 启动两大浏览器.按市场份额来说,全球前三大浏览器是:IE.Firefox.Chrom ...

- Machine Learning Week_3 Classification Model

目录 1 Classification and Representation 1.1 Classification unfamiliar words 1.2 Hypothesis Representa ...

- jQuery 杂项方法-grep()_20220114

jQuery 杂项方法-grep() 实例: var targetEmpArr = $.grep(empArr, function(elem,index){ return elem.empCode = ...