Python爬虫教程-02-使用urlopen

Spider-02-使用urlopen

做一个最简单的python爬虫,使用爬虫爬取:智联招聘某招聘信息的DOM

urllib

- 包含模块

- urllib.request:打开和读取urls

- urllib.error:包含urllib.request产生的常见错误,使用try捕捉

- urllib.parse:包含解析url的方法

- urllib.robotparse:解析robots.txt文件

robots:机器人协议,放在网站的开头,供给爬虫读取,当爬虫读到robots之后,就知道那些是允许爬取的数据,哪些是禁止爬取的数据

(爬虫道德问题:1.不许过频繁爬取 2.不许爬取禁止内容) - 案例v1 (使用PyCharm开发工具,配置python解释器,创建python文件)

- 我把代码放在github了,可以直接下载,地址:

- py01v1.py文件:https://xpwi.github.io/py/py爬虫/py01v1.py

- request.py文档文件:https://xpwi.github.io/py/py爬虫/request.py

# py01v1.py

from urllib import request

# 使用urllib.request请求一个网页的内容,并把内容打印出来

if __name__ == '__main__':

# 定义需要爬的页面

url = "https://jobs.zhaopin.com/CC375882789J00033399409.htm"

# 打开相应url并把页面作为返回

rsp = request.urlopen(url)

# 按住Ctrl键不送,同时点击urlopen,可以查看文档,有函数的具体参数和使用方法

# 把返回结果读取出来

html = rsp.read()

print(html)

上面简单几行代码就可以爬取页面的HTML代码了

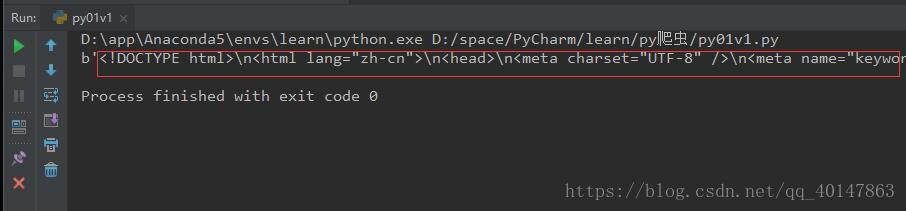

右键运行,截图如下

但是,我们爬取到的代码是不能自行显示中文的,需要解码处理

py02v1.py文件:https://xpwi.github.io/py/py爬虫/py02v1.py

# py02v1.py

from urllib import request

if __name__ == '__main__':

url = "https://jobs.zhaopin.com/CC375882789J00033399409.htm"

rsp = request.urlopen(url)

# 按住Ctrl键不送,同时点击urlopen,可以查看文档,有函数的具体参数和使用方法

html = rsp.read()

# 解码

html = html.decode()

print(html)

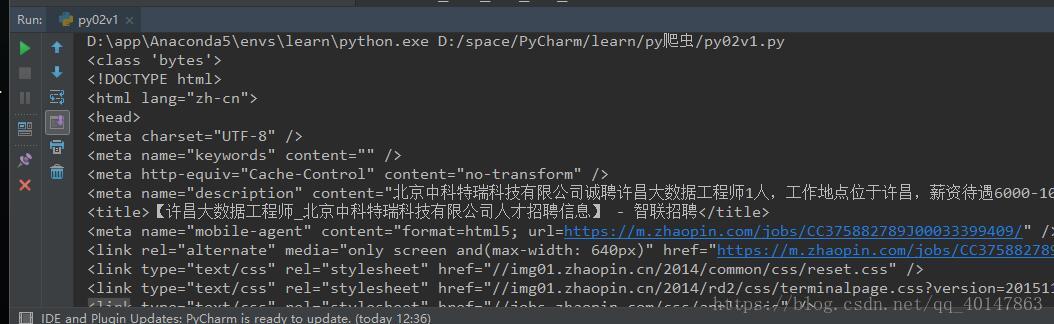

解码后效果:

恭喜你,最简单的爬虫就已经学会啦!

如果运行失败,可能是

1.【爬取的连接失效】,更换最新的地址就可以了

2.【Python环境问题】,这里不做仔细介绍,请自行【百度】解决,也可联系博主

QQ:1370911284

微信:18322295195

更多文章链接:Python 爬虫随笔

- 本笔记学习于图灵学院python全栈课程

- 本笔记不允许任何个人和组织转载

Python爬虫教程-02-使用urlopen的更多相关文章

- Python爬虫教程-01-爬虫介绍

Spider-01-爬虫介绍 Python 爬虫的知识量不是特别大,但是需要不停和网页打交道,每个网页情况都有所差异,所以对应变能力有些要求 爬虫准备工作 参考资料 精通Python爬虫框架Scrap ...

- Python爬虫教程-00-写在前面

鉴于好多人想学Python爬虫,缺没有简单易学的教程,我将在CSDN和大家分享Python爬虫的学习笔记,不定期更新 基础要求 Python 基础知识 Python 的基础知识,大家可以去菜鸟教程进行 ...

- Python爬虫教程-11-proxy代理IP,隐藏地址(猫眼电影)

Python爬虫教程-11-proxy代理IP,隐藏地址(猫眼电影) ProxyHandler处理(代理服务器),使用代理IP,是爬虫的常用手段,通常使用UserAgent 伪装浏览器爬取仍然可能被网 ...

- Python爬虫教程-10-UserAgent和常见浏览器UA值

Python爬虫教程-10-UserAgent和常见浏览器UA值 有时候使用爬虫会被网站封了IP,所以需要去模拟浏览器,隐藏用户身份, UserAgent 包含浏览器信息,用户身份,设备系统信息 Us ...

- Python爬虫教程-09-error 模块

Python爬虫教程-09-error模块 今天的主角是error,爬取的时候,很容易出现错,所以我们要在代码里做一些,常见错误的处,关于urllib.error URLError URLError ...

- Python爬虫教程-08-post介绍(百度翻译)(下)

Python爬虫教程-08-post介绍(下) 为了更多的设置请求信息,单纯的通过urlopen已经不太能满足需求,此时需要使用request.Request类 构造Request 实例 req = ...

- Python爬虫教程-07-post介绍(百度翻译)(上)

Python爬虫教程-07-post介绍(百度翻译)(上) 访问网络两种方法 get: 利用参数给服务器传递信息 参数为dict,使用parse编码 post :(今天给大家介绍的post) 一般向服 ...

- Python爬虫教程-25-数据提取-BeautifulSoup4(三)

Python爬虫教程-25-数据提取-BeautifulSoup4(三) 本篇介绍 BeautifulSoup 中的 css 选择器 css 选择器 使用 soup.select 返回一个列表 通过标 ...

- Python爬虫教程-24-数据提取-BeautifulSoup4(二)

Python爬虫教程-24-数据提取-BeautifulSoup4(二) 本篇介绍 bs 如何遍历一个文档对象 遍历文档对象 contents:tag 的子节点以列表的方式输出 children:子节 ...

随机推荐

- ASP.NET MVC 下拉列表实现

https://blog.csdn.net/Ryan_laojiang/article/details/75349555?locationNum=10&fps=1 前言 我们今天开始好好讲讲关 ...

- 2018焦作网络赛 - Poor God Water 一道水题的教训

本题算是签到题,但由于赛中花费了过多的时间去滴吧格,造成了不必要的浪费以及智商掉线,所以有必要记录一下坑点 题意:方格从1到n,每一格mjl可以选择吃鱼/巧克力/鸡腿,求走到n格时满足 1.每三格不可 ...

- mysql grant权限总结

2019-01-07 转自 https://blog.csdn.net/wulantian/article/details/38230635 一.权限表 mysql数据库中的3个权限表:user .d ...

- c#Task类。实现异步的一种方式

Task和Task<TResult>是c#提供的一种实现异步功能的2个类.Task<TResult>继承Task类,有返回参数. 1.基本用法 不嵌套利用静态方法创建和运行任务 ...

- windows电脑配置

1.本地电脑通过修改hosts文件实现域名本地解析 以管理员身份打开记事本 并打开C:\Windows\System32\drivers\etc 路径下的hosts文件 在文件末尾添加如下

- Windows Server 2003、2008、2012系统的安装

说在前面的话 Windows Server 2003,和Windows XP十分相似,可以简单地认为Windows Server 2003是在Windows XP的基础上多了一些服务器管理和操作的功能 ...

- Java的接口(interface)属性和方法的类型

接口的属性必须是public static final Type 接口的方法必须是public abstract Type 不管你是全写,或只写部分,系统都会自动按上面的要求不全 也就是说 接口中 所 ...

- 利用keepalived构建高可用MySQL-HA

关于MySQL-HA,目前有多种解决方案,比如heartbeat.drbd.mmm.共享存储,但是它们各有优缺点.heartbeat.drbd配置较为复杂,需要自己写脚本才能实现MySQL自动切换,对 ...

- 【总结】java 后台文件上传整理

public Map<String,String> clientUploadAttachment(Long belongId, String fileSource, MultipartFi ...

- jquery实现的让图片在网页的可视区域里四处漂浮的效果

本文分享给大家一个用jquery开发的图片漂浮效果. jquery图片漂浮效果,常见的就是网页里四处漂来漂去的广告了,漂到边缘时还会反弹和拐弯. 下面来看具体的代码,先看要实现漂亮效果的这个jquer ...