scrapy异步的爬虫框架简单的使用

scrapy异步的爬虫框架

异步的爬虫框架

高性能的数据解析,持久化存储,全栈数据的爬取,中间件,分布式

框架:就是一个集成好了各种功能且具有很强通用性的一个项目模板。

环境安装:

Linux:

pip3 install scrapy

Windows:

1. pip3 install wheel

2. 下载twisted http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted

3. 进入下载目录,执行 pip3 install Twisted‑17.1.0‑cp35‑cp35m‑win_amd64.whl

4. pip3 install pywin32

5. pip3 install scrapy

基本使用

新建一个工程:

前提需要将

Twisted‑17.1.0‑cp35‑cp35m‑win_amd64.whl这个文件放在项目目录下# 在终端中执行下面这个命令

scrapy startporject + “项目名”

- settings.py:当前工程的配置文件

- spiders:爬虫包,必须要存放一个或者多个爬虫文件(.py)

进入项目

# 在终端中执行

cd + 项目名

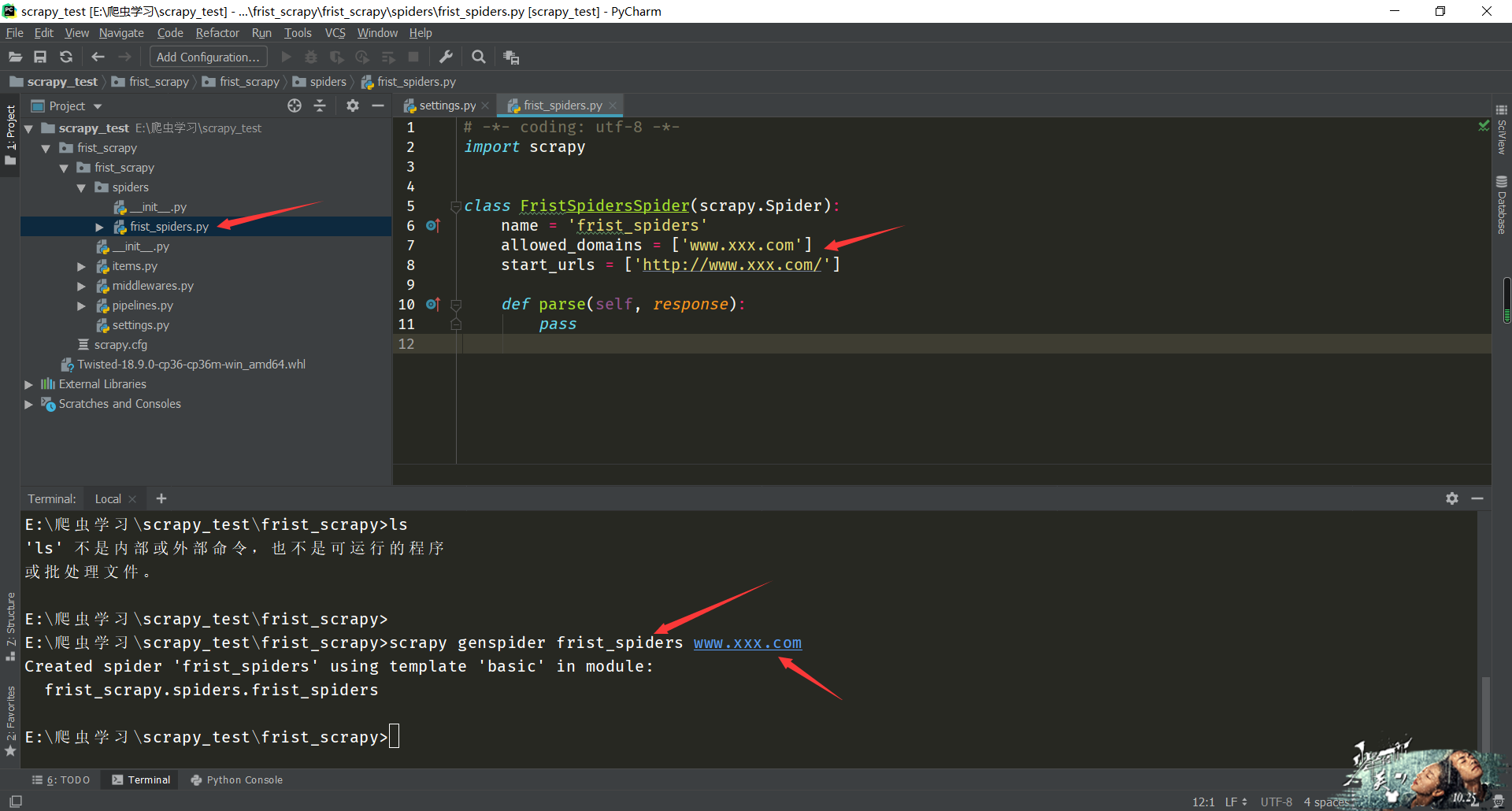

创建一个爬虫文件:

# 在终端中执行:

scrapy genspider spiderName www.xxx.com # 命令解析:

scrapy genspider 爬虫文件名 url

# 这个url是必写的,不写无法创建文件,可以随意些,最后在文件中修改

执行工程:

# 在终端中执行下面的命令:

scrapy crawl spiderName # 执行命令scrapy crawl 加爬虫文件名

在

sttings文件中需要配置的:settings.py: - 不遵从robots协议

如果选择不遵循robots协议的就修改文件中的

ROBOTSTXT_OBEY = False # 将True改为False - UA伪装

将UA伪装的数据加载文件中 - 指定日志输出的类型:

将 LOG_LEVEL = 'ERROR' 添加到配置文件中

爬虫文件中:

# -*- coding: utf-8 -*-

import scrapy class SecondSpidersSpider(scrapy.Spider):

name = 'second_spiders'

#允许的域名

allowed_domains = ['www.123.com'] #起始的url列表:列表元素只可以是url

#作用:列表元素表示的url就会被进行请求发送

start_urls = ['http://duanziwang.com/category/%E7%BB%8F%E5%85%B8%E6%AE%B5%E5%AD%90/'] def parse(self, response):

all_data = []

article_list = response.xpath('/html/body/section/div/div/main/article')

for article in article_list:

# xpath在进行数据提取时,返回的不再是字符串而是一个Selector对象,想要的数据被包含在了该对象的data参数中 title = article.xpath('./div[1]/h1/a/text()').extract_first()

content = article.xpath('./div[2]//text()').extract()

content = ''.join(content)

dic = {

'title': title,

'content': content

}

all_data.append(dic)

return all_data # 将解析到的数据进行了返回

数据解析:

- 1.response.xpath('xpath表达式')

- 2.scrapy中的xpath解析,在进行数据提取的时候,xpath方法返回的列表中存储的不再是字符串,

而是存储的Selector对象,相关的字符串数据是存储在Selector对象的data参数中,我们必须使用

extract()/extract_first()进行字符串数据的提取 - extract():可以作用到列表中的每一个列表元素中,返回的依然是一个列表

- extract_first():只可以作用到列表中的第一个列表元素中,返回的是字符串

持久化存储

- 基于终端指令的持久化存储

- 只可以将parse方法的返回值存储到指定后缀的文本文件中。

- scrapy crawl spiderName -o ./duanzi.csv

- 基于管道的持久化存储

- 基于终端指令的持久化存储

scrapy异步的爬虫框架简单的使用的更多相关文章

- 使用Scrapy爬虫框架简单爬取图片并保存本地(妹子图)

初学Scrapy,实现爬取网络图片并保存本地功能 一.先看最终效果 保存在F:\pics文件夹下 二.安装scrapy 1.python的安装就不说了,我用的python2.7,执行命令pip ins ...

- 一篇文章教会你理解Scrapy网络爬虫框架的工作原理和数据采集过程

今天小编给大家详细的讲解一下Scrapy爬虫框架,希望对大家的学习有帮助. 1.Scrapy爬虫框架 Scrapy是一个使用Python编程语言编写的爬虫框架,任何人都可以根据自己的需求进行修改,并且 ...

- python网络爬虫(14)使用Scrapy搭建爬虫框架

目的意义 爬虫框架也许能简化工作量,提高效率等.scrapy是一款方便好用,拓展方便的框架. 本文将使用scrapy框架,示例爬取自己博客中的文章内容. 说明 学习和模仿来源:https://book ...

- 『Scrapy』爬虫框架入门

框架结构 引擎:处于中央位置协调工作的模块 spiders:生成需求url直接处理响应的单元 调度器:生成url队列(包括去重等) 下载器:直接和互联网打交道的单元 管道:持久化存储的单元 框架安装 ...

- Scrapy网络爬虫框架的开发使用

1.安装 2.使用scrapy startproject project_name 命令创建scrapy项目 如图: 3.根据提示使用scrapy genspider spider_name dom ...

- 网络爬虫框架Scrapy简介

作者: 黄进(QQ:7149101) 一. 网络爬虫 网络爬虫(又被称为网页蜘蛛,网络机器人),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本:它是一个自动提取网页的程序,它为搜索引擎从万维 ...

- [原创]一款基于Reactor线程模型的java网络爬虫框架

AJSprider 概述 AJSprider是笔者基于Reactor线程模式+Jsoup+HttpClient封装的一款轻量级java多线程网络爬虫框架,简单上手,小白也能玩爬虫, 使用本框架,只需要 ...

- Python之Scrapy爬虫框架安装及简单使用

题记:早已听闻python爬虫框架的大名.近些天学习了下其中的Scrapy爬虫框架,将自己理解的跟大家分享.有表述不当之处,望大神们斧正. 一.初窥Scrapy Scrapy是一个为了爬取网站数据,提 ...

- 教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http://www.xiaohuar.com/,让你体验爬取校花的成就感. Scr ...

随机推荐

- 【软件测试 Python自动化】全网最全大厂面试题,看完以后你就是面试官!

前言 为了让大家更好的理解和学习投入到Python自动化来找到一份好的资料也是学习过程中,非常重要的一个点.你的检索能力越强,你就会越容易找到最合适你的资料. 有需要的小伙伴可以复制群号 313782 ...

- Bootstrap留言板界面练习

<!DOCTYPE html> <html> <head> <meta charset="utf-8"> <title> ...

- Linux简单复习

cd 命令:切换目录 ls命令:用于浏览目录下的文件或者文件夹 rm 命令:用于删除文件或者目录,用法 rm –rf test.txt (-r表示递归,-f表示强制) cp 命令:用于拷贝文件,用法, ...

- 一劳永逸,解决基于 keep-alive 的后台多级路由缓存问题

用过 vue-element-admin 的同学一定很清楚,路由的配置直接关系侧边栏导航菜单的展示,也得益于这种设计思路,几乎大部分后台框架都采用这个方案,当然也包括了我写的 Fantastic-ad ...

- 主数据管理(MDM)的6大层级简述,你不可不知的数据治理参考!

前面我写了一篇关于对元数据和元数据管理的认知和理解的文章,有兴趣的朋友可以去看看.接下来我们讲一讲主数据管理(MDM). 主数据管理(MDM) 主数据是系统间共享数据,它是系统间信息交换的基准.主数据 ...

- python列表(九)元组

元组 元组是不可变序列,元组一旦创建,用任何方法都不可以修改其元素. 元组的偶有元素是放在一对圆括号"()"中 1.元组创建与删除 使用"="讲一个元组赋值给变 ...

- 麦格理银行借助DataStax Enterprise (DSE) 驱动数字化转型

在本文中,我们将介绍DataStax Enterprise是如何助力澳大利亚最大的投资银行麦格理银行的数字银行,实现了实时分析和自然语言搜索等多项功能,并为用户提供了个性化的用户体验. "D ...

- 记录第一次使用Vivado——以全加器为例子

从altera转战xilinx,经典的FPGA到ZYNQ系列,第一站就是先熟悉编译软件Vivado.我就直接跳过软件安装部分了,如有疑问,可以在评论区提出来,我看到了就帮你解答. 首先是是打开界面 然 ...

- 第十一章节 BJROBOT PS3 手柄控制【ROS全开源阿克曼转向智能网联无人驾驶车】

1.把小车架空平放在地板上. 2.用 USB 线将 PS3 蓝牙手柄连接至小车主控端,初次连接手柄上的 4 个红色指示灯会同时闪烁; 3.按下手柄中间的圆形配对键,然后等待红灯闪烁至停止. 4.此 ...

- 项目API接口鉴权流程总结

权益需求对接中,公司跟第三方公司合作,有时我们可能作为甲方,提供接口给对方,有时我们也作为乙方,调对方接口,这就需要API使用签名方法(Sign)对接口进行鉴权.每一次请求都需要在请求中包含签名信息, ...