增强学习--Sarsa算法

import numpy as np

import random

from collections import defaultdict

from environment import Env # SARSA agent learns every time step from the sample <s, a, r, s', a'>

class SARSAgent:

def __init__(self, actions):

self.actions = actions

self.learning_rate = 0.01

self.discount_factor = 0.9

self.epsilon = 0.1

self.q_table = defaultdict(lambda: [0.0, 0.0, 0.0, 0.0])#动作值函数表,q表,要更新的表,不同于mc的更新v表 # with sample <s, a, r, s', a'>, learns new q function

def learn(self, state, action, reward, next_state, next_action):

current_q = self.q_table[state][action]

next_state_q = self.q_table[next_state][next_action]

new_q = (current_q + self.learning_rate *

(reward + self.discount_factor * next_state_q - current_q))#q表更新公式

self.q_table[state][action] = new_q # get action for the state according to the q function table

# agent pick action of epsilon-greedy policy

def get_action(self, state):#获取下一步动作

#epsilon-greedy policy,exploration

if np.random.rand() < self.epsilon:

# take random action

action = np.random.choice(self.actions)

else:

# take action according to the q function table

state_action = self.q_table[state]

action = self.arg_max(state_action)

return action @staticmethod

def arg_max(state_action):

max_index_list = []

max_value = state_action[0]

for index, value in enumerate(state_action):

if value > max_value:

max_index_list.clear()

max_value = value

max_index_list.append(index)

elif value == max_value:

max_index_list.append(index)

return random.choice(max_index_list) if __name__ == "__main__":

env = Env()

agent = SARSAgent(actions=list(range(env.n_actions))) for episode in range(1000):

# reset environment and initialize state state = env.reset()

# get action of state from agent

action = agent.get_action(str(state)) while True:

env.render() # take action and proceed one step in the environment

next_state, reward, done = env.step(action)

next_action = agent.get_action(str(next_state)) # with sample <s,a,r,s',a'>, agent learns new q function

agent.learn(str(state), action, reward, str(next_state), next_action) state = next_state

action = next_action # print q function of all states at screen

env.print_value_all(agent.q_table) # if episode ends, then break

if done:

break

增强学习--Sarsa算法的更多相关文章

- 增强学习贪心算法与Softmax算法

(一) 这个算法是基于一个概率来对探索和利用进行折中:每次尝试时,以概率进行探索,即以均匀概率随机选取一个摇臂,以的概率进行利用,即以这个概率选择当前平均奖赏最高的摇臂(如有多个,则随机选取). 其中 ...

- 增强学习--TRPO算法

理论部分参考 推导 数学上的分析 代码

- 马里奥AI实现方式探索 ——神经网络+增强学习

[TOC] 马里奥AI实现方式探索 --神经网络+增强学习 儿时我们都曾有过一个经典游戏的体验,就是马里奥(顶蘑菇^v^),这次里约奥运会闭幕式,日本作为2020年东京奥运会的东道主,安倍最后也已经典 ...

- 增强学习(五)----- 时间差分学习(Q learning, Sarsa learning)

接下来我们回顾一下动态规划算法(DP)和蒙特卡罗方法(MC)的特点,对于动态规划算法有如下特性: 需要环境模型,即状态转移概率\(P_{sa}\) 状态值函数的估计是自举的(bootstrapping ...

- (zhuan) 大牛讲堂 | 算法工程师入门第二期-穆黎森讲增强学习

大牛讲堂 | 算法工程师入门第二期-穆黎森讲增强学习 2017-07-13 HorizonRobotics

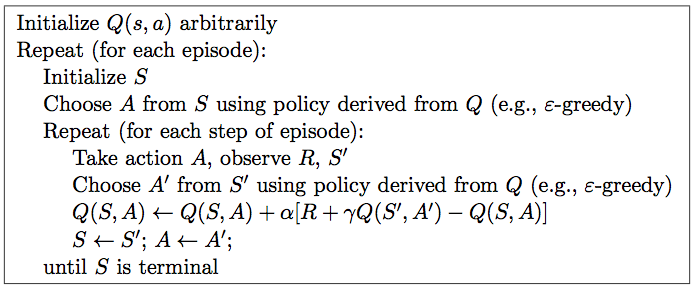

- 强化学习-学习笔记7 | Sarsa算法原理与推导

Sarsa算法 是 TD算法的一种,之前没有严谨推导过 TD 算法,这一篇就来从数学的角度推导一下 Sarsa 算法.注意,这部分属于 TD算法的延申. 7. Sarsa算法 7.1 推导 TD ta ...

- 增强学习(三)----- MDP的动态规划解法

上一篇我们已经说到了,增强学习的目的就是求解马尔可夫决策过程(MDP)的最优策略,使其在任意初始状态下,都能获得最大的Vπ值.(本文不考虑非马尔可夫环境和不完全可观测马尔可夫决策过程(POMDP)中的 ...

- 增强学习(四) ----- 蒙特卡罗方法(Monte Carlo Methods)

1. 蒙特卡罗方法的基本思想 蒙特卡罗方法又叫统计模拟方法,它使用随机数(或伪随机数)来解决计算的问题,是一类重要的数值计算方法.该方法的名字来源于世界著名的赌城蒙特卡罗,而蒙特卡罗方法正是以概率为基 ...

- 增强学习————K-摇臂赌博机

探索与利用增强学习任务的最终奖赏是在多步动作之后才能观察到,于是我们先考虑最简单的情形:最大化单步奖赏,即仅考虑一步操作.不过,就算这样,强化学习仍与监督学习有显著不同,因为机器要通过尝试来发现各个动 ...

随机推荐

- LeetCode Regular Expression Matching 网上一个不错的实现(非递归)

'.' Matches any single character.'*' Matches zero or more of the preceding element. The matching sho ...

- django自带的orm增删改

# 转载请留言联系 模型管理器 模型管理器:objects属性 每个模型类默认都有一个叫 objects 的类属性,它由django自动生成 我们把 objects 称为 模型管理器,其类型为: dj ...

- happens-before规则

happens-before原则: happens-before它是判断数据是否存在竞争.线程是否安全的主要依据.为了保证线程安全我们可以让2个操作具有happens-before关系.(JDK5 开 ...

- 作业执行器Job Executor

Job Executor 激活作业执行器 AsyncExecutor是一个组件,它管理线程池,来触发计时器和其他异步任务.其他实现也是可能的(例如使用消息队列,请参阅用户指南的高级部分). 默认情况下 ...

- 云平台服务运行情况检测脚本V0.1

1.准备Python3环境 yum groupinstall "Development tools" -y yum install zlib-devel bzip2-devel o ...

- EntityFramework整理

最近公司项目需要,想要给订单增加一个状态修改记录. 说起来很简单的需求,但是做的时候,卡了我半天... 问题描述: 修改订单状态保存之前的时候,需要判断,如果新状态不等于旧状态,才做记录,但是在底层的 ...

- Asp.Net MVC在过滤器中使用模型绑定

废话不多话,直接上代码 1.创建MVC项目,新建一个过滤器类以及使用到的实体类: public class DemoFiltersAttribute : AuthorizeAttribute { pu ...

- (六)if流程控制

(1)单分支结构 if 条件判断;then fi 例 #!/bin/bash read -p "please input Y" num if [ "$num" ...

- 【转】Python模块subprocess

subprocess 早期的Python版本中,我们主要是通过os.system().os.popen().read()等函数.commands模块来执行命令行指令的,从Python 2.4开始官方文 ...

- HDU 6362.oval-and-rectangle-数学期望、微积分 (2018 Multi-University Training Contest 6 1001)

2018 Multi-University Training Contest 6 6362.oval-and-rectangle 题意就是椭圆里画内接矩形,问你矩形周长的期望. 比赛的时候推了公式,但 ...