[TensorFlow]Tensor维度理解

http://wossoneri.github.io/2017/11/15/[Tensorflow]The-dimension-of-Tensor/

Tensor维度理解

Tensor在Tensorflow中是N维矩阵,所以涉及到Tensor的方法,也都是对矩阵的处理。由于是多维,在Tensorflow中Tensor的流动过程就涉及到升维降维,这篇就通过一些接口的使用,来体会Tensor的维度概念。以下是个人体会,有不准确的请指出。

tf.reduce_mean

reduce_mean(

input_tensor,

axis=None,

keep_dims=False,

name=None,

reduction_indices=None

)

计算Tensor各个维度元素的均值。这个方法根据输入参数axis的维度上减少输入input_tensor的维度。

举个例子:

x = tf.constant([[1., 1.], [2., 2.]])

tf.reduce_mean(x) # 1.5

tf.reduce_mean(x, 0) # [1.5, 1.5]

tf.reduce_mean(x, 1) # [1., 2.]

x是二维数组[[1.0,1.0],[2.0, 2.0]]

当axis参数取默认值时,计算整个数组的均值:(1.+1.+2.+2.)/4=1.5

当axis取0,意味着对列取均值:[1.5, 1.5]

当axis取1,意味着对行取均值:[1.0, 2.0]

再换一个3*3的矩阵:

sess = tf.Session()

x = tf.constant([[1., 2., 3.], [4., 5., 6.], [7., 8., 9.]])

print(sess.run(x))

print(sess.run(tf.reduce_mean(x)))

print(sess.run(tf.reduce_mean(x, 0)))

print(sess.run(tf.reduce_mean(x, 1)))

输出结果是

[[ 1. 2. 3.]

[ 4. 5. 6.]

[ 7. 8. 9.]]

5.0

[ 4. 5. 6.]

[ 2. 5. 8.]

如果我再加一维是怎么计算的?

sess = tf.Session()

x = tf.constant([[[1., 1.], [2., 2.]], [[3., 3.], [4., 4.]]])

print(sess.run(x))

print(sess.run(tf.reduce_mean(x)))

print(sess.run(tf.reduce_mean(x, 0)))

print(sess.run(tf.reduce_mean(x, 1)))

print(sess.run(tf.reduce_mean(x, 2)))

我给的输入Tensor是三维数组:

[[[ 1. 1.]

[ 2. 2.]]

[[ 3. 3.]

[ 4. 4.]]]

推测一下,前面二维的经过处理都变成一维的,也就是经历了一次降维,那么现在三维的或许应该变成二维。但现在多了一维,应该从哪个放向做计算呢?

看下结果:

2.5

[[ 2. 2.]

[ 3. 3.]]

[[ 1.5 1.5]

[ 3.5 3.5]]

[[ 1. 2.]

[ 3. 4.]]

发现,

当axis参数取默认值时,依然计算整个数组的均值:(float)(1+2+3+4+1+2+3+4)/8=2.5

当axis取0,计算方式是:

[[(1+3)/2, (1+3)/2],

[(2+4)/2, (2+4)/2]]

当axis取1,计算方式是:

[[(1+2)/2, (1+2)/2],

[(3+4)/2, (3+4)/2]]

当axis取2,计算方式是:

[[(1+1)/2, (2+2)/2],

[(3+3)/2, (4+4)/2]]

看到这里,能推断出怎么从四维降到三维吗?

有人总结了一下:

规律:

对于k维的,

tf.reduce_xyz(x, axis=k-1)的结果是对最里面一维所有元素进行求和。

tf.reduce_xyz(x, axis=k-2)是对倒数第二层里的向量对应的元素进行求和。

tf.reduce_xyz(x, axis=k-3)把倒数第三层的每个向量对应元素相加。

链接

拿上面的数组验证这个规律:

[[[ 1. 1.]

[ 2. 2.]]

[[ 3. 3.]

[ 4. 4.]]]

我们的k=3。小括号是一层,在一层内进行计算:

axis=3-1=2,做最内层计算,我们的最内层就是(1,1),(2,2),(3,3),(4,4),计算出来的就是

[[ 1. 2.]

[ 3. 4.]]

axis=3-2=1,做倒数第二层计算(参考二维计算):([1,1],[2,2])和([3, 3],[4, 4])

[[ 1.5 1.5]

[ 3.5 3.5]]

axis=3-3=1,做倒数第三层计算:([[1, 1], [2, 2]])([[3, 3], [4, 4]])

[[ 2. 2.]

[ 3. 3.]]

对于四维的,就贴段结果,自己可以尝试算一下,加深理解。

# input 4-D

[[[[ 1. 1.]

[ 2. 2.]]

[[ 3. 3.]

[ 4. 4.]]]

[[[ 5. 5.]

[ 6. 6.]]

[[ 7. 7.]

[ 8. 8.]]]]

# axis=none

4.5

# axis=0

[[[ 3. 3.]

[ 4. 4.]]

[[ 5. 5.]

[ 6. 6.]]]

# axis=1

[[[ 2. 2.]

[ 3. 3.]]

[[ 6. 6.]

[ 7. 7.]]]

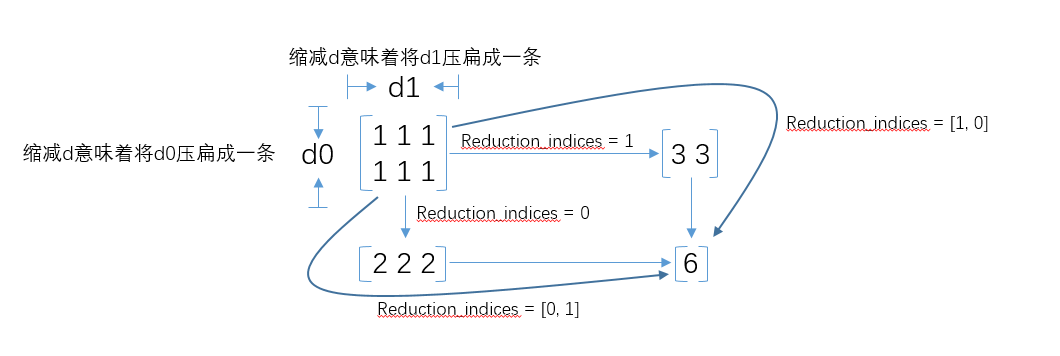

在tensorflow 1.0版本中,

reduction_indices被改为了axis,在所有reduce_xxx系列操作中,都有reduction_indices这个参数,即沿某个方向,使用xxx方法,对input_tensor进行降维。

对于axis参数的作用,文档的解释是

the rank of the tensor is reduced by 1 for each entry in axis

即Tensor在axis的每一个分量上的秩减少1。如何理解矩阵的「秩」? - 马同学的回答 - 知乎

附一张reduction_indices的图

下面再看下第三个参数keep_dims,该参数缺省值是False,如果设置为True,那么减少的维度将被保留为长度为1。

回头看看最开始的例子:

# 2*2

[[ 1. 1.]

[ 2. 2.]]

# keep_dims=False

[ 1.5 1.5] # 1*2

[ 1. 2.] #1*2

# keep_dims=True

[[ 1.5 1.5]] #1*2

[[ 1.] #2*1

[ 2.]]

可以看到差别。关于这个参数,还没看到太多介绍,还需要了解。

[TensorFlow]Tensor维度理解的更多相关文章

- pytorch tensor 维度理解.md

torch.randn torch.randn(*sizes, out=None) → Tensor(张量) 返回一个张量,包含了从标准正态分布(均值为0,方差为 1)中抽取一组随机数,形状由可变参数 ...

- tensorflow中的函数获取Tensor维度的两种方法:

获取Tensor维度的两种方法: Tensor.get_shape() 返回TensorShape对象, 如果需要确定的数值而把TensorShape当作list使用,肯定是不行的. 需要调用Tens ...

- pytorch 中改变tensor维度的几种操作

具体示例如下,注意观察维度的变化 #coding=utf-8 import torch """改变tensor的形状的四种不同变化形式""" ...

- 对Tensorflow中tensor的理解

Tensor即张量,在tensorflow中所有的数据都通过张量流来传输,在看代码的时候,对张量的概念很不解,很容易和矩阵弄混,今天晚上查了点资料,并深入了解了一下,简单总结一下什么是张量的阶,以及张 ...

- tensor维度变换

维度变换是tensorflow中的重要模块之一,前面mnist实战模块我们使用了图片数据的压平操作,它就是维度变换的应用之一. 在详解维度变换的方法之前,这里先介绍一下View(视图)的概念.所谓Vi ...

- tensor 维度 问题。

tf.argmax takes two arguments: input and dimension. example: tf.argmx(arr, dimension = 1). or tf.arg ...

- 关于类型为numpy,TensorFlow.tensor,torch.tensor的shape变化以及相互转化

https://blog.csdn.net/zz2230633069/article/details/82669546 2018年09月12日 22:56:50 一只tobey 阅读数:727 1 ...

- 从维度理解dp问题

对于dp,我目前的理解就是,干成题目中的那件事需要作出若干次决策,然后你要取其中最优的结果,我们可以用深搜来递归地找最优解,然后我们来观察一下这个递归树的形状,如果它能从底往上直接递推的话,就不用递归 ...

- tensorflow tensor Flatten 张量扁平化,多通道转单通道数据

slim.flatten(inputs,outputs_collections=None,scope=None) (注:import tensorflow.contrib.slim as slim) ...

随机推荐

- 如何优雅的关闭golang的channel

How to Gracefully Close Channels,这篇博客讲了如何优雅的关闭channel的技巧,好好研读,收获良多. 众所周知,在golang中,关闭或者向已关闭的channel发送 ...

- Api 文档管理系统 RAP2 环境搭建

Api 文档管理系统 RAP2 环境搭建 发表于 2018-03-27 | 分类于 Api | 评论数: 4| 阅读次数: 4704 本文字数: 4.8k | 阅读时长 ≍ 9 分钟 RA ...

- Android--解析XML之PULL

前言 在上一篇博客已经介绍了Android解析XML的几种方式,分别有:SAX.DOM.PULL.详细的可以看看上一篇博客:http://www.cnblogs.com/plokmju/p/andro ...

- 【EF6学习笔记】(十二)EF高级应用场景

本篇原文链接:Advanced Entity Framework Scenarios 本篇主要讲一些使用Code First建立ASP.NET WEB应用的时候除了基础的方式以外的一些扩展方式方法: ...

- Spring Boot 简介

作者其他Spring系列文章 Spring Framework简介 Spring框架快速入门 Spring Boot愿景 Spring Boot愿景就是让我们创建可运行的.独立的.基于Spring的 ...

- web进修之—Hibernate HQL(7)

概述 HQL是Hibernate封装成为面向对象的数据库查询语言,具有如下特点: 面向对象,包括继承.多态和关联之类的概念,SQL操作的数据库的表,HQL更像是操作对象 大小写敏感,只对对象和属性敏感 ...

- Python 实现 KNN(K-近邻)算法

一.概述 KNN(K-最近邻)算法是相对比较简单的机器学习算法之一,它主要用于对事物进行分类.用比较官方的话来说就是:给定一个训练数据集,对新的输入实例,在训练数据集中找到与该实例最邻近的K个实例, ...

- SSL证书(HTTPS)背后的加密算法

SSL证书(HTTPS)背后的加密算法 之前我们介绍SSL工作原理了解到当你在浏览器的地址栏上输入https开头的网址后,浏览器和服务器之间会在接下来的几百毫秒内进行大量的通信.这些复杂的步骤的第一步 ...

- KeepAlived(三):vrrp实例故障转移(keepalived+haproxy)

keepalived使用脚本进行健康检查时的相关配置项.例如keepalived+haproxy实现haproxy的高可用. keepalived分为vrrp实例的心跳检查和后端服务的健康检查.如果要 ...

- Go基础系列:import导包和初始化阶段

import导入包 搜索路径 import用于导入包: import ( "fmt" "net/http" "mypkg" ) 编译器会根据 ...