【2022知乎爬虫】我用Python爬虫爬了2300多条知乎评论!

您好,我是 @马哥python说,一枚10年程序猿。

一、爬取目标

前些天我分享过一篇微博的爬虫:

https://www.cnblogs.com/mashukui/p/16414027.html

但是知乎平台和微博平台的不同之处在于,微博平台的数据用于分析社会舆论热点事件是极好的,毕竟是个偏娱乐化的社交平台。但知乎平台的评论更加客观、讨论内容更加有深度,更加有专业性,基于此想法,我开发出了这个知乎评论的爬虫。

二、展示爬取结果

我在知乎上搜索了5个关于”考研“的知乎回答,爬取了回答下方的评论数据,共计2300+条数据。

https://www.zhihu.com/question/291278869/answer/930193847

https://www.zhihu.com/question/291278869/answer/802226501

https://www.zhihu.com/question/291278869/answer/857896805

https://www.zhihu.com/question/291278869/answer/910489150

https://www.zhihu.com/question/291278869/answer/935352960

爬取字段,含:

回答url、页码、评论作者、作者性别、作者主页、作者头像、评论时间、评论内容、评论级别。

部分数据截图:

三、爬虫代码讲解

3.1 分析知乎页面

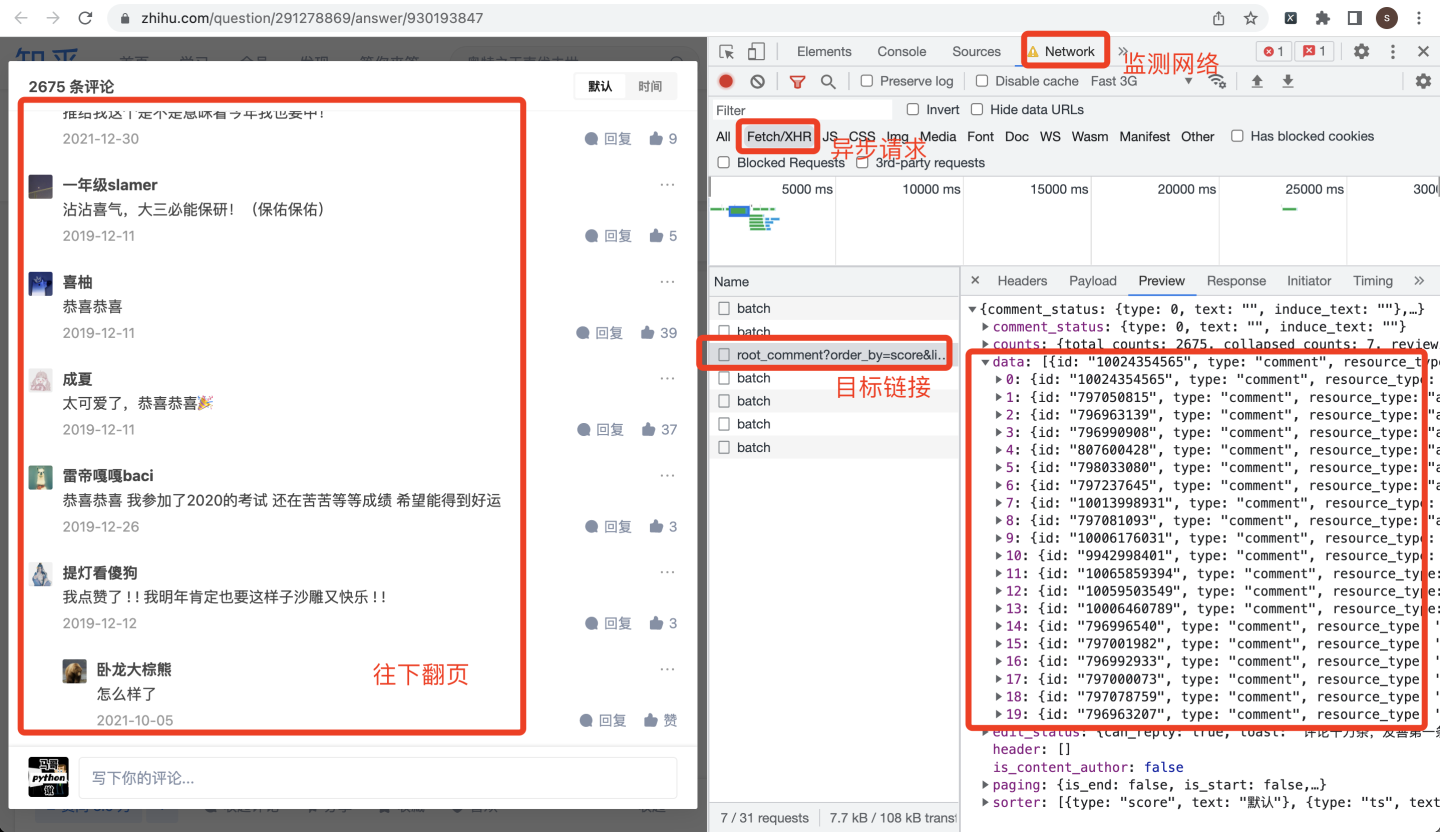

任意打开一个知乎回答,点开评论界面:

同时打开chrome浏览器的开发者模式,评论往下翻页,就会找到目标链接:

作为爬虫开发者,看到这种0-19的json数据,一定要敏感,这大概率就是评论数据了。猜测一下,每页有20条评论,逐级打开json数据:

基于此数据结构,开发爬虫代码。

3.2 爬虫代码

首先,导入用到的库:

import requestsimport timeimport pandas as pdimport os

从上面的截图可以看到,评论时间created_time是个10位时间戳,因此,定义一个转换时间的函数:

def trans_date(v_timestamp):"""10位时间戳转换为时间字符串"""timeArray = time.localtime(v_timestamp)otherStyleTime = time.strftime("%Y-%m-%d %H:%M:%S", timeArray)return otherStyleTime

作者的性别gender是0、1,所以也定义一个转换函数:

def tran_gender(gender_tag):"""转换性别"""if gender_tag == 1:return '男'elif gender_tag == 0:return '女'else: # -1return '未知'

准备工作做好了,下面开始写爬虫。

请求地址url,从哪里得到呢?

打开Headers,找到Request URL,直接复制下来,然后替换:

先提取出一共多少评论,用于计算后面的翻页次数:

url0 = 'https://www.zhihu.com/api/v4/answers/{}/root_comments?order=normal&limit=20&offset=0&status=open'.format(answer_id)r0 = requests.get(url0, headers=headers) # 发送请求total = r0.json()['common_counts'] # 一共多少条评论print('一共{}条评论'.format(total))

计算翻页次数,直接用评论总数除以20就好了:

# 判断一共多少页(每页20条评论)max_page = int(total / 20)print('max_page:', max_page)

下面,再次发送请求,获取评论数据:

url = 'https://www.zhihu.com/api/v4/answers/{}/root_comments?order=normal&limit=20&offset={}&status=open'.format(answer_id,str(offset))r = requests.get(url, headers=headers)print('正在爬取第{}页'.format(i + 1))j_data = r.json()comments = j_data['data']

现在,所有数据都在comments里面了,开始for循环遍历处理:

字段过多,这里以评论作者、评论性别为例,其他字段同理:

for c in comments: # 一级评论# 评论作者author = c['author']['member']['name']authors.append(author)print('作者:', author)# 作者性别gender_tag = c['author']['member']['gender']genders.append(tran_gender(gender_tag))

其他字段不再赘述。

需要注意的是,知乎评论分为一级评论和二级评论(二级评论就是一级评论的回复评论),所以,为了同时爬取到二级评论,开发以下逻辑:(同样以评论作者、评论性别为例,其他字段同理)

if c['child_comments']: # 如果二级评论存在for child in c['child_comments']: # 二级评论# 评论作者print('子评论作者:', child['author']['member']['name'])authors.append(child['author']['member']['name'])# 作者性别genders.append(tran_gender(child['author']['member']['gender']))

待所有字段处理好之后,把所有字段的列表数据拼装到DataFrame,to_csv保存到csv文件里,完毕!

df = pd.DataFrame({'回答url': answer_urls,'页码': [i + 1] * len(answer_urls),'评论作者': authors,'作者性别': genders,'作者主页': author_homepages,'作者头像': author_pics,'评论时间': create_times,'评论内容': contents,'评论级别': child_tag,})# 保存到csv文件df.to_csv(v_result_file, mode='a+', index=False, header=header, encoding='utf_8_sig')

完整代码中还涉及到避免数据重复、字段值拼接、判断翻页终止等细节逻辑,详细了解请见文末。

四、同步视频

演示视频:

https://www.zhihu.com/zvideo/1545723927430979584

我是 @马哥python说, 感谢您的阅读。

【2022知乎爬虫】我用Python爬虫爬了2300多条知乎评论!的更多相关文章

- python爬虫-基础入门-python爬虫突破封锁

python爬虫-基础入门-python爬虫突破封锁 >> 相关概念 >> request概念:是从客户端向服务器发出请求,包括用户提交的信息及客户端的一些信息.客户端可通过H ...

- 【爬虫集合】Python爬虫

一.爬虫学习教程 1. https://www.jianshu.com/u/c32d557edfa3 2. WebMagic是一个简单灵活的Java爬虫框架.基于WebMagic,你可以快速开发出一个 ...

- 抖音爬虫教程,python爬虫采集反爬策略

一.爬虫与反爬简介 爬虫就是我们利用某种程序代替人工批量读取.获取网站上的资料信息.而反爬则是跟爬虫的对立面,是竭尽全力阻止非人为的采集网站信息,二者相生相克,水火不容,到目前为止大部分的网站都还是可 ...

- 【Python】【爬虫】如何学习Python爬虫?

如何学习Python爬虫[入门篇]? 路人甲 1 年前 想写这么一篇文章,但是知乎社区爬虫大神很多,光是整理他们的答案就够我这篇文章的内容了.对于我个人来说我更喜欢那种非常实用的教程,这种教程对于想直 ...

- Python爬虫之xpath语法及案例使用

Python爬虫之xpath语法及案例使用 ---- 钢铁侠的知识库 2022.08.15 我们在写Python爬虫时,经常需要对网页提取信息,如果用传统正则表达去写会增加很多工作量,此时需要一种对数 ...

- Python爬虫入门一之综述

大家好哈,最近博主在学习Python,学习期间也遇到一些问题,获得了一些经验,在此将自己的学习系统地整理下来,如果大家有兴趣学习爬虫的话,可以将这些文章作为参考,也欢迎大家一共分享学习经验. Pyth ...

- [python]爬虫学习(一)

要学习Python爬虫,我们要学习的共有以下几点(python2): Python基础知识 Python中urllib和urllib2库的用法 Python正则表达式 Python爬虫框架Scrapy ...

- Python爬虫入门:综述

大家好哈,最近博主在学习Python,学习期间也遇到一些问题,获得了一些经验,在此将自己的学习系统地整理下来,如果大家有兴趣学习爬虫的话,可以将这些文章作为参考,也欢迎大家一共分享学习经验. Pyth ...

- python爬虫:使用Selenium模拟浏览器行为

前几天有位微信读者问我一个爬虫的问题,就是在爬去百度贴吧首页的热门动态下面的图片的时候,爬取的图片总是爬取不完整,比首页看到的少.原因他也大概分析了下,就是后面的图片是动态加载的.他的问题就是这部分动 ...

随机推荐

- 彰显个性│github和gitlab之自定义首页样式

目录 一.个性首页 二.制作步骤 三.修改内容 一.个性首页 相信很多小伙伴在逛 github 和 gitlab 的时候 会发现很多开发者的首页异常的炫酷,如 https://github.com/c ...

- Python3 collections模块

https://www.cnblogs.com/zhangxinqi/p/7921941.html http://www.wjhsh.net/meng-wei-zhi-p-8259022.html h ...

- React中render Props模式

React组件复用 React组件复用的方式有两种: 1.render Props模式 2.高阶组件HOC 上面说的这两种方式并不是新的APi. 而是利用Raect自身的编码特点,演化而来的固定编码写 ...

- BUUCTF-easycap

easycap 看这个题目应该是流量包来的,wireshark打开即可.没什么特征,直接打开第一个包发现flag

- 基于swiftadmin极速后台开发框架,我制作了菜鸟教程[专业版]

由于互联网上基础编程教学的文档和视频教程已经有很多了,为什么还要建立菜鸟教程网, 这是因为基于我个人在十余年的自学编程的道路上.,我能深刻的体会到一名新手 在入门编程的时候,门槛在哪里,痛点在哪里?很 ...

- 『现学现忘』Docker基础 — 39、实战:自定义Tomcat9镜像

目录 1.目标 2.准备 3.编写Dockerfile文件 4.构建镜像 5.启动镜像 6.验证容器是否能够访问 7.向容器中部署WEB项目,同时验证数据卷挂载 (1)准备一个简单的WEB项目 (2) ...

- C#.NET笔试题-高级

1.说说什么是架构模式. 1,分层. 2,分割. 分层是对网站进行横向的切分,那么分割就是对网站进行纵向的切分.将网站按照不同业务分割成小应用,可以有效控制网站的复杂程度. 3,分布式. 在大型网站中 ...

- 记一次 .NET 差旅管理后台 CPU 爆高分析

一:背景 1. 讲故事 前段时间有位朋友在微信上找到我,说他的 web 系统 cpu 运行一段时候后就爆高了,让我帮忙看一下是怎么回事,那就看吧,声明一下,我看 dump 是免费的,主要是锤炼自己技术 ...

- RocketMQ 集群的搭建部署 以及rocketmq-console-ng仪表台的安装部署

在 RocketMQ 主要的组件如下. NameServerNameServer 集群,Topic 的路由注册中心,为客户端根据 Topic 提供路由服务,从而引导客户端向 Broker 发送消息.N ...

- HiEngine:可媲美本地的云原生内存数据库引擎

摘要:HiEngine与华为GaussDB (for MySQL)集成,将内存数据库引擎的优势带到云端,并与基于磁盘的引擎共存.HiEngine的性能比传统的以存储为中心的解决方案高出7.5倍. 本文 ...