LibTorch 自动微分

得益于反向传播算法,神经网络计算导数时非常方便,下面代码中演示如何使用LibTorch进行自动微分求导。

进行自动微分运算需要调用函数

torch::autograd::grad(

outputs, // 为某个可微函数的输出 y=f(x) 中的 y

inputs, // 为某个可微函数的输入 y=f(x) 中的 x

grad_outputs,// 雅克比矩阵(此处计算 f'(x),故设置为1,且与x形状相同 )

retain_graph,// 默认值与 create_graph 相同,这里设置为 true即可

create_graph,// 需要设置为 true 以计算高阶导数

allow_unused // 设置为 false 即可

)

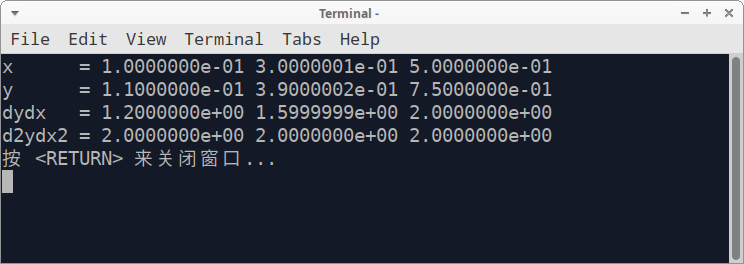

在本文示例中,我们计算 \(y=x^2+x\) 在 \(x = 0.1, 0.3, 0.5\) 处的函数值、一阶导数和二阶导数值,根据我们学到的数学知识,很容易计算出下列数据

| \(x\) | 0.1 | 0.3 | 0.5 |

|---|---|---|---|

| \(y\) | 0.11 | 0.39 | 0.75 |

| \(y'\) | 1.20 | 1.60 | 2.00 |

| \(y''\) | 2.00 | 2.00 | 2.00 |

而在LibTorch中调用自动微分计算导数的代码如下所示

#include <iostream>

#include <torch/torch.h>

int main(int argc, char* atgv[])

{

std::cout.setf(std::ios::scientific);

std::cout.precision(7);

std::vector<float> vec{0.1, 0.3, 0.5};

torch::Tensor x = torch::from_blob(vec.data(), {3}, torch::kFloat).requires_grad_(true);

torch::Tensor y = x * x + x; // y= x^2 + x

auto weight = torch::ones_like(x);

std::cout << "x = ";

for (int i = 0; i < 3; ++i)

std::cout << x[i].item<float>() << " ";

std::cout << std::endl;

std::cout << "y = "; // 0.11 0.39 0.75

for (int i = 0; i < 3; ++i)

std::cout << y[i].item<float>() << " ";

std::cout << std::endl;

// 计算输出一阶导数(y' = 2x + 1)

auto dydx = torch::autograd::grad({y}, {x}, {weight}, true, true, false);

std::cout << "dydx = "; // 1.2 1.6 2.0

for (int i = 0; i < 3; ++i)

std::cout << dydx[0][i].item<float>() << " ";

std::cout << std::endl;

// 计算输出二阶导数(y''= 2)

auto d2ydx2 = torch::autograd::grad({dydx[0]}, {x}, {weight});

std::cout << "d2ydx2 = "; // 2.0 2.0 2.0

for (int i = 0; i < 3; ++i)

std::cout << d2ydx2[0][i].item<float>() << " ";

std::cout << std::endl;

return 0;

}

计算结果如下图所示,与我们手动计算的结果一致。

LibTorch 自动微分的更多相关文章

- 附录D——自动微分(Autodiff)

本文介绍了五种微分方式,最后两种才是自动微分. 前两种方法求出了原函数对应的导函数,后三种方法只是求出了某一点的导数. 假设原函数是$f(x,y) = x^2y + y +2$,需要求其偏导数$\fr ...

- pytorch学习-AUTOGRAD: AUTOMATIC DIFFERENTIATION自动微分

参考:https://pytorch.org/tutorials/beginner/blitz/autograd_tutorial.html#sphx-glr-beginner-blitz-autog ...

- 自动微分(AD)学习笔记

1.自动微分(AD) 作者:李济深链接:https://www.zhihu.com/question/48356514/answer/125175491来源:知乎著作权归作者所有.商业转载请联系作者获 ...

- <转>如何用C++实现自动微分

作者:李瞬生转摘链接:https://www.zhihu.com/question/48356514/answer/123290631来源:知乎著作权归作者所有. 实现 AD 有两种方式,函数重载与代 ...

- (转)自动微分(Automatic Differentiation)简介——tensorflow核心原理

现代深度学习系统中(比如MXNet, TensorFlow等)都用到了一种技术——自动微分.在此之前,机器学习社区中很少发挥这个利器,一般都是用Backpropagation进行梯度求解,然后进行SG ...

- PyTorch自动微分基本原理

序言:在训练一个神经网络时,梯度的计算是一个关键的步骤,它为神经网络的优化提供了关键数据.但是在面临复杂神经网络的时候导数的计算就成为一个难题,要求人们解出复杂.高维的方程是不现实的.这就是自动微分出 ...

- 【tensorflow2.0】自动微分机制

神经网络通常依赖反向传播求梯度来更新网络参数,求梯度过程通常是一件非常复杂而容易出错的事情. 而深度学习框架可以帮助我们自动地完成这种求梯度运算. Tensorflow一般使用梯度磁带tf.Gradi ...

- PyTorch 自动微分示例

PyTorch 自动微分示例 autograd 包是 PyTorch 中所有神经网络的核心.首先简要地介绍,然后训练第一个神经网络.autograd 软件包为 Tensors 上的所有算子提供自动微分 ...

- PyTorch 自动微分

PyTorch 自动微分 autograd 包是 PyTorch 中所有神经网络的核心.首先简要地介绍,然后将会去训练的第一个神经网络.该 autograd 软件包为 Tensors 上的所有操作提供 ...

随机推荐

- UiPath官方视频Level1

[UiPath官方视频Level1]第一课-UiPath简介https://www.bilibili.com/video/BV1zJ41187vB [UiPath官方视频Level1]第二课-变量和数 ...

- Docker 与 K8S学习笔记(二十五)—— Pod的各种调度策略(上)

上一篇,我们学习了各种工作负载的使用,工作负载它会自动帮我们完成Pod的调度和部署,但有时我们需要自己定义Pod的调度策略,这个时候该怎么办呢?今天我们就来看一下如何定义Pod调度策略. 一.Node ...

- weiphp 插件"通用表单"BUG修改

修改文件目录 在类FormsValueController 中添加函数 // 匹配函数 //$value:字符串 //$validate_rule:正则规则 // return true:比配成功,f ...

- 端口被占用的问题解决 Web server failed to start. Port ×× was already in use

出现此问题是端口被占用了,只需要关闭正在使用的端口就行 解决思路: 1.在服务器中更改port端口号,改为不冲突,没有被占用的端口. 2.找出被占用的端口,结束被占用的端口 解决结束被占用的端口的方法 ...

- 分布式机器学习:模型平均MA与弹性平均EASGD(PySpark)

计算机科学一大定律:许多看似过时的东西可能过一段时间又会以新的形式再次回归. 1 模型平均方法(MA) 1.1 算法描述与实现 我们在博客<分布式机器学习:同步并行SGD算法的实现与复杂度分析( ...

- 使用 NSProxy 实现消息转发

一.简介 在 iOS 应用开发中,自定义一个类一般需要继承自 NSObject 类或者 NSObject 子类,但是,NSProxy 类不是继承自 NSObject 类或者 NSObject 子类 ...

- NOI / 2.3基本算法之递归变递推-6262:流感传染

OpenJudge - 6262:流感传染http://noi.openjudge.cn/ch0203/6262/ 6262:流感传染 总时间限制: 1000ms 内存限制: 65536k ...

- Class对象功能概述和Class对象功能获取Field

Constructor[] getConstructors() Constructor getConstructor(类... parameterTypes) Constructor getDecla ...

- Shell 编程基础语法

# shell脚本 # 如何运行shell脚本 sh test.sh source test.sh ./test.sh # 需要有执行权限 # source和其他两种的区别是.source不会开新进程 ...

- Docker-Compose和Docker Network的应用

1 # Docker-Compose分为两部分 2 # 一.Docker-Compose.yml 3 # 二.Docker-Compose 命令 4 5 # 桌面板的Docker(Win.Mac)会默 ...