大数据之路week07--day07 (Sqoop 从mysql增量导入到HDFS)

我们之前导入的都是全量导入,一次性全部导入,但是实际开发并不是这样,例如web端进行用户注册,mysql就增加了一条数据,但是HDFS中的数据并没有进行更新,但是又再全部导入一次又完全没有必要。

所以,sqoop提供了增量导入的方法。

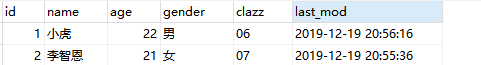

1、数据准备:

2、将其先用全量导入到HDFS中去

3、先在mysql中添加一条数据,在使用命令进行追加

#指定字段的取值范围,增量到数据(指的是Mysql增加了一条或多条数据,追加到HDFS中去,

如果想追加到hive本来的数据中去就把路径换成hive的路径)

# 适用于表不断的有新数据插入 sqoop import \

--connect jdbc:mysql://master:3306/student \

--username root \

--password \

--table student_zeng \

--target-dir /user/hive/warehouse/sqlhivetest.db/student_zeng/ \

--split-by id \

-m \

--fields-terminated-by '\t' \

--incremental append \

--check-column id \

--last-value

4、根据时间进行大量追加(不去重)

追加

sqoop import \

--connect jdbc:mysql://master:3306/student \

--username root \

--password \

--target-dir /user/hive/warehouse/sqlhivetest.db/student_zeng/ \

--table student_zeng \

--fields-terminated-by '\t' \

--check-column last_mod \

--incremental lastmodified \

--last-value "2019-12-19 20:57:16" \

-m \

--append

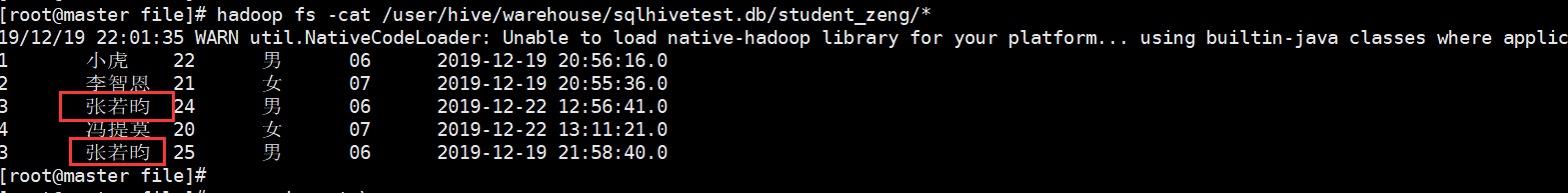

结果:但是我们发现有两个重复的字段

5、往往开发中需要进行去重操作:sqoop提供了一个方法进行去重,内部是先开一个map任务将数据导入进来,然后再开一个map任务根据指定的字段进行合并去重

#根据业务可能需要去重 -merge-key 就是做这个事 sqoop import \

--connect jdbc:mysql://master:3306/student \

--username root \

--password \

--target-dir /user/hive/warehouse/sqlhivetest.db/student_zeng/ \

--table student_zeng \

--fields-terminated-by '\t' \

--check-column last_mod \

--incremental lastmodified \

--last-value "2019-12-19 22:00:09" \

-m \

-merge-key id

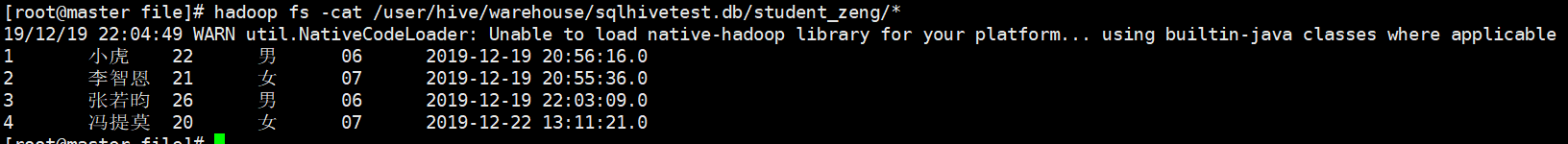

结果:

之前有重复的也进行合并去重操作,最后生成一个结果。

大数据之路week07--day07 (Sqoop 从mysql增量导入到HDFS)的更多相关文章

- 大数据之路week07--day06 (Sqoop 的使用)

Sqoop的使用一(将数据库中的表数据上传到HDFS) 首先我们先准备数据 1.没有主键的数据(下面介绍有主键和没有主键的使用区别) -- MySQL dump 10.13 Distrib 5.1.7 ...

- 大数据之路week07--day06 (Sqoop 将关系数据库(oracle、mysql、postgresql等)数据与hadoop数据进行转换的工具)

为了方便后面的学习,在学习Hive的过程中先学习一个工具,那就是Sqoop,你会往后机会发现sqoop是我们在学习大数据框架的最简单的框架了. Sqoop是一个用来将Hadoop和关系型数据库中的数据 ...

- 大数据之路week07--day06 (Sqoop 在从HDFS中导出到关系型数据库时的一些问题)

问题一: 在上传过程中遇到这种问题: ERROR tool.ExportTool: Encountered IOException running export job: java.io.IOExce ...

- 大数据之路week07--day06 (Sqoop 的安装及配置)

Sqoop 的安装配置比较简单. 提供安装需要的安装包和连接mysql的驱动的百度云链接: 链接:https://pan.baidu.com/s/1pdFj0u2lZVFasgoSyhz-yQ 提取码 ...

- sqoop操作之Oracle导入到HDFS

导入表的所有字段 sqoop import --connect jdbc:oracle:thin:@192.168.1.100:1521:ORCL \ --username SCOTT --passw ...

- 大数据之路week06--day07(Hadoop生态圈的介绍)

Hadoop 基本概念 一.Hadoop出现的前提环境 随着数据量的增大带来了以下的问题 (1)如何存储大量的数据? (2)怎么处理这些数据? (3)怎样的高效的分析这些数据? (4)在数据增长的情况 ...

- 大数据之路week04--day06(I/O流阶段一 之异常)

从这节开始,进入对I/O流的系统学习,I/O流在往后大数据的学习道路上尤为重要!!!极为重要,必须要提起重视,它与集合,多线程,网络编程,可以说在往后学习或者是工作上,起到一个基石的作用,没了地基,房 ...

- 大数据框架开发基础之Sqoop(1) 入门

Sqoop是一款开源的工具,主要用于在Hadoop(Hive)与传统的数据库(mysql.postgresql...)间进行数据的传递,可以将一个关系型数据库(例如 : MySQL ,Oracle , ...

- C#码农的大数据之路 - 使用C#编写MR作业

系列目录 写在前面 从Hadoop出现至今,大数据几乎就是Java平台专属一般.虽然Hadoop或Spark也提供了接口可以与其他语言一起使用,但作为基于JVM运行的框架,Java系语言有着天生优势. ...

随机推荐

- Android Tcp操作

Tcp是基于传输层的面向连接的可靠通讯协议,其优点是基于连接,使得服务端和客户端可以实现双向通信,且实时性高,在需要服务端主动向客户端推送数据的应用场景中,使用TCP协议是一种很好的方式. 初学And ...

- [转] ABP框架Web API跨域问题的解决方案

原文地址:https://www.cnblogs.com/farb/p/ABPWebAPICrossDomain.html 1.在Web Api 项目下安装 Microsoft.AspNet.Web ...

- GAN代码实战

batch normalization 1.BN算法,一般用在全连接或卷积神经网络中.可以增强整个神经网络的识别准确率以及增强模型训练过程中的收敛能力2.对于两套权重参数,例如(w1:0.01,w2: ...

- SQL中EXPLAIN命令详解---(转)

MySQL Explain详解 在日常工作中,我们会有时会开慢查询去记录一些执行时间比较久的SQL语句,找出这些SQL语句并不意味着完事了,些时我们常常用到explain这个命令来查看一个这些SQ ...

- Linux学习-基本命令文件操作

终端 1.多个终端 连接linux的客户端可以理解为终端. 命令:tty查看终端 2.不同终端之间的通讯 [root@wyx wyx]# echo 123 > /dev/pts/1 把123发给 ...

- TiDB基本架构简单总结

TiDB特点 高可用 水平拓展 事务 SQL支持 TiDB架构 和MySql不同,TiDB是一个分布式的数据库而不是单个进程,所以整个TiDB是由以下角色组成: TiKV, PD, TiDB, T ...

- quartz2.3.0(二)触发器Trigger花式Scheduler调度job

任务类 package org.quartz.examples.example2; import java.util.Date; import org.slf4j.Logger; import org ...

- 使用Jenkins自带功能(不用shell)构建Docker镜像并推送到远程仓库

意义: 一开始实现这个目的是在Jenkins中使用的shell脚本,也就是如下的这个: bash # 进入到生成jar包的根目录 cd ${WORKSPACE}/${module_filename} ...

- 浅谈Vue.js2.0某些概念

Vue.js2.0是一套构建用户界面的渐进式框架,目标是实现数据驱动和组件系统. A 渐进式框架 Vue.js是一个提供MVVM数据双向绑定的库,只专注于UI层面,这是它的核心.它本身没有解决SP ...

- Bootstrap 结合 PHP ,做简单的登录以及注册界面及功能

登录实现 HTML代码 <div class="container"> <?php if (isset($error_msg)): ?> <div c ...