DataFrames与RDDs的相互转换

import org.apache.spark.sql.{DataFrameReader, SQLContext}

import org.apache.spark.{SparkConf, SparkContext}

object InferringSchema {

def main(args: Array[String]) {

//创建SparkConf()并设置App名称

val conf = new SparkConf().setAppName("SQL-intsmaze")

//SQLContext要依赖SparkContext

val sc = new SparkContext(conf)

//创建SQLContext

val sqlContext = new SQLContext(sc)

//从指定的地址创建RDD

val lineRDD = sc.textFile("hdfs://192.168.19.131:9000/person.tzt").map(_.split(","))

//创建case class

//将RDD和case class关联

val personRDD = lineRDD.map(x => Person(x().toInt, x(), x().toInt))

//导入隐式转换,如果不导入无法将RDD转换成DataFrame

//将RDD转换成DataFrame

import sqlContext.implicits._

val personDF = personRDD.toDF

//注册表

personDF.registerTempTable("intsmaze")

//传入SQL

val df = sqlContext.sql("select * from intsmaze order by age desc limit 2")

//将结果以JSON的方式存储到指定位置

df.write.json("hdfs://192.168.19.131:9000/personresult")

//停止Spark Context

sc.stop()

}

}

//case class一定要放到外面

case class Person(id: Int, name: String, age: Int)

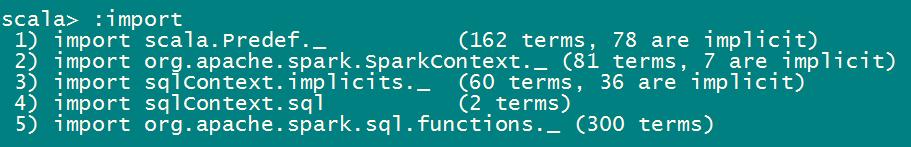

spark shell中不需要导入sqlContext.implicits._是因为spark shell默认已经自动导入了。

打包提交到yarn集群:

/home/hadoop/app/spark/bin/spark-submit --class InferringSchema \

--master yarn \

--deploy-mode cluster \

--driver-memory 512m \

--executor-memory 512m \

--executor-cores \

--queue default \

/home/hadoop/sparksql-1.0-SNAPSHOT.jar

通过编程接口指定Schema(Programmatically Specifying the Schema)

当JavaBean不能被预先定义的时候,编程创建DataFrame分为三步:

从原来的RDD创建一个Row格式的RDD.

创建与RDD中Rows结构匹配的StructType,通过该StructType创建表示RDD的Schema.

通过SQLContext提供的createDataFrame方法创建DataFrame,方法参数为RDD的Schema.

import org.apache.spark.sql.{Row, SQLContext}

import org.apache.spark.sql.types._

import org.apache.spark.{SparkContext, SparkConf}

object SpecifyingSchema {

def main(args: Array[String]) {

//创建SparkConf()并设置App名称

val conf = new SparkConf().setAppName("SQL-intsmaze")

//SQLContext要依赖SparkContext

val sc = new SparkContext(conf)

//创建SQLContext

val sqlContext = new SQLContext(sc)

//从指定的地址创建RDD

val personRDD = sc.textFile(args()).map(_.split(","))

//通过StructType直接指定每个字段的schema

val schema = StructType(

List(

StructField("id", IntegerType, true),

StructField("name", StringType, true),

StructField("age", IntegerType, true)

)

)

//将RDD映射到rowRDD

val rowRDD = personRDD.map(p => Row(p().toInt, p().trim, p().toInt))

//将schema信息应用到rowRDD上

val personDataFrame = sqlContext.createDataFrame(rowRDD, schema)

//注册表

personDataFrame.registerTempTable("intsmaze")

//执行SQL

val df = sqlContext.sql("select * from intsmaze order by age desc ")

//将结果以JSON的方式存储到指定位置

df.write.json(args())

//停止Spark Context

sc.stop()

}

}

将程序打成jar包,上传到spark集群,提交Spark任务

/home/hadoop/app/spark/bin/spark-submit --class SpecifyingSchema \

--master yarn \

--deploy-mode cluster \

--driver-memory 512m \

--executor-memory 512m \

--executor-cores \

--queue default \

/home/hadoop/sparksql-1.0-SNAPSHOT.jar \

hdfs://192.168.19.131:9000/person.txt hdfs://192.168.19.131:9000/intsmazeresult

/home/hadoop/app/spark/bin/spark-submit --class SpecifyingSchema \

--master yarn \

--deploy-mode client \

--driver-memory 512m \

--executor-memory 512m \

--executor-cores \

--queue default \

/home/hadoop/sparksql-1.0-SNAPSHOT.jar \

hdfs://192.168.19.131:9000/person.txt hdfs://192.168.19.131:9000/intsmazeresult

在maven项目的pom.xml中添加Spark SQL的依赖

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_2.</artifactId>

<version>1.6.</version>

</dependency>

DataFrames与RDDs的相互转换的更多相关文章

- 2.sparkSQL--DataFrames与RDDs的相互转换

Spark SQL支持两种RDDs转换为DataFrames的方式 使用反射获取RDD内的Schema 当已知类的Schema的时候,使用这种基于反射的方法会让代码更加简洁而且效果也很好. 通 ...

- Spark SQL 之 DataFrame

Spark SQL 之 DataFrame 转载请注明出处:http://www.cnblogs.com/BYRans/ 概述(Overview) Spark SQL是Spark的一个组件,用于结构化 ...

- Spark SQL 官方文档-中文翻译

Spark SQL 官方文档-中文翻译 Spark版本:Spark 1.5.2 转载请注明出处:http://www.cnblogs.com/BYRans/ 1 概述(Overview) 2 Data ...

- SparkSql官方文档中文翻译(java版本)

1 概述(Overview) 2 DataFrames 2.1 入口:SQLContext(Starting Point: SQLContext) 2.2 创建DataFrames(Creating ...

- Spark记录-SparkSql官方文档中文翻译(部分转载)

1 概述(Overview) Spark SQL是Spark的一个组件,用于结构化数据的计算.Spark SQL提供了一个称为DataFrames的编程抽象,DataFrames可以充当分布式SQL查 ...

- 转】Spark SQL 之 DataFrame

原博文出自于: http://www.cnblogs.com/BYRans/p/5003029.html 感谢! Spark SQL 之 DataFrame 转载请注明出处:http://www.cn ...

- DataFrames,Datasets,与 SparkSQL

v\:* {behavior:url(#default#VML);} o\:* {behavior:url(#default#VML);} w\:* {behavior:url(#default#VM ...

- A Tale of Three Apache Spark APIs: RDDs, DataFrames, and Datasets(中英双语)

文章标题 A Tale of Three Apache Spark APIs: RDDs, DataFrames, and Datasets 且谈Apache Spark的API三剑客:RDD.Dat ...

- Spark RDDs vs DataFrames vs SparkSQL

简介 Spark的 RDD.DataFrame 和 SparkSQL的性能比较. 2方面的比较 单条记录的随机查找 aggregation聚合并且sorting后输出 使用以下Spark的三种方式来解 ...

随机推荐

- MathType中输入破折号的教程

MathType公式编辑器中的包含的各种数学符号与模板已经足够我们在编辑公式时使用了,但是除此之外,MathType还有一些符号并不是数学专有的符号,但是在数学中也偶尔会用到,比如破折号.MathTy ...

- 面试题:谈谈如何优化MYSQL数据库查询

1.优化数据类型 MySQL中数据类型有多种,如果你是一名DBA,正在按照优化的原则对数据类型进行严格的检查,但开发人员可能会选择他们认为最简单的方案,以加快编码速度,或者选择最明显的选择,因此,你可 ...

- ios开发之--ios11适配:TableView的heightForHeaderInSection设置高度无效/UISearchBar消失

更新到ios11,然后使用x-code9运行项目,发现tableview的-(CGFloat)tableView:(UITableView *)tableView heightForHeaderInS ...

- RF使用的相关库API

RF内置库: http://robotframework.org/robotframework/ SSHLibrary: ---WEB自动化测试 http://robotframework.org ...

- 《C++ Primer Plus》10.2 抽象和类 学习笔记

10.2.1 类型是什么基本类型完成了下面的三项工作:* 决定数据对象需要的内存数量:* 决定如何解释内存中的位(long和float在内存中占用的位数相同,但是将它们转换为数值的方法不同):* 决定 ...

- devstack screen 详解

n my previous blog i discussed how to install devstack based openstack. Now if I need to restart ind ...

- Android反编译技术总结

一.Apk反编译工具及其使用方法 1.原理 学习反编译之前,建议先学习一下Apk打包的过程,明白打包完成后的Apk里面都有什么文件,各种文件都是怎么生成的. 这里有两篇AndroidWeekly中推荐 ...

- Bettercap的安装和使用嗅探WIFI

一.首先安装bettercap 我这里的环境是ubuntu 16.04 apt-get install build-essential ruby-dev libpcap-dev git ruby ge ...

- virgo-tomcat访问日志的详细配置

Tomcat 日志信息分为两类:1.运行中的日志,它主要记录运行的一些信息,尤其是一些异常错误日志信息.2.访问日志信息,它记录的访问的时间.IP.访问的资料等相关信息. 关于tomcat访问日志的产 ...

- 【BZOJ1720】[Usaco2006 Jan]Corral the Cows 奶牛围栏 双指针法

[BZOJ1720][Usaco2006 Jan]Corral the Cows 奶牛围栏 Description Farmer John wishes to build a corral for h ...