MapReduce-实践1

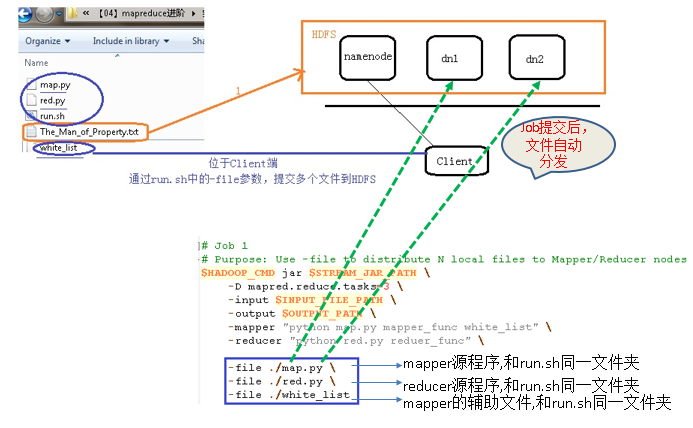

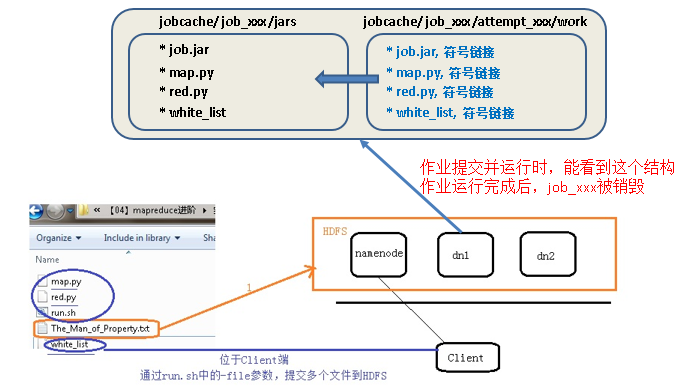

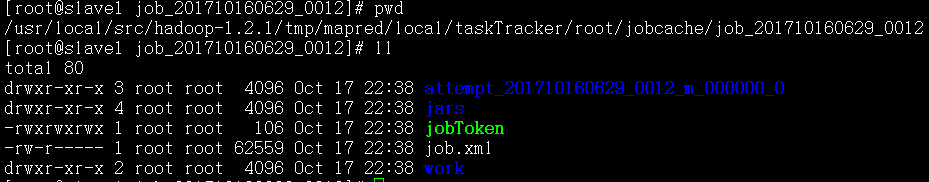

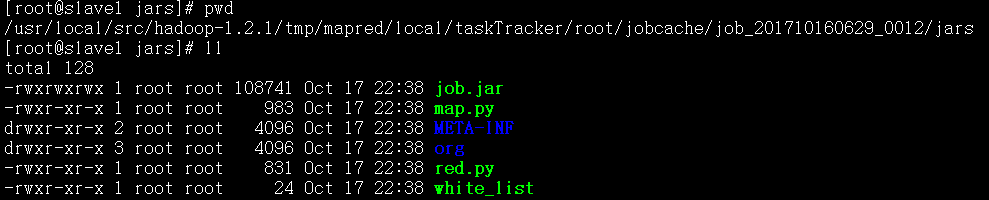

MR进阶实践1: -file 分发多个文件

【-file 适合场景】分发文件在本地,小文件

HADOOP_CMD="/usr/local/src/hadoop-1.2.1/bin/hadoop"

STREAM_JAR_PATH="/usr/local/src/hadoop-1.2.1/contrib/streaming/hadoop-streaming-1.2.1.jar"

INPUT_FILE_PATH="/02_filedistribute_input/The_Man_of_Property.txt"

OUTPUT_PATH="/02_filedistribute_output"

$HADOOP_CMD fs -rmr-skipTrash $OUTPUT_PATH

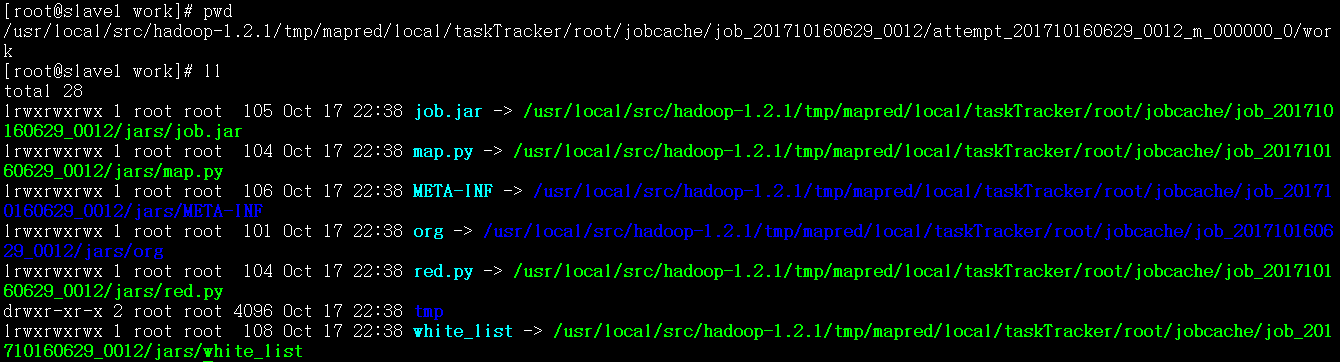

# job1: use -file to distribute local file to cluster

# these files will bestored in the same directory in each datanode

$HADOOP_CMD jar$STREAM_JAR_PATH \

-input $INPUT_FILE_PATH \

-output $OUTPUT_PATH \

-mapper "python map.py mapper_funcwhite_list" \

-reducer "python red.pyreducer_func" \

-file ./map.py \

-file ./red.py \

-file ./white_list

HADOOP_CMD="/usr/local/src/hadoop-1.2.1/bin/hadoop"

STREAM_JAR_PATH="/usr/local/src/hadoop-1.2.1/contrib/streaming/hadoop-streaming-1.2.1.jar"

INPUT_FILE_PATH="/02_filedistribute_input/The_Man_of_Property.txt"

OUTPUT_PATH="/02_filedistribute_output"

$HADOOP_CMD fs -rmr-skipTrash $OUTPUT_PATH

# job1: use -file todistribute files

# these files will be stored in the same directory in each datanode

$HADOOP_CMD jar$STREAM_JAR_PATH \

-input $INPUT_FILE_PATH \

-output $OUTPUT_PATH \

-mapper "python map.py mapper_funcwhite_list" \

-reducer "pythonred.py reducer_func" \

-jobconf “mapred.reduce.tasks=” \ # deprecated option, not suggested

-file ./map.py \

-file ./red.py \

-file ./white_list

HADOOP_CMD="/usr/local/src/hadoop-1.2.1/bin/hadoop"

STREAM_JAR_PATH="/usr/local/src/hadoop-1.2.1/contrib/streaming/hadoop-streaming-1.2.1.jar"

INPUT_FILE_PATH="/02_filedistribute_input/The_Man_of_Property.txt"

OUTPUT_PATH="/02_filedistribute_output"

$HADOOP_CMD fs -rmr-skipTrash $OUTPUT_PATH

# job1: use -file todistribute files

# these files will bestored in the same directory in each datanode

$HADOOP_CMD jar$STREAM_JAR_PATH \

-D mapred.reduce.tasks= \

-input $INPUT_FILE_PATH \

-output $OUTPUT_PATH \

-mapper "python map.py mapper_funcwhite_list" \

-reducer "pythonred.py reducer_func" \

-file ./map.py \

-file ./red.py \

-file ./white_list

MR进阶实践2: -cacheFile 将放在HFDS上的文件分发给计算节点

# hadoop fs -put ./white_list /

# rm -rf ./white_list

HADOOP_CMD="/usr/local/src/hadoop-1.2.1/bin/hadoop"

STREAM_JAR_PATH="/usr/local/src/hadoop-1.2.1/contrib/streaming/hadoop-streaming-1.2.1.jar"

INPUT_FILE_PATH="/03_cachefiledistribute_input/The_Man_of_Property.txt"

OUTPUT_PATH="/03_cachefiledistribute_output"

$HADOOP_CMD fs -rmr-skipTrash $OUTPUT_PATH

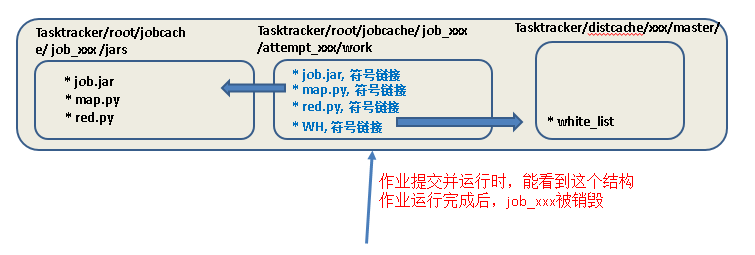

# job2: use -cacheFileto distribute HDFS file to compute node

$HADOOP_CMD jar$STREAM_JAR_PATH \

-input $INPUT_FILE_PATH \

-output $OUTPUT_PATH \

-mapper "python map.py mapper_func WH" \

#这里也一定要用WH符号链接,因为作业开始运行后创建的attemps目录中只能看到WH,和map.py符号链接位于同一目录

-reducer "pythonred.py reducer_func" \

-cacheFile “hdfs://master:9000/white_list#WH”

#WH一定要,每个attemp中要生成该符号链接,指向Tasktracer/distcache中的whitelist

-file ./map.py \

-file ./red.py

MR进阶实践3: -cacheArchive 将位于HFDS上的压缩文件分发给计算节点

# hadoop fs –put ./w.tar.gz / # hadoop fs –ls /

查看是否已经上传成功

HADOOP_CMD="/usr/local/src/hadoop-1.2.1/bin/hadoop"

STREAM_JAR_PATH="/usr/local/src/hadoop-1.2.1/contrib/streaming/hadoop-streaming-1.2.1.jar"

INPUT_FILE_PATH="/03_cachefiledistribute_input/The_Man_of_Property.txt"

OUTPUT_PATH="/03_cachefiledistribute_output"

$HADOOP_CMD fs -rmr-skipTrash $OUTPUT_PATH

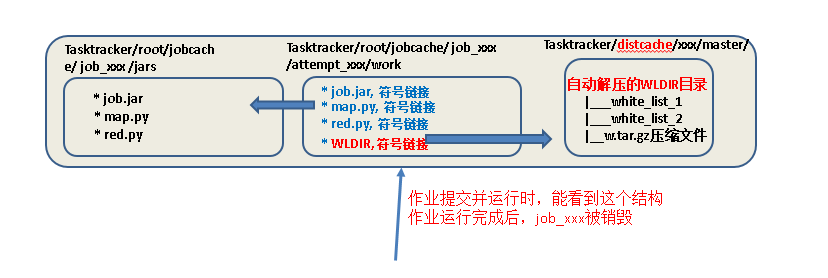

# job3: use -cacheArchive to distribute HDFS compressed file to compute node

$HADOOP_CMD jar$STREAM_JAR_PATH \

-input $INPUT_FILE_PATH \

-output $OUTPUT_PATH \

-mapper "python map.py mapper_func WLDIR" \

#这里也一定要用WH.gz符号链接名,因为attemps中只能看到WH.gz

-reducer "pythonred.py reducer_func" \

-cacheArchive “hdfs://master:9000/w.tar.gz#WLDIR”

#WLDIR一定要,每个attemp中要生成该符号链接,指向Tasktracer/distcache中已经自动解压的文件夹,文件夹中有white_list_1,white_list_2

-file ./map.py \

-file ./red.py

MapReduce-实践1的更多相关文章

- 大数据系列之分布式计算批处理引擎MapReduce实践-排序

清明刚过,该来学习点新的知识点了. 上次说到关于MapReduce对于文本中词频的统计使用WordCount.如果还有同学不熟悉的可以参考博文大数据系列之分布式计算批处理引擎MapReduce实践. ...

- 大数据系列之分布式计算批处理引擎MapReduce实践

关于MR的工作原理不做过多叙述,本文将对MapReduce的实例WordCount(单词计数程序)做实践,从而理解MapReduce的工作机制. WordCount: 1.应用场景,在大量文件中存储了 ...

- 大数据系列之数据仓库Hive命令使用及JDBC连接

Hive系列博文,持续更新~~~ 大数据系列之数据仓库Hive原理 大数据系列之数据仓库Hive安装 大数据系列之数据仓库Hive中分区Partition如何使用 大数据系列之数据仓库Hive命令使用 ...

- Hadoop MapReduce开发最佳实践(上篇)

body{ font-family: "Microsoft YaHei UI","Microsoft YaHei",SimSun,"Segoe UI& ...

- 化繁为简(三)—探索Mapreduce简要原理与实践

目录-探索mapreduce 1.Mapreduce的模型简介与特性?Yarn的作用? 2.mapreduce的工作原理是怎样的? 3.配置Yarn与Mapreduce.演示Mapreduce例子程序 ...

- MapReduce 原理与 Python 实践

MapReduce 原理与 Python 实践 1. MapReduce 原理 以下是个人在MongoDB和Redis实际应用中总结的Map-Reduce的理解 Hadoop 的 MapReduce ...

- 【原创 Hadoop&Spark 动手实践 3】Hadoop2.7.3 MapReduce理论与动手实践

开始聊MapReduce,MapReduce是Hadoop的计算框架,我学Hadoop是从Hive开始入手,再到hdfs,当我学习hdfs时候,就感觉到hdfs和mapreduce关系的紧密.这个可能 ...

- Hadoop化繁为简(三)—探索Mapreduce简要原理与实践

目录-探索mapreduce 1.Mapreduce的模型简介与特性?Yarn的作用? 2.mapreduce的工作原理是怎样的? 3.配置Yarn与Mapreduce.演示Mapreduce例子程序 ...

- [转] Hadoop MapReduce开发最佳实践(上篇)

前言 本文是Hadoop最佳实践系列第二篇,上一篇为<Hadoop管理员的十个最佳实践>. MapRuduce开发对于大多数程序员都会觉得略显复杂,运行一个WordCount(Hadoop ...

- Mapreduce简要原理与实践

探索Mapreduce简要原理与实践 目录-探索mapreduce 1.Mapreduce的模型简介与特性?Yarn的作用? 2.mapreduce的工作原理是怎样的? 3.配置Yarn与Mapred ...

随机推荐

- 201521123074 《Java程序设计》第14周学习总结

1. 本周学习总结 1.1 以你喜欢的方式(思维导图或其他)归纳总结多数据库相关内容. 2. 书面作业 Q1. MySQL数据库基本操作 建立数据库,将自己的姓名.学号作为一条记录插入.(截图,需出现 ...

- 201521123053《Java程序设计》第十三周学习总结

1. 本周学习总结 以你喜欢的方式(思维导图.OneNote或其他)归纳总结多网络相关内容. 2. 书面作业 TCP和UDP两者之间的区别: UDP:1)将数据及源和目的封装成数据包中,不需要建立连接 ...

- java课程设计(团队)-五子棋

单机五子棋小游戏 一:团队介绍 组长:网络1511,毛卓 组员:网络1511,朱潞潞 组员:网络1511,范阳斌 二:项目git提交记录截图 三:项目使用主要技术 netBeans,GUI 四:项目特 ...

- CSS3 3D环境实现立体 魔方效果代码

<!DOCTYPE html> <html lang="en"> <head> <meta charset="UTF-8&quo ...

- JSP第六篇【自定义标签之传统标签】

为什么要使用自定义标签? JSTL标签库只提供了简单的输出等功能,没有实现任何的HTML代码封装,并且某些复杂类型转换,或者逻辑处理的时候,JSTL标签库完成不了,需要自定义标签! 编写自定义标签的步 ...

- oracle安装时,条件检查不通过解决办法

1.开始菜单→ 运行:输入regedit,打开注册表 2.依次点开HKEY_LOCAL_MACHINE>>SYSTEM>>CurrenControlSet>>ser ...

- HTML 4.01+5基礎知識

HTML 4.01+5 1.Html結構:html>head+body 2.Html快捷鍵:!加Tab(在sublime中) 3.雙標籤: ①常用標籤 h1.h2.h3.h4.h5.h6 p.c ...

- 关于sql语句引发的404错误

今天分享个小问题,也是今天在项目中遇到的,希望对遇到相关问题的朋友有所帮助. 使用工具:(相关的) mybatis,spring-mvc,mysql 问题原因: 我在mybatis的mapper文件中 ...

- [python学习笔记] pyqt5下载与安装

下载 命令安装 pip3 install PyQt5 但是我这里老安装失败 失败问题 host='pypi.python.org', port=443): Read timed out 方案1:加大命 ...

- 【框架学习与探究之宿主服务--Topshelf】

前言 此文欢迎转载,原始链接地址:http://www.cnblogs.com/DjlNet/p/7603819.html 正文 原先也偶然见过这个关键词,当时只是有个大致了解貌似和WinServic ...